개발자를 위한 LLM 튜닝 효과적인 활용과 최적화 전략

대규모 언어 모델은 오늘날 개발 분야에서 가장 강력한 도구 중 하나입니다.

하지만 이 거대한 잠재력을 우리 업무와 서비스에 최적화하여 적용하는 것은 또 다른 문제입니다. 이번 포스팅에서는 개발자 관점에서 LLM을 어떻게 효율적으로 활용하고 튜닝할지에 대해 깊이 있게 다룹니다.

LLM의 기본 개념부터 튜닝의 필요성, 효과적인 튜닝 전략, 그리고 실제 업무에 바로 적용할 수 있는 실용적인 팁까지 상세히 살펴보겠습니다.

1. LLM과 튜닝, 왜 필요할까?

LLM(Large Language Model)은 방대한 양의 데이터를 학습하여 사람처럼 텍스트를 생성하고, 질문에 답변하며, 다양한 언어 작업을 수행할 수 있는 AI 모델입니다.

OpenAI의 GPT나 Google의 Gemini와 같은 대형 모델들은 범용적인 용도로 설계되었기 때문에, 특정 도메인이나 기업의 고유한 요구사항에 완벽히 부합하지 않을 수 있습니다.

바로 이 지점에서 튜닝의 필요성이 대두됩니다.

튜닝의 주요 목적

-

작은 모델 최적화: GPU 비용 문제로 대형 모델 대신 작은 모델(예: 1.5B, 4B, 7B 파라미터)을 사용하는 경우, 특정 작업에 맞춰 성능을 극대화하기 위해 튜닝이 필수적입니다.

-

특화된 작업 수행: 사용자의 자연어 입력을 SQL 쿼리로 변환하거나, Python/Kotlin 코드를 생성하는 등 특정 도메인에 특화된 기능을 수행하는 모델을 만들려면 튜닝이 필요합니다.

-

외부 시스템 연동: 날씨 정보, 위치 데이터, 내부 DB 등 외부 시스템과 연동하여 동적으로 응답하는 에이전트 AI를 구현하려면, 모델이 외부 툴과 유기적으로 상호작용하도록 튜닝해야 합니다.

-

비용 효율성: 대형 모델의 API 호출 비용이 누적될 때, 특정 작업에 최적화된 작은 모델을 자체 호스팅하는 것이 장기적으로 훨씬 경제적일 수 있습니다.

작은 모델의 한계와 현실

작은 모델들은 일반적으로 제한적인 지식을 가지고 있으며, 회사 내부 데이터나 특정 도메인 지식을 반영하기 어렵습니다.

예를 들어, 아무리 강력한 GPT라도 여러분 회사의 내부 문서를 알지는 못합니다.

또한, 복잡한 추론이나 다단계 문제 해결에서 대형 모델보다 성능이 떨어질 수 있습니다.

이러한 한계를 극복하고 모델을 특정 목적에 맞게 최적화하는 것이 바로 튜닝의 핵심입니다.

2. LLM 튜닝의 세 가지 주요 방법

LLM 튜닝은 크게 모델 튜닝(Fine-tuning), 프롬프트 엔지니어링(Prompt Engineering), 그리고 이 둘을 보완하는 하이브리드 접근법(RAG, Function Calling)으로 나뉩니다.

(1) 모델 튜닝: 신경망 내부를 손보는 작업

모델 튜닝은 LLM의 신경망 파라미터를 직접 조정하는 방법입니다.

신경망은 행렬 연산으로 구성된 함수로, 이 행렬의 각 원소(파라미터)를 추가 학습 데이터를 통해 미세하게 조정합니다.

전통적인 Fine-tuning의 문제점

-

데이터 부족: 7B 파라미터 모델을 의미 있게 튜닝하려면 최소 150만~200만 개의 고품질 학습 데이터가 필요합니다.

하지만 실제 기업 환경에서는 4만 개 정도의 데이터만 추출 가능한 경우가 많아 효과가 미미할 수 있습니다. -

비용 문제: 전체 파라미터를 학습하는 데는 고성능

GPU(예: A100 4대, 약 5천만 원 이상)가 필요하여 막대한 비용이 듭니다.

반면, 추론(Inference)은 비교적 저렴한 RTX 4080 GPU로도 가능합니다. -

모델 불균형(Catastrophic Forgetting): 잘못된 튜닝은 모델의 기존 지식 균형을 깨뜨려, 상식적인 질문에도 엉뚱한 답변을 내놓게 만들 수 있습니다.

효율적인 경량 튜닝 기법 해결책

이러한 문제점을 해결하기 위해 경량 튜닝(Parameter-Efficient Fine-Tuning, PEFT) 기법들이 주목받고 있습니다.

-

LoRA (Low-Rank Adaptation): 전체 파라미터를 건드리지 않고, 저랭크 행렬을 추가하여 특정 작업에 최적화합니다. 기존 모델 크기의 1-3% 정도의 파라미터만 추가로 학습하면 됩니다.

-

QLoRA: LoRA에 양자화(Quantization)를 결합하여 메모리 사용량을 더욱 줄인 기법입니다. 24GB GPU에서도 65B 모델을 튜닝할 수 있을 정도로 효율적입니다.

-

Adapter 레이어: 각 트랜스포머 블록에 작은 어댑터 레이어를 추가하는 방법으로, 파라미터 효율성이 뛰어납니다.

-

Prompt Tuning: 입력 프롬프트에 학습 가능한 soft prompt를 추가하여 모델의 동작을 유도하는 방식입니다.

실무 적용 팁

모델 튜닝을 시작할 때는 작은 규모부터 시작하는 것이 좋습니다.

1.5B-3B 모델에 LoRA를 적용하여 프로토타입을 만들고, 성능을 충분히 검증한 후 더 큰 모델이나 다른 기법으로 확장하는 것이 효율적입니다.

(2) 프롬프트 간단하고 효과적인 대안 엔지니어링

프롬프트 엔지니어링은 모델 자체를 수정하지 않고, 입력 프롬프트에 추가 지침이나 맥락을 제공하여 원하는 결과를 얻는 방법입니다.

가장 빠르고 비용 효율적인 튜닝 방법으로 꼽힙니다.

고급 프롬프트 기법

-

Few-shot Learning: 프롬프트에 2-5개의 예시를 포함시켜 모델이 패턴을 학습하도록 유도합니다.

-

Chain-of-Thought (CoT): "단계별로 생각해보자", "논리적으로 추론해봐"와 같은 지시어를 통해 모델의 추론 과정을 명시적으로 개선합니다.

-

Role-based Prompting: "당신은 SQL 전문가입니다", "당신은 노련한 Kotlin 개발자입니다"와 같이 역할을 부여하여 특정 도메인 지식이나 스타일을 활용하도록 유도합니다.

-

Template-based Approach: 일관된 출력 형식을 위해 구조화된 템플릿을 프롬프트에 포함시킵니다.

Kotlin 기반 Spring Boot 환경

// SQL 생성 프롬프트 예시

val prompt = """

당신은 PostgreSQL 전문가입니다. 다음 요청을 SQL 쿼리로 변환하세요.

규칙:

- 출력은 반드시 JSON 형식으로 {"query": "...", "explanation": "..."}

- 테이블명은 snake_case 사용

- 에러 메시지는 포함하지 마세요

데이터베이스 스키마:

- users (id, name, email, created_at)

- orders (id, user_id, amount, status, created_at)

사용자 요청: "최근 30일간 주문 금액이 높은 상위 10명의 고객 목록"

""".trimIndent()

// 실제 LLM API 호출 (예: OpenAI API 클라이언트)

// val response = llmService.generate(prompt)

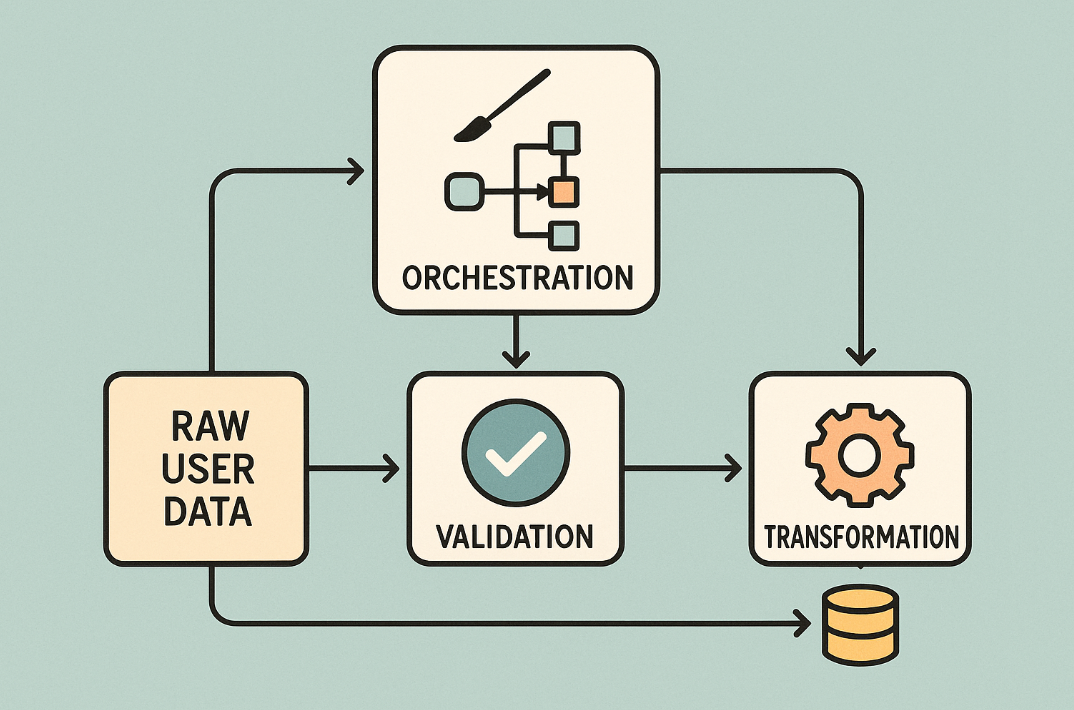

// print(response)(3) 하이브리드 RAG와 Function Calling 접근

단일 LLM 모델만으로는 처리하기 어려운 복잡한 문제나 실시간 정보가 필요한 경우, 다른 시스템과의 연동이 필수적입니다.

이때 RAG(Retrieval-Augmented Generation)와 Function Calling이 강력한 해결책이 됩니다.

-

RAG (Retrieval-Augmented Generation): 외부 데이터베이스나 문서 저장소에서 관련 정보를 검색하여 프롬프트에 포함시킨 후 LLM이 답변을 생성하도록 하는 방법입니다.

벡터 데이터베이스(Pinecone, Weaviate, Milvus 등)를 활용하여 구현할 수 있습니다. 이를 통해 모델의 환각(Hallucination)을 줄이고 최신 정보나 내부 데이터를 활용할 수 있습니다. -

Function Calling: LLM이 필요에 따라 외부 함수나 API를 호출할 수 있도록 하는 기능입니다.

OpenAI GPT-4, Claude 3.5, Google Gemini 등이 이 기능을 지원합니다.

모델은 사용자 요청을 분석하여 어떤 도구가 필요한지 판단하고, 필요한 인자를 추출하여 함수 호출을 제안합니다.

3. 에이전트 AI와 외부 시스템 연동

최근 주목받는 에이전트 AI는 외부 시스템과 연동하여 동적으로 정보를 가져오고 복잡한 작업을 수행하는 AI를 의미합니다.

예를 들어, "오늘 서울 날씨 어때?"라는 질문에 답하려면 에이전트는 다음과 같은 단계를 거칩니다.

- 사용자의 위치를 파악 (IP 추적, 직접 입력 등).

- 날씨 API를 호출하여 최신 데이터를 가져옴.

- 가져온 데이터를 기반으로 자연스러운 응답을 생성.

추천 모델과 프레임워크

-

유료 모델: Anthropic의 Claude 3.5 Sonnet은 외부 툴 연동 능력과 추론 능력이 뛰어납니다.

특히 도구 선택과 사용자 맥락 파악에 강점을 보입니다.

OpenAI의 GPT-4o 또한 강력한 멀티모달 및 Function Calling 기능을 제공합니다. -

오픈소스 모델: Alibaba의 Qwen 시리즈(예: Qwen 2.5), Meta의 Llama 3.1, Microsoft의 Phi-3 등은 외부 시스템 연동에 특화된 튜닝으로 강력한 성능을 보여주며, 자체 호스팅에 유리합니다.

-

프레임워크: LangChain, LlamaIndex, AutoGen 등은 에이전트 AI 구현을 위한 다양한 모듈과 추상화를 제공하여 개발을 용이하게 합니다.

Kotlin 기반 Spring Boot 환경 - LangChain4j 활용

// build.gradle.kts 에 의존성 추가

// implementation("dev.langchain4j:langchain4j-spring-boot-starter:0.32.0")

// implementation("dev.langchain4j:langchain4j-open-ai:0.32.0")

import dev.langchain4j.agent.tool.Tool

import dev.langchain4j.memory.chat.MessageWindowChatMemory

import dev.langchain4j.model.openai.OpenAiChatModel

import dev.langchain4j.service.AiServices

import org.springframework.boot.CommandLineRunner

import org.springframework.stereotype.Component

// 날씨 정보를 가져오는 서비스 (외부 시스템 연동 예시)

@Component

class WeatherService {

@Tool("현재 날씨 정보를 가져옵니다. 지역을 입력받습니다.")

fun getWeatherData(location: String): String {

// 실제 날씨 API 호출 로직을 여기에 구현

return "$location 의 현재 날씨는 맑음, 기온 22도입니다."

}

}

// AI 에이전트 인터페이스

interface MyAssistant {

fun chat(message: String): String

}

@Component

class AgentRunner(private val weatherService: WeatherService) : CommandLineRunner {

override fun run(vararg args: String?) {

val model = OpenAiChatModel.builder()

.apiKey(System.getenv("OPENAI_API_KEY")) // 환경 변수에서 API 키 로드

.modelName("gpt-4o") // 또는 gpt-3.5-turbo 등

.build()

val assistant = AiServices.builder(MyAssistant::class.java)

.chatLanguageModel(model)

.tools(weatherService) // WeatherService를 툴로 등록

.chatMemory(MessageWindowChatMemory.with MaxMessages(10)) // 채팅 히스토리 저장

.build()

println("AI Assistant: 서울 날씨 어때?")

val response1 = assistant.chat("서울 날씨 어때?")

println("User: $response1") // AI Assistant: 현재 날씨 정보를 가져오는 중... 서울의 현재 날씨는 맑음, 기온 22도입니다.

println("AI Assistant: 오늘 점심 뭐 먹지?")

val response2 = assistant.chat("오늘 점심 뭐 먹지?")

println("User: $response2") // AI Assistant: 음... 제가 날씨 정보는 알려드릴 수 있지만, 점심 메뉴는 잘 모르겠네요!

}

}4. 성능 최적화와 배포 전략

LLM을 실제 서비스에 적용하려면 성능 최적화와 효율적인 배포 전략이 필수적입니다.

모델 압축과 최적화

-

양자화(Quantization): 모델의 가중치를 FP16, INT8, 심지어 INT4와 같이 더 낮은 정밀도로 표현하여 모델 크기를 줄이고 추론 속도를 개선합니다.

QLoRA와 같은 기법에서 중요한 요소입니다. -

프루닝(Pruning): 모델의 중요하지 않은 파라미터를 제거하여 모델 크기와 연산량을 줄입니다.

-

지식 증류(Knowledge Distillation): 크고 성능이 좋은 모델(Teacher)의 지식을 작고 효율적인 모델(Student)에게 전달하여, 작은 모델이 큰 모델의 성능을 모방하도록 하는 기법입니다.

배포 옵션

-

클라우드 관리형 서비스: AWS SageMaker, Google Vertex AI, Azure ML 등을 활용하면 LLM 모델 학습, 배포, 모니터링을 쉽게 관리할 수 있습니다.

초기 설정이 간단하고 확장성이 뛰어납니다. -

자체 호스팅(On-premise): Docker 컨테이너 등을 활용하여 자체 서버에 모델을 배포합니다.

데이터 주권이 중요하거나 비용 통제가 필요한 경우 유리합니다. -

엣지 배포: 모바일 기기나 IoT 장치에서 직접 동작하는 초경량 모델을 배포합니다.

실시간 응답이 중요하거나 네트워크 연결이 불안정한 환경에 적합합니다.

5. 실무에서 LLM 튜닝 시작하기

LLM 튜닝 프로젝트를 성공적으로 이끌기 위한 단계별 접근법과 체크리스트입니다.

단계별 접근 방법

1. 문제 정의와 목표 설정

- 해결하고자 하는 구체적인 문제를 명확히 정의하세요.

- 성공 지표(정확도, 응답 시간, 비용 등)를 설정하고, 현재 솔루션 대비 얼마나 개선할지 목표를 세웁니다.

2. 데이터 준비와 분석

- 사용 가능한 데이터의 양과 품질을 평가합니다.

- 데이터 전처리 및 정제 작업을 수행하고, 학습/검증/테스트 데이터셋으로 분할합니다.

3. 베이스라인 설정

- 우선 프롬프트 엔지니어링만으로 기본 성능을 측정합니다.

- 기존 대형 모델들의 성능과 비교하여 개선 여지를 파악합니다.

4. 점진적 개선

-

프롬프트 최적화 → RAG 도입 → 경량 튜닝(PEFT) → 전체 Fine-tuning순으로 점진적으로 진행하는 것을 권장합니다. -

각 단계에서 성능을 측정하고 ROI(투자 수익률)를 계산하여 다음 단계 진행 여부를 결정합니다.

실무 체크리스트

| 카테고리 | 고려 사항 |

|---|---|

| 기술적 요구사항 | - GPU 메모리: 최소 24GB (예: RTX 4090, A6000 등) - 저장 공간: 모델 크기의 3~5배 필요 - 개발 환경: Python 3.8+, PyTorch/TensorFlow, 또는 Kotlin/Java 기반 ML 프레임워크 |

| 팀 역량 | - 머신러닝 엔지니어링 경험 - 데이터 전처리 및 분석 능력 - LLM 배포 및 운영 경험 |

| 예산 계획 | - 하드웨어 비용: 초기 투자 500만원~3000만원 (온프레미스) - 클라우드 비용: 월 100만원~1000만원 (사용량에 따라 유동적) - 인력 비용: 전담 개발자 1~2명 |

6. 성능 평가와 모니터링

LLM 튜닝 프로젝트의 성공은 지속적인 평가와 모니터링에 달려 있습니다.

평가 지표

-

정량적 지표

- 정확도(Accuracy): 분류, 추출 등 특정 작업의 정확성.

- BLEU, ROUGE 스코어: 텍스트 생성 결과의 품질(참조 문장과의 유사도).

- 응답 시간(Latency): 쿼리당 응답 시간.

- 처리량(Throughput): 단위 시간당 처리할 수 있는 요청 수.

-

정성적 지표

- 사용자 만족도: 실제 사용자의 피드백.

- 에러 유형 분석: 모델이 어떤 종류의 오류를 자주 범하는지 분석.

- 도메인 전문성 평가: 특정 도메인 지식을 얼마나 잘 활용하는지.

7. 미래 전망과 준비사항

LLM 기술은 끊임없이 진화하고 있으며, 개발자는 이러한 변화에 발맞춰 준비해야 합니다.

기술 트렌드

-

멀티모달 AI: 텍스트뿐만 아니라 이미지, 음성, 비디오 등 다양한 형태의 데이터를 통합 처리하는 모델이 더욱 중요해질 것입니다.

-

강화학습(RLHF): 인간 피드백 기반

강화학습(Reinforcement Learning from Human Feedback)을 통해 모델의 사용자 의도 파악 및 안전성, 유용성이 크게 개선될 것입니다. -

경량화 및 온디바이스 AI: 모바일 및 엣지 환경에서 동작하는 초경량 모델의 중요성이 커지며, 이는 더욱 다양한 애플리케이션의 등장을 가능하게 할 것입니다.

개발자가 준비해야 할 것

-

기술적 역량: 머신러닝 파이프라인 설계, 분산 시스템 이해, 클라우드 네이티브 개발, 그리고 Kotlin/Spring Boot 환경에서의 AI 모델 연동 능력 등.

-

비즈니스 이해: LLM 기술이 비즈니스에 어떤 가치를 제공할 수 있는지, ROI를 어떻게 계산하고 비용을 최적화할지 이해해야 합니다.

또한, 윤리적 AI 개발 및 관련 규제 준수에도 관심을 기울여야 합니다.

8. 마무리

LLM 튜닝은 개발자가 AI를 자신의 필요에 맞게 최적화하는 매우 강력한 방법입니다.

하지만 비용, 데이터, 기술적 난이도를 종합적으로 고려하여 적절한 전략을 선택하는 것이 중요합니다.

프롬프트 엔지니어링부터 시작하여 RAG, 경량 튜닝, 그리고 필요하다면 전체 Fine-tuning에 이르는 점진적인 접근 방식을 권장합니다.

성공적인 LLM 프로젝트를 위해서는 기술적 구현을 넘어, 명확한 비즈니스 목표와의 정렬, 사용자 경험 고려, 그리고 지속적인 개선 체계가 필수적입니다.

작은 프로젝트부터 시작하여 경험을 쌓아가며 점진적으로 확장하는 것이 가장 현실적이고 효과적인 접근법이 될 것입니다.

다음 포스팅에서는 Kotlin 기반의 Spring Boot 환경에서 LLM을 활용한 구체적인 코드 예시와 실제 프로젝트 케이스 스터디를 통해 더욱 깊이 있는 내용을 다뤄보겠습니다.