[Paper] AdapterFusion

AdapterFusion: Non-Destructive Task Composition for Transfer Learning

https://arxiv.org/pdf/2005.00247.pdf

Transfer Learning 하는 경우, Multiple task를 위해 여러개의 adapter layer를 적용했을 때 생기는 문제인 catastropic forgetting을 해결하기 위해 AdapterFusion Layer를 제시하는 논문이다.

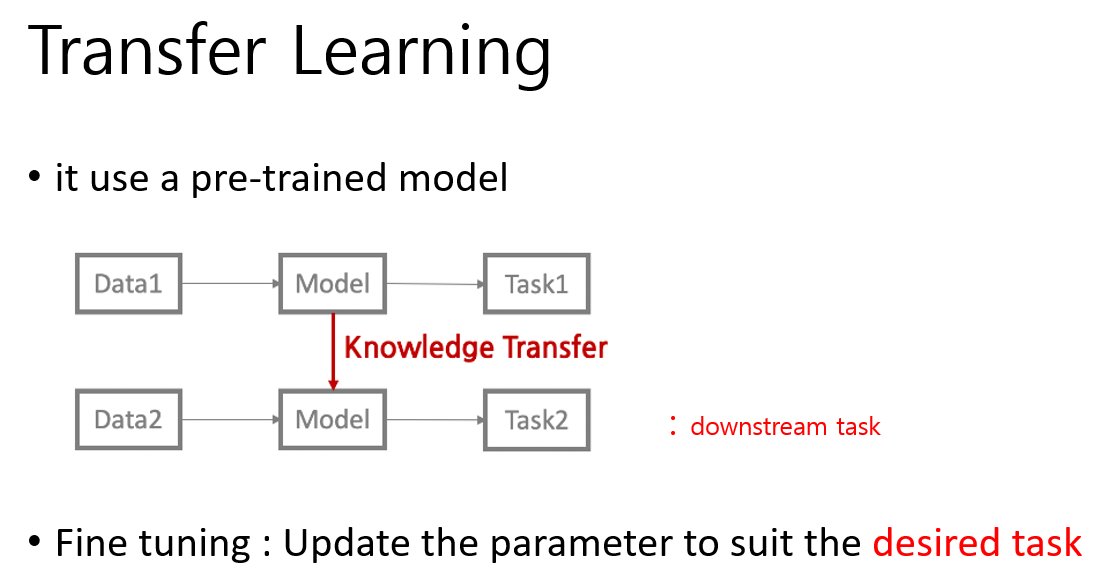

Transfer Learning

이미 일반적인 경우에 대해 데이터를 학습한 pre-trained model이 있을 때, 특정한 task에 더 적합하게 만들기 위해 fine tuning을 진행하는 것이 Transfer learning이다.

fine tuning은 일반적인 경우에 대해 학습된 learnable parameter matrix와 원하는 task을 하기위한 새로운 layer의 learnable parameter matrix를 다시 업데이트하는 것을 말한다.

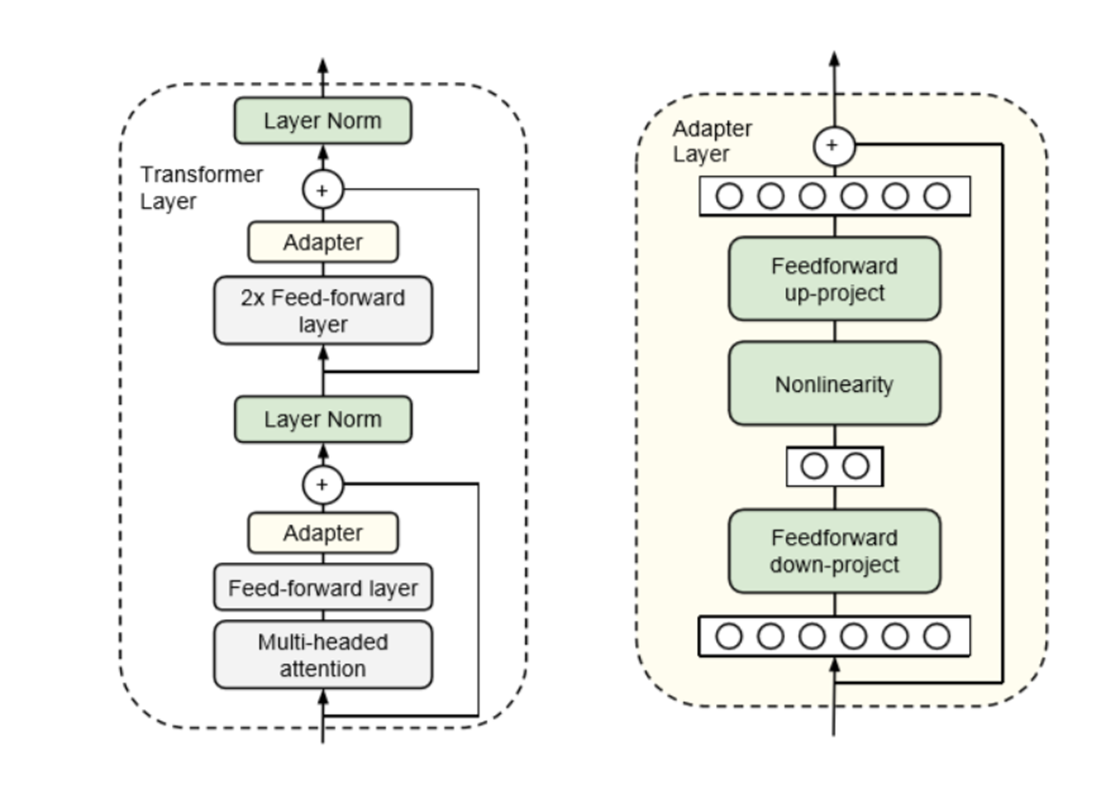

Adapter

원시적인 Fine tuning 같은 경우 ,

위에서 언급했듯이 parameter matrix들을 동시에 업데이트 하니까,

본래의 Layer에는 영향을 주지 않고 Transformer Layer 안에 위치해서 (NLP에서 제시되었기 때문에) 훈련을 안정적으로 하기위한 Adapter가 제시되었다.

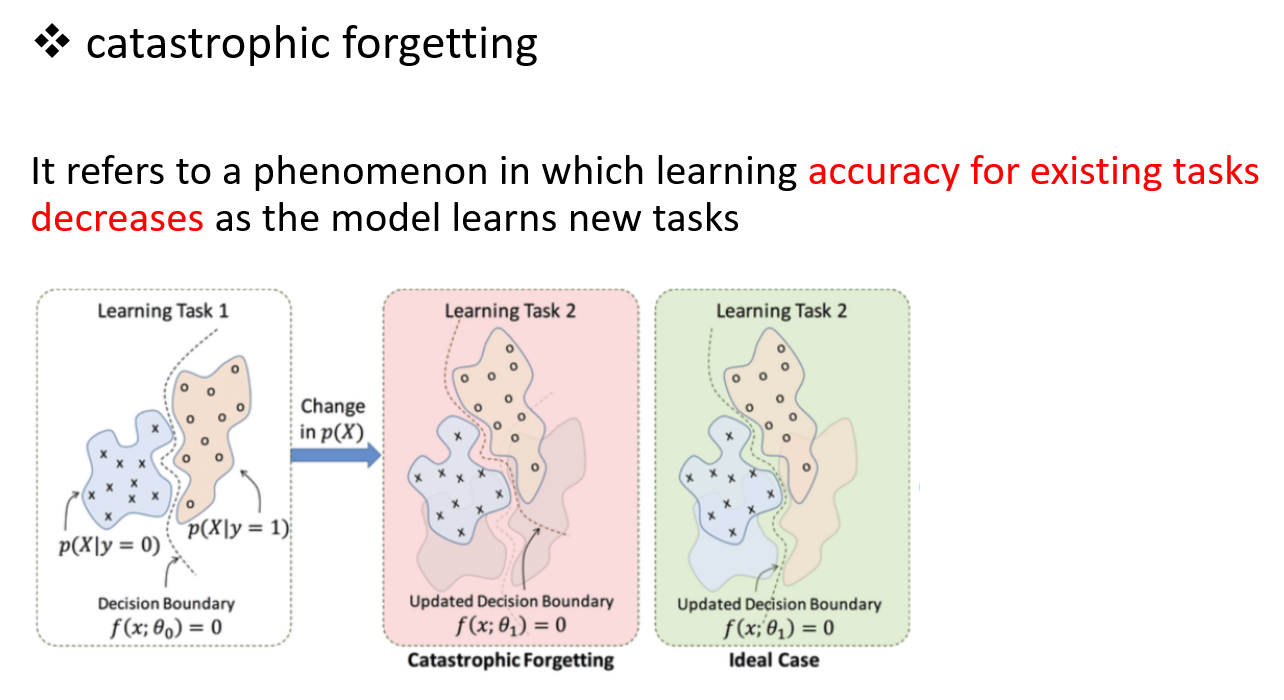

Catastrophic forgetting

하지만 multiple task를 위해 adapter를 여러개 추가하면, catastrophic forgetting 문제가 생긴다.

해당 문제는,

새로운 task에 대해 학습할 때, 기존의 task에 대한 성능이 떨어지는 것을 말한다.

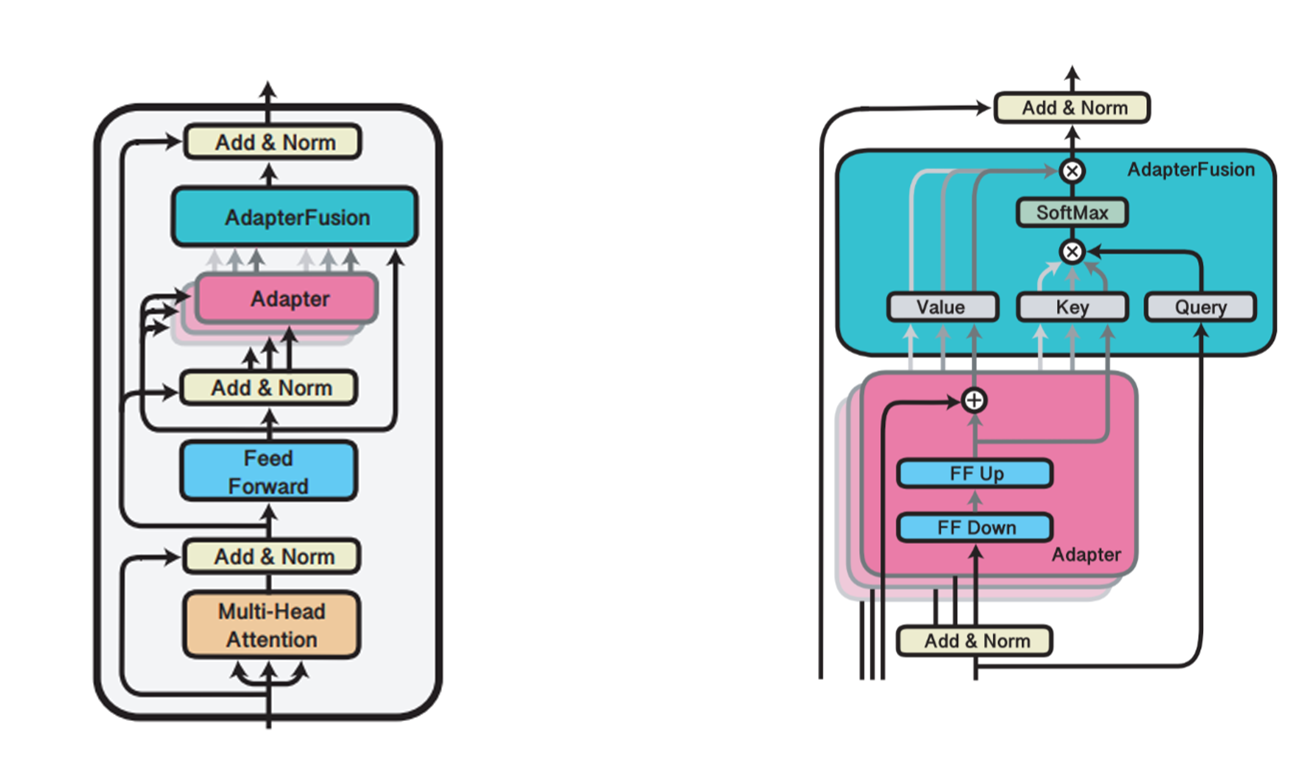

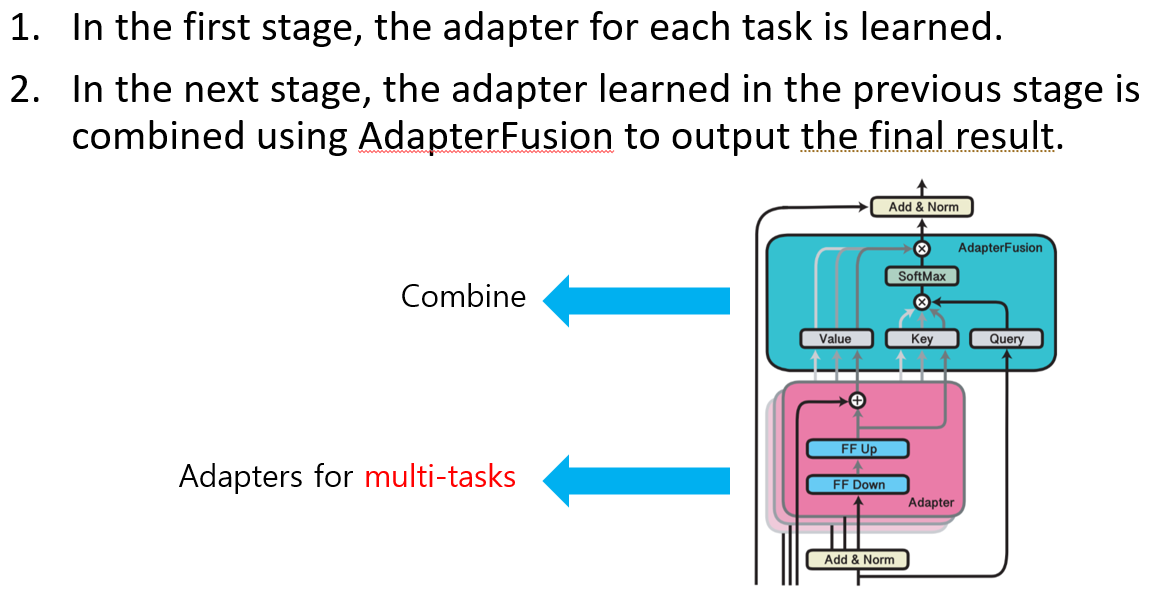

AdapterFusion

catastrophic forgetting problem을 해결하기 위해 adapter들을 fushion하는 layer를 추가하도록 논문은 제시한다.

Formulation

추가예정.