📝 A Self-Attentive model for Knowledge Tracing

📢 위 논문 리뷰입니다. 내용을 유지하되, 추가적으로 필요한 내용은 추가하고 시각화 자료를 만들어 재구성하며 정리하였습니다. 개인적으로 읽으며 이해가 어려웠던 부분을 모두 정리해 둔 글이기에 목적에 따라 굵직한 흐름만 이해하고 가셔도 충분합니다. 논의 및 피드백은 언제나 환영입니다😊

✅ Summary

📌 Knowledge Tracing

지식 추적(knowledge tracing)은 학생이 학습 활동을 수행할 때 각 지식 개념(KC)에 대한 학생의 숙련도를 모델링하는 과정입니다. 이를 통해 학생의 학습 활동 성과를 추정하고, 개인 맞춤형 학습을 제공하는 데 중요한 역할을 합니다.

📌 Related Works

최근에는 DKT와 DKVMN 같은 순환 신경망(RNN) 기반 모델들이 복잡한 학습 패턴을 포착하는 능력 덕분에 전통적인 방법보다 뛰어난 성과를 보였습니다. 하지만 DKT(Deep Knowledge Tracing)는 파라미터 해석 가능성 문제가 있었습니다. 또한, DKVMN(Dynamic Key-Value Memory Networks for Knowledge Tracing)은 KC 표현 행렬(키)과 지식 상태 표현 행렬(값)을 유지하여 DKT보다 해석 가능성이 높아졌으나, DKT 모델과 같은 RNN 기반이기 때문에 학생들이 비교적 적은 수의 KC와 상호작용하는 현실 데이터에서 발생하는 데이터 희소성 문제를 잘 처리하지 못하는 한계가 있습니다.

📌 Solution

이 문제를 해결하기 위해, 학생의 문제 풀이 이력 중 현재 푸는 문제의 KC와 관련 있는 KC들을 식별하고, 비교적 적은 수의 KC에 기반해 학생의 숙련도를 예측하는 자기 집중 지식 추적(Self Attentive Knowledge Tracing, SAKT) 방법이 제안되었습니다. SAKT는 모든 문제 풀이 이력을 사용하는 대신, 해당 KC와 관련된 주요 이력을 선택하여 데이터 희소성 문제를 효과적으로 처리합니다.

SAKT는 RNN 대신 self-attention 메커니즘을 활용하는 트랜스포머로 각 KC 간의 관련성을 파악하여 예측 정확도를 높입니다. 다양한 실제 데이터셋에서 실험한 결과, SAKT는 기존의 DKT 및 DKVMN 모델보다 더 나은 성과를 보였으며, 평균 AUC에서 4.43%의 향상을 달성했다고 합니다.

📢 본 포스팅에서 사용할 용어를 약속하고 넘어가겠습니다.

상호작용(interaction) = 문제 풀이 이력(문제 번호와 정오답 여부)

exercise = 문제

✅ PROPOSED METHOD

📢 이제 논문에서 제안한 방법을 긴 호흡으로 자세히 살펴볼 예정입니다. 제안한 방법을 자세히 들여다 보기 전에 최대한 이해하는 데 겪는 어려움을 줄이기 위한 두 가지 사전 작업을 거치고 가겠습니다. 세부 내용을 들여다 볼 때 아래 두 내용을 함께 띄워놓고 같이 보시길 권장합니다.

📌 사전 작업 1 : 기호 정의

먼저 기호 정의를 하겠습니다. 미리 인지하지 않고 들어가면 복잡한 모델 구조에 헷갈리는 기호까지 어렵습니다.

| 기호 | 설명 |

|---|---|

| 학생의 총 수 | |

| 문제의 총 수 | |

| 학생의 상호작용 시퀀스: () | |

| 학생의 i번째 문제-답 쌍 | |

| 시퀀스의 최대 길이 | |

| 잠재 벡터 차원 수 | |

| 학생이 해결한 문제의 시퀀스 | |

| 상호작용 임베딩 매트릭스 | |

| 위치 임베딩 매트릭스 | |

| 문제 조회 매트릭스 | |

| 과거 상호작용 임베딩 | |

| 문제 임베딩 |

📌 사전 작업 2 : 모델 전체 구조도

다음으로 복잡한 구조를 미리 전체 구조도를 한 번 보고 넘어가겠습니다. 아래 세부 내용을 확인하다가 헷갈릴 때도 한 번씩 확인하면 흐름을 확인하기에 좋습니다.

SAKT

├── Input Layer

│ └── Response Sequence y

│ └── Transformed Sequence s

├── Embedding Layers

│ ├── Interaction Embedding Layer (M)

│ └── Positional Embedding Layer (P)

│ ├── Exercise Embedding Layer (E)

├── Self-Attention Layer

│ ├── Scaled Dot-Product Attention

│ ├── Multiple Heads

│ ├── Residual Connections

│ └── Layer Normalization

├── Feed Forward Layer

│ ├── Feed Forward Network

│ ├── Residual Connections

│ └── Layer Normalization

└── Output Layer

├── Final Output (p_t)

└── Loss Calculation (L)

📢 이제 논문에서 기술한 순서를 따라가며 제안한 방법을 톺아보겠습니다.

📌 순차적 모델링 (Sequencial Modeling Problem)

순차적 모델링(sequential modeling)은 이전에 일어난 사건들이 다음에 일어날 사건에 영향을 미친다는 가정을 바탕으로 데이터를 처리하는 방식입니다. 지식 추적의 경우에는 학생이 푼 문제와 그에 대한 반응(정답 여부)이 다음 문제를 맞힐 가능성을 예측하는 데 영향을 준다는 가정으로 데이터를 처리하는 것인데요. 예를 들어보겠습니다.

학생이 다음 문제 을 풀 수 있을지 예측하려면 학생이 지금까지 풀었던 문제들 (t번 문제까지 풀었던 문제와 정오답 여부)로 다음 문제에서 정오답 여부를 예측하는 것입니다.

모델의 입력은 이전 상호작용들 이 되고, 다음 문제들은 가 됩니다. 여기서 모델은 각 문제에 대한 정답 여부를 예측합니다.

상호작용 는 라는 튜플 형식이고 는 문제 번호, 는 정답 여부입니다. 이 상호작용을 모델에 넣기 위해, 로 변환합니다. 여기서 는 총 문제 수이고, 가 정답이면 해당 문제 번호에 를 더해주고, 오답이면 그대로 두는 것이죠.

예를 들어보겠습니다.

문제 번호 et = 5, 총 문제 수 E = 100이라고 가정 # 정답인 경우 yt = et + rt × E = 5 + 1 × 100 = 5 + 100 = 105 # 오답인 경우 yt = et + rt × E = 5 + 0 × 100 = 5 + 0 = 5

이 방식으로 학생의 각 상호작용을 하나의 숫자로 변환해서 모델이 이해할 수 있도록 만듭니다.

📌 Embedding Layer

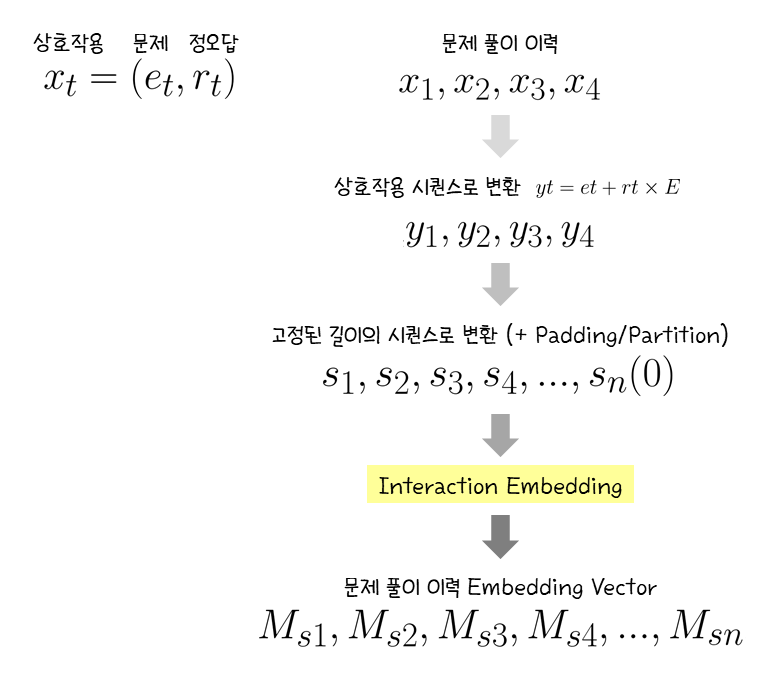

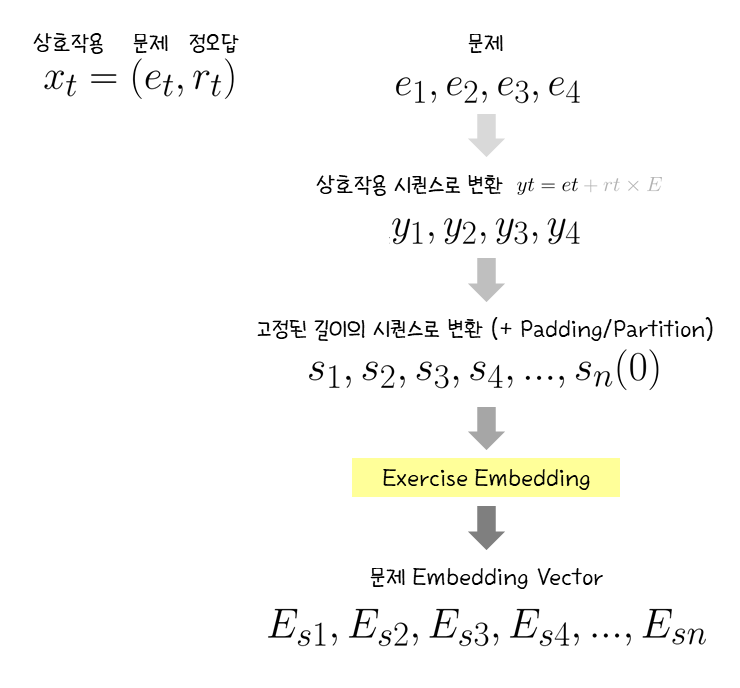

이제 임베딩 레이어를 거쳐 어텐션 계산을 위한 준비를 해주겠습니다. 임베딩 레이어에 넣을 입력값을 준비하는 과정, 임베딩 레이어를 거치며 일어나는 일, 출력값을 순서대로 보겠습니다.

1. 입력 시퀀스 변환 (y → s)

앞에서 모델 입력 형식을 라는 상호작용 시퀀스로 변환해 주었습니다. 각 는 학생이 어떤 문제를 풀고 맞혔는지 틀렸는지에 대한 정보를 담고 있습니다. 이제 이 시퀀스를 이라는 고정된 길이의 시퀀스로 변환해야 합니다. 여기서 은 모델이 처리할 수 있는 최대 시퀀스 길이입니다.

2. Padding & Partition

모델이 고정된 길이의 시퀀스만 처리할 수 있기 때문에 추가 작업이 필요합니다.

시퀀스 길이 t < 모델이 처리 가능한 최대 시퀀스 길이 n인 경우, 시퀀스 앞쪽에 빈 문제-정답 쌍(패딩)을 추가합니다. 예를 들어, 시퀀스 길이가 5이고 모델이 처리할 수 있는 최대 길이 n = 10이면, 앞에 5개의 패딩을 넣어 총 길이가 10이 되도록 맞추어 줍니다.

시퀀스 길이 t > 모델이 처리 가능한 최대 시퀀스 길이 n의 경우, 여러 개의 서브시퀀스로 나눕니다. 예를 들어, 시퀀스 길이가 25이고 n = 10이면, 시퀀스를 10개씩 끊어서 3개(10, 10, 5)의 서브시퀀스로 나눕니다. 이때 마지막 5개의 서브시퀀스는 역시 패딩을 추가해서 길이를 맞춥니다. 나눠진 모든 서브시퀀스는 모델의 입력으로 사용됩니다.

📢 임베딩을 입력값 준비를 마쳤습니다.

준비된 입력값은 임베딩 매트릭스에 들어갑니다. 임베딩은 서로 다른 값이 서로 다른 매트릭스인 Interaction Embedding M과 Exercise Embedding(Question Embedding) E를 거치게 됩니다.

3-1. Embedding Matrix : Interaction Embedding

위에서 준비한 입력값 는 interaction embedding matrix 에 입력됩니다. Interaction embedding matrix 을 지나면 각 (패딩 적용 가정)은 임베딩 벡터 을 출력으로 얻습니다.

이때, 은 크기 의 행렬인데, 여기서 는 문제의 개수, 는 임베딩 벡터의 차원 수입니다. 는 각 문제에 대해 두 가지 경우(정답 여부: 맞춤 또는 틀림)를 표현합니다.

임베딩 매트릭스 을 지나면서 숫자로 표현된 상호작용 정보가 벡터로 변환되는 것이죠. 이 벡터는 각 문제와 학생의 정오답 여부를 압축해서 의미 있는 정보를 담고 있습니다.

3-2. Embedding Matrix : Exercise Embedding E

다른 임베딩 매트릭스 Exercise Embedding Matrix 는 문제 자체를 벡터로 변환합니다. 는 크기 의 행렬로, interaction embedding matrix M에서와 동일하게 E는 문제 개수, d는 임베딩 차원 수입니다. 각 문제 는 이 행렬의 한 행에 대응되고, 그 행을 통해 문제에 대한 벡터 표현을 얻을 수 있습니다.

이 벡터는 학생이 현재 풀고 있는 문제에 대한 의미 있는 정보를 담고 있습니다.

4. Position Encoding

셀프 어텐션을 활용하는 장점은 여러 가지가 있습니다.

- 과거 문제 풀이 이력과 먼 시점의 문제와 현재 문제 간 관계를 파악하는 데 유리함

- 입력 시퀀스를 병렬 처리해서 학습 속도가 빠름

하지만 셀프 어텐션의 문제가 한 가지 있는데요. RNN, LSTM과 같은 모델은 시간적 순서를 명시적으로 처리하면서 상태를 지속적으로 업데이트하기 때문에 순서 정보를 자연스럽게 인식합니다. 반면, 셀프 어텐션은 Transformer의 attention mechanism을 활용하므로 시퀀스가 한 번에 병렬로 입력되어 단어 순서에 대한 정보를 담고 있지 않습니다. 따라서 단어 위치 정보를 추가해 주는데, 이 과정이 Position Encoding입니다. 포지션 인코딩은 순서 정보를 제공함으로써 지식 상태의 점진적 변화를 포착하고 지속적인 지식 추적을 가능하게 합니다.

🤔 지식 추적의 관점에서 문제 풀이 이력 벡터가 순서 정보를 담는 이유는 무엇일까요?

지식 상태는 학생이 특정 시간에 얼마나 많은 지식을 가지고 있는지를 나타냅니다. 이 상태는 학생의 문제 풀이 경험에 따라 서서히 진화하는 경향이 있습니다. 예를 들어, 학생이 덧셈 문제를 여러 번 풀면서 그 개념을 점진적으로 이해하게 되는 것입니다. 이러한 지식 상태는 Wavy transitions, 즉 학생의 지식 상태가 불규칙하게 변화하면 안됩니다. 어떤 문제에서 잘 풀었다가 다음 문제에서 갑자기 틀리는 식으로 지식 상태가 자주 변동하면 모델이 학생의 실제 학습 과정을 제대로 반영하지 못하게 됩니다. 따라서 지식 추적 모델에서는 이러한 불안정한 변화가 없도록 하는 것이 중요합니다.

만약 학생이 1번 문제에서 성공하고 2번 문제에서 실패했다면, 포지션 인코딩이 없으면 모델은 두 문제의 결과를 독립적으로 고려할 수 있습니다. 하지만 포지션 인코딩이 있다면, 모델은 문제의 순서와 과거의 성과를 바탕으로 학생의 지식 상태가 여전히 개선되고 있다는 점을 이해할 수 있게 됩니다. 이러한 접근은 학생이 각 문제를 통해 어떻게 배워가고 있는지를 명확히 추적할 수 있도록 하여, 이후 문제 풀이에서 어떤 개념이 더 필요할지를 예측하는 데 중요한 역할을 합니다.

이러한 맥락에서 포지션 인코딩은 상호작용 임베딩()에서 학생의 과거 상호작용의 순서를 인식하기 위해 적용되며, 이는 지식 상태를 시간에 따라 추적하는 데 필수적입니다. 반면, 문제 임베딩은 고정된 정보이기 때문에 포지션 인코딩이 필요하지 않습니다.

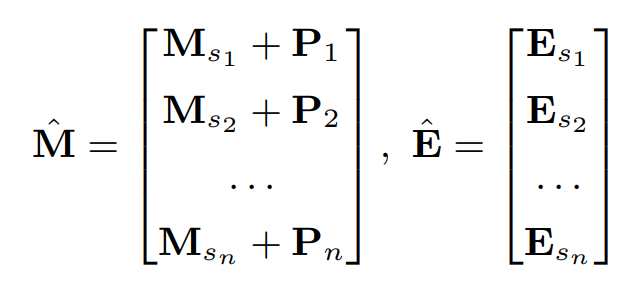

이렇게 포지션 인코딩까지 더해 SAKT 모델의 임베딩 레이어에서 생성되는 최종 출력은 문제 풀이 이력 벡터 과 현재 문제 벡터 입니다.

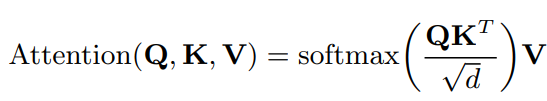

📌 Self-attention layer

앞에서 SAKT는 과거의 모든 활동을 사용하는 대신, 해당 KC와 관련된 중요한 활동만을 선택하여 데이터 희소성 문제를 더 효과적으로 처리한다고 했는데요. 현재 학생이 풀고 있는 문제와 이전 문제 풀이 이력의 연관성을 계산하기 위해 Self-attention 레이어를 거쳐 쿼리 𝑄, 키 𝐾, 값 𝑉를 생성합니다.

쿼리 () : 현재 문제의 정보로, 학생이 푸는 문제에 대한 표현 (from exercise embedding)

키 () : 이전 문제들의 정보를 나타내는 표현 (from interaction embedding)

값 () : 이전 문제의 결과(예: 정답 여부) (from interaction embedding)

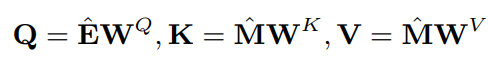

각 벡터(Q, K, V)는 다음과 같은 식을 통해 변환됩니다.

: 상호작용의 임베딩 매트릭스

: 운동(문제)의 임베딩 매트릭스

: 각각 쿼리, 키, 값의 투영 매트릭스

투영과 관련해서는 고수 블로거 분의 포스팅을 첨부합니다.

[선형대수학] 투영(projection)과 최소자승법(least square method)

지식 추적에서 투영 매트릭스가 활용되는 이유를 간단히 정리하면 데이터의 특성을 변형하고 다양한 공간으로 매핑함으로써 모델이 과거 문제 풀이 이력과 현재 문제 간의 연관성을 효과적으로 계산하여 학생의 지식 상태를 더 잘 추적할 수 있게 합니다.

이렇게 변환한 벡터 Q, K, V로 이전 상호작용과 현재 문제 간의 관련성을 계산하기 위해 어텐션 가중치를 사용하는데, 어텐션 가중치를 찾기 위해 scaled dot-product attention을 사용합니다. 어텐션 메커니즘은 다음과 같은 수식을 사용합니다.

는 쿼리와 키의 내적을 계산하여, 쿼리와 키 간의 유사도를 측정합니다. 로 나누는 것은 스케일링입니다. 이는 차원이 커질수록 내적 값이 커지는 경향이 있어, softmax 계산의 안정성을 높이기 위해 사용됩니다. softmax 함수는 유사도를 확률로 변환하여 각 이전 상호작용이 현재 문제에 얼마나 중요한지를 나타냅니다.

아래 사진에서 는 각각 를 와 내적을 계산하여 도출한 어텐션 가중치입니다.

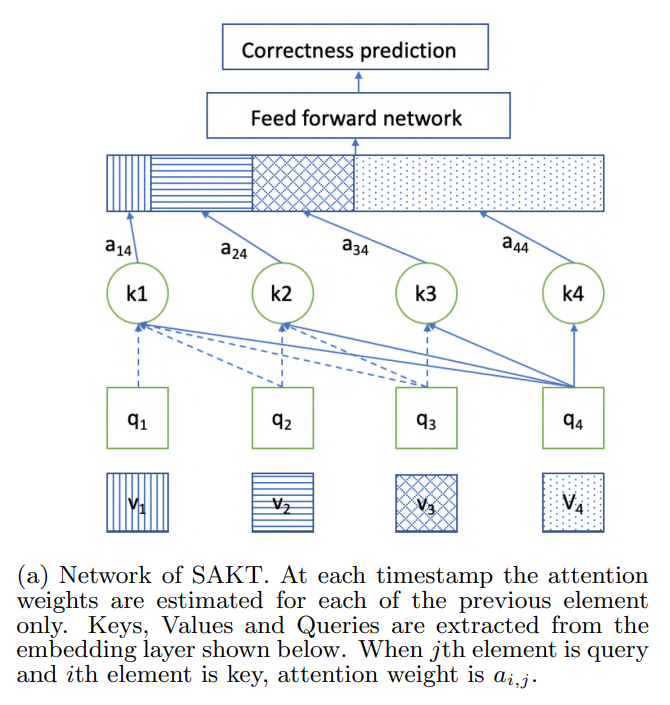

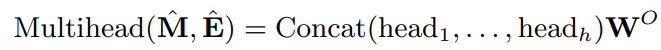

Multiple heads

멀티헤드 어텐션은 여러 개의 어텐션 헤드를 사용하여 서로 다른 서브스페이스에서 정보를 동시에 처리할 수 있도록 합니다. 이렇게 하면 모델이 다양한 정보에 주의를 기울일 수 있습니다.

: 임베딩된 상호작용 입력 매트릭스

: 임베딩된 연습 문제 매트릭스

: 각 헤드의 결과를 결합(concatenate)하는 함수

: 각 어텐션 헤드의 결과로 각 헤드는 독립적으로 정보를 처리합니다.

: 최종 출력을 위한 선형 변환 매트릭스로 이 매트릭스는 각 헤드의 결과를 결합한 후 최종 차원을 맞추기 위해 사용됩니다.

: 어텐션 헤드의 수

각 헤드의 계산 방식은 다음과 같습니다.

Causality

모델은 (𝑡+1)번째 문제의 결과를 예측할 때, 𝑡개의 상호작용만 고려해야 합니다. 즉, 현재 문제를 예측할 때 미래의 상호작용(예: 𝑗>𝑖)의 정보를 사용하면 안 됩니다. 이를 위해 causality layer를 사용하여 미래의 키에 대한 가중치를 마스킹합니다. 이 마스킹은 모델이 과거 상호작용만 고려하게 하여 정확한 예측을 가능하게 합니다.

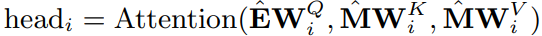

📌 Feed Forward layer

위에서 설명한 자체 attention 레이어는 이전 상호작용의 가중치 합인 를 생성합니다. 그러나 멀티헤드 레이어에서 얻은 행렬의 행인 Multihead()는 여전히 이전 상호작용의 값인 의 선형 조합입니다. 선형 변환만으로는 복잡한 데이터 패턴을 잘 모델링하기 어렵습니다. 예를 들어, 두 개의 선형 함수 는 두 변수 간의 관계를 직선으로 제한합니다. 하지만 많은 실제 데이터는 비선형적 관계를 가집니다. 따라서 모델에 활성화 함수(예: ReLU)를 통해 비선형성을 도입하여 비선형성을 통합하고 서로 다른 잠재 차원 간의 다양한 상호작용을 고려하여 모델 표현력 향상을 위해 피드 포워드 네트워크를 사용합니다.

: 비선형 활성화 함수로, 출력이 0보다 작으면 0으로 설정하고, 0보다 크면 그대로 출력

: 학습되는 파라미터 매트릭스로, 각각 𝑑×𝑑 차원

: 학습되는 편향 벡터로, 각각 𝑑 차원

📌 Residual Connections

잔차 연결은 낮은 레이어의 피처를 높은 레이어로 전파하는 데 사용됩니다. 이는 낮은 레이어의 정보가 예측에 중요할 경우, 이를 마지막 레이어로 쉽게 전달할 수 있게 해줍니다.

학생이 특정 개념에 속하는 문제를 푸는 경우, 잔차 연결이 최근에 해결된 문제의 임베딩을 마지막 레이어로 전파하여 낮은 레이어의 정보를 모델이 활용하기 쉽게 만듭니다.

잔차 연결은 self-attention 레이어와 피드포워드 레이어 각각의 뒤에 적용됩니다.

📌 Layer normalization

레이어 정규화는 입력을 정규화하여 신경망의 안정성과 학습 속도를 향상시키는 방법입니다. 입력을 정규화하면 각 레이어의 출력을 안정화하고, 학습 과정에서 더 빠르게 수렴하게 할 수 있습니다.

레이어 정규화은 self-attention 레이어와 피드포워드 레이어 각각의 뒤에 적용됩니다.

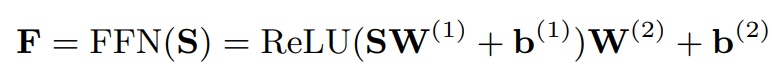

📌 Prediction layer

마지막으로 위에서 얻은 행렬 의 각 행은 Fully Connected Network를 통과시킨 후 이진 분류(정답/오답)을 예측하기 위해 최종적으로 0 과 1 사이의 값으로 출력하는 시그모이드 활성화 함수에 통과시켜 학생의 정오답을 예측합니다.

: 스칼라이며 학생이 운동 에 대한 올바른 응답을 제공할 확률

: 와 의 번째 행

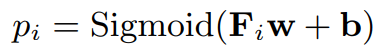

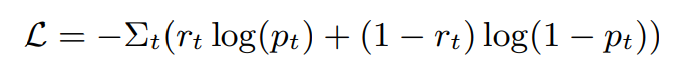

📌 Network Training

훈련의 목표는 모델 하에서 관찰된 학생 응답의 음의 로그 가능도를 최소화하는 것입니다. 파라미터는 와 사이의 크로스 엔트로피 손실을 최소화하는 방향으로 학습됩니다.

: 시간 𝑡에서 학생의 실제 응답(정답일 경우 1, 틀릴 경우 0)

: 모델이 예측한 정답 확률

✅ EXPERIMENTAL SETTINGS

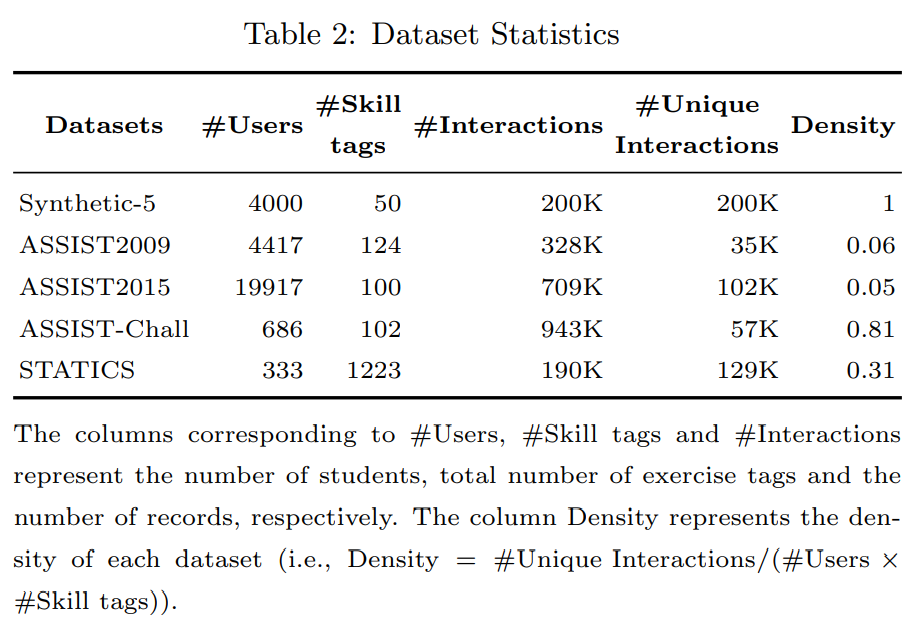

📌 Datasets

📌 Evaluation Methodology

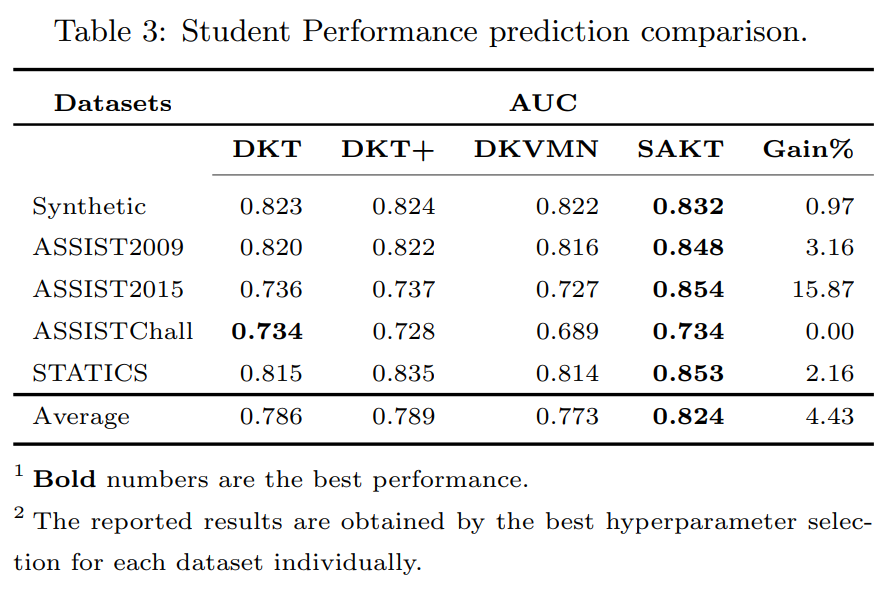

성능 비교를 위해 AUC(Area Under Curve) 지표를 사용했고, 최신 지식 추적(KT) 방법인 DKT, DKT+, 그리고 DKVMN과 비교했습니다.

모델 학습 시 전체 데이터셋 중 80%를 학습에 사용하고 나머지 20%를 테스트에 사용했습니다. 모든 방법에 대해 숨겨진 상태의 차원 𝑑는 {50, 100, 150, 200}을 시도했습니다. SAKT(Successive Attention Knowledge Tracing)는 TensorFlow로 구현되었으며, ADAM 옵티마이저를 사용해 학습률 0.001로 학습했습니다.

ASSISTChall 데이터셋은 배치 크기 256, 나머지 데이터셋은 128을 사용했습니다. 상호작용이 많은 데이터셋(ASSISTChall, ASSIST2015)에서는 드롭아웃 비율을 0.2로 설정했고, 다른 데이터셋에서는 0.2를 유지했습니다. 시퀀스의 최대 길이 𝑛은 학생당 평균 문제 태그 수에 비례하여 설정했습니다. ASSISTChall과 STATICS 데이터셋은 𝑛=500, ASSIST2009는 𝑛=100과 50, 인공 및 ASSIST2015 데이터셋은 𝑛=50으로 설정했습니다.

✅ RESULTS AND DISCUSSION

📌 Student Performance Prediction

SAKT 모델은 다양한 데이터셋에서 성능이 향상된 결과를 보여주며, 특히 어텐션 메커니즘이 효과적으로 작동하여 희소한 데이터셋에서도 강한 일반화 능력을 발휘합니다. Synthetic 데이터셋에서는 높은 상관관계를 통해 개념 간의 관계를 잘 이해하고, 다른 데이터셋에서도 경쟁력 있는 성능을 유지하고 있습니다.

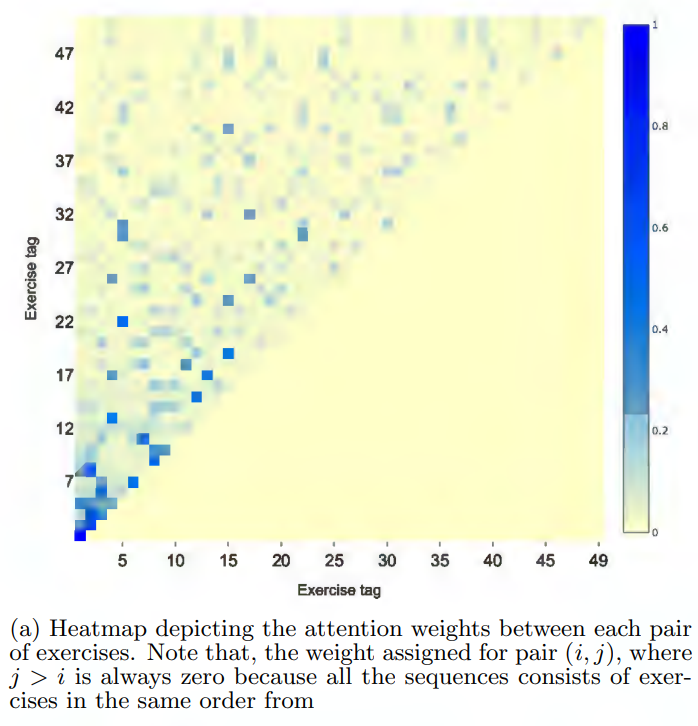

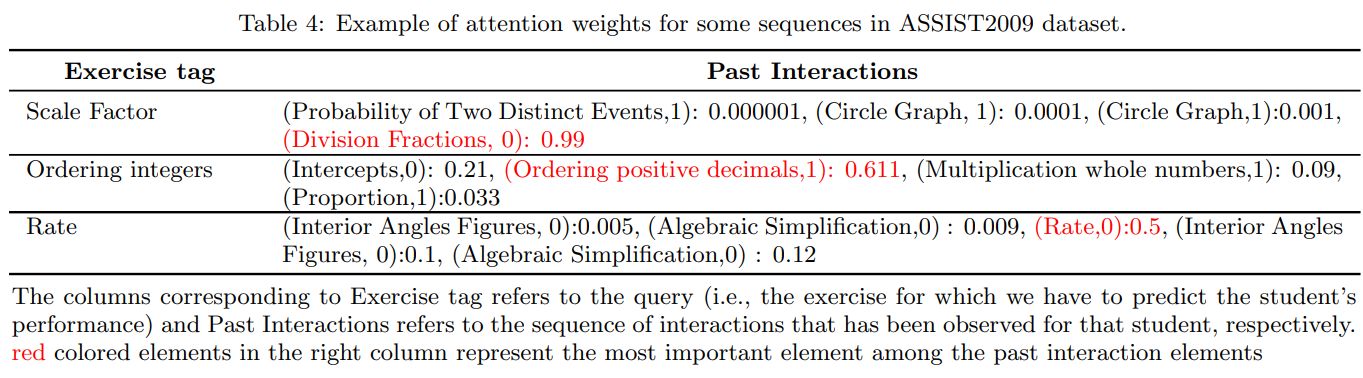

📌 Attention weights visualization

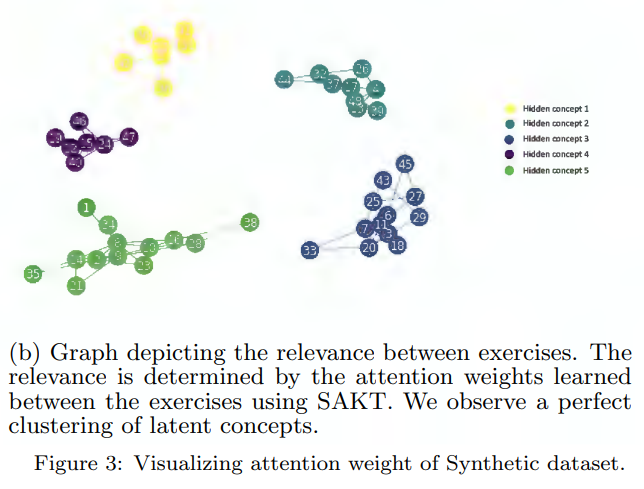

과거 상호작용에서의 각 문제(키 역할)와 학생이 다음에 풀 문제(쿼리 역할) 간의 어텐션 가중치를 시각화함으로써, 학생의 현재 문제 해결에 영향을 미치는 과거 문제들을 파악할 수 있습니다. 이를 통해 특정 문제 쌍(e1, e2) 간의 상관관계를 분석하고, 각 쿼리에 대한 가중치의 합이 1이 되도록 정규화하여 관련성 행렬(relevance matrix)을 만듭니다. 이 행렬의 각 요소 (e1, e2)는 e2가 e1에 미치는 영향을 나타냅니다.

Synthetic 데이터셋을 사용하여 분석을 수행합니다. 이 데이터셋은 숨겨진 개념(hidden concepts)이 알려져 있기 때문에 서로 다른 문제 간의 관련성에 대한 진실 값(ground truth)을 알 수 있습니다. 모든 시퀀스는 1에서 50까지의 모든 문제 태그로 구성됩니다.

유사도 행렬을 사용하여 문제 태그 간의 영향 그래프를 구축합니다. 각 숨겨진 개념에 해당하는 첫 번째 문제를 시퀀스에서 추출하고, 각 행을 방문하여 해당 행에 연결된 문제와 두 번째 문제를 연결합니다. 이 연결은 어텐션 가중치에 비례하여 정렬됩니다. 이 과정을 통해 문제 태그가 숨겨진 개념에 따라 완벽하게 군집화(clustering)됩니다.

흥미로운 점은 시퀀스에서 멀리 떨어져 있지만 동일한 개념에 속하는 두 가지 운동을 SAKT로 식별할 수 있다는 것입니다. 예를 들어, 쿼리 문제 22는 시퀀스에서 멀리 떨어져 있는 문제 5에 가장 많은 가중치를 할당합니다. 이는 두 문제 간의 상관관계가 멀리 떨어져 있음에도 불구하고 확인될 수 있음을 보여줍니다. 서로 관련 있는 두 문제는 높은 어텐션 가중치를 가지며, 하나의 문제에 대한 성과는 다른 문제의 성과에 영향을 미칠 수 있습니다.

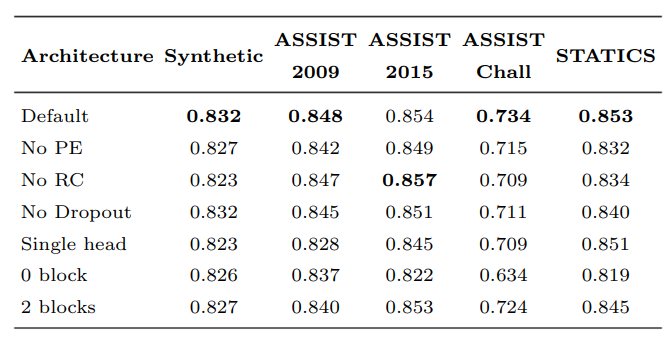

📌 Ablation Study

논문에서 ablation study는 특정 모델이나 시스템의 성능에 영향을 미치는 다양한 구성 요소나 기능을 평가하기 위한 실험적 접근법입니다. 이 연구 방법은 모델의 각 부분을 체계적으로 제거(또는 "탈락")하여 그 부분이 전체 성능에 미치는 영향을 분석합니다.

표 4는 d=200일 때 모든 데이터 세트에서 기본 SAKT 아키텍처와 모든 변형의 성능을 보여줍니다.

다음은 모델의 여러 변형 결과를 정리한 표와 결과입니다.

| 수정 내용 | 효과 | 관찰 결과 |

|---|---|---|

| 위치 인코딩 없음 (No Positional Encoding, PE) | 위치 인코딩을 제거함. 특정 운동에 대한 학생의 성과를 예측하는 데 사용되는 어텐션 가중치는 상호작용 임베딩에만 의존하고, 시퀀스에서의 위치는 무시됨. | 희소 데이터 세트(ASSIST2009, ASSIST2015)에서는 그 영향이 덜 뚜렷하게 나타났고, 밀집 데이터 세트(ASSISTChall, STATICS)에서는 더 두드러짐. |

| 잔차 연결 없음 (No Residual Connection, RC) | 잔차 연결을 제거함. 잔차 연결은 저수준 특징(상호작용 임베딩)을 유지하는 데 도움을 줌. | ASSIST2015에서는 잔차 연결 없이 성능이 향상되었으며, 이는 복잡성이 낮은 아키텍처에서의 제한된 이점을 나타냄. |

| 드롭아웃 없음 (No Dropout) | 드롭아웃 정규화를 제거함. 드롭아웃은 과적합을 방지하는 데 도움을 주며, 특히 훈련 레코드 수가 적은 모델에서 효과적임. | 데이터 수가 적은 데이터 세트(ASSIST2009 및 STATICS)에서 과적합 가능성이 높아 드롭아웃의 역할이 더 중요함. |

| 단일 헤드 (Single Head) | 기본 아키텍처에서 사용되는 다섯 개의 헤드 대신 단일 헤드만 사용함. 여러 헤드는 서로 다른 하위 공간에서 어텐션 가중치를 캡처하여 모델의 표현력을 향상시킴. | 모든 데이터 세트에서 단일 헤드를 사용할 때 성능이 일관되게 저하됨. |

| 블록 없음 (No Block) | 셀프 어텐션 블록을 제거함. 다음 운동의 예측이 마지막 상호작용에만 의존하게 됨. | 어텐션 블록이 없으면 성능이 크게 떨어져, 그 중요성을 강조함. |

| 2개 블록 (2 Blocks) | 셀프 어텐션 블록의 수를 두 개로 증가시킴. 매개변수 증가, 하지만 반드시 더 나은 성능으로 이어지지 않음. | 복잡성을 추가해도 성능이 개선되지 않아, 모델이 이미 필요한 상호작용을 효과적으로 캡처하고 있음을 나타냄. |

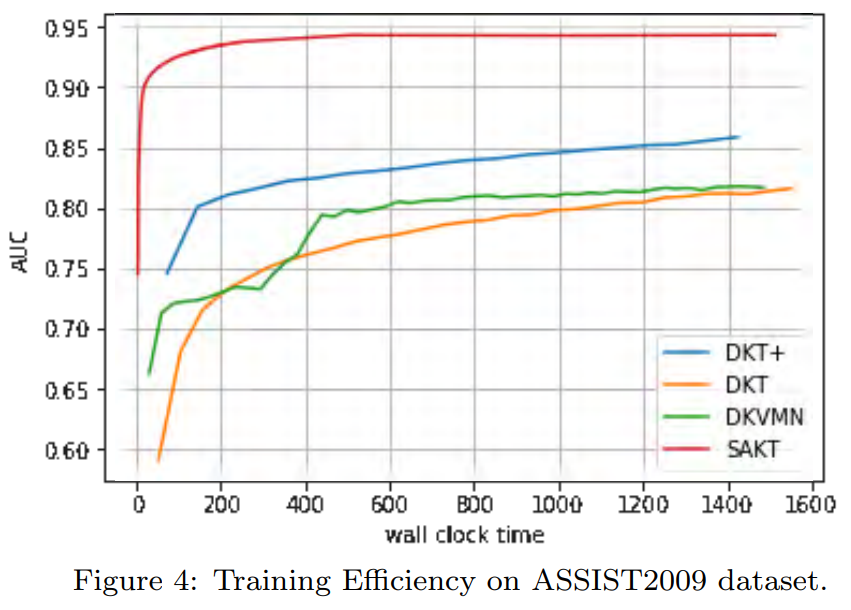

📌 Training efficiency

그림 4는 훈련 단계에서 GPU의 실행 시간에 따른 다양한 방법의 효율성을 보여줍니다.

NVIDIA Titan V 유형의 단일 GPU에서 실험을 수행

계산 효율성을 비교하면 SAKT는 한 에포크에서 1.4초만 소비하는데, 이는 DKT+(65초/에포크)가 소비한 시간보다 46.42초 적고, DKT(45초/에포크)보다 32배, DKVMN(26초/에포크)보다 17.33배 적습니다.

💡 Insight

SAKT는 self-attention 매커니즘을 활용하는 트랜스포머를 활용합니다. 핵심은 학생의 문제 풀이 이력을 바탕으로 현재 풀고 있는 문항과의 연관성을 고려하여 지식 추적을 함으로써 데이터 희소성 문제를 효과적으로 처리할 수 있다는 점이었는데요.

DKVMN(Dynamic Key-Value Memory Networks for Knowledge Tracing) 포스팅에서도 언급했던 웅진씽크빅 에듀테크 연구소에서는 DKVMN 모델을 활용하여 메타요소로 필요한 지식개념 추출을 하고 SAKT 모델을 활용하여 개별 문항에 대한 정답 확률을 예측하는 지식 추적 모델을 구축하였다고 합니다. 각 모델의 특징을 고려했을 때 지식 추적 효과를 높이기 좋은 아이디어라는 생각이 들었는데요. 자세한 구축 방법과 활용 현황을 확인해 보고 싶기도 했습니다.

개인적으로 현재까지 리뷰한 논문 중 SAKT 논문 리뷰에 가장 많은 시간을 쏟은 것 같습니다. 하지만 논문 리뷰를 진행할수록 논문 읽는 방법, 잘 정리하는 방법 등이 익혀지고 있어 확실히 성장하고 있다는 생각이 듭니다. 발표 순서대로 KT 논문을 리뷰하고 있는데요. KT뿐 아니라 AI 분야 자체가 워낙 빨리 발전하는 만큼 연구 결과도 빠르게 업데이트 되고 있어서 갈 길이 멀다는 생각이 들기도 하지만 기반을 잘 다지는 것이 중요하다는 믿음을 가지고 있는 만큼 차근차근히 내공을 쌓아가고 있습니다.

현재는 논문 리뷰 중심으로 스터디 중인데요. 이에 그치지 않고 코드 구현 및 인사이트를 바탕으로 데이터에 적합한 방법론을 찾아 적용하는 역량을 키워 나가고자 합니다.

추천 자료

이해가 잘 되도록 내용과 시각화 자료를 정리해 주셨습니다.

uoahvu(나연) 님 SAKT 포스팅

또한 본 글을 읽으시면서 Transformer에 대해 제대로 학습하기를 희망하시는 분들을 위해 잘 작성된 블로그 자료 추천 드립니다.

Tigris 님 Transformer 시리즈

코딩 오페라 님 Attention 시리즈