https://arxiv.org/pdf/2406.04692

https://github.com/togethercomputer/moa

- 요약

논문 "Mixture-of-Agents Enhances Large Language Model Capabilities"는 여러 개의 대형 언어 모델(LLM)을 협력적으로 사용하여 성능을 향상시키는 Mixture-of-Agents (MoA) 접근 방식을 제안하고 평가하는 연구입니다. 이 논문은 LLM들이 협력적으로 작업할 때 개별 모델보다 더 나은 성과를 낼 수 있다는 가정에 기반하고 있으며, 이를 위해 MoA 방법론을 사용하여 다양한 LLM의 출력을 통합하고 최적의 응답을 생성하는 시스템을 설계했습니다.주요 내용 요약:

-

연구 배경: 대형 언어 모델들은 서로 다른 데이터와 학습 방식을 통해 각기 다른 강점을 가지며, 이를 협력적으로 사용하면 더 나은 결과를 도출할 수 있다는 개념에서 출발합니다. 최근 LLM의 발전에도 불구하고, 단일 모델이 모든 작업에서 최적의 성능을 발휘하지는 못하므로, 여러 모델의 협력을 통해 성능을 향상시키는 방법론이 필요하다고 강조합니다.

-

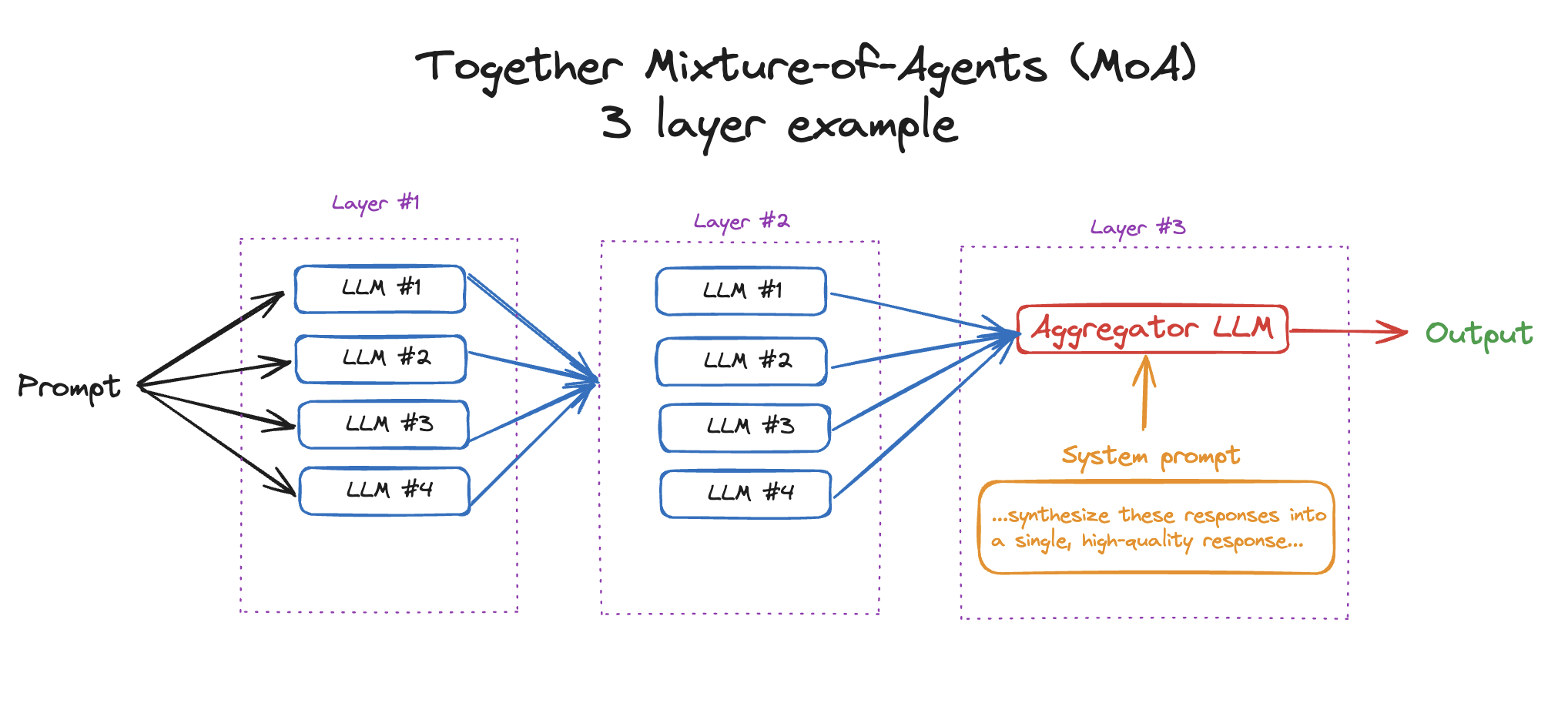

Mixture-of-Agents(MoA) 방법론:

- MoA는 여러 LLM을 층별로 구성하고, 각 층은 여러 제안자(Proposer)와 통합자(Aggregator)로 이루어져 있습니다.

- 제안자는 주어진 프롬프트에 대한 독립적인 응답을 생성하고, 통합자는 제안자들이 생성한 응답을 종합하여 최종 응답을 만들어냅니다.

- MoA는 여러 층을 통해 단계적으로 응답을 개선하는데, 각 층에서 제안자들이 응답을 생성하고, 그 응답들은 다음 층의 통합자에 의해 추가로 평가 및 조정됩니다. 이를 통해 최종적으로 더 세련되고 포괄적인 응답을 생성할 수 있습니다.

- MoA의 중요한 점은 여러 모델이 협력하여 상호 보완적인 강점을 최대한 활용할 수 있다는 것입니다. 이 방식은 모델 간의 상호작용을 통한 성능 개선을 목표로 합니다.

-

모델 구조:

- MoA는 여러 개의 LLM을 층별로 배치합니다. 첫 번째 층에서는 여러 모델이 동시에 응답을 생성하며, 각 응답은 상위 층에서 평가되고 개선됩니다.

- 제안자와 통합자는 각기 다른 역할을 수행하는데, 제안자는 다양하고 창의적인 응답을 제공하고, 통합자는 이 응답들을 종합하여 일관성 있고 신뢰할 수 있는 최종 응답을 생성합니다.

-

실험 결과:

- 논문에서는 MoA가 AlpaEval 2.0, MT-Bench, FLASK와 같은 벤치마크에서 GPT-4와 같은 단일 모델을 능가하는 성과를 보였다고 주장합니다.

- 특히 MoA는 GPT-4 Omni 대비 최대 65%의 승률 향상을 기록했으며, 더 적은 자원으로 더 높은 성능을 달성하는 비용 효율적인 시스템임을 입증했습니다.

-

비용 효율성:

- MoA는 성능 향상뿐만 아니라 비용 대비 효율성 측면에서도 탁월한 성과를 보였습니다. GPT-4 기반 시스템과 비교했을 때 MoA는 비슷한 성능을 더 적은 비용으로 제공하며, 모델의 예산과 연산 성능(TFLOPS) 간의 균형을 유지하면서도 우수한 결과를 얻을 수 있었습니다.

-

모델의 특화:

- MoA는 각 LLM의 강점을 최대한 활용하는 데 중점을 두며, 특정 LLM은 제안자로, 또 다른 LLM은 통합자로서 특화된 역할을 수행할 수 있도록 설계되었습니다. 이를 통해 다양한 작업에서 LLM의 협력적 성능을 극대화할 수 있었습니다.방법론 요약:

-

MoA의 구조는 기본적으로 여러 개의 LLM이 서로 다른 역할을 수행하는 구조로, 각 층에서 제안자(Proposer)가 먼저 응답을 생성하고, 이후 통합자(Aggregator)가 이를 취합해 더 나은 응답을 만들게 됩니다.

-

제안자는 다양한 응답을 제공하여 창의적이고 폭넓은 가능성을 제시하며, 통합자는 여러 응답 중에서 최상의 것을 선택하거나 결합해 최종 응답을 도출합니다.

-

이를 통해 MoA는 단일 LLM보다 성능이 더 뛰어나고 비용 효율적인 시스템을 구축할 수 있으며, 협력적 모델 구성을 통해 복잡한 작업에서도 높은 성능을 유지할 수 있음을 실험으로 증명했습니다.

결론:

이 연구는 다중 LLM의 협력적 접근 방식을 통해 성능을 극대화할 수 있는 가능성을 보여줍니다. 특히, MoA는 단일 모델이 가지는 한계를 극복하고 더 높은 품질의 응답을 생성할 수 있도록 여러 모델의 장점을 결합한 혁신적인 방법을 제시합니다. 이 연구는 LLM의 상호작용을 극대화할 수 있는 새로운 방법론으로, 대형 언어 모델의 성능 향상을 위한 중요한 연구로 평가됩니다.

-

에이전트 관련 추가 설명

에이전트(Agent)는 인공지능과 컴퓨터 과학에서 주로 '스스로 행동하거나 결정을 내릴 수 있는 독립적인 컴퓨터 프로그램'을 의미합니다. 기본적으로, 에이전트는 어떤 주어진 환경에서 정보를 수집하고, 그 정보를 바탕으로 판단을 내리며, 그에 맞는 행동을 실행하는 시스템입니다.

에이전트의 일반적인 기능

에이전트는 크게 네 가지 주요 기능을 가집니다:

-

환경 인식: 에이전트는 외부 환경이나 시스템으로부터 데이터를 수집합니다. 이 환경 정보는 에이전트가 어떻게 반응할지를 결정하는 데 중요한 요소가 됩니다.

-

판단: 수집된 정보를 바탕으로 에이전트는 상황에 대한 분석을 하고, 목표를 달성하기 위해 어떤 행동을 할지 결정합니다.

-

행동: 판단한 내용을 바탕으로 실제로 행동합니다. 예를 들어, 어떤 문제를 해결하기 위해 데이터를 처리하거나, 대화형 AI라면 질문에 대한 답변을 생성하는 행동을 할 수 있습니다.

-

학습(선택 사항): 일부 에이전트는 자신이 한 행동에 대한 결과를 바탕으로 학습하여, 다음에 더 나은 결정을 내릴 수 있게 됩니다. 이를 통해 시간이 지남에 따라 성능을 개선할 수 있습니다.

이 논문에서 말하는 에이전트란?

논문에서 언급된 에이전트는 특정 작업을 수행하는 개별적인 언어 모델(LLM)을 의미합니다. 이 연구에서는 여러 LLM들이 서로 다른 역할을 맡아 협력하는 시스템을 설명하고 있는데, 여기서 각 LLM을 에이전트라고 부릅니다.

논문의 Mixture-of-Agents (MoA) 방법론에서는 여러 LLM(에이전트)들이 함께 작동하여 최종적으로 더 나은 답변을 생성하는 과정이 포함됩니다. 각 에이전트는 독립적으로 응답을 생성하거나, 다른 에이전트들의 출력을 통합하는 역할을 맡습니다.

MoA에서의 에이전트 역할

MoA에서는 에이전트들이 두 가지 중요한 역할을 수행합니다:

-

제안자 (Proposer): 주어진 질문이나 입력에 대해 각 에이전트가 독립적으로 응답을 생성합니다. 제안자 에이전트들은 다양한 응답을 제시하며, 이 응답들은 각각의 관점이나 방식에서 생성된 것입니다.

-

통합자 (Aggregator): 제안자들이 생성한 여러 응답을 종합하여 최종적인 하나의 응답으로 통합합니다. 통합자는 제안자들이 제시한 응답을 평가하고, 가장 적절한 응답을 선택하거나 여러 응답을 결합해 더 나은 결과를 만들어냅니다.

이 방식으로 여러 에이전트가 협력하여 더 나은 성능을 발휘할 수 있으며, 개별 LLM의 한계를 극복할 수 있게 됩니다.

예를 들어:

-

제안자 에이전트가 세 가지 질문에 대한 답변을 각각 생성했다고 가정합시다.

- 에이전트 1: "서울은 대한민국의 수도입니다."

- 에이전트 2: "서울은 인구가 약 1천만 명입니다."

- 에이전트 3: "서울은 한반도 중서부에 위치합니다."

-

통합자 에이전트는 이 세 가지 답변을 종합하여 하나의 응답을 생성합니다.

- "서울은 대한민국의 수도로, 인구가 약 1천만 명이며, 한반도 중서부에 위치해 있습니다."이처럼 에이전트들은 서로 다른 응답을 제안하고, 그 제안들을 결합하여 최종적인 응답을 만들어 내는 방식으로 작동합니다. MoA 방법론은 이러한 에이전트 간 협력을 통해 더 나은 결과를 도출할 수 있다는 점에서 매우 유용한 접근법입니다.

-

-

에이전트 혼합(Mixture-of-Agents)이 대형 언어 모델의 성능을 향상시킨다

초록

대형 언어 모델(LLM)의 최근 발전은 언어 이해와 생성 작업에서 상당한 능력을 보여주고 있습니다. 많은 LLM이 등장하면서 여러 LLM의 공동 전문 지식을 활용하는 것이 새로운 가능성의 길을 열고 있습니다. 이러한 목표를 위해, 우리는 여러 LLM의 공동 능력을 활용하는 새로운 접근 방식을 제안합니다. 우리의 Mixture-of-Agents(MoA) 기술은 여러 LLM을 활용하며, 각 층은 여러 LLM 에이전트를 갖고 있습니다. 각 에이전트는 이전 층의 출력을 입력으로 받아들이며, 보조 정보 없이 고유한 결정을 내립니다. 우리의 MoA 접근 방식은 벤치마크 작업에서 뛰어난 성능을 발휘하였으며, 예를 들어 GPT-4 Omni, Bison, Falcon, 및 FLAN과 같은 여러 LLM을 사용할 때, MoA는 AlpaEva로 작업했을 때 65.1%라는 성과를 기록했습니다. 이는 GPT-4 Omni의 57.5%와 비교됩니다.

1 서론

대형 언어 모델(LLM)(Zhang et al., 2022a; Chowdhery et al., 2022; Touvron et al., 2023a; Touvron et al., 2023b; Brown et al., 2020; OpenAI, 2023)은 최근 몇 년 동안 자연어 이해와 생성에서 크게 발전했습니다. 이러한 모델은 대규모 데이터를 기반으로 학습되며, 일반적으로 단일 LLM이 주어진 작업을 수행하는 것이 일반적입니다. 그러나 최근 연구들은 LLM의 선호도와 강점이 모델마다 다를 수 있음을 보여줍니다(Dodge et al., 2021). 또한, 다양한 LLM들은 서로 다른 학습 데이터와 구조로 인해 독특한 한계와 강점을 가집니다(Zhang et al., 2022a). 추가 연구는 이러한 LLM의 결합이 성능 향상에 어떻게 기여할 수 있는지에 대해 탐구하고 있습니다(Muennighoff et al., 2023).

동시에, LLM은 다양한 작업에서 독특한 강점을 보입니다. 예를 들어, 일부 모델은 특정 지침에 따른 상호작용에서 더 잘 수행됩니다(Wang et al., 2023a), 반면 다른 모델들은 특정 영역에서 우수한 성능을 보입니다(Rogriguez et al., 2023). 이러한 차이는 여러 LLM의 집단적 능력을 활용하는 방법에 대한 질문을 제기합니다. 우리는 어떻게 여러 LLM의 전문 지식을 결합하여 더 뛰어난 모델을 만들 수 있을까요?

이 질문에 대한 우리의 답은 LLM의 협력적 특성에 주목하는 것입니다. 우리는 LLM들이 다른 모델보다 더 나은 응답을 생성하는 사례에서 이러한 협력적 특성을 활용할 수 있는 가능성을 탐구합니다.

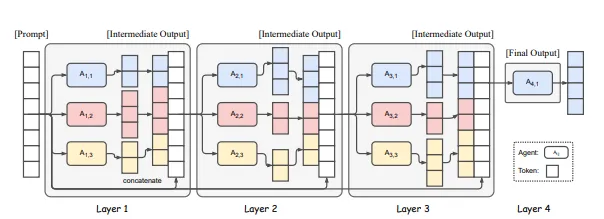

Figure 2: Mixture-of-Agents 구조의 예시. 이 그림은 각 층에 3개의 에이전트를 포함한 4개의 MoA 층을 보여줍니다. 각 층의 에이전트들은 동일한 모델을 공유할 수 있습니다.

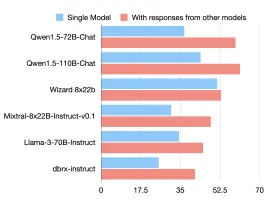

이 모델들이 다른 모델들로부터 독립적으로 답변을 생성할 때, 이들의 LC 승률(LC win rate)은 상당히 향상됩니다. 이는 협력적인 현상이 여러 LLM에 걸쳐 광범위하게 나타난다는 것을 시사합니다. 놀랍게도, 이 개선은 보조 정보를 사용하지 않은 경우에도 발생하며, 이때 LLM의 응답은 다른 모델이 생성한 응답보다 질적으로 우수합니다.

이 논문에서는 LLM의 협력 능력을 활용하여 응답의 질을 높이는 Mixture-of-Agents (MoA) 방법을 제안합니다. 그림 2는 MoA의 구조를 설명합니다. 처음에, 1층에 있는 LLM들은 에이전트로 간주되어 와 같이 같은 프롬프트에 대한 독립적인 응답을 생성합니다. 그런 다음 이 응답들은 다음 층의 에이전트 에게 전달되어 추가적인 개선을 위해 반복됩니다. 이러한 성능 향상 과정은 여러 층에 걸쳐 이어지며, 보다 강력하고 종합적인 응답을 얻게 됩니다.

모델 간의 협력을 극대화하고 전반적인 응답 품질을 개선하기 위해, 각 LLM의 선택은 각 MoA 층에서 신중하게 이루어집니다. 이 선택 과정은 두 가지 주요 기준에 의해 결정됩니다:

- 성능 지표: 각 층에서 모델의 평균 승률이 다음 층으로의 포함 가능성을 결정하는 데 중요한 역할을 합니다.

- 모델 다양성: 고품질 응답을 생성할 수 있는 LLM을 다양하게 배치하여 상호 협력의 이점을 최적화합니다. 이러한 방식으로 각 층에서 생성된 응답은 이전보다 개선된 성능을 보여줍니다.

우리는 AlpaEva 2.0, MT-Bench(Zheng et al., 2023), FLASK 등의 벤치마크에서 우리의 방법을 실험적으로 검증하였으며, MoA는 65.8%의 승률을 기록하여 GPT-4 Omni의 57.5%와 비교해 더 나은 성과를 보였습니다.

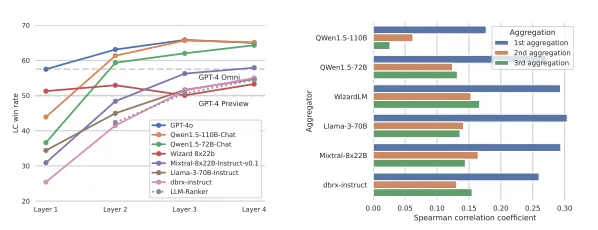

Figure 1: AlpaEva 2.0 LC 승률 비교. 다른 모델의 응답과 함께 제공될 때, 승률이 크게 향상되는 모습을 볼 수 있습니다.

우리의 주요 기여는 다음과 같이 요약됩니다:

- 새로운 프레임워크: Mixture-of-Agents 구조는 여러 LLM의 협력적인 능력을 극대화하여 성능을 높였습니다.

- 집단적 응답 생성: 모델 간 협력과 응답 품질의 향상에 중점을 두어 각 모델이 독립적으로는 얻기 힘든 결과를 얻었습니다.

- 상태-of-the-art 성능: 우리는 AlpaEva 2.0, MT-Bench, FLASK에서 탁월한 성능을 달성했으며, 이는 최신 모델의 성능을 크게 능가합니다.

2. Mixture-of-Agents 방법론

이 섹션에서는 여러 모델을 활용하여 성능을 향상시키기 위한 우리의 제안 방법론을 소개합니다. 우리는 LLM이 협력적 역할을 수행하여 다른 모델들의 출력을 기반으로 성능을 향상시킬 수 있음을 보여줍니다. 이후 Mixture-of-Agents 방법론을 소개하고 그 설계 방식에 대해 논의합니다.

2.1 LLM의 협력 능력

우리는 LLM의 협력 능력을 증명하는 것에서 시작합니다. 구체적으로, 다른 모델들의 출력을 참조할 수 있을 때 더 나은 품질의 응답을 생성하는 능력을 보여줍니다. 그림 1과 그림 2에서 볼 수 있듯이, 오늘날의 다양한 LLM은 협력적 능력을 보유하고 있습니다.

다중 LLM에서 최대의 이익을 얻기 위한 중요한 경로는 각 모델이 협력 과정에서 얼마나 다양한 측면에서 뛰어난지를 파악하는 것입니다. 협력 과정에서 우리는 LLM을 두 가지 구별된 역할로 신중하게 나눌 수 있습니다:

- Proposer(제안자): 다른 모델에서 사용될 참조 응답을 생성하는 역할입니다. 뛰어난 제안자는 반드시 최종 응답을 생성하는 것이 아니라, 종종 더 복잡하고 다양한 관점에서 강력한 중간 응답을 제공하여 최종 응답의 품질을 높이게 됩니다.

- Aggregator(통합자): 다른 모델에서 받은 출력들을 통합하여 고품질의 응답을 생성하는 역할입니다. 뛰어난 통합자는 다른 모델들의 응답을 유지하거나 더 나은 품질로 개선하는 능력을 갖추고 있어야 합니다.

섹션 3.2에서는 제안자와 통합자의 역할을 경험적으로 분석합니다. 구체적으로, 우리는 많은 LLM이 제안자 또는 통합자로서의 능력을 표시함을 보여줍니다. 예를 들어, GPT-4, Qwen, LLaMA는 주로 제안자로서 뛰어난 성능을 보이며, 독립적인 응답 생성에서 우수한 성과를 거두었습니다. 반면, Wizard.LM은 통합자로서 응답의 품질을 종합하는 데 뛰어난 성과를 보였습니다.

제안자가 다른 모델들의 출력을 사용하여 더 높은 품질의 응답을 생성할 수 있다는 점을 고려할 때, 우리는 응답을 집계하는 통합자의 역할이 얼마나 중요한지를 탐구합니다. 제안자와 통합자는 응답을 생성하는 능력에서 상호 보완적 역할을 합니다. 이러한 방식으로, 협력적 응답 생성 과정에서 각 모델이 가지고 있는 강점을 통합하여 더 나은 최종 결과를 얻을 수 있습니다. 이것이 Mixture-of-Agents 방법론의 설계 원리입니다.

2.2 Mixture-of-Agents

그림 2는 MoA의 구조를 설명합니다. MoA는 개의 층을 가지며, 각 층은개의 LLM으로 구성되어 있습니다. 이를 로 표시합니다. 중요한 점은 LLM이 동일 층 내에서 또는 다른 층에 걸쳐 재사용될 수 있다는 것입니다. 많은 LLM들이 독립적인 응답을 생성하는 반면, 우리는 이러한 응답들이 종합적으로 평가되고 선택된 후 다시 통합되는 과정을 통해 최종 응답이 생성됩니다.

MoA의 응답 생성 과정은 아래 식으로 나타낼 수 있습니다:

여기서 는 텍스트를 연결한 결과를 의미하며, 는 LLM의 출력을 나타냅니다.

Table 1: 다른 모델의 응답을 통합하기 위한 Aggregate-and-Synthesize 프롬프트

다양한 오픈소스 모델에서 생성된 응답이 주어졌습니다. 당신의 작업은 이러한 응답을 하나의 고품질 응답으로 종합하는 것입니다. 이 작업에서 정보가 명확하고 정확한지 확인해야 하며, 주어진 일부 응답이 틀릴 수 있음을 고려하십시오. 단순히 응답을 결합하는 것만이 아니라, 잘 구성되고 포괄적이며 질문에 적절히 응답하는 최종 응답을 생성해야 합니다. 최종 응답은 잘 구성되어야 하며, 최고의 표준을 준수해야 합니다.

- [Model Response from ]

- [Model Response from ]

- [Model Response from ]

2.3 Mixture-of-Experts와의 유사성

Mixture-of-Experts(MoE)(Shazeer et al., 2017)는 여러 전문 네트워크들이 서로 다른 데이터 집합에서 특화된 역할을 수행하는 기계 학습에서 잘 확립된 기법입니다. MoE 접근 방식은 다양한 문제 해결 작업에서 모델의 역량을 활용함으로써 뛰어난 성능을 보여주었으며, 우리의 MoA 방법도 이 기법에서 영감을 얻었습니다.

일반적인 MoE 설계는 MoE 층으로 이루어진 스택으로 구성됩니다. 각 층은 전문가 네트워크의 게이트 역할을 하는 스위칭 네트워크와 경사 하강 최적화를 위한 잔차 연결로 구성됩니다. 공식적으로, 각 층 에서 이는 다음과 같이 표현될 수 있습니다:

여기서 는 전문가 와 대응되는 게이팅 네트워크를 나타내고, 는 전문가 네트워크 에서 생성된 출력입니다. 여러 전문가의 활용은 모델이 서로 다른 데이터 집합을 처리할 수 있도록 허용합니다.

높은 수준에서 보면, 우리의 제안인 MoA 프레임워크는 MoE 개념을 모델 레벨로 확장합니다. 각 층에 여러 LLM이 배치되어 다중 전문가 네트워크의 형태를 띠며, MoA 접근 방식은 이러한 LLM들 간의 협력적 상호작용을 통해 응답 품질을 향상시킵니다. 우리는 게이팅 네트워크와 잔차 연결을 사용하지 않으며, 대신 응답을 통합하고 개선하는 과정을 거쳐 최종 결과를 생성합니다.

3. 평가

이 섹션에서는 우리의 제안한 MoA의 포괄적인 평가를 제공합니다. 우리의 주요 발견은 다음과 같습니다:

- 우리는 AlpaEval 2.0, MT-Bench, 그리고 FLASK 벤치마크에서 MoA가 상당한 성능 향상을 달성했음을 확인했습니다. 특히, 오픈소스 모델에서 MoA는 GPT-4 Omni 및 FLASK에서 더 나은 성과를 보였습니다.

- 우리는 추가 실험을 통해 MoA의 내부 메커니즘을 더 잘 이해하기 위한 연구를 진행했습니다.

- 세부적인 비용 분석을 통해, MoA는 GPT-4 Turbo에 비해 2배 더 비용 효율적인 성능을 제공할 수 있음을 확인했습니다.

Table 2: AlpaEval 2.0 및 MT-Bench의 결과.

AlpaEval 2.0에서 MoA와 MoA-Lite는 각각 3개의 층을 가진 6개의 제안자와 2개의 층을 가진 4개의 제안자로 구성됩니다. MoA w/ GPT-4는 MoA 모델이 GPT-4를 사용하는 실험입니다. 우리는 각 실험의 평균 점수와 표준 편차를 보고하며, *는 AlpaEval 결과의 복제본을 나타냅니다. 모든 MT-Bench 점수는 각 실험의 평균 기반 점수를 나타냅니다.

(a) AlpaEval 2.0

| 모델 | LC win% | 승률 | stddev |

|---|---|---|---|

| MoA w/ GPT-4 | 65.8% | 78.7 | ±2.2 |

| MoA-Lite | 55.0% | 71.5 | ±2.8 |

| GPT-4 Turbo (04/09) | 57.5% | 57.5 | ±2.1 |

| GPT-4 Omni (05/15) | 51.0% | 54.2 | ±1.6 |

| WizardLM 7B v1.0 | 36.0% | 35.9 | ±3.5 |

| Qwen-5 7B Chat | 35.5% | 37.8 | ±2.4 |

| GPT-4 Preview (11/06) | 49.0% | 51.2 | ±2.0 |

| GPT-3.5 Turbo | 31.5% | 31.5 | ±2.7 |

| LLaMA 3 7B Instruct | 33.0% | 32.9 | ±3.3 |

| Mistral X28B v1.0.1 | 30.5% | 29.6 | ±3.1 |

(b) MT-Bench

| 모델 | 평균 1차 점수 | 1등 점수 | 2등 점수 |

|---|---|---|---|

| MoA w/ GPT-4 | 9.45 | 9.49 | 9.39 |

| GPT-4 Turbo (04/09) | 9.05 | 9.15 | 8.98 |

| GPT-4 Preview (11/06) | 8.86 | 9.04 | 8.70 |

| GPT-4 Omni (05/15) | 8.74 | 8.84 | 8.60 |

| WizardLM 13B Inst v3 | 8.45 | 8.55 | 8.34 |

| LLaMA 3 7B Instruct | 8.25 | 8.30 | 8.15 |

| Qwen-5 7B Chat | 8.34 | 8.55 | 8.04 |

| Mistral X28B v1.0.1 | 8.46 | 8.61 | 8.34 |

3.1 설정

벤치마크

우리는 주로 AlpaEval 2.0 (Dubois et al., 2024)을 사용하여 모델을 평가했습니다. AlpaEval은 인간 선호도를 반영하는 대표적인 테스트로, 실제 사용 사례를 대표하는 다양한 작업을 포함하고 있습니다. 각 모델의 응답은 GPT-4 점수와 비교됩니다. 이를 통해 편향이 제거된 비교를 보장하며, 평가 기준으로는 승률(Loss-Controlled, LC)을 사용하여 편향을 최소화합니다.

또한, MT-Bench(Zheng et al., 2023) 및 FLASK(Ye et al., 2023)에서 추가적인 평가를 수행했습니다. MT-Bench는 모델의 성능을 점수로 평가하고, FLASK는 더 세밀한 성능 분석을 제공합니다.

모델

우리의 연구에서, 우리는 오직 오픈소스 모델만을 사용하여 기본 MoA를 구성했습니다. 실험에 사용된 모델로는 WizardLM-1.0B Chat, Qwen-5 72B Chat, WizardLM-X28B v2, Qwen-1.0B Chat, LLaMA-3 70B Instruct 등이 있습니다. GPT-4 기반의 MoA와 비교했을 때, 우리의 MoA는 비용 효율성 면에서 뛰어난 성과를 달성했습니다.

3.2 벤치마크 결과

이 섹션에서는 AlpaEval 2.0, MT-Bench, 및 FLASK에서 평가한 결과를 제공합니다. 이 벤치마크를 통해 우리의 접근 방식과 최신 LLM 성능을 비교할 수 있었습니다.

AlpaEval 2.0

우리는 GPT-4 및 다른 최첨단 오픈소스 모델들과의 비교 실험을 수행했습니다. Table 2에서 자세한 결과를 볼 수 있으며, 우리의 MoA 방법론은 AlpaEval 2.0 리더보드에서 GPT-4 Omni 대비 8.2% 더 높은 성과를 달성했습니다. 특히 주목할 점은 GPT-4 Omni보다 GPT-4 Turbo가 오픈소스 모델과 더 유사한 성과를 보였다는 것입니다. 우리의 MoA 방법론은 GPT-4 Omni의 57.5%에서 MoA의 65.1%로, 실질적인 성능 향상을 기록했습니다. 또한, 더 높은 비용 효율성을 보였습니다. 이러한 접근법은 더 적은 리소스를 사용하면서도 성능을 향상시켰으며, GPT-4 Turbo를 능가하는 결과를 보여줍니다.

MT-Bench

MT-Bench에서의 개별 모델 성능 개선은 미미한 편이지만, 이미 대부분의 모델이 이 벤치마크에서 뛰어난 성과를 기록하고 있음에도 불구하고 우리의 접근법은 여전히 경쟁력을 유지합니다. 특히, 단일 모델로 9.0 이상의 점수를 달성했습니다. 우리의 MoA가 MT-Bench에서 리더보드 상위권을 유지하며 뛰어난 성능을 입증했습니다.

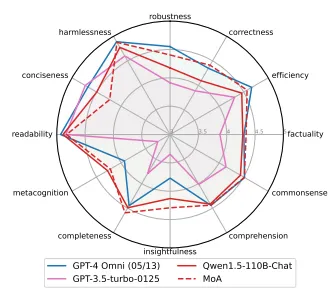

FLASK

FLASK는 모델의 세밀한 평가를 제공합니다. 우리의 MoA는 정확성, 오류 감지, 완성도, 메타 인식에서 GPT-4 Omni를 능가했으며, 특히 응답의 응집성에서 눈에 띄는 향상을 보였습니다. 그러나 일부 영역에서는 약간의 부족함을 보였습니다.

Figure 3: 우리는 6개의 제안자로 구성된 MoA 설정과 Qwen-5-110B-Chat을 통합 모델로 사용한 FLASK 결과를 보여줍니다.

3.3 Mixture-of-Agents가 잘 작동하는 이유는 무엇인가?

이 섹션에서는 Mixture-of-Agents의 내부 메커니즘을 더 잘 이해하기 위해 수행한 실험 결과를 다룹니다. 주요 인사이트는 다음과 같습니다:

-

Mixture-of-Agents는 LLM을 능가한다

우리는 MoA가 제안자와 통합자 모델로 구성되어 있음을 발견했습니다. 제안자가 생성한 응답 중 일부는 통합자가 더 우수한 응답을 생성하는 데 도움이 되었습니다. 이를 통해 MoA가 더 나은 종합적인 성능을 보여줍니다.

-

MoA는 최적의 응답을 제안한다

통합자의 응답보다 제안자의 응답이 더 좋은 경우가 종종 발생하며, 이는 여러 모델 간 협력으로 인해 더 높은 품질의 응답이 생성됨을 의미합니다.

Figure 4: (a) AlpaEval 2.0에서 서로 다른 통합자들을 사용하는 6-모델 Mixture-of-Agents 설정에서 LC 승률. 모든 그래프는 동일한 6명의 제안자를 사용하지만 최종 통합자의 선택이 다릅니다. LLM 계층은 Qwen-5-110B-Chat을 통합자로 사용합니다. GPT-4 모델은 오직 통합자의 역할로만 사용되며, 제안자 역할을 수행하지 않습니다. (b) BLEU 점수(3-그램, 4-그램, 5-그램)와 제안된 출력의 LC 승률을 기반으로 한 제안자의 분리.

Table 3: AlpaEval 2.0에서 제안자 모델의 효과. 제안자가 각 MoA 층에서 생성한 출력의 수가 클수록 성능이 더 좋아집니다. 우리는 Qwen-5-110B-Chat을 통합자로 사용하며, MoA 설정에 2개의 층을 사용합니다.

| 설정 | 다중 제안자 | 단일 제안자 |

|---|---|---|

| n = 6 | 61.3% | 54.5% |

| n = 3 | 58.8% | 51.7% |

| n = 1 | 47.8% | 44.5% |

Table 4: 서로 다른 모델들이 제안자 및 통합자로서 작동할 때의 영향. 제안자로서 모든 모델이 사용됩니다. 2개의 MoA 층을 사용합니다.

| 모델 | 통합자로서 | 제안자로서 |

|---|---|---|

| Qwen-5-110B-Chat | 65.3% | 63.5% |

| Qwen-5-7B-Chat | 53.9% | 53.6% |

| LLaMA-3-70B-Instruct | 53.6% | 52.2% |

| WizardLM-7B-Inst | 48.5% | 46.8% |

| Mistral-X28B-Instruct | 41.5% | 41.0% |

| dbxr-instruct | 41.6% | 41.5% |

모델 다양성 및 제안자 수의 효과

우리는 제안자 수가 최종 출력의 품질에 미치는 영향을 분석합니다. 더 많은 제안자가 참여할수록 성능이 증가하는 경향을 보이며, 이는 Table 3에서 나타납니다. 특히, 다양한 모델을 사용한 경우 더욱 두드러집니다. MoA 설정에서 다중 제안자 접근 방식은 단일 제안자 접근 방식보다 성능이 훨씬 뛰어납니다.

Mixture-of-Agent 생태계에서 모델의 특화

우리는 각 모델이 제안자 및 통합자로서 작동할 때의 성능을 분석했습니다. Qwen-5-110B-Chat은 뛰어난 통합자로서 작동하며, 다른 LLM들의 출력을 종합하여 성능을 크게 향상시켰습니다.

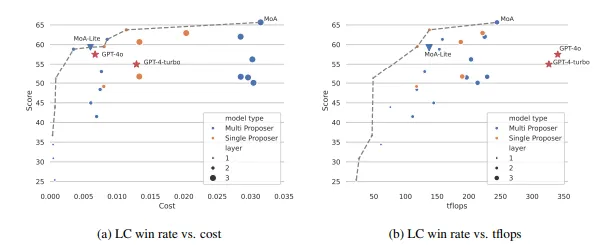

3.4 예산 및 토큰 분석

우리는 예산, 토큰 사용량, 그리고 LC 승률 간의 관계를 이해하기 위해 분석을 진행했습니다. Figure 5a와 Figure 5b는 이러한 관계를 시각화합니다.

Figure 5:

(a) 비용 대비 LC 승률의 트레이드오프.

(b) LC 승률과 테라 플로팅 연산 횟수(TFLOPS) 간의 트레이드오프. 우리는 TFLOPS를 대리 변수로 사용하여 지연 시간(latency)를 측정합니다. 각 MoA 층에서 다중 제안자가 참여하는 경우 더 많은 연산이 발생하는데, 이는 단일 제안자와 비교됩니다. 이 그림에서, 우리는 동일한 성능을 유지하면서 비용이 적게 드는 모델들이 Pareto 전선에서 어떤 위치에 있는지를 보여줍니다. Mixture-of-Agents 접근 방식은 비용과 성능 측면에서 GPT-4 Turbo 및 GPT-4 Omni보다 우수합니다.

비용 효율성

Figure 5a에서는 AlpaEval 2.0에서 각 인스턴스에 대한 LC 승률과 평균 추론 비용 간의 관계를 보여줍니다. 이 비용은 각 API 제공업체에서 얻을 수 있는 공개 정보를 바탕으로 계산됩니다. 이를 통해 우리는 비용을 과도하게 증가시키지 않고 높은 성능을 달성할 수 있는 비용 효율적인 모델을 식별할 수 있습니다.

TFLOPS 소비

Figure 5b에서는 LC 승률과 TFLOPS 간의 관계를 보여줍니다. 여기서 TFLOPS 수는 지연 시간의 대리 변수로 사용되며, 시스템의 성능을 측정하는 중요한 지표입니다. 이러한 데이터를 통해 우리는 예산과 성능 간의 균형을 유지하면서 최적의 LC 승률을 달성할 수 있는 모델을 파악할 수 있습니다.

4. 관련 연구

4.1 LLM 추론

대형 언어 모델의 진화를 통해 최근 연구들은 다양한 다운스트림 작업을 최적화하는 데 큰 진전을 이루었습니다. Chain of Thought(Cot) 방법은 단계별 문제 해결을 강조하는데, 각 단계가 이전 단계 위에 구축됩니다. 이와 유사한 Auto-CoT는 질문을 샘플링하고 추론 체인을 생성함으로써 CoT 프롬프트를 자동화합니다. Active-Prompt는 PS 프롬프트(Wang et al., 2023)는 작업별 주석에서 가장 불확실한 질문을 선택하는 데 중점을 둡니다. Tree-of-Thought (ToT) (Yao et al., 2023a)는 다중 하위 작업으로 추론 프로세스를 분해하며, Graph-of-Thought (GoT) (Yao et al., 2023b)는 추론 과정에서 여러 경로를 생성하고 자체 평가하는 방식으로 이를 확장합니다. Effective Graph-of-Thought (Yao et al., 2023c)는 프롬프트에서 다양한 추론 경로를 형성하며, Natural Program prompting (Liu et al., 2023)은 프로그래밍과 관련된 추론을 수행합니다. Re-reading Prompt (Xu et al., 2023b)는 입력 프롬프트 내에서 정보 임베딩을 재검토합니다.

4.2 모델 앙상블

다중 모델의 강점을 활용하는 가장 직관적인 해결책 중 하나는 서로 다른 모델의 출력을 재순위화하는 것입니다. 예를 들어, Jiang et al. (2023)은 PAIRRANKER를 소개했는데, 이는 모델 간 비교를 통해 가장 좋은 응답을 선택하는 방식으로 작동하며, 이는 자가 감독 학습의 주요 장점을 보여줍니다. 여러 LLM 간의 경쟁에서 발생하는 연산 비용 문제를 해결하기 위해, 일부 연구는 고정된 집합의 LLM을 사용하는 최적의 모델을 예측하는 방법을 탐구했습니다(Wang et al., 2024). 추가적으로, FLM4GPT (Chen et al., 2023b)는 서로 다른 모델을 단계적으로 사용하여 LLM의 비용을 줄이는 방법을 제안했습니다.

다른 연구들은 협력적인 다중 에이전트 구조를 탐구했습니다. 여러 LLM이 서로 협력하며 응답을 논의하는 방식으로 진행되며, MAD(AI)가 이와 유사한 비대칭적인 다중 에이전트 시스템을 도입해 서로 다른 모델들이 역할을 분담하여 협력할 수 있음을 보여주었습니다.

5. 결론

이 논문에서는 Mixture-of-Agents(MoA) 접근 방식을 통해 여러 LLM이 계층적으로 협력하며 성능을 향상시키는 방법을 소개했습니다. 이 방법은 각 층이 이전 층에서 나온 출력을 바탕으로 다음 출력을 생성하는 방식으로 작동합니다. 우리는 AlpaEval 2.0, MT-Bench, FLASK 벤치마크에서 MoA의 우수한 성능을 확인했습니다. 특히 GPT-4 Omni와 비교했을 때 최대 65%까지 성능 향상이 있었으며, 더 적은 비용으로 높은 효율성을 달성했습니다.

한계점

우리의 제안된 방법은 모델 응답을 효과적으로 통합하지만, LLM 간의 상호작용 비용이 발생할 수 있습니다. 이는 최종 응답까지 걸리는 시간이 다소 길어질 수 있으며, 이러한 부분을 개선하기 위한 추가 연구가 필요합니다.

이 연구는 LLM 기반의 대화 시스템을 개선할 수 있는 잠재력을 보여주며, MoA 접근 방식이 대화 시스템의 성능을 극대화하는데 기여할 수 있음을 시사합니다.

이를 통해 Mixture-of-Agents 접근 방식이 보다 명확하게 모델의 상호작용을 이해하고, 협력적 성능을 높일 수 있는 방안을 제공한다는 점을 알 수 있습니다.