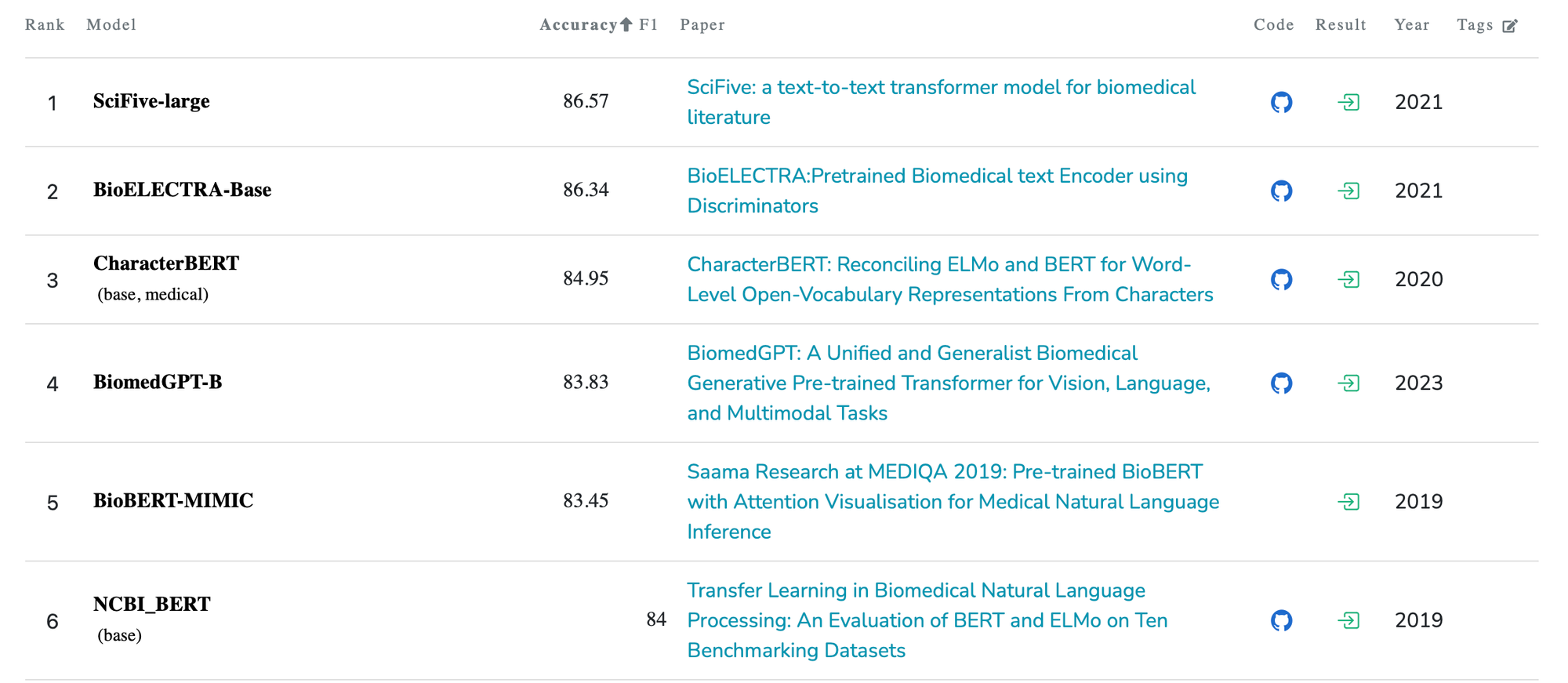

https://paperswithcode.com/sota/natural-language-inference-on-mednli : MedNLI SOTA models

- SciFive-Large :

MedNLI Acc 86.57https://arxiv.org/pdf/2106.03598v1.pdf- size - base : 220M, large : 770M

- base model : t5(pre-trained weights 사용)

- re-train dataset : C4 corpus, PubMed abstracts, PMC full-text articles

- finetuning dataset : NLI의 경우) MedNLI datasets

- task : NER, RE, NLI, Document Classification, QA

- +) input length는 256, output length는 12.

- BioELECTRA-Base

MedNLI Acc 86.34https://aclanthology.org/2021.bionlp-1.16/- size - 110M

- base model : ELECTRA model

- train dataset(pretrain from scratch) : PubMed, PMC full text articles. (학습 방법이나 전처리 방법은 ELECTRA에서 제공하는 방법을 따름.)

- finetuning dataset : MedNLI datasets

- CharacterBERT

MedNLI Acc 84.95https://arxiv.org/pdf/2010.10392v3- size : base - 104.6M

- 기존 base model에서 학습시키는 방법이 아닌, 새로운 모델 제안. wordpiece 토큰화를 characterpiece 토큰화로 변형한 BERT를 제안하여 단어 전체를 문자 수준에서 표현함.

- domain : medical. (general과 medical domain의 두 종류가 있음)

- training dataset : medical domain model의 경우 general model에서 MIMIC-III과 PMC OA로 re-train진행.

- finetuning dataset : NLI의 경우) MedNLI datasets

- 장점) 의료 도메인에서 wordpiece vocabulary가 필요가 없음에도 좋은 성능을 보이며, noise와 오탈자에 robust함.

- BiomedGPT-B

MedNLI Acc 83.83https://arxiv.org/pdf/2305.17100v2- size - S:33M, M:93M, B:182M

- vision, language, multimodal task에서 유연하게 사용가능한 모델. 특히 멀티모달 진단 관련해서 좋은 성능을 보임. (MedNLI에서는 SOTA에 이르지 못함)

- finetuning - 5 task : disease classification(vision-only), medical language understanding(MedNLI로 파인튜닝), text summarization, image captioning/description and VQA

- GatorTron-large

MedNLI Acc 90.20(SOTA) https://arxiv.org/abs/2203.03540- size - base : 345 M, Medium : 3.9 B, Large : 8.9B (base model(345M)의 MedNLI Acc=86.7로, 작은 사이즈로도 SOTA수준.)

- base model : Megatron BERT 모델

- training dataset(pretrain from scratch) : clinical notes of University of Florida Health, PubMed articles, and Wikipedia

- finetuning dataset : NLI의 경우) MedNLI datasets

- task : clinical concept extraction, medical relation extraction, semantic textual similarity, NLI, medical QA