activation func이 zero-centered 이어야 하는 이유

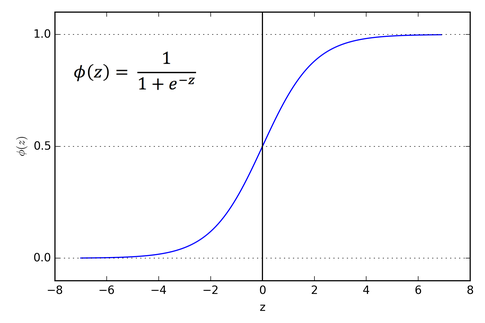

예를 들어 logistic sigmoid의 경우 zero-centered가 아니고 모든 값이 양수이다.

그렇기 때문에 이 함수를 activation func으로 쓰게 되면

deep neural net에서 l번째 layer 입장에서 l-1번째 레이어의 output이 항상 양수가 된다.

따라서 l-1번째 레이어는 input으로 계속 양수의 값을 받게 되는 것이다.

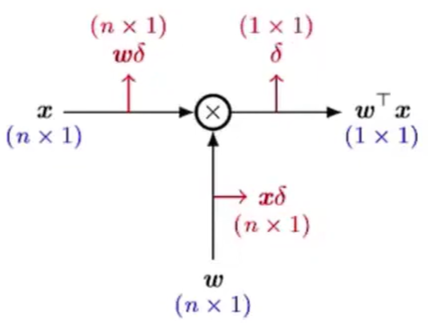

이는 back prop과정에서 gradient를 흘려보낼 때 w의 미분 값이 X값에 의존적이기 때문에 gradient update시 느린 수렴을 발생하게 한다.

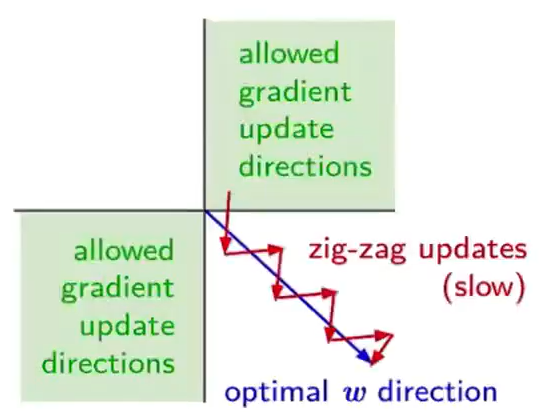

따라서 loss func을 최솟값으로 갖게 하는 최적의 방향이 파란색 방향임에도 불구하고 gradient가 한 방향으로만 흐르기 때문에 빨간색 처럼 zig-zag수렴을 하게 되는 것이다.