https://github.com/unslothai/unsloth

RunPod 개요

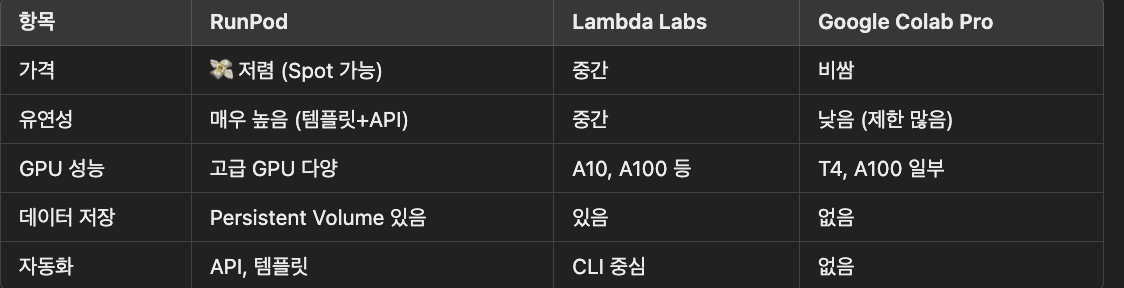

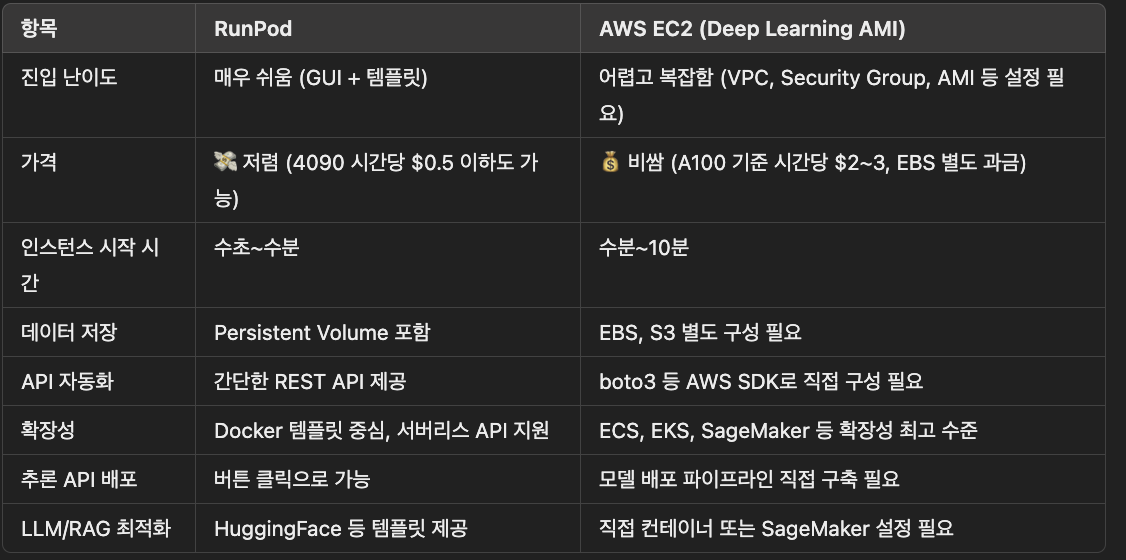

RunPod는 사용자가 저렴하고 유연하게 GPU 인스턴스를 사용할 수 있도록 지원하는 GPU 클라우드 인프라 서비스다.

특히 딥러닝 모델 학습, 추론, 배치 서비스를 위한 최적화된 환경을 제공

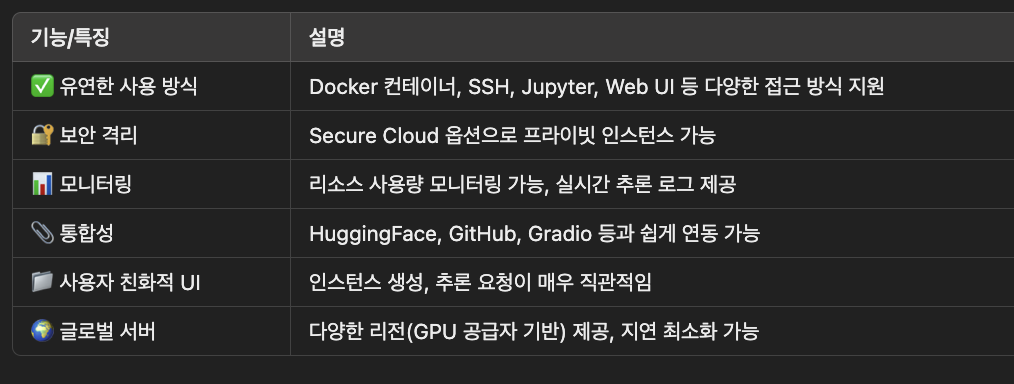

🔧 주요 기능

1. 🖥️ GPU 인스턴스 임대 (Serverless & Secure Cloud)

다양한 GPU 종류 제공 (A100, H100, RTX 4090, 3090, T4 등)

On-demand 또는 Spot 인스턴스 지원

서버리스 컴퓨팅(Serverless Functions)으로 함수 기반 추론 가능

- 🔄 Persistent Volumes

코드, 데이터, 모델 등을 저장 가능한 영구 디스크 지원

인스턴스를 껐다 켜도 데이터 유지됨

- 🚀 자동화된 모델 배포 (RunPod Templates)

Docker 기반 템플릿으로 손쉽게 모델을 배포

예: Stable Diffusion, Whisper, LLaMA, FastChat 등 오픈소스 모델 템플릿 다수 제공

- ⚙️ API 기반 자동화

REST API를 통해 인스턴스 생성/삭제, 상태 체크, 추론 요청 등 자동화 가능

MLOps 파이프라인 통합에 용이

- 💸 가격 경쟁력

시간당 GPU 사용료가 매우 저렴함 (사용자 간 GPU 리소스를 공유하는 방식도 존재)

Spot 인스턴스로 사용 시 더욱 저렴하게 사용 가능

📌 RunPod 활용 예시

Stable Diffusion으로 이미지 생성 웹 서비스 만들기

LLaMA, Mistral, GPT 기반 챗봇을 API로 서빙

Whisper로 대용량 오디오를 텍스트로 자동 변환

HuggingFace Transformers 모델을 빠르게 추론 서버로 배포

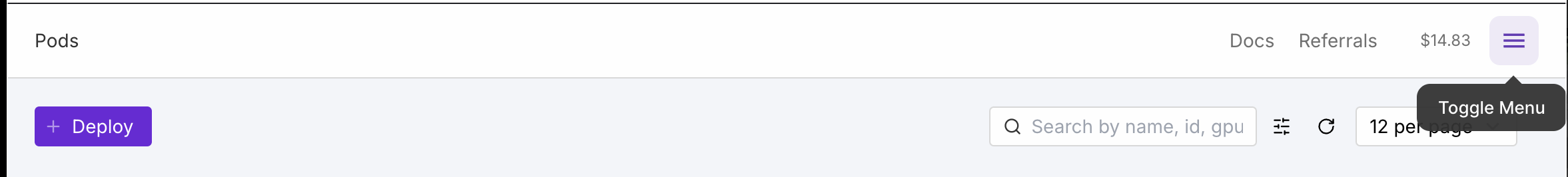

POD 생성 방법

-

햄버거버튼 클릭

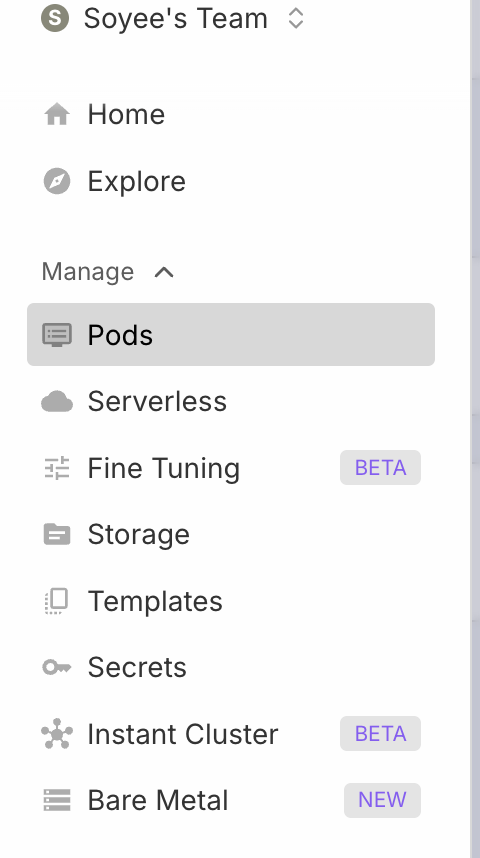

-

Pods 클릭

-

Deploy 클릭

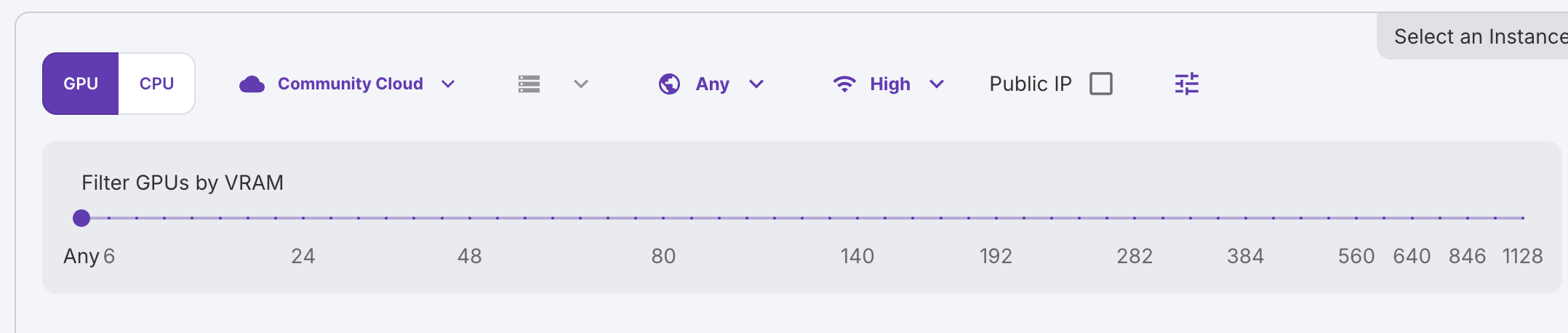

-

GPU, Internet speed high로 sorting

-

GPU 선택

-

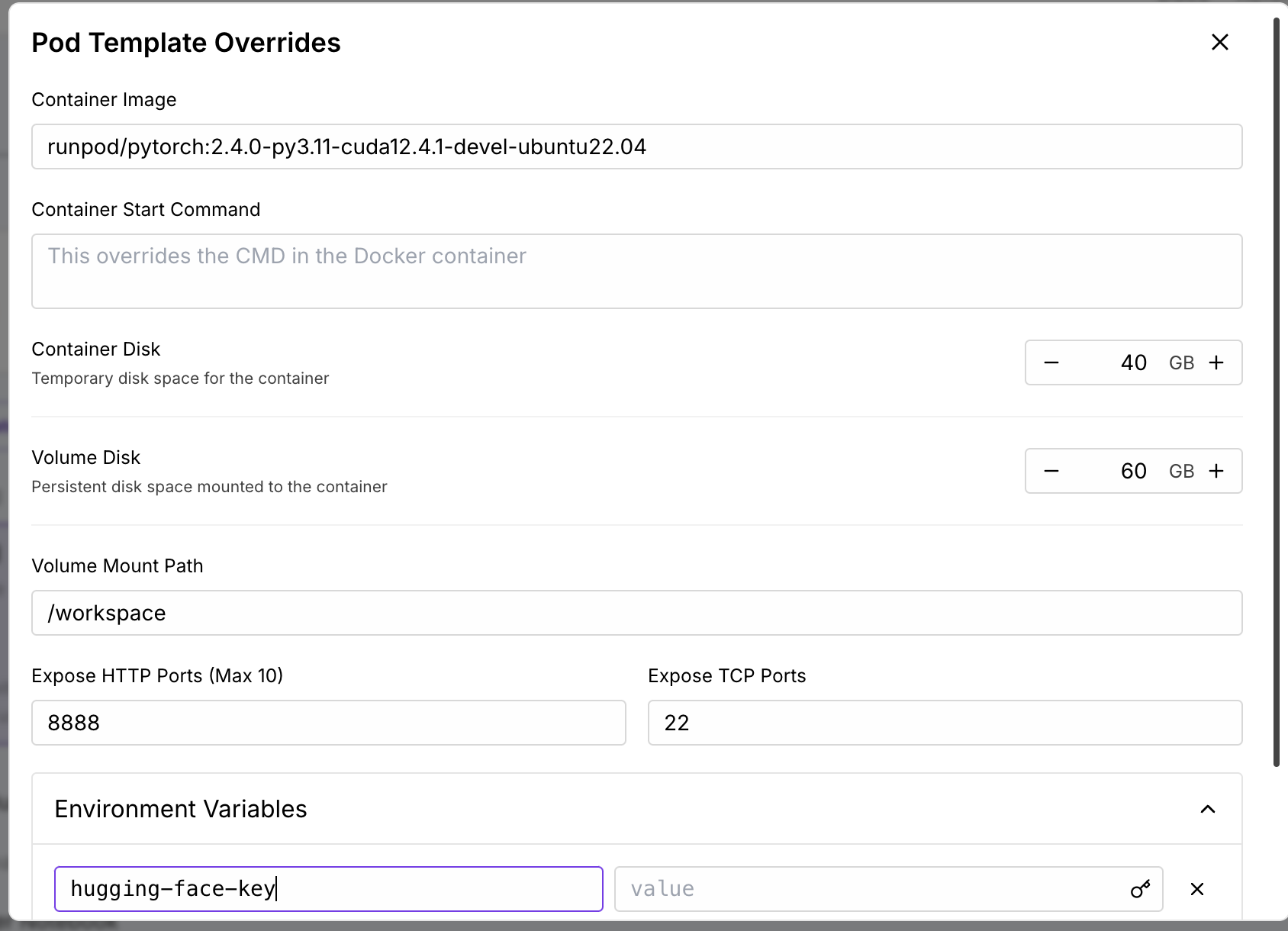

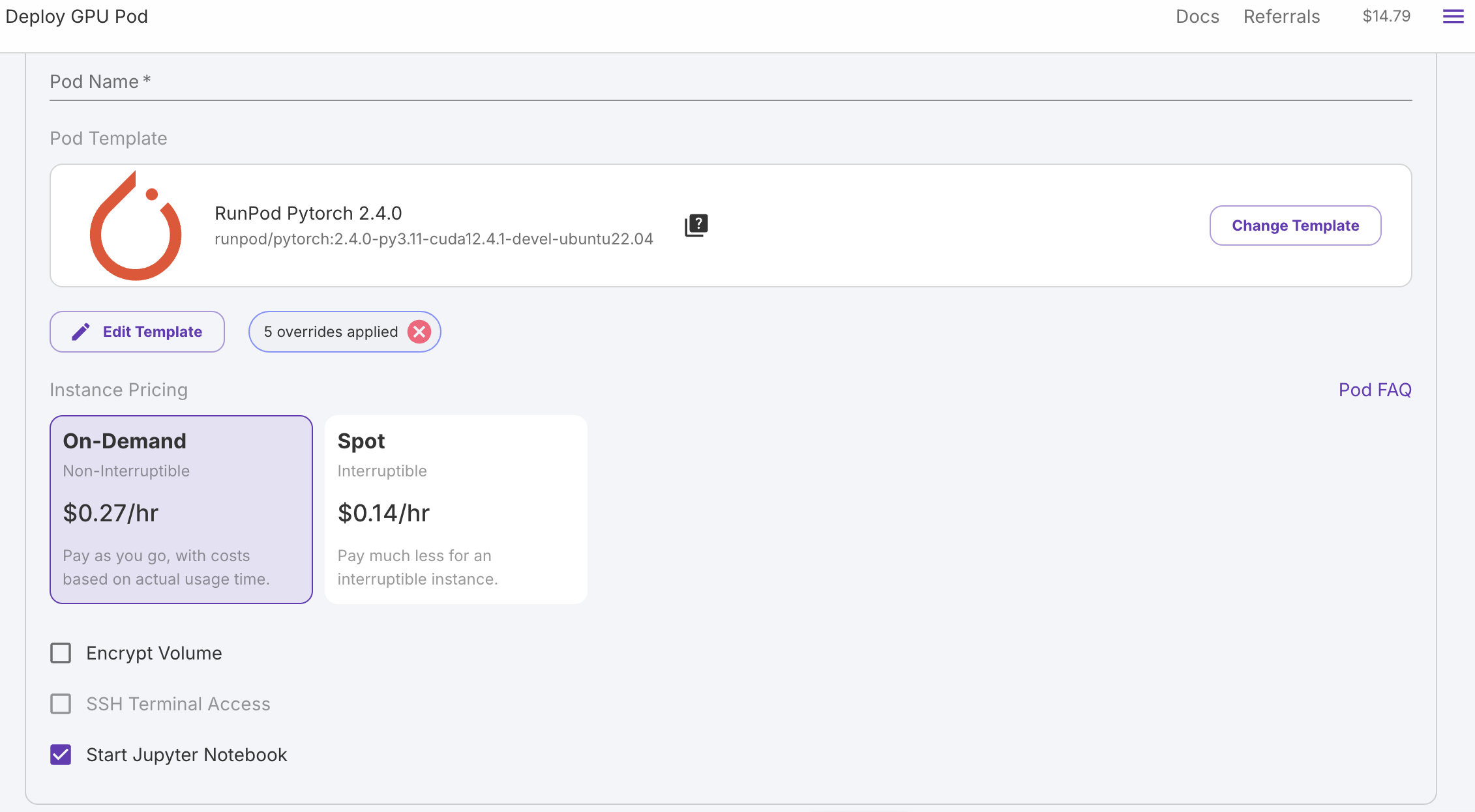

POD name 입력 및 edit pod

-

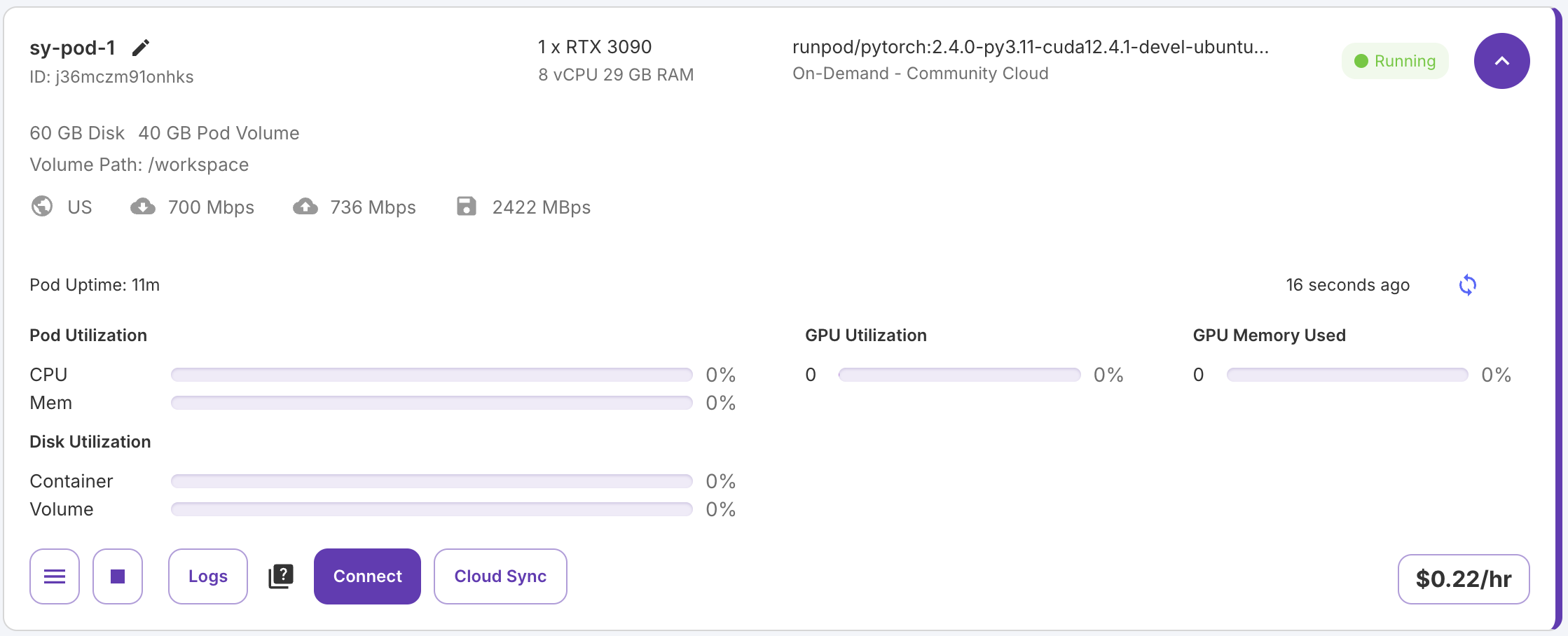

설정 완료 상태

-

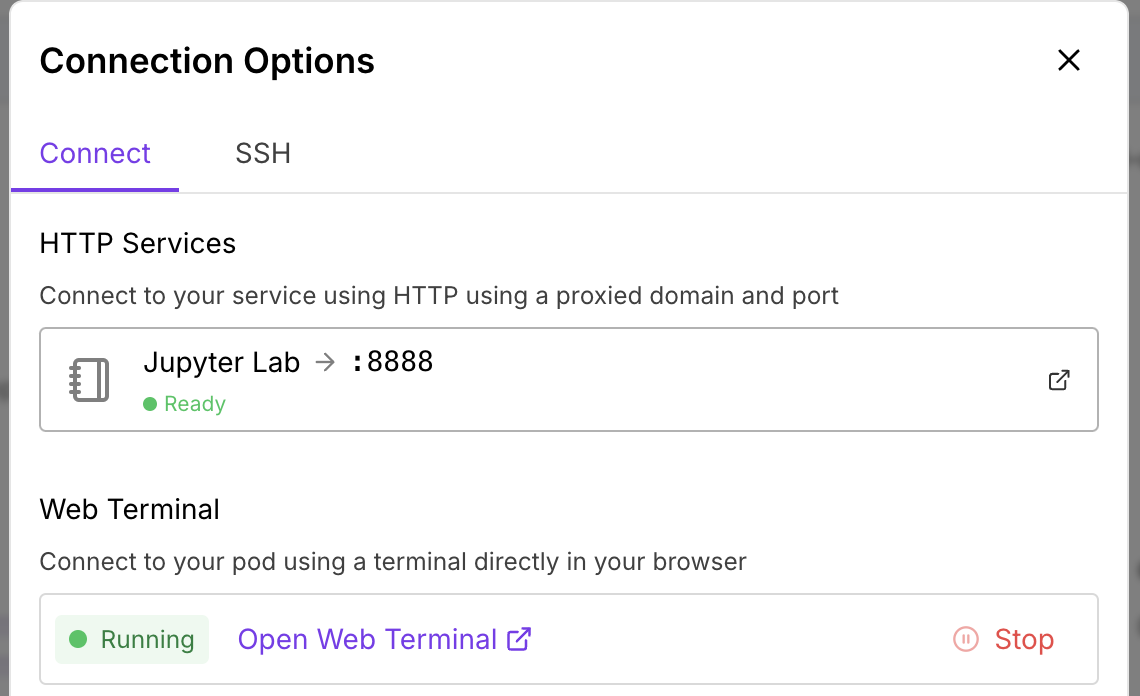

Connect 버튼 클릭

-

Jupyter or Webterminal 접속