고가용성 (High Availability)

= 하나의 장비에 문제 발생 시 다른 장비 대체

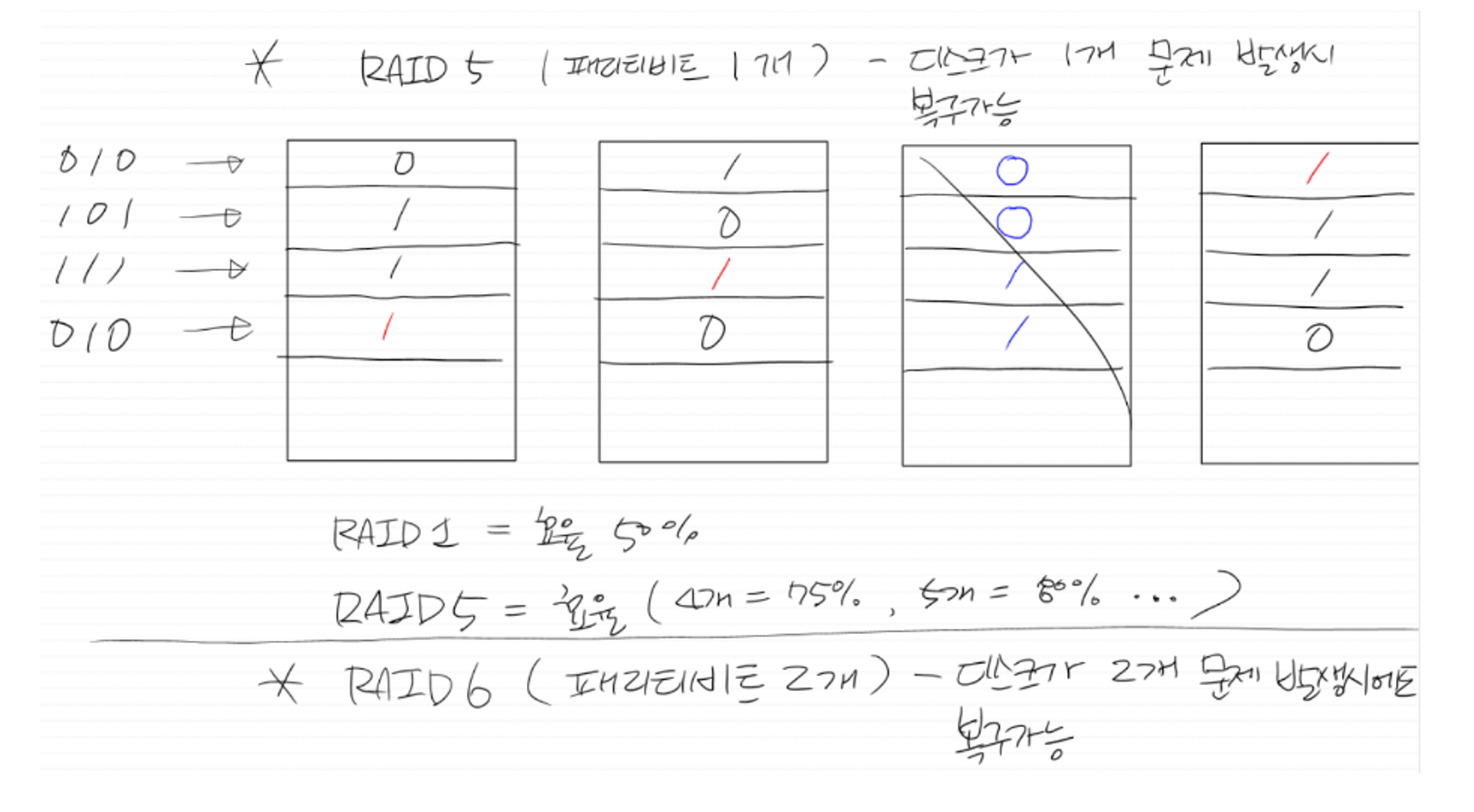

RAID 5 (페리티비트)

패리티(Parity)란?

-

정수의 홀수 또는 짝수 특성

-

정보 블록과 연결된 중복 정보, 패리티는 오류 후 데이터를 재구축하는데 사용되는 계산된 값

디스크가 1개 문제 발생 시 복구 가능

RAID 1 = 효율 50%

- RAID 5 = 효율 (4개 = 75%, 5개 = 80% …)

- RAID 6 ( 페리티비트 2개) = 디스크가 2개 문제 발생시에도 복구 가능

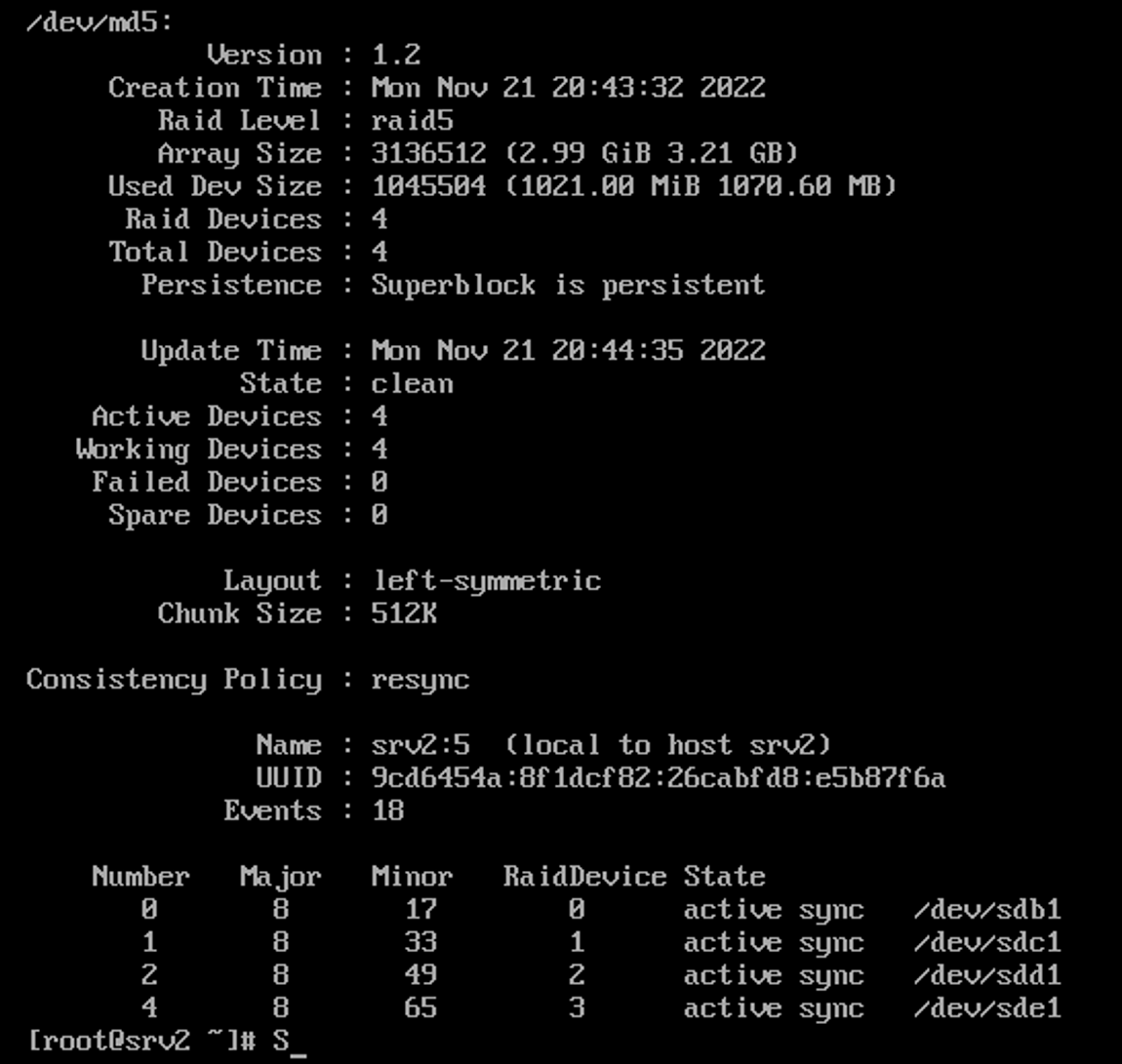

RAID 5 실습

-

Settings

이름 raid5

ip 211.183.3.50

전원 켰다 끄고 1GB 디스크 4개 추가각각의 디스크에 파티션 추가

ls -l /dev/sd* # 현재 디스크 확인 fdisk /dev/sdb # c,d,e 까지 해주기 n p [Enter] [Enter] [Enter] t fd p # 확인 w # 저장 ls -l /dev/sd* # 변경 후 디스크 확인mdadm 설치 후 RAID 5 세팅

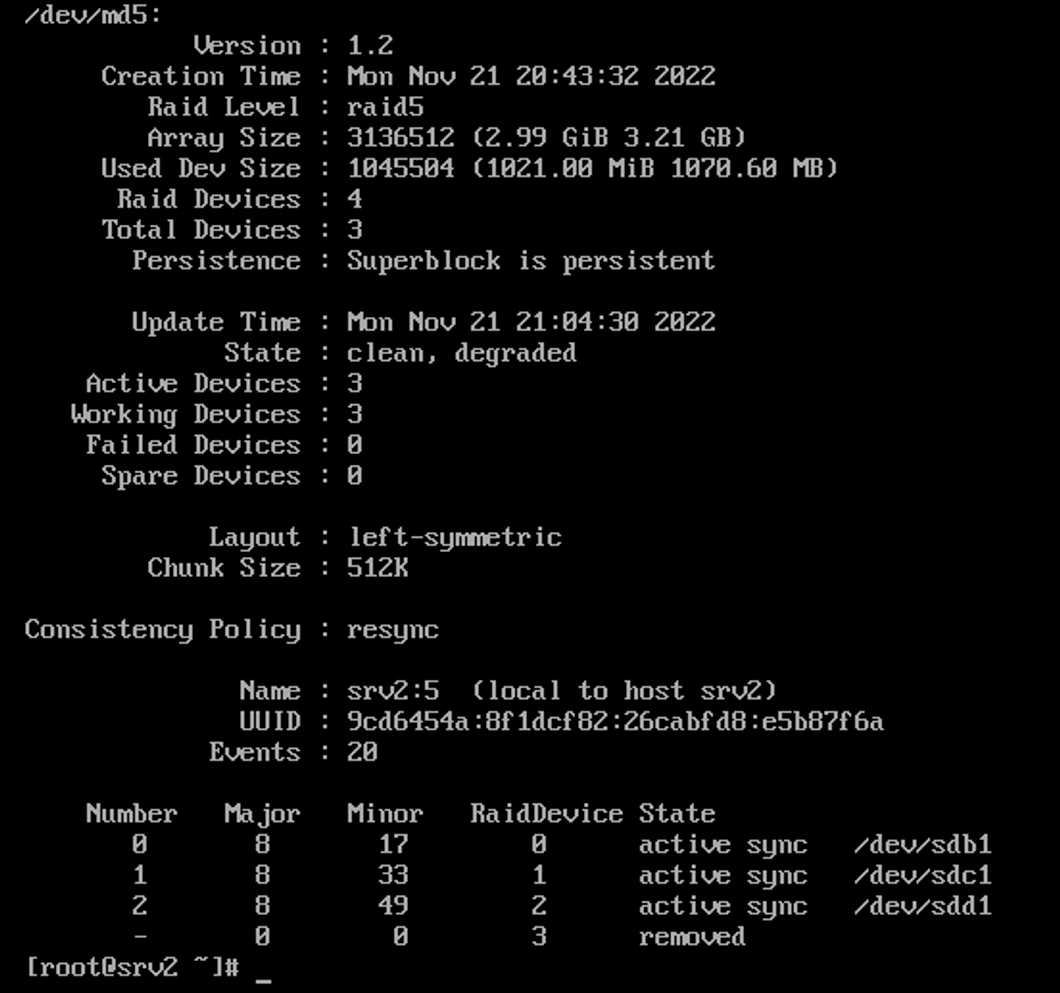

yum -y install mdadm mdadm --create /dev/md5 --level=5 --raid-devices=4 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 # 파티션 나눠준걸 md5로 합침 mdadm -D /dev/md5 # 확인 mkfs.ext4 /dev/md5 # 파일 시스템 (초기화) mkdir /raid5 mount /dev/md5 /raid5 # 마운트 vi /etc/fstab # 마운트 폴더 들어가서 수정 # /dev/md /raid5 ext4 default 0 0 mdadm -D/dev/md5 df -h | grep /raid5

디스크 하나 삭제 이후 동작 확인

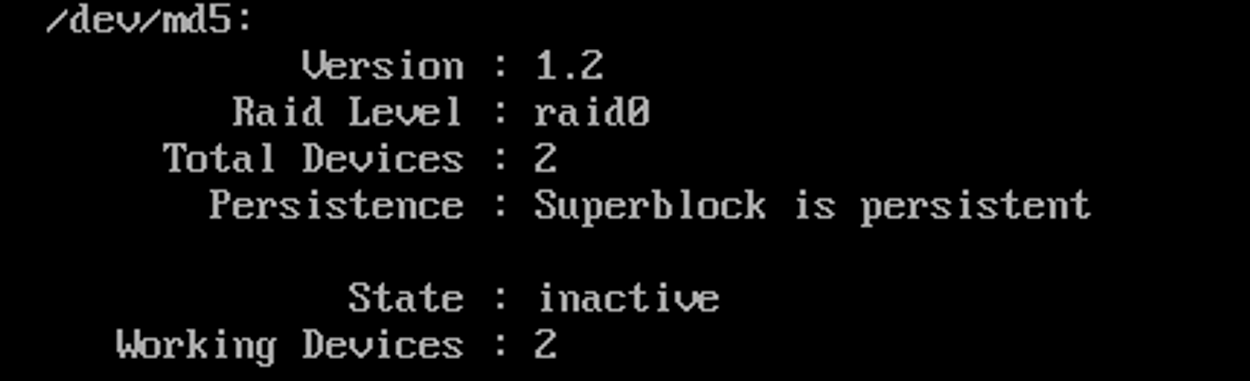

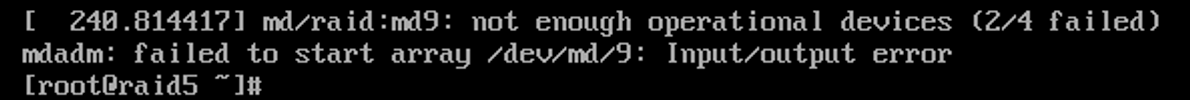

디스크 두개 삭제 이후 동작 확인

- emergency 모드로 진입됨

- md5 사망

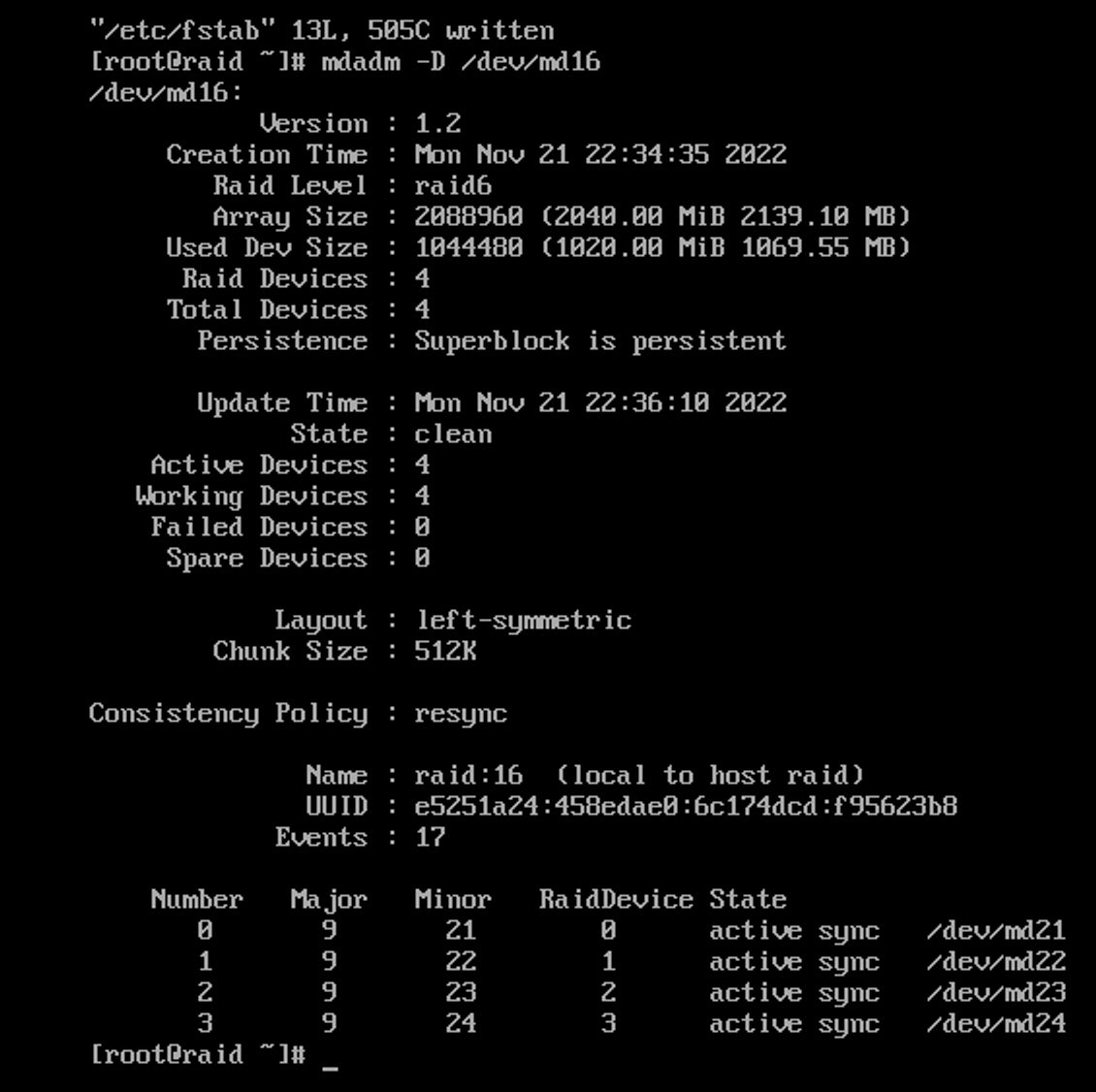

RAID 6 실습

-

RAID 6 ( 페리티비트 2개) = 디스크가 2개 문제 발생시에도 복구 가능

-

Settings

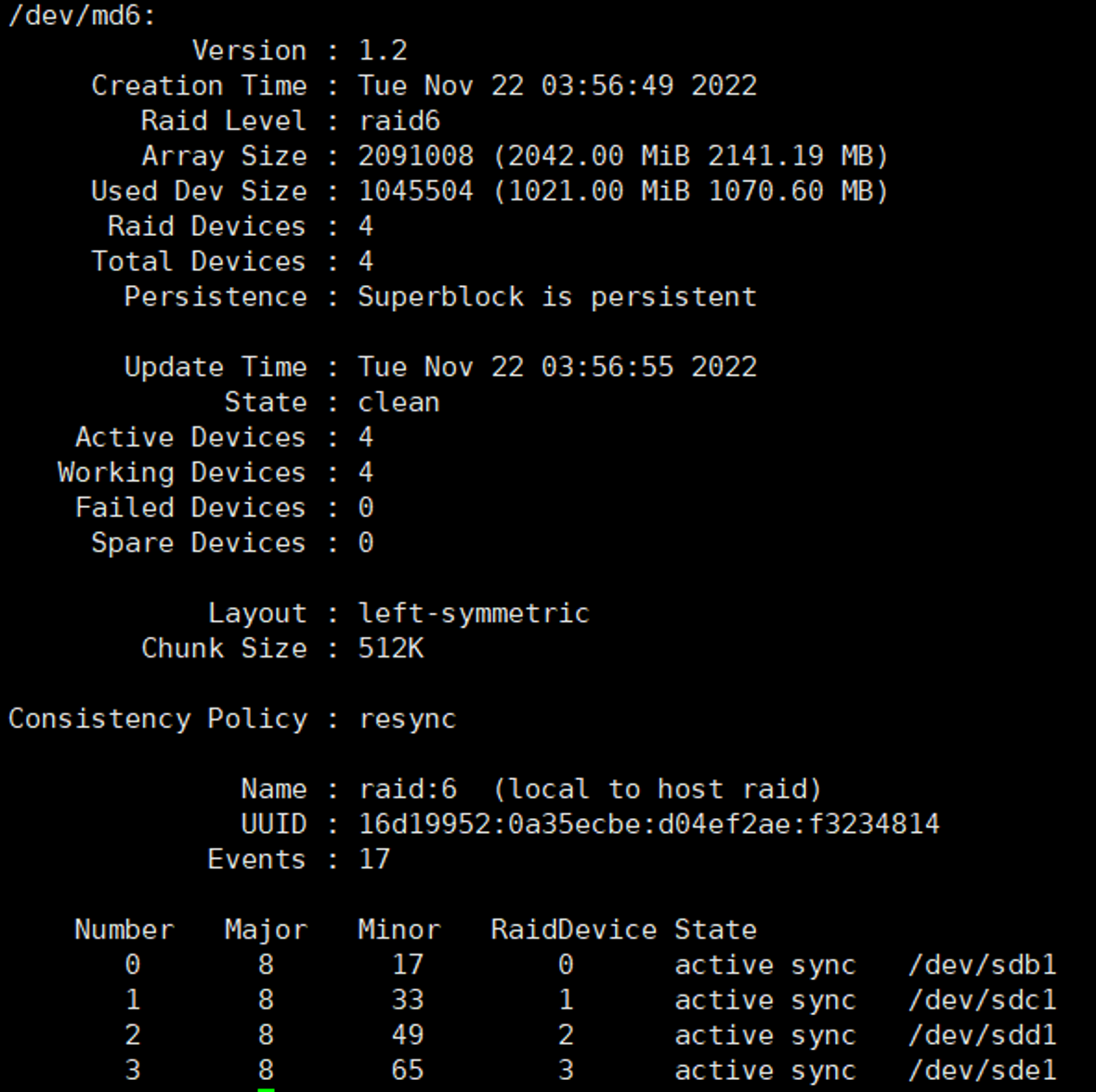

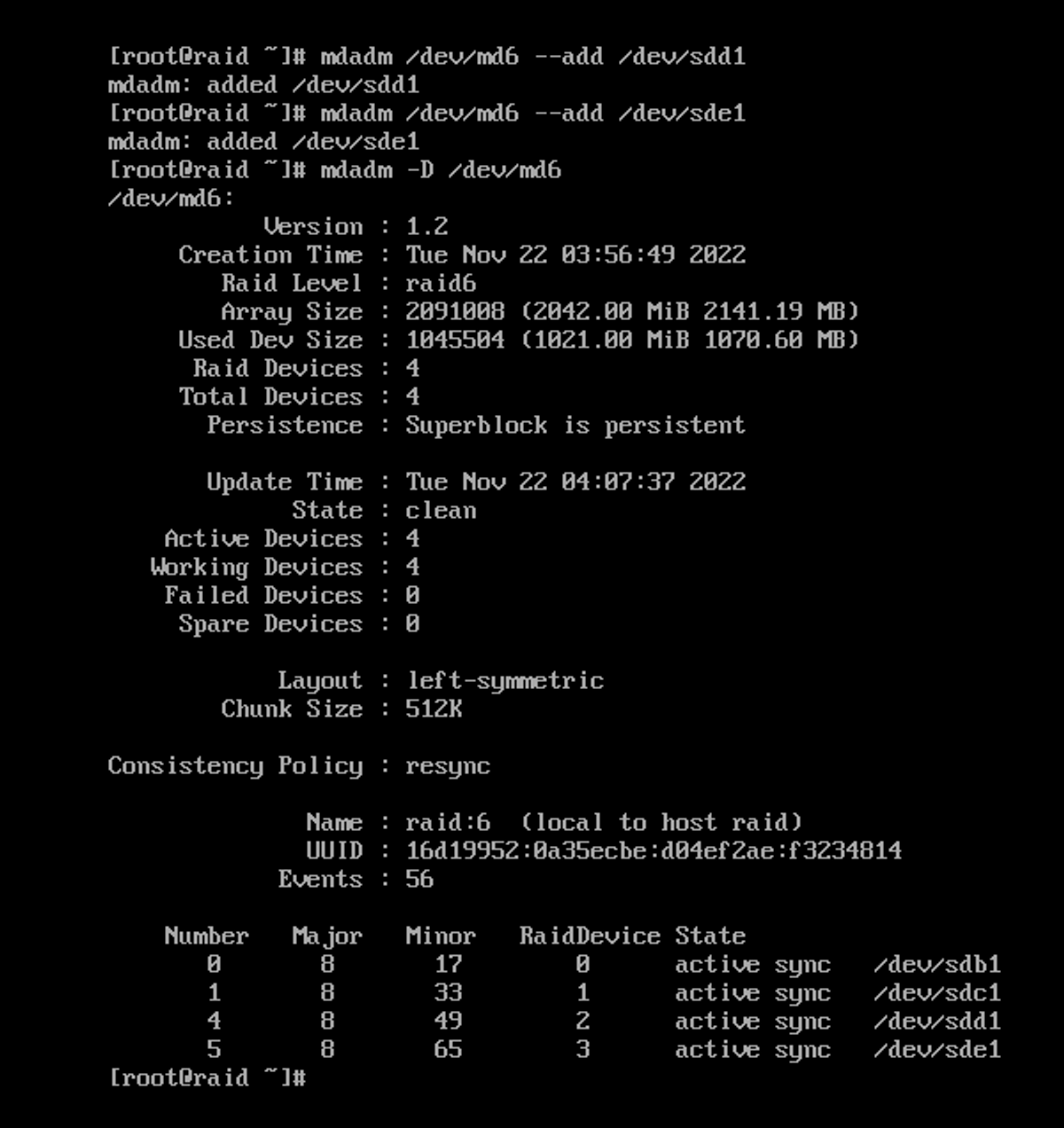

디스크 4개 추가 후 부팅yum install -y mdadm ls -l /dev/sd* #확인 fdisk /dev/sdb #c,d,e 모두 해줌 n p [Enter] [Enter] [Enter] t fd p w ls -l /dev/sd* #또 확인mdadm --create /dev/md6 --level=6 --raid-devices=4 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 mdadm -D /dev/md6 #확인 mkfs.ext4 /dev/md6 #파일시스템 (초기화) mkdir /raid6 mount /dev/md6 /raid6 #마운트 vi /etc/fstab #enable 설정 # /dev/md6 /raid6 ext4 defaults 0 0

cp anaconda-ks.cfg /raid6 cat /raid6/anaconda-ks.cfg #파일 복사 확인2개 지우고 상태 확인

mdadm -D /dev/md6

다시 두개 생성 후 addfdisk /dev/sdb #sdc 두개 설정 후 mdadm /dev/md6 --add /dev/sdd1 mdadm /dev/md6 --add /dev/sde1 #두개의 파티션 추가 mdadm -D /dev/md6

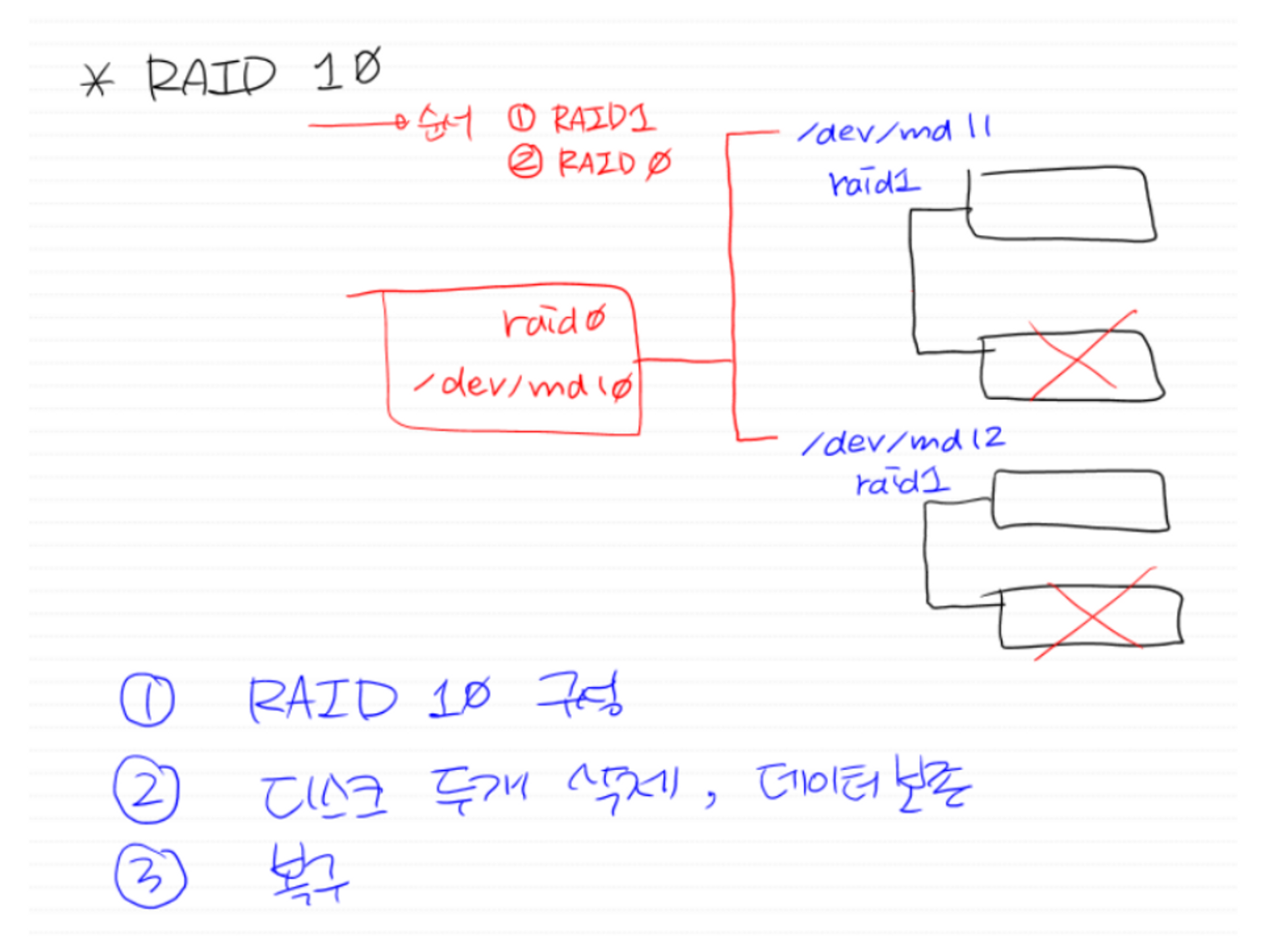

RAID 10

순서 RAID 1 → RAID 0

-

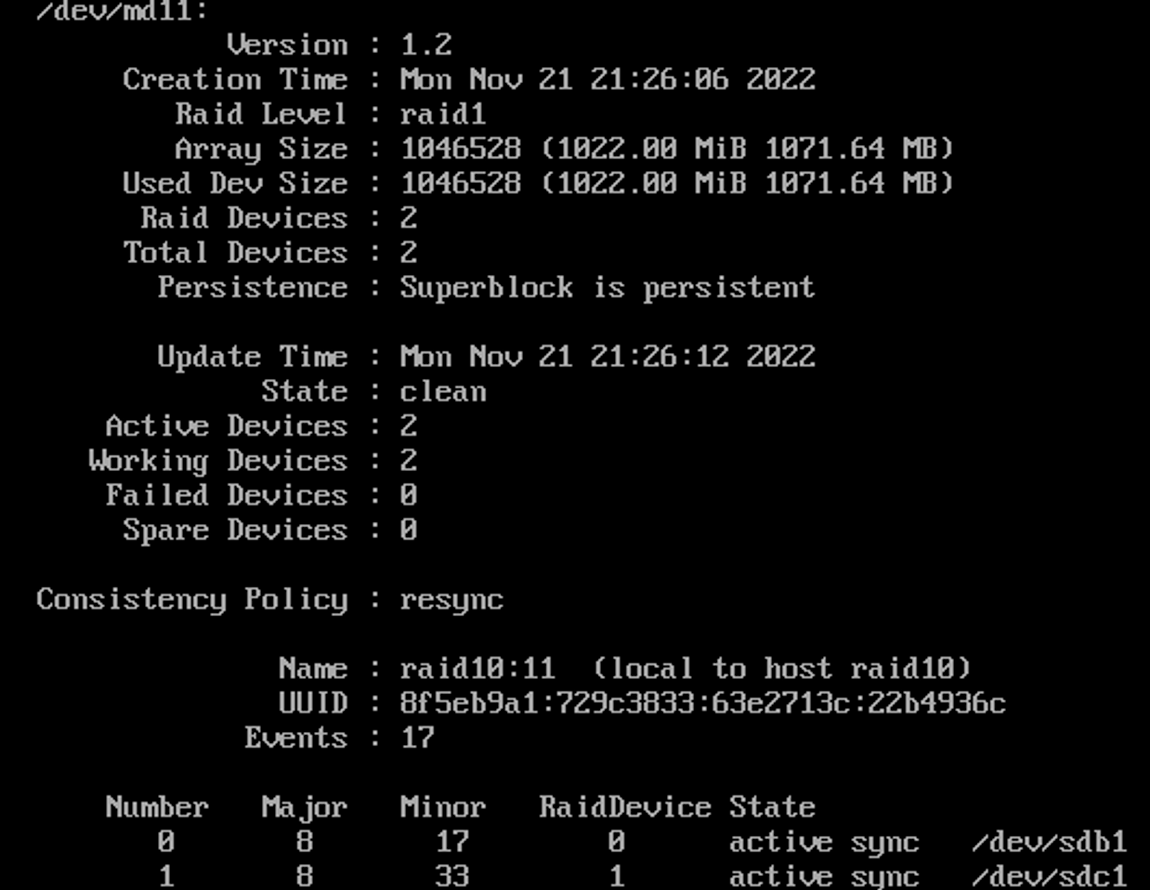

RAID 10 실습

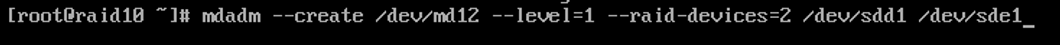

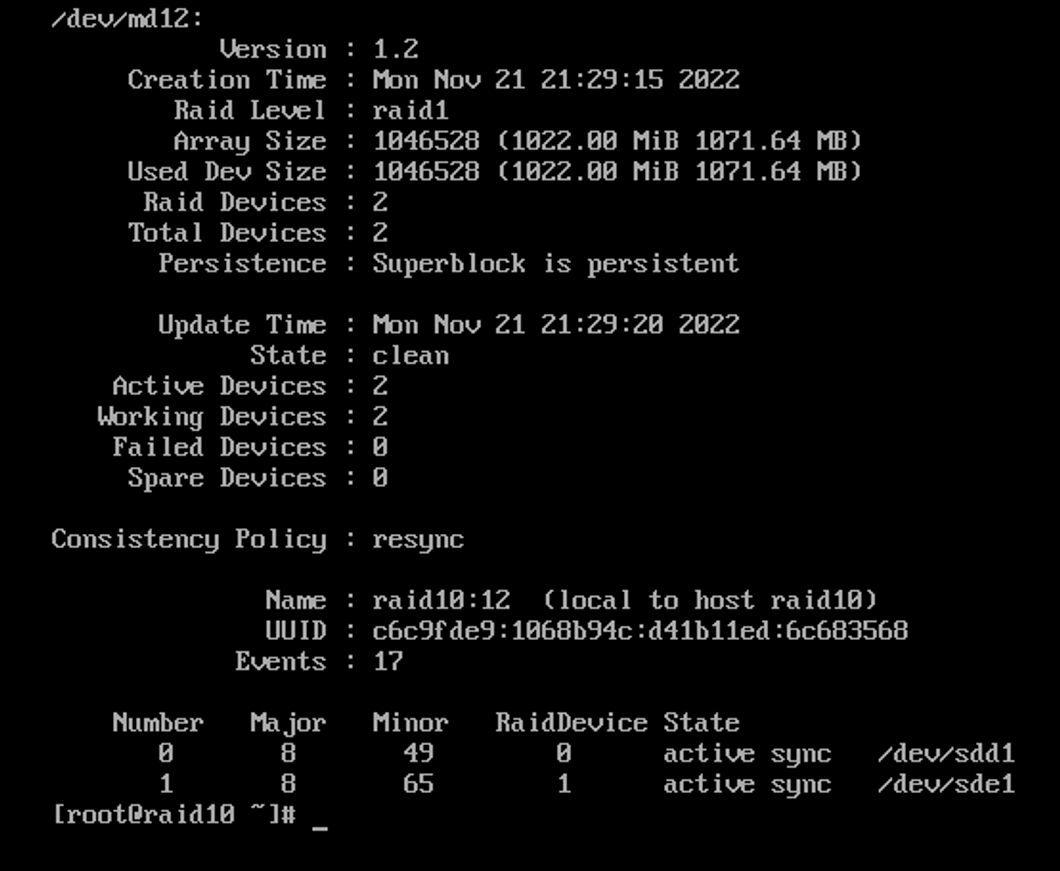

ls -l /dev/sd* #로 디스크 확인해주고 fdisk /dev/sdb #c,d,e 각각 파티션 나눠줌 mdadm --create /dev/md11 --level=1 --raid-devices=2 /dev/sdb1 /dev/sdc1 mdadm --create /dev/md12 --level=1 --raid-devices=2 /dev/sdd1 /dev/sde1 # 둘 다 각각 RAID 1, md11, md12 를 만들어 줌

둘 다 각각 RAID 1, md11, md12 를 만들어 줌

이후에 바로 RAID 0, md10을 만들어 4개의 파일 입력 후 바로mdadm --create /dev/md10 --level=0 --raid-devices=2 /dev/md11 /dev/md12 mkfs.ext4 /dev/md10 mkdir /raid10 mount /dev/md10 /raid10 #마운트 해주고 mdadm -D /dev/md10 df -h #를 통해 확인!디스크 각각 하나씩 제거 후 확인 해보자!

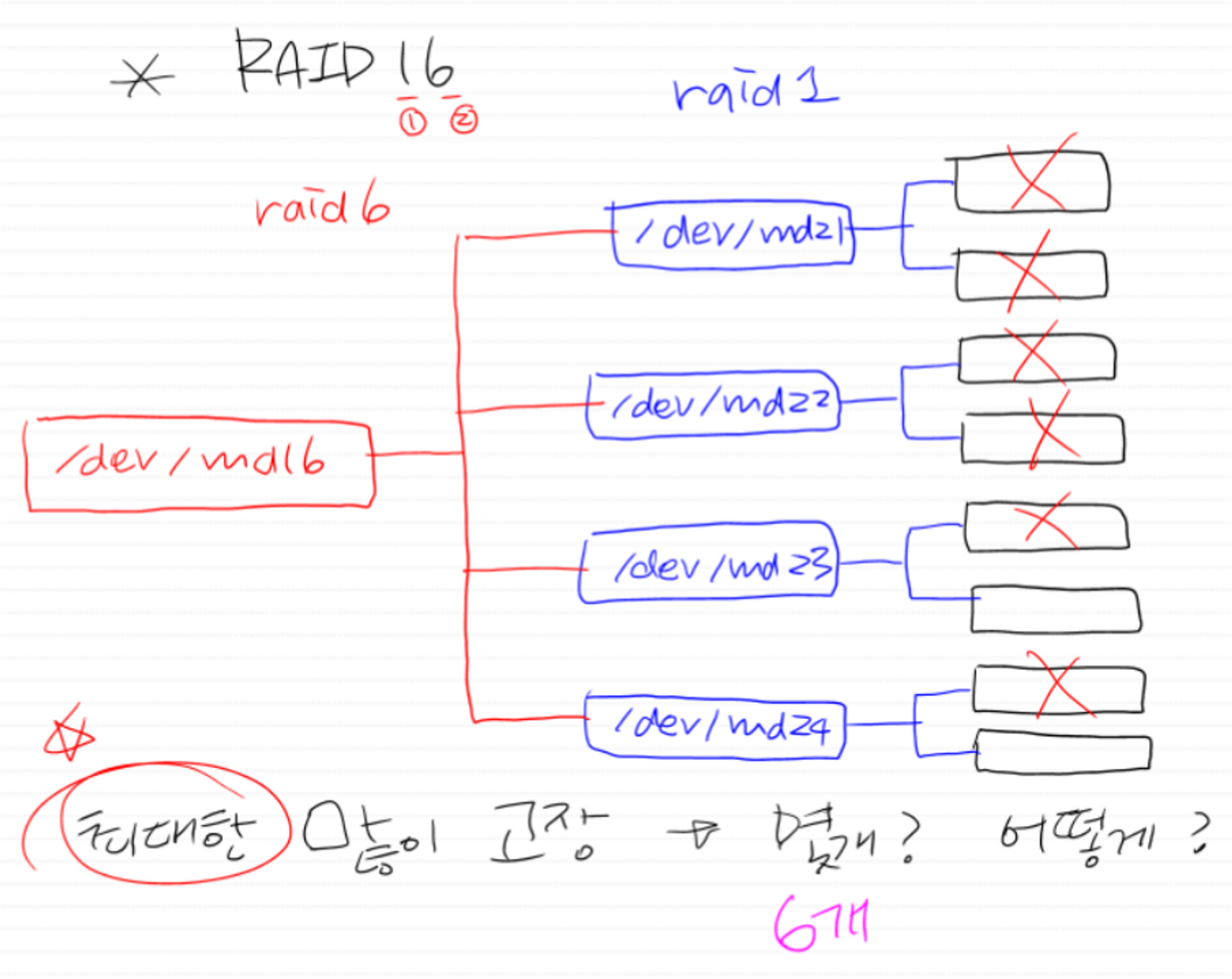

RAID 16

순서 RAID 1 → RAID 6

위에 했던 RAID 10 과 동일한 방법으로 시행