BERT와 GPT의 공통점

GPT(Generative Pre-trained Transformer)

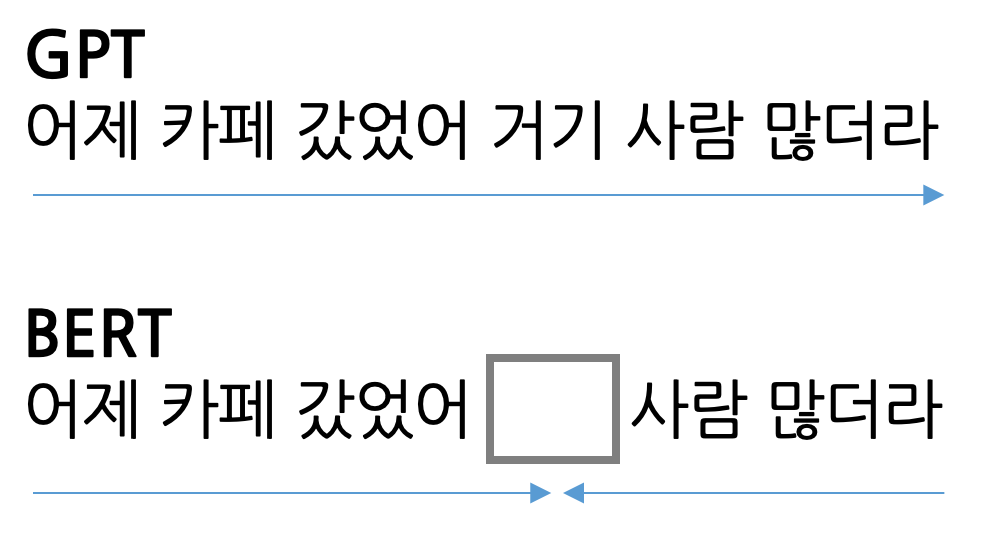

- 언어 모델로 이전 단어들이 주어졌을 때 다음 단어가 무엇인지 맞히는 과정에서 Pre-train을 합니다. 문장 왼쪽에서부터 오른쪽으로 순차적으로 계산한다는 점에서 일방향(Unidirectional) 입니다.

BERT(Bidirectional Encoder Representations from Transformers)

- 마스크 언어 모델로 문장 중간에 빈칸을 만들고 해당 빈칸에 어떤 단어가 적절할지 맞히는 과정에서 Pre-train을 합니다. 빈칸 앞뒤 문맥을 모두 살필 수 있다는 점에서 양방향(Bidirectional) 입니다.

- 트랜스포머에서 BERT는 Encoder, GPT는 Decoder만 취해 사용한다는 것 또한 다른 점입니다.