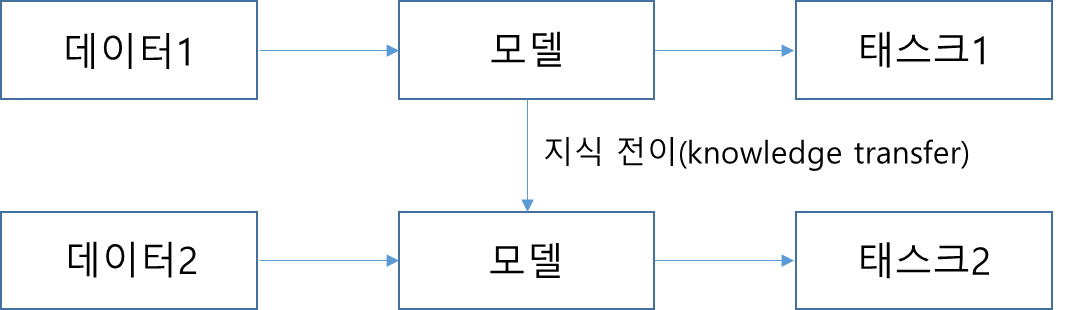

Transfer Learning 이란?

- 특정 태스크(Task)를 학습한 모델을 다른 태스크 수행에 재사용하는 기법입니다.

- 트랜스퍼 러닝을 적용하면 기존보다 모델의 학습 속도가 빨라지고 새로운 태스크를 더 잘 수행하는 경향이 있습니다.(Bert / GPT 등등)

- 아래와 같이 태스크2를 수행하는 모델을 만든다고 가정한다면 모델이 태스크2를 배울 때 태스크1을 수행해본 경험을 재활용할 수 있습니다.

- 위의 그림에서 태스크 1을 업스트림 태스크(Upstream task) 라고 하고 태스크 2를 다운스트림 태스크(Downstream task) 라고 합니다.

Upstream Task

- Pretrain : 업스트림 태스크를 학습하는 과정

- 다음 단어 맞히기로 Pretrain 수행 : GPT 계열의 모델(Language Model)

- 빈칸 채우기로 Pretrain 수행 : Bert 계열의 모델(Masked Language Model)

Downstream Task

- Pretrain을 마친 모델을 구조의 변경 없이 그대로 사용하여 자연어 처리의 구체적인 과제들을 수행

- 분류 : 자연어를 입력받아서 해당 입력이 어떤 범주에 해당하는지 확률 형태로 반환

- Finetuning : Pretrain을 마친 모델을 Downstream Task 에 맞게 업데이트하는 기법