위클리 NLP

1.[weekly NLP] Week 1

컴퓨터에게 언어는 어떤 의미? 언어란 하나의 시스템, 즉 체계 문자열(character) -> 음절(syllable) -> 단어 (word) 컴퓨터는 모든걸 숫자로 본다. 그 기반으로 발전해 오고 이것을 디지털이라고 한다. > 단어는 어떻게 숫자로 표현될 수 있을까? vector로 표현 단어를 vector로 표현하는 것을 one-hot vecto...

2.[weekly NLP] Week 2

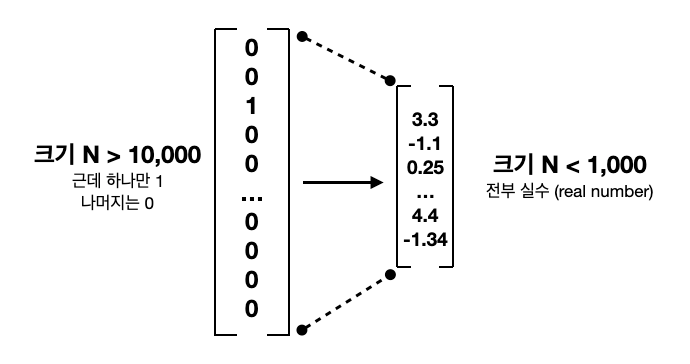

Week 2 - 단어를 가방에 때려 넣으면 문장이 된다 문장을 이해하는데 단어의 순서는 중요하다. 하지만 문장이 어떤 주제를 가지는지만 알고 싶다면 순서는 크게 상관없다. NLP에서는 해결하고자 하는 문제에 따라 문장을 표현하는 방법이 달라질 수 있다. Bag-of-words (BoW) one-hot vector는 단어를 한개의 column vec...

3.[weekly NLP] Week 3

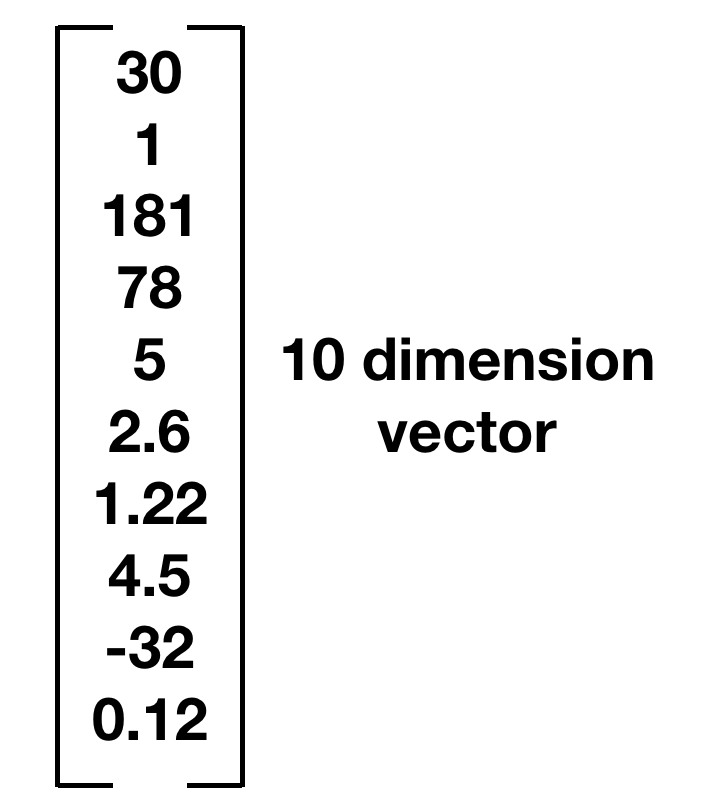

Vector 기초잡기 벡터란? Scalar(스칼라) = 크기가 있는 물리량 몸무게, 키, 컵의 물의 양 나타내는 숫자 모두 scalar Vector는 방향도 포함한다. 몇 차원의 공간에서 표현되느냐에 따라 크게 달라진다. vector는 N차원 공간에 사는 존재 = euclidean space 10차원 같은 4차원 이상 vector 어떻게 표현할까?...

4.[weekly NLP] Week 4

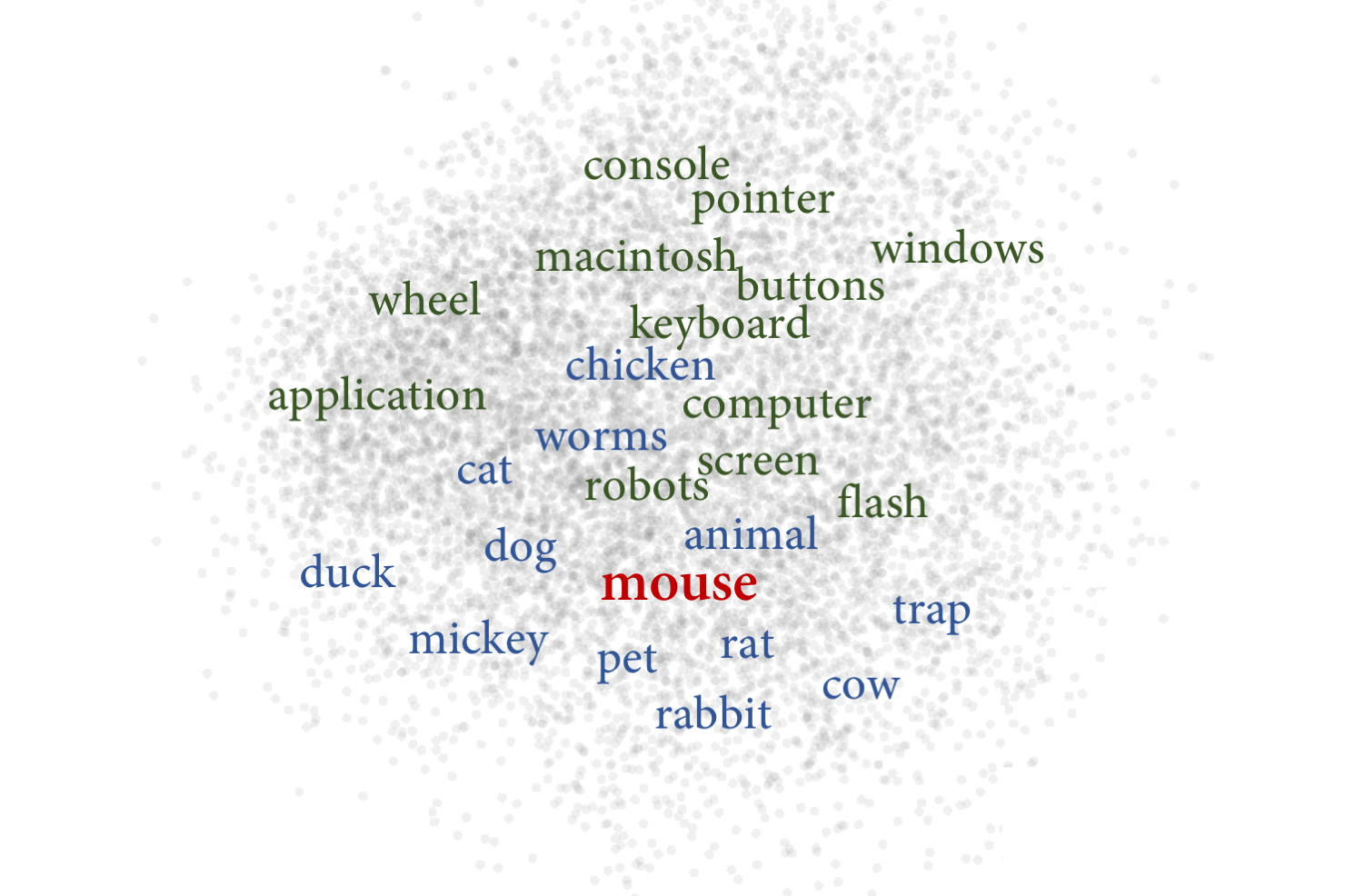

minus plus = ? 단어 간의 관계를 학습해 vector에 저장하는 word embedding 이라는 중요한 모델 소개 Distributional Hypothesis (분포가설) 단어는 주변 단어들에 의해 정의된다. unsupervised learning (비지도학습) -> 따로 시간, 돈 들여 데이터 가공할 필요 없이 그냥 책, 인터넷에 있...

5.[weekly NLP] Week 5

애랑 나랑 얼마나 비슷해? NLP에서 Vector의 역할은? Bag-of-Word (BoW) vector 또는 tf-idf vector는 문장을 단어의 빈도수를 계산해 N차원의 column vector로 표현한 것을 배웠다. N은 전체 단어의 숫자 word embedding은 각 단어들 GloVe, skipgram같은 알고리즘으로 단어들 비교적 작은 ...

6.[weekly NLP] Week 6

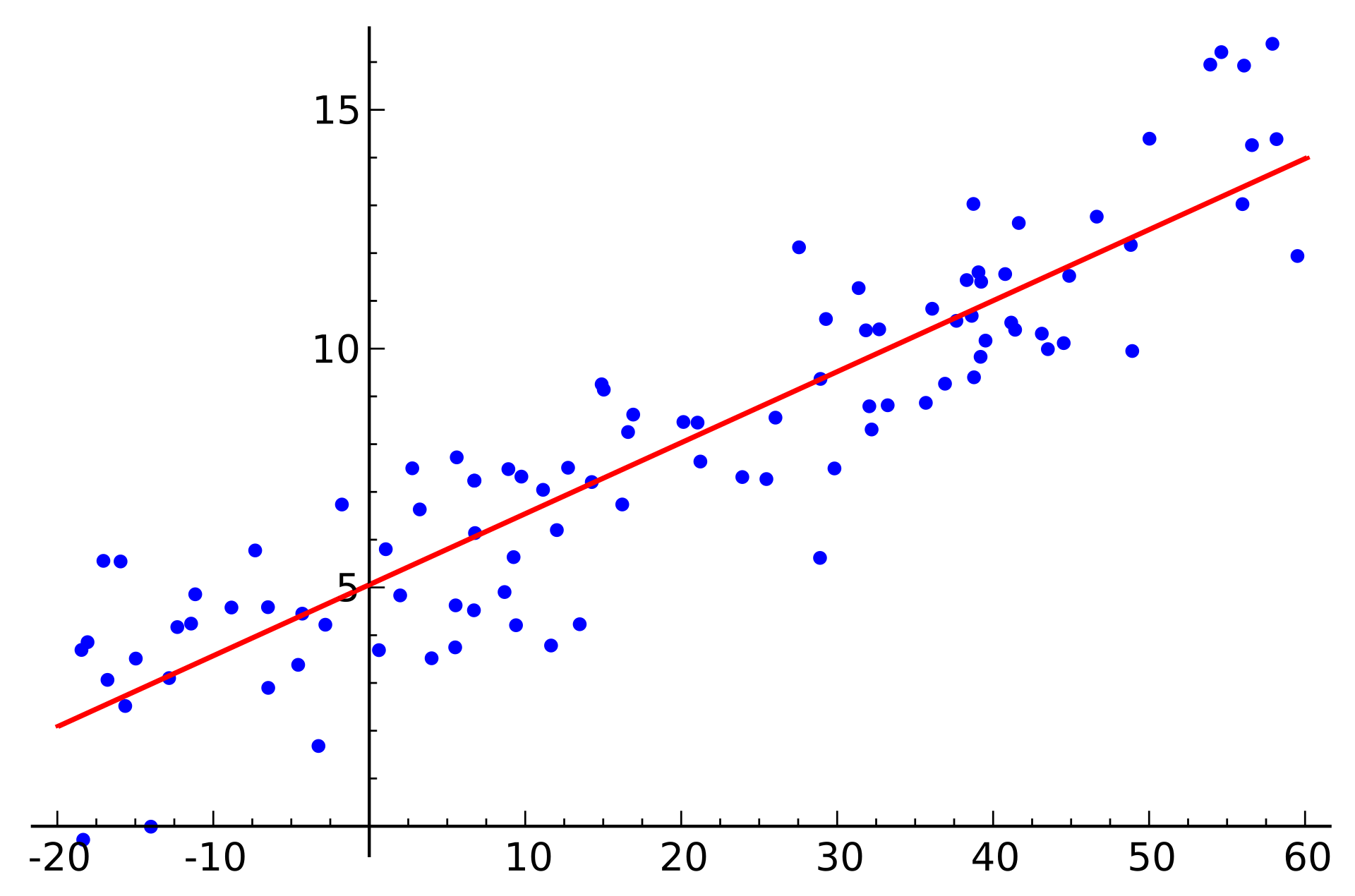

문서들 주제별로 분류 NLP 분야에서는 이 주제를 document(text) classification 이라고 한다. 0이냐 1이냐: Binary Classification Classification에서 가장 기본적이고 쉬운 것은 이분법(binary)다. machine learning에서 수학이 좀 더 쉬워지는 좋은 방법 machine learni...

7.[weekly NLP] Week 7

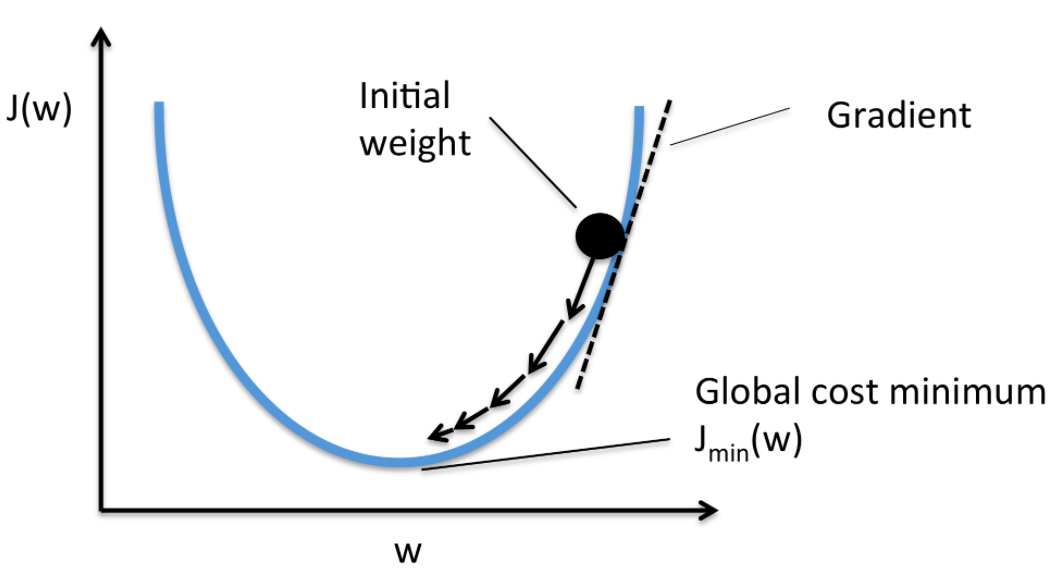

Machine learning과 NLP 왜 함께 갈까 언어를 이해한다는 것은 무슨 의미일까? NLP에서 가장 큰 화두는 언어 이해(NLU)다. 거의 모든 NLP 문제는 NLU가 필요하다. 대화 시스템은 유저가 무엇을 원하는지 이해해 답을 해야하고, 감성 분석은 글쓴이가 어떤 주제에 대해 어떤 감성을 가지고 있는지 파악해 숫자로 나타내야 한다. 그렇기 때...

8.[weekly NLP] Week 8

스팸 이메일 분류기 만들기 NLP 기술로 편지함에서 스팸 걸러낼 수 있는 감지모델 기본적인 통계 모델 Naive Bayes Classifier 사용 이분법으로? 가장 간단한 0, 1로 나누는 이분법을 logistic regression이라는 통계 모델을 가지고 학습 해봤는데 Spam detection도 이분법으로 가능할까? 문제는 어떤 데이터를 가지...

9.[weekly NLP] Week 9

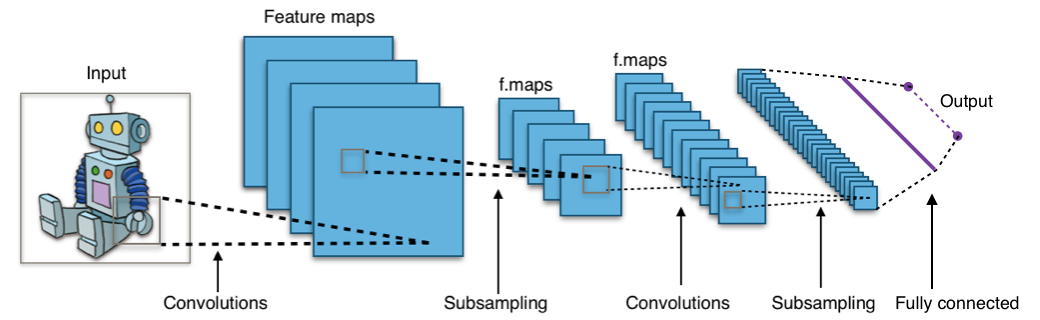

이미지 부분 부분을 현미경으로 줌 인해 본다.이것을 필터(convolution filter)라고 하는데, 이 필터를 이미지 전체를 훑으며 살펴보도록 움직여 전체 이미지에 대한 이해를 형성하는 구조를 가지고 있다.http://taewan.kim/post/cnn/

10.[weekly NLP] Week 10

CNN은 input 길이 너무 길거나 여러 input간 길이간 차이가 다양하면 효율적으로 처리하기 어렵다는 단점 가진다 사람이 읽는 것처럼 문장의 단어들 순차적으로 처리한다면? 이런 방식에 아주 적합한 다른 neural network모델은 recurrent neural network (RNN)이다. Time Series Modelling의 강자 RNN ...

11.[weekly NLP] Week 11

y = f(x) x는 input, y는 output 예를 들어 x는 영화 대사, y는 반말(o), 존댓말(1)이라고 한다. 만약 어떤 관객이 x를 들었을 시, 즉시 y를 결정할 수 있을 것 이다. (x,y) ("라면 먹고 갈래요?",1), ("혼자니?",0), ("싱글이야",0), ("눈사람 같이 만들어요",1) 영화 몇 편만 보면 몇 백개, 몇 천...

12.[weekly NLP] Week 12

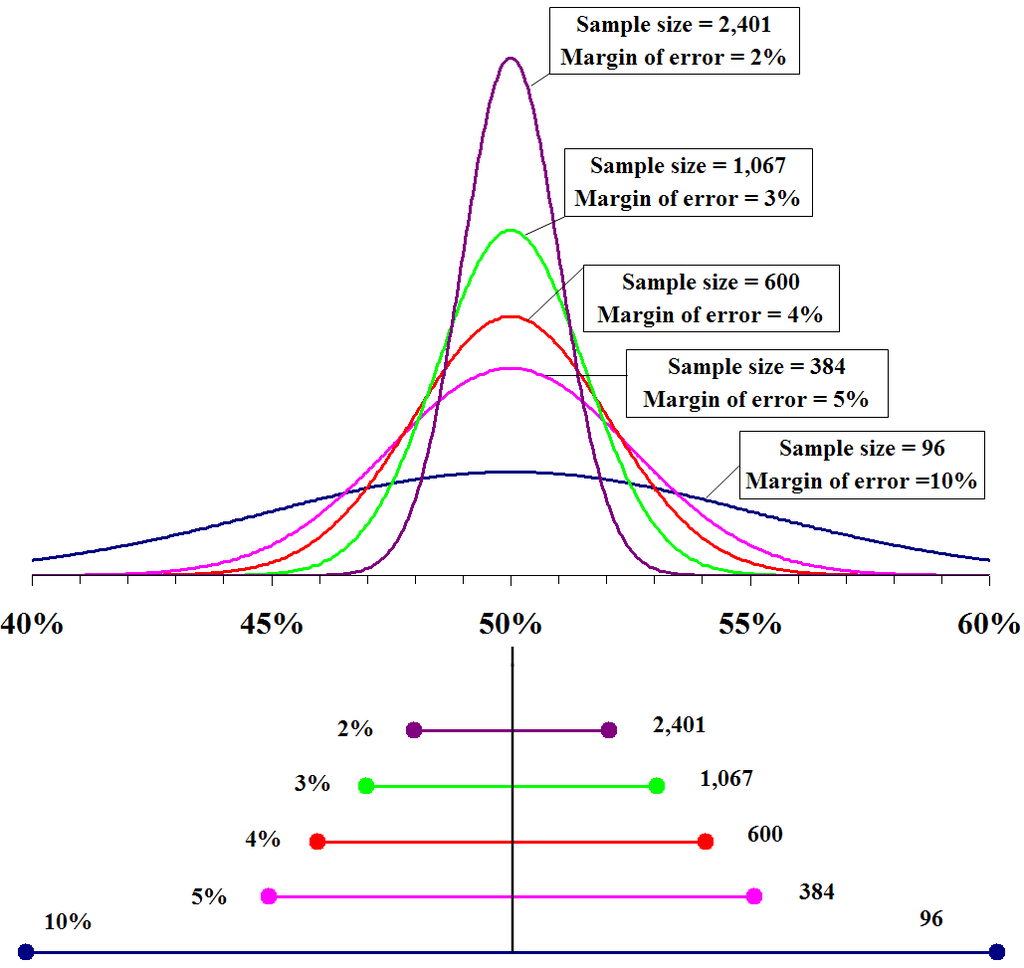

학습 데이터 뿐만 아니라 평가용 데이터도 중요한 이유 지난번 문서 분류 모델 중 텍스트 감성평가 모델을 예시로 데이터 형태를 100,000 쌍을 가지고 있다고 하자 ("재밌어",1) ("재미없어",0) ("배우가 연기를 잘해",1) ("배우가 연기를 못해",0) 이렇게 100,000쌍의 데이터를 전부 학습용(training data)로 쓰고나서 모델이...

13.[weekly NLP] Week 13

Likeliness - 그럴듯함? Likeliness 직역하면 '그럴듯하다' 누가 어떤 일이 일어났다고 설명해줄 때, 우리는 "그럴듯하네" 반응한다. 우리가 문장을 읽을 때도 그렇다. 딱 읽고 자연스러운 문장은 "그럴 듯"하기에 술술 읽힌다. 조금이라도 이상한 단어 쓰이거나 문법 틀리면 우리는 바로 부자연스러움을 느낀다. 우리 뇌는 이미 LM을 구축해 놓...