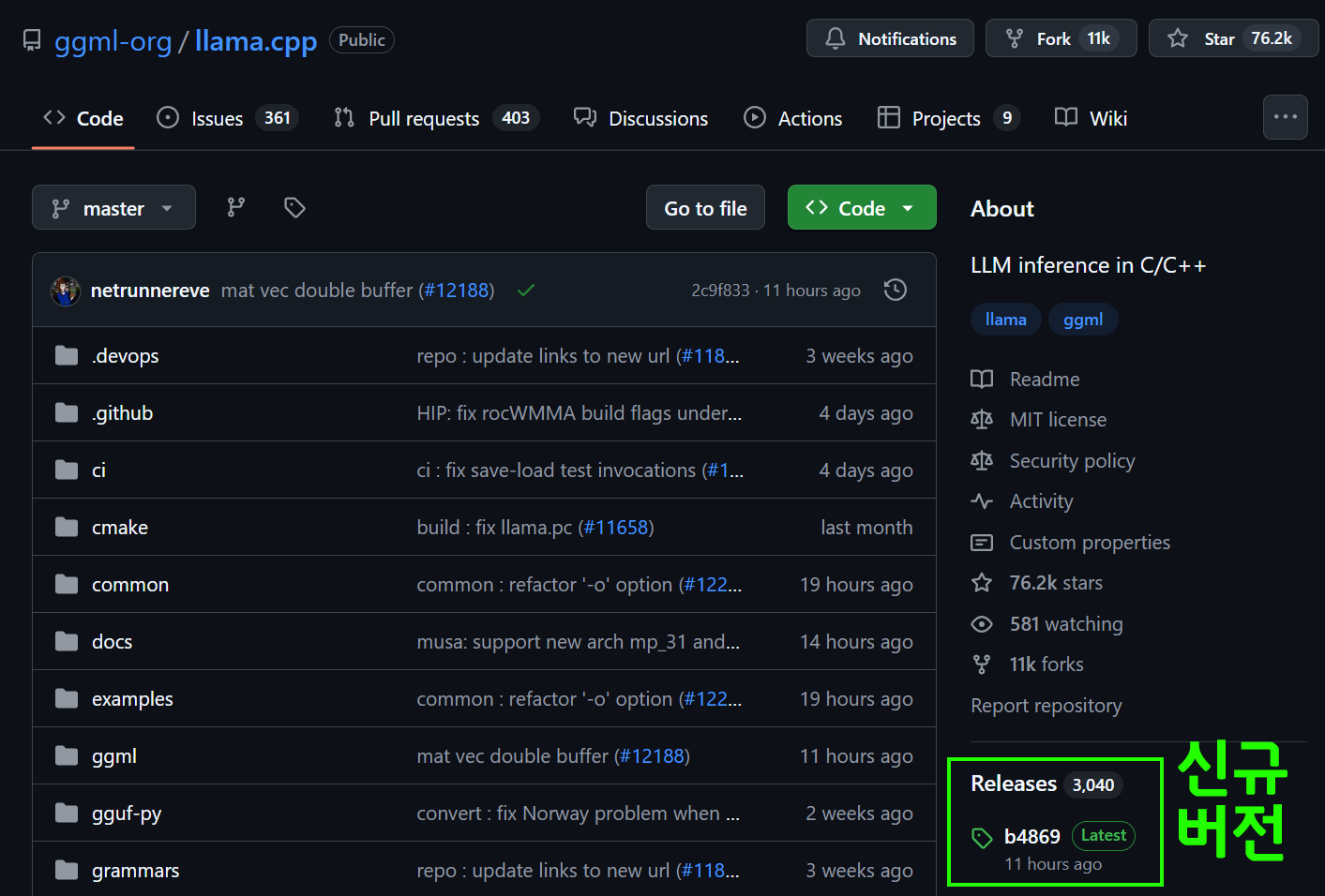

https://github.com/ggml-org/llama.cpp

llama.cpp를 사용해서 Hugging Face Checkmodel 규격을 GGUF변환해서 사용하거나 llama.cpp-cli를 이용해 LLM Serving API를 사용하는 경우에는 llama.cpp가 신규버전이 릴리즈 되었는지 자주 확인하는 습관을 들여야 한다.

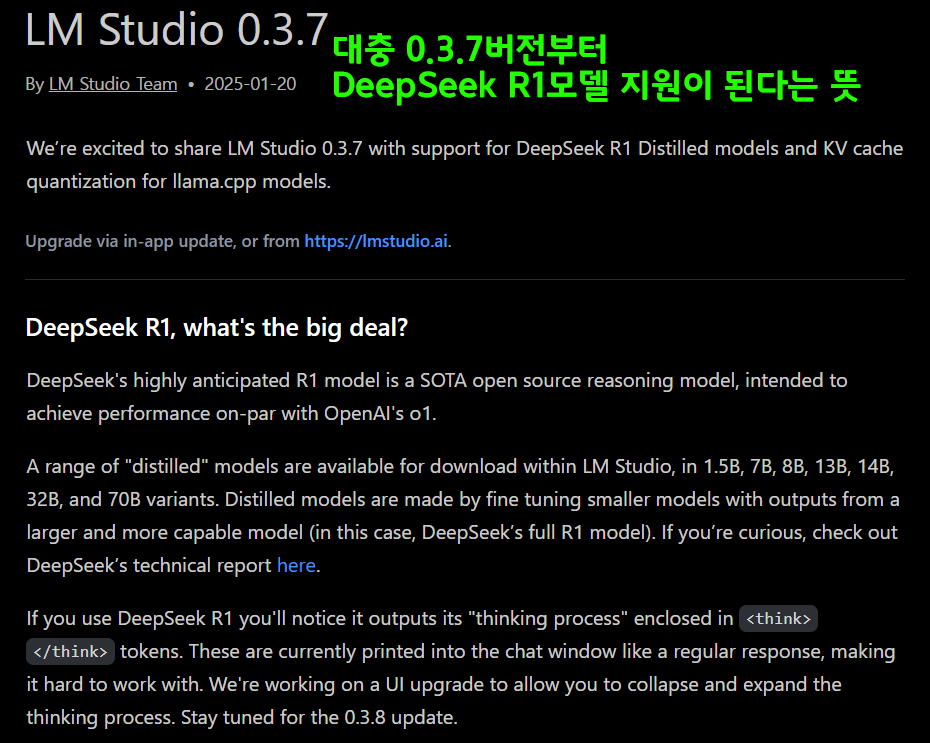

다른 llm Serving API인 LM Studio의 경우

위 사진처럼 신규 버전이 출시되면 업데이트 하라는 팝업이 뜨고

왜 업데이트가 필요한지 신규버전 릴리즈 노트를 충실하게 기록하고 있다.

여기서 중요한 점은 신규버전이 출시될 때마다 신규 모델의 지원이 가능해진다는 것인데

llama.cpp도 동일하게 신규 버전이 release되면

최신 파운데이션 모델의 GGUF변환이나 로드가 가능해진다.

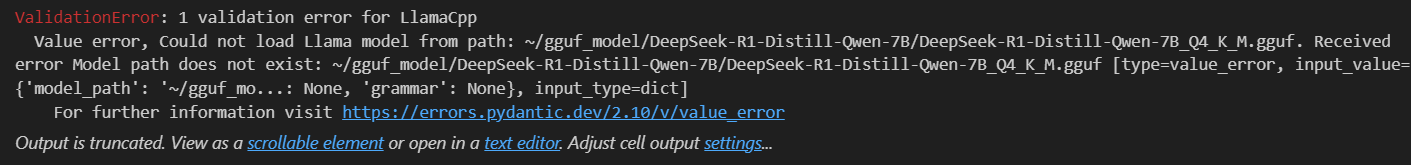

최신 버전으로 업데이트를 안할 시에는 위 사진처럼 모델 로드가 안되는 에러가 발생하거나 HF checkpont -> GGUF 변환 오류가 발생한다.

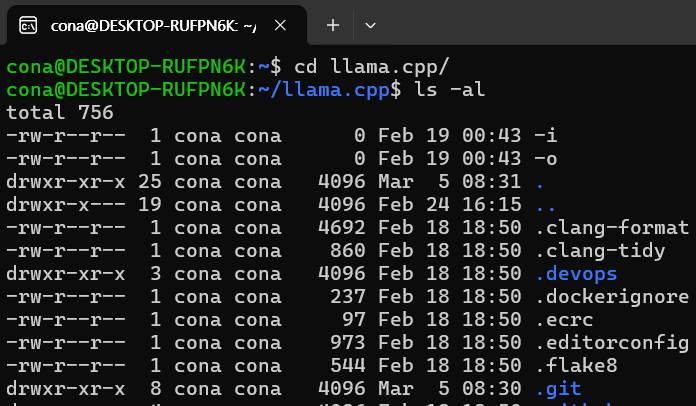

llama.cpp의 최신버전 업데이틑 아래의 절차를 따른다

1) llama.cpp가 설치된 폴더로 이동

위 사진처럼 git폴더가 있는것을 확인하자

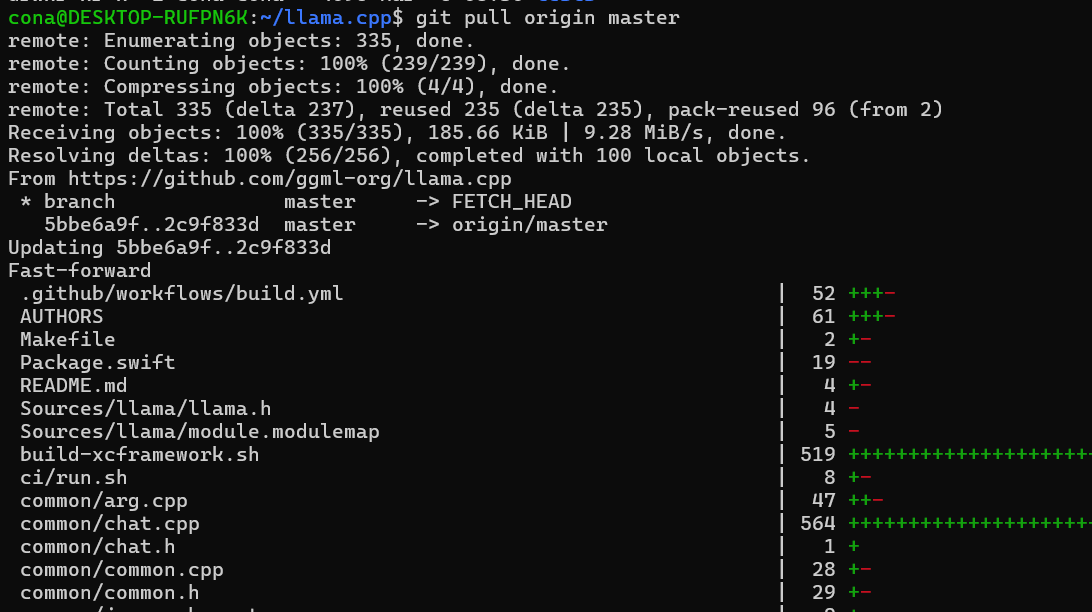

2) git pull origin master 입력

github에서 관리되고 있는 llama.cpp폴더를 최신버전으로 업데이트를 진행한다.

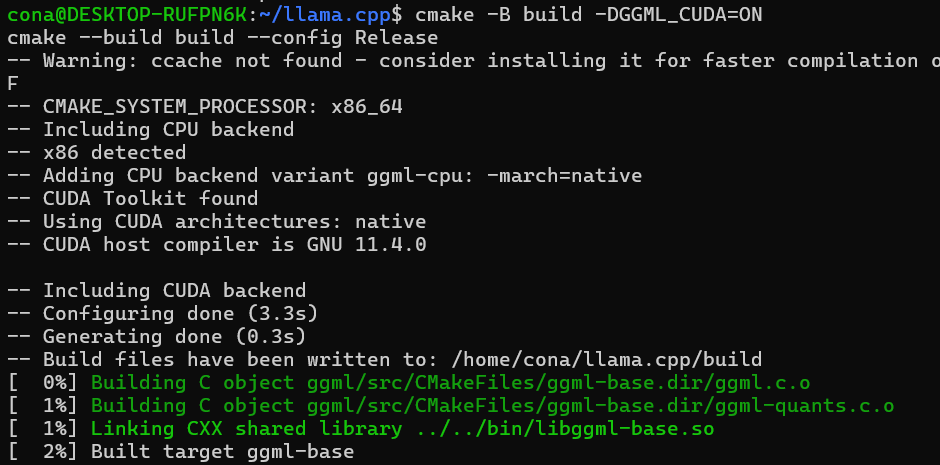

3) 업데이트 후 재빌드 수행

cmake -B build -DGGML_CUDA=ON

cmake --build build --config Release다들 CUDA (엔비디아 그래픽카드) 기준으로 llama.cpp를 사용한다면 위 사진처럼 업데이트 후 재빌드를 진행하면 된다.