Contrastive Language-Image Pre-Training

-

자연어는 Label과 달리 특정 개수로 구분되지 않음

-

이미지 마다 매칭되어 있는 설명 문장은 전부 다르기 때문에 softmax로 구분하는 학습 방법 불가

-

Contrastive Learning

- 매칭되는 데이터 Feature들끼리는 가까워지도록, 나머지 Feature들끼리는 멀어지도록 학습

-

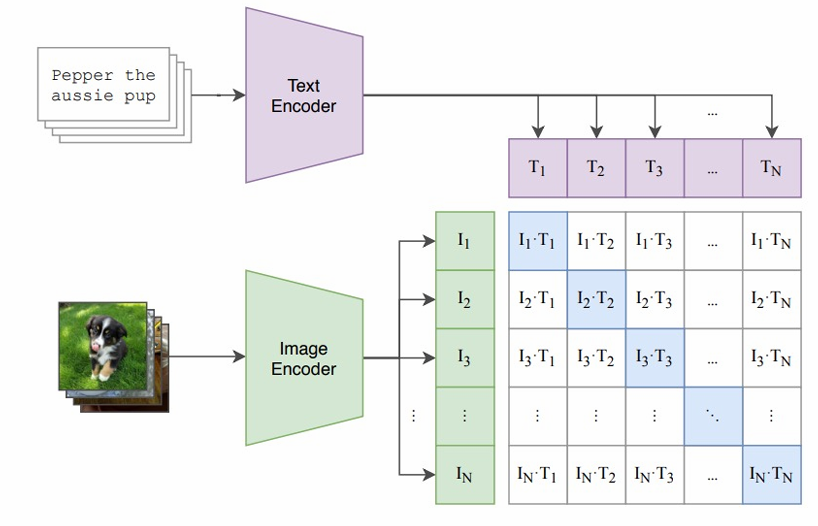

Contrastive Pre-Training

- 이미지와 해당 이미지에 대한 설명 Text를 pair로 두고 학습데이터셋으로 구성한 후, 각각을 인코더로 임베딩하여 같은 pair에 대해 거리를 가깝게 하고 다른 pair에 대해 거리가 멀어지도록 텍스트/이미지 인코더 학습 시킴

- 거리가 가까움 → 두 Feature의 Cosine Similarity가 커지는 방향

- 두개의Feature가 공간상에서 가까운 각도에위치할수록 → Cosine Similarity는 큰 값

- 이미지와 해당 이미지에 대한 설명 Text를 pair로 두고 학습데이터셋으로 구성한 후, 각각을 인코더로 임베딩하여 같은 pair에 대해 거리를 가깝게 하고 다른 pair에 대해 거리가 멀어지도록 텍스트/이미지 인코더 학습 시킴

-

zero shot prediction이 가능해짐

-

한 번도 학습하지 않은 문제를 맞추는 것

-

학습하지 않은 클래스를 예측

→ Image Feature와 Text Feature들간의 Cosine Similarity를 측정 , 그럼 해당 이미지를 가장 잘 설명하는 Text Feature와의 Cosine Similarity 값이 가장 크게 나옴 왜냐하면 CLIP이 바로 그렇게 학습했기 때문!!

-