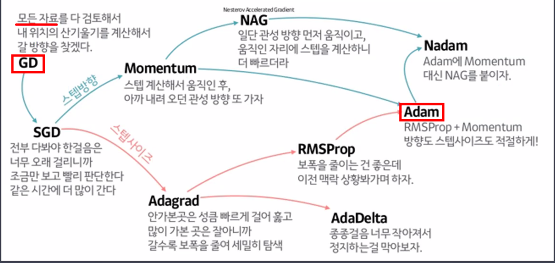

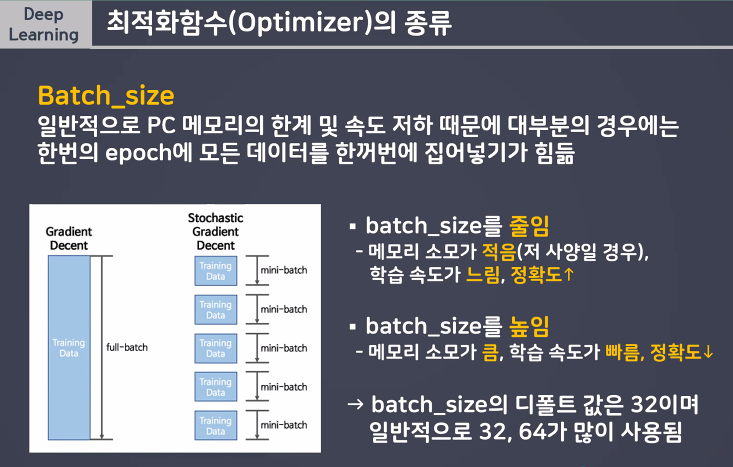

최적화함수의 종류

가장 많이 사용한 것은 SGD, Adam 입니다

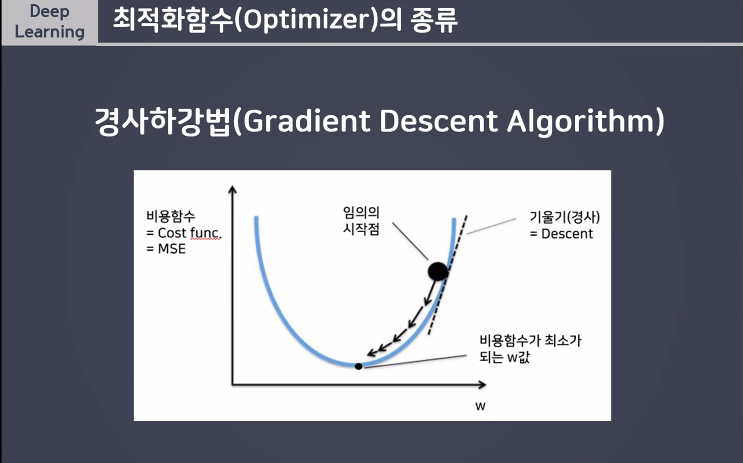

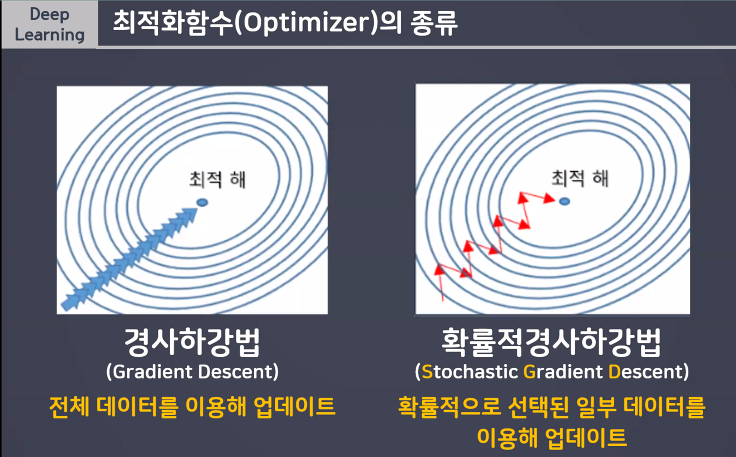

GDA (경사하강법) - Gradient Descent

경사하강법

모든 자료를 다 검토해서 내 위치의 산기울시를 계산해서 갈 방향을 찾겠다.

- 비용함수: mse = cost function

-> 비용함수가 최소가 되는 w 값

단점: 전체 데이터를 이용해 업데이트하니까 한번 학습하면 시간이 오래 걸리고

해결방법 : 확률적경사하강법 Stochstic Gradient Descent (SGD)사용

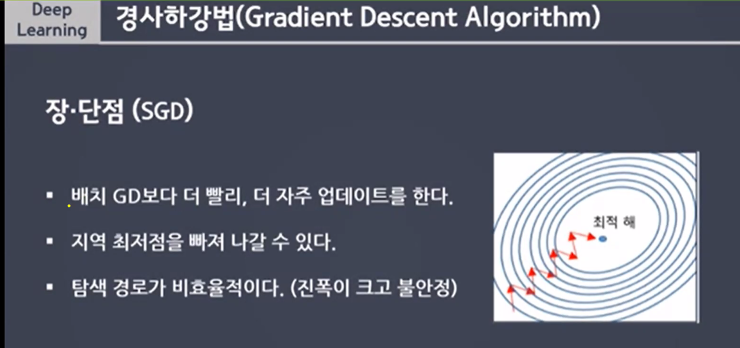

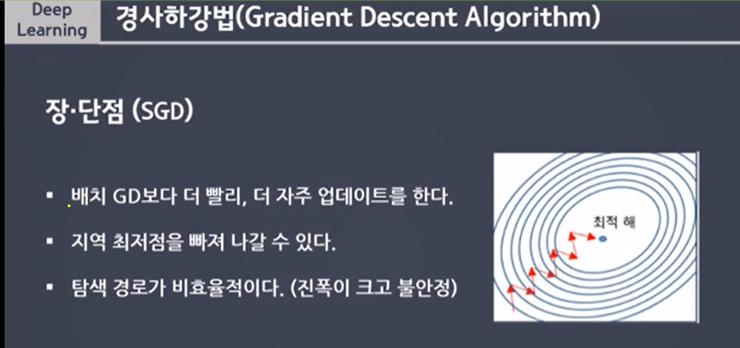

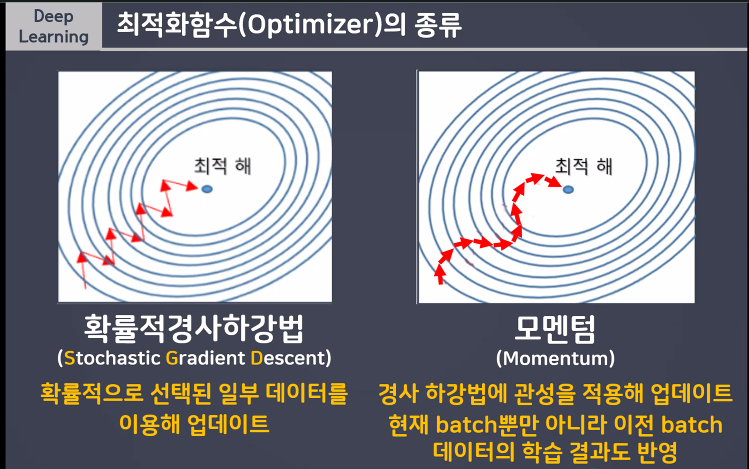

SGD (확률적경사하강법) - Stochastic Gradient Descent

전부 다봐야 한걸음은 너무 오래 걸리니까 조금만 보고 빨리 판단한다, 같은 시간에 더 많이 간다.

-> 결과는 잘나오는 편!

모멘텀 Momentum

경사 하강법에 관성을 적용해 업데이트 현재 batch 뿐만 아니라 이번 batch데이터의 학습 결과도 반영

스텝 계산해서 움직인 후, 아까 내려 오던 관성방향 또 가자

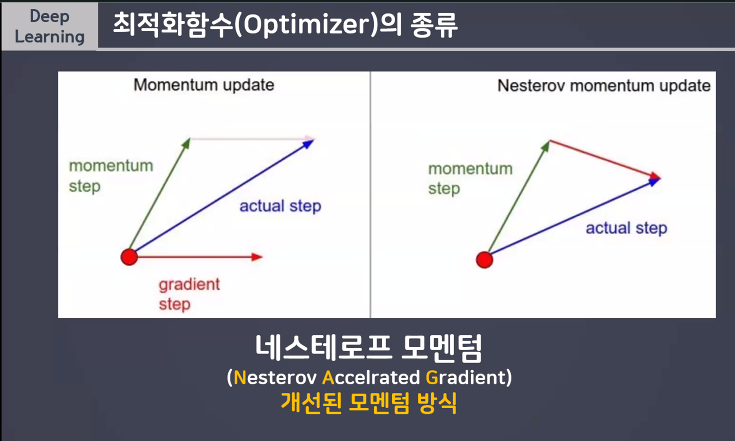

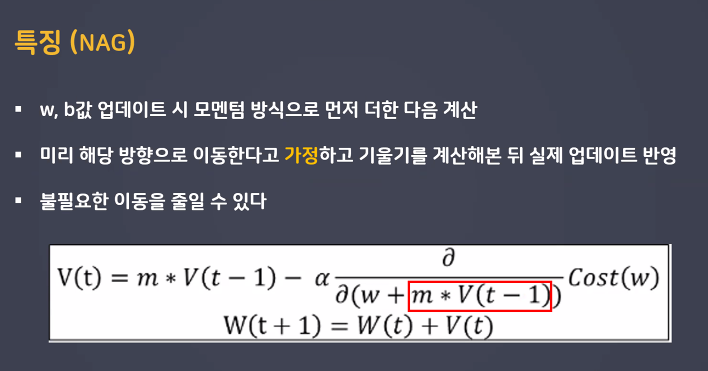

NAG (네스테로프 모멘텀) - Nesterov Accelrated Gradient

일단 관성방향 먼저 움직이고 움직인 자리에 스텝을 계산하니 더 빠르더라

특징

Nadam

Adam에 Momentum대신 NAG를 붙이자.

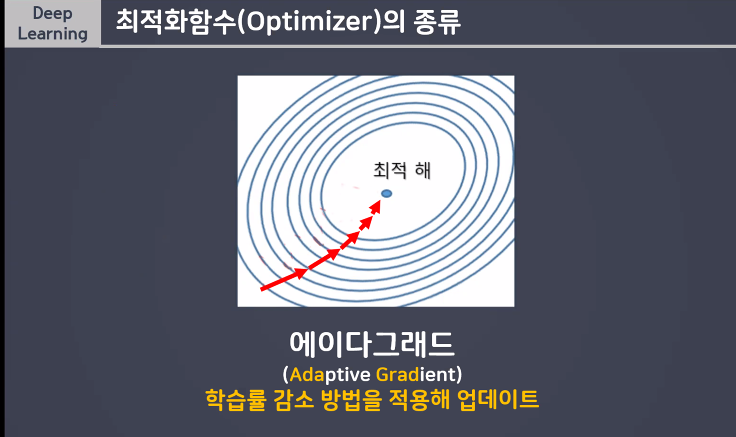

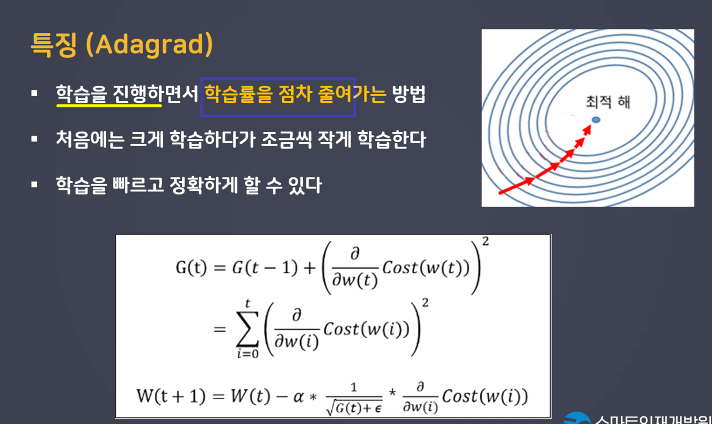

AG (Apdative Gradient) 에이다그래드

학습률 learning rate 감소 방법을 적용해 업데이트

안거본곳은 성큼 빠르게 걸어 홇고 많이 가본 곳은 잘아니까 갈수록 보푹을 줄여 세밀히 탐색

RMSProp

보푹을 줄이는 건 좋은데 이전맥락 상황봐가며 하자

Adam

RMSProp + Momentum 방향도스텝사이즈도 적절하게!

AdaDelta

종종걸음 너무 작아져서 정지하는걸 막아보자