최근 Deepseek가 많은 화제를 모으고 있습니다.

다만, 개인 정보 보호(프라이버시) 이슈가 있어, 간단히 로컬 환경에서 돌려볼 수 있는 방법을 정리했습니다.

다음은 로컬에서 Deepseek를 실행하는 과정입니다.

1. 로컬 테스트 환경

하드웨어 스펙

CPU: AMD Ryzen™ 5 5600X

GPU: GeForce RTX 3060Ti

RAM: DDR4 32G해당 스펙을 기준으로 Distill된 32b 모델로 진행했으며, 크게 무리 없이 작동했습니다.

2. Ollama 설치 및 Deepseek 모델 선택

1. ollama 설치

Ollama는 여러 환경에서 자체적으로 LLM 모델을 다운로드/관리하고, 명령어 실행을 간소화해주는 도구입니다.

설치가 끝나면 원하는 LLM 모델을 선택할 수 있습니다.

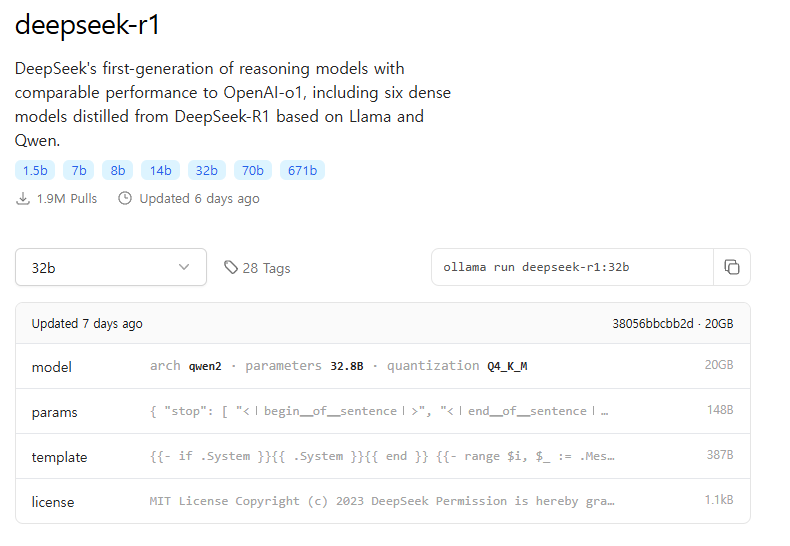

2. LLM 모델 선택

Distill된 32b 모델을 사용했습니다.

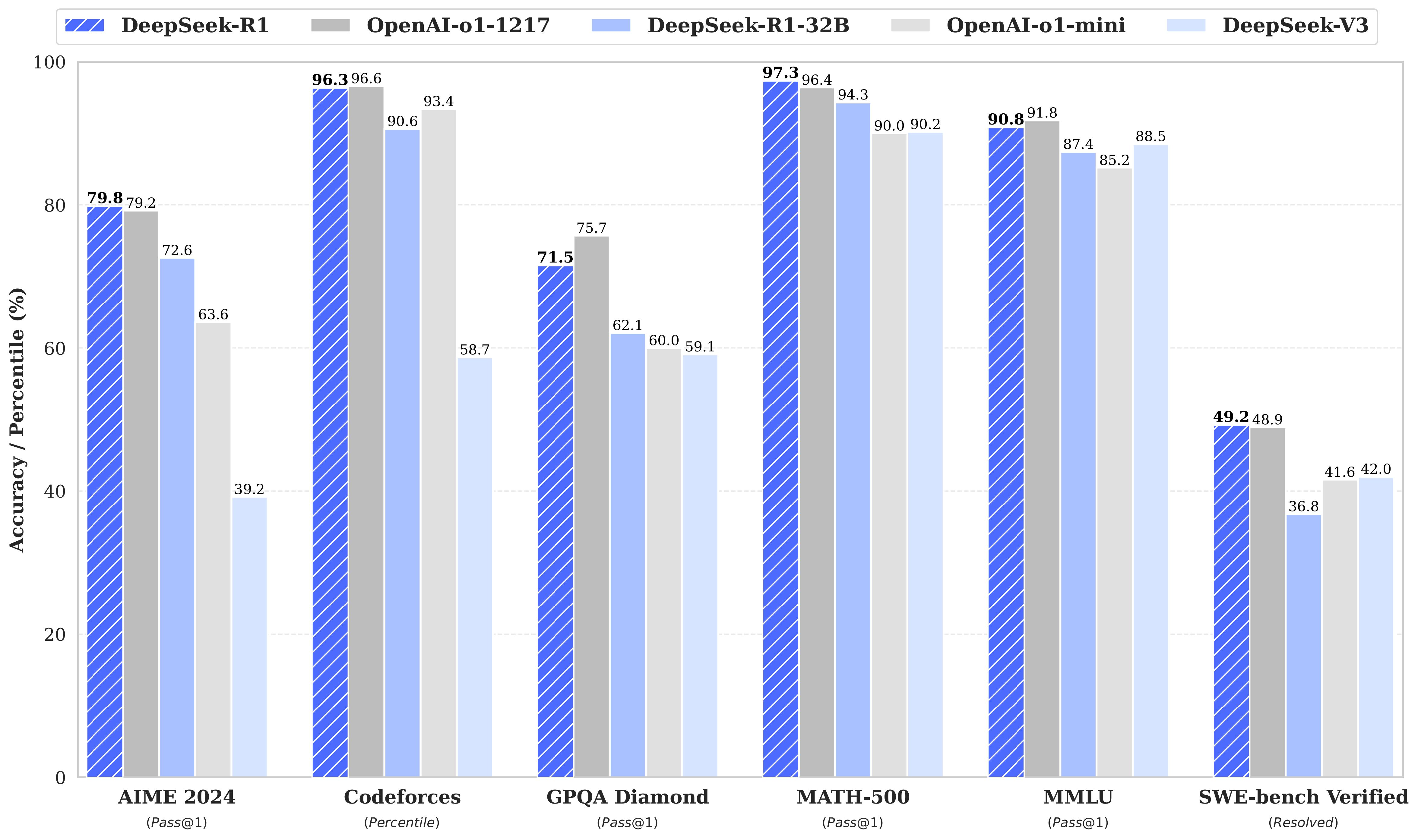

아래 이미지는 R1 버전과 32b 모델 성능 차이를 간략히 보여줍니다.

상황에 따라 모델 크기가 큰 쪽(R1) 혹은 Distill된 버전 중 적합한 것을 고르면 됩니다.

3. Deepseek 실행하기

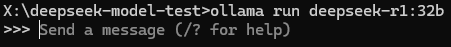

1. 명령어 입력

터미널(cmd)에서 다음 명령어로 Deepseek 모델을 로컬에 클론 받습니다.

ollama run deepseek-r1:32b모델 파일이 클론될 때까지 잠시 기다립니다.

2. 모델 동작 확인

클론이 끝나면 아래처럼 프롬프트를 입력할 수 있습니다.

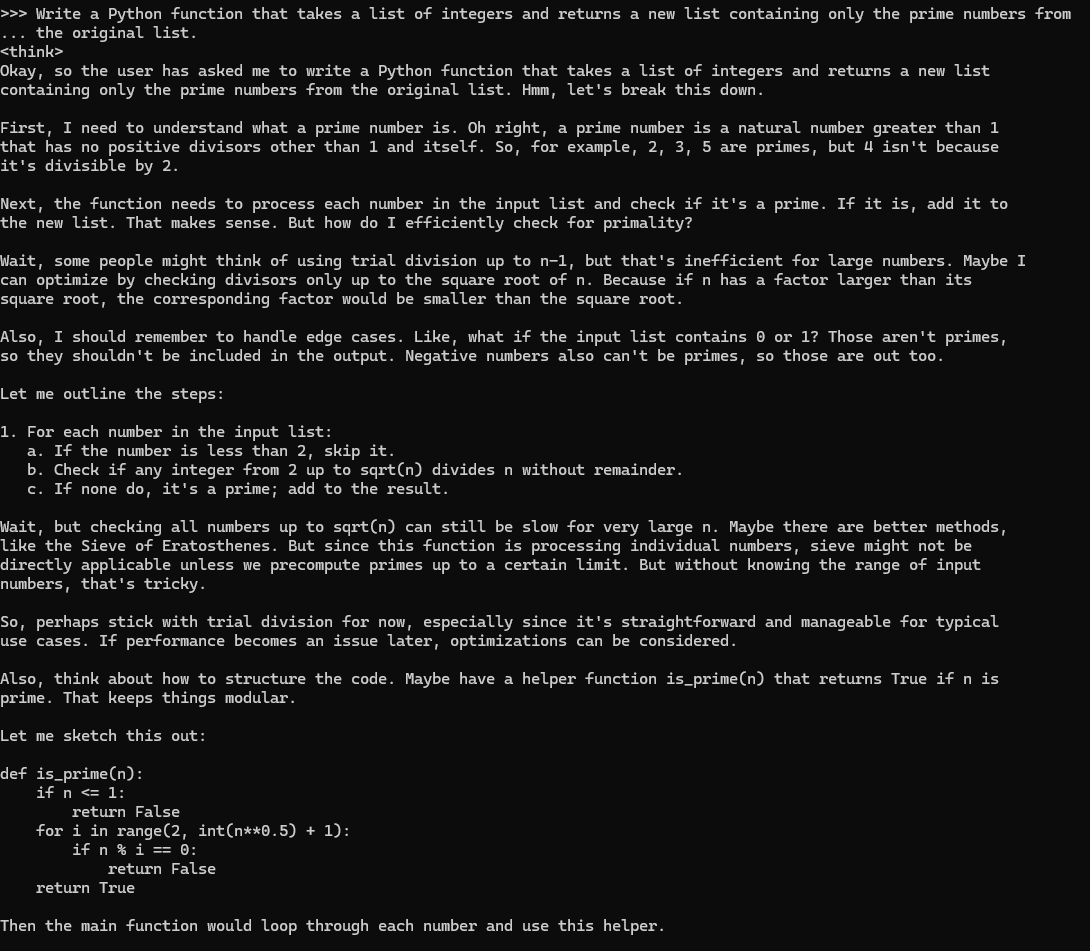

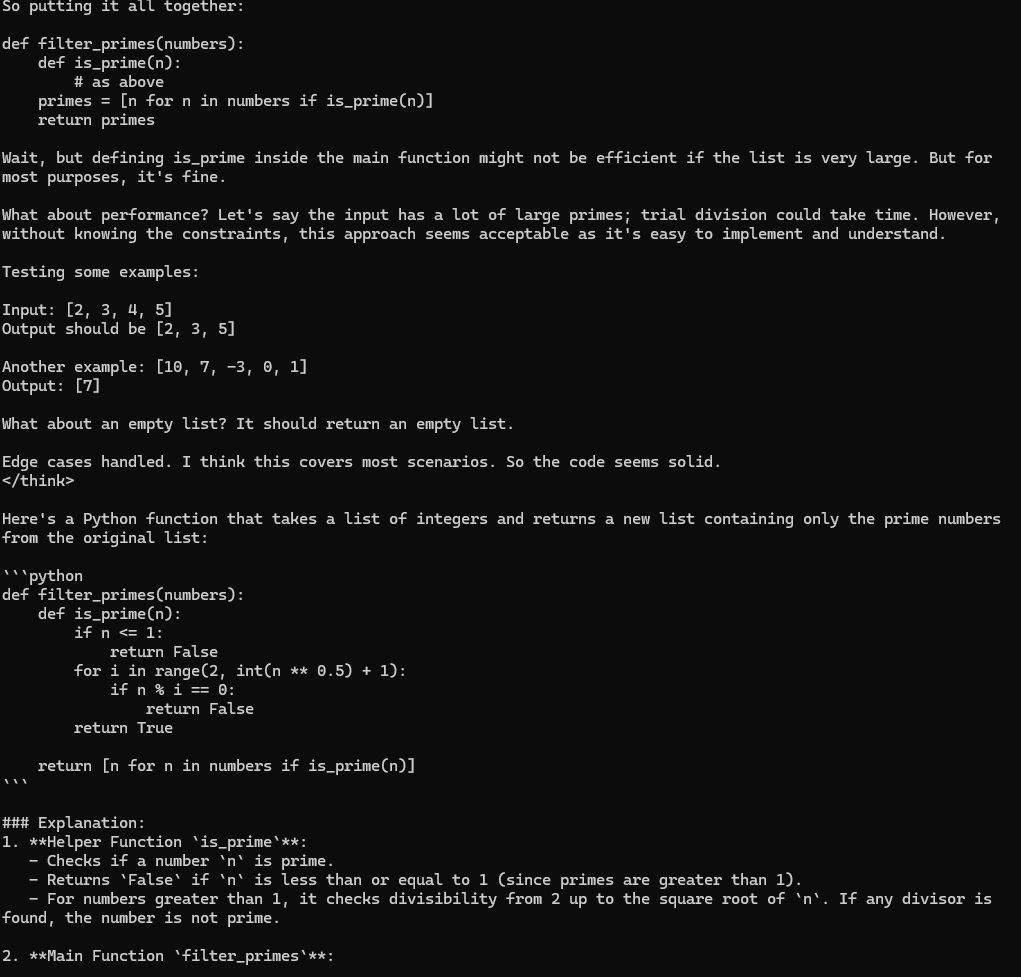

예시 프롬프트:

Write a Python function that takes a list of integers and returns a new list containing only the prime numbers from the original list.

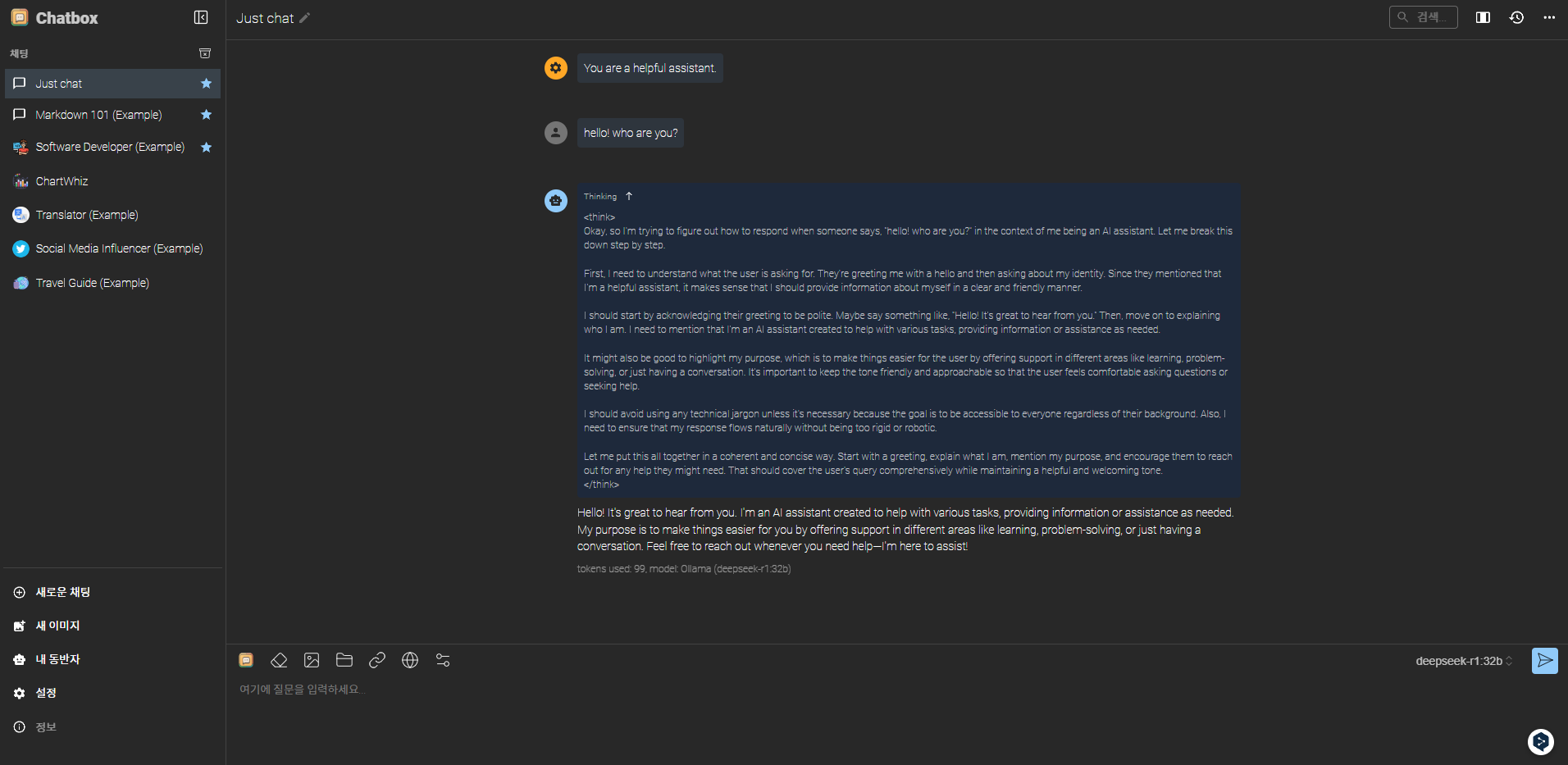

Deepseek가 스스로 추론하는 과정을 콘솔 상에서 직접 확인할 수 있습니다.

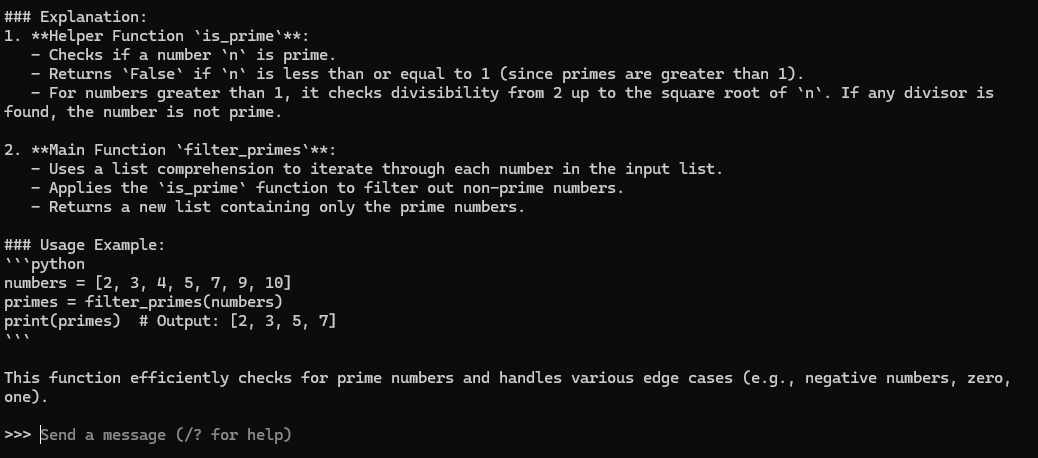

실제 출력 결과로 보아, 32b 모델이 문제없이 실행되는 것을 확인했습니다.

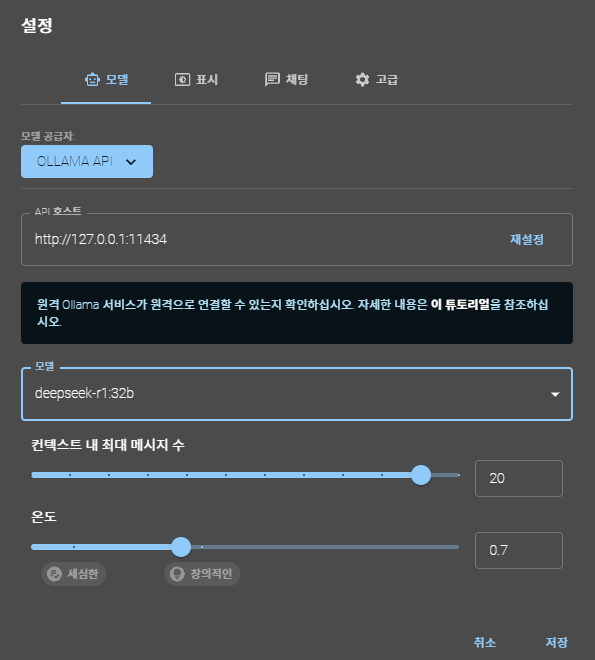

4. GUI 기반의 Chatbox 사용

CLI(명령 프롬프트) 대신 대화형 GUI가 더 익숙하다면 Chatbox라는 서비스를 활용해 로컬 모델을 실행할 수 있습니다.

마치며

간단히 Ollama와 Deepseek를 연동해 로컬 환경에서 실험해본 과정을 공유했습니다. Distill된 모델과 일반 모델 간의 차이를 숙지하여, 자신의 하드웨어 스펙과 작업 목적에 맞는 모델을 선택하면 됩니다.

특히 Deepseek가 무료 오픈소스로 제공된다는 점은 정말 놀랍습니다. 상용 서비스(예: ChatGPT)와 견줄 만한 수준의 성능을 무료로 활용할 수 있다는 것은 큰 장점입니다.

이 글이 로컬 환경에서 Deepseek를 직접 시도해보고자 하는 분들께 도움이 되길 바라며 마치겠습니다.

2개의 댓글

The versatility of the Escort Service in Defence colony means there’s a perfect match for everyone. Whether you're seeking a casual outing or a more intimate experience, the options are plentiful.

Defence colony Escorts

Defence colony Escorts Service

Defence colony Escorts Agency

Defence colony Escort

Escort in Defence colony

Escorts Service in Defence colony

Defence colony Escort Service

속도는 괜찮나요. 저도 동일한 사양인데 32b 급 모델 돌리면 시간이 워낙 오래 걸려서.