딥러닝

1.Qwen3-VL review

Abstract Qwen3-VL의 3가지 핵심 기둥 획기적으로 강화된 순수 텍스트 이해력(markedly stronger pure-text understanding): 동급의 텍스트 전용 백본 모델을 능가하는 수준 견고한 롱컨텍스트 이해: 텍스트뿐만 아니라 이미

2026년 1월 6일

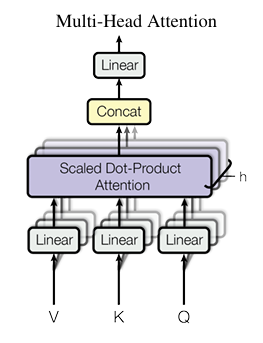

2.Transformer의 어텐션에 대해 수식으로 이해하기

Attention is all you need에서 처음 제안되는 Transformer 아키텍쳐에 대해 수식적으로 이해하기 Scaled Dot-Product Attention Fig 1

2026년 1월 7일