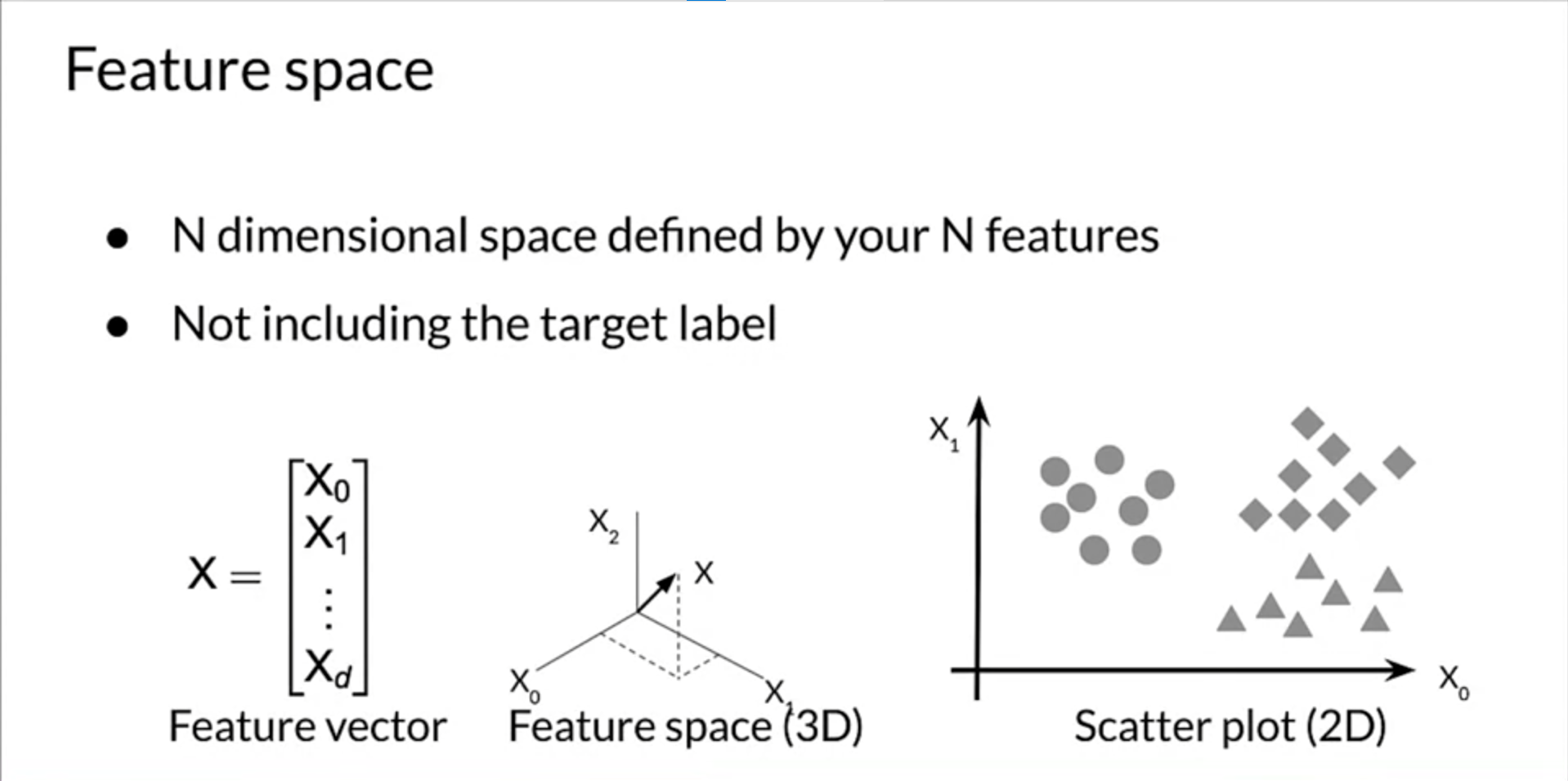

Feature space

1. Feature Space

- Feature Space란, 정의한 feature의 N 차원으로 정의됨. 만약에 2개의 feature를 정의하였으면 2차원으로 정의됩니다.

- 다만, target label은 포함되지 않습니다.

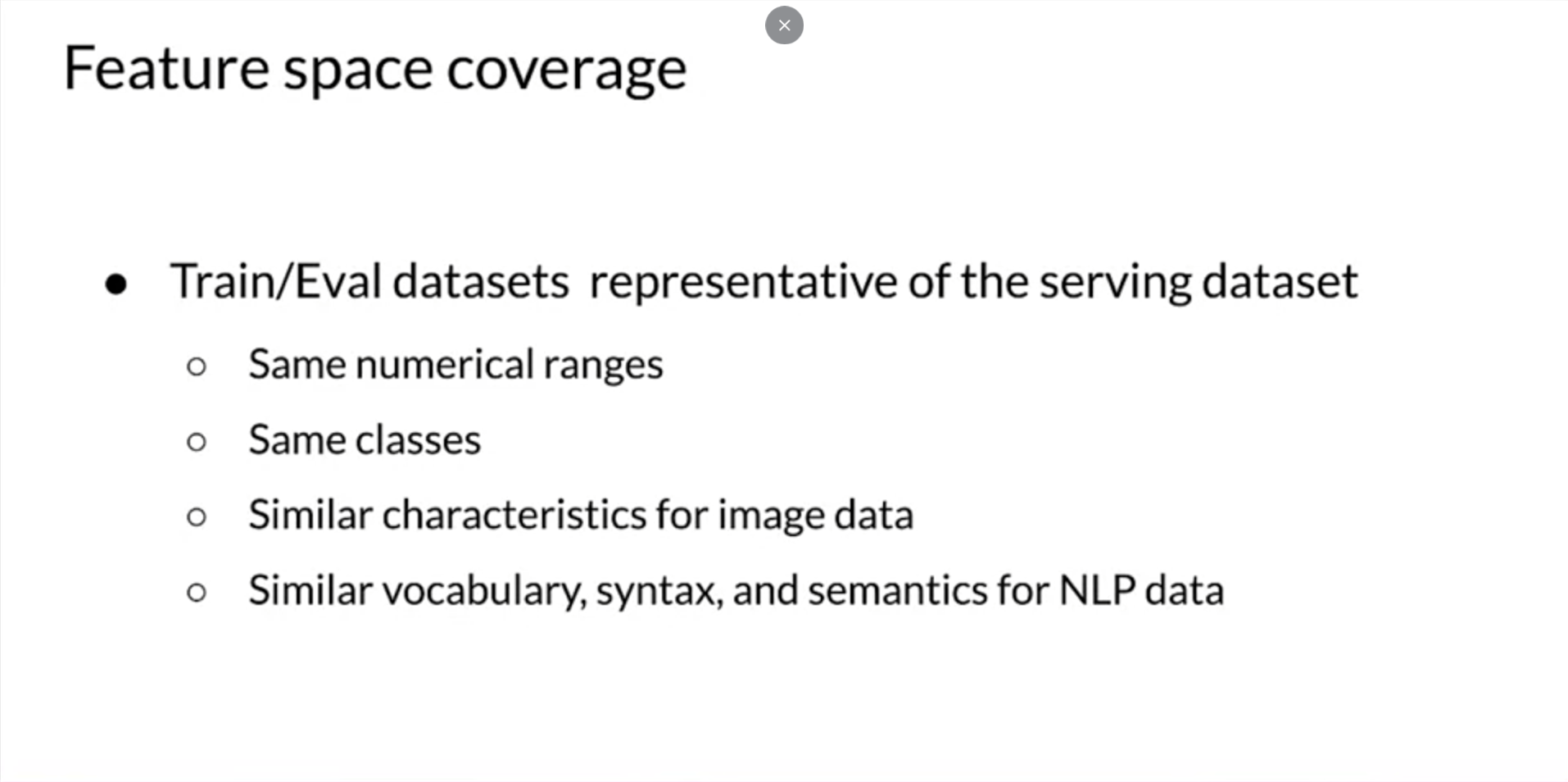

- Feature Space coverage

- feature space coverage는 매우 중요합니다. train과 evalutation을 위한 데이터의 예시는, 대표성을 띄어야 하니다. 즉, 모델에 전달될 requests와 이 requests가 feature space에 있는 경우 해당 feature space의 영역도 model을 train하거나 evaluation할 때 다뤄야 합니다.

- 동일한 classes에 대한 동일한 차원

- image data에 대한 비슷한 특성(CV)

- 비슷한 단어, 구문, 의미(NLP)여야 합니다.

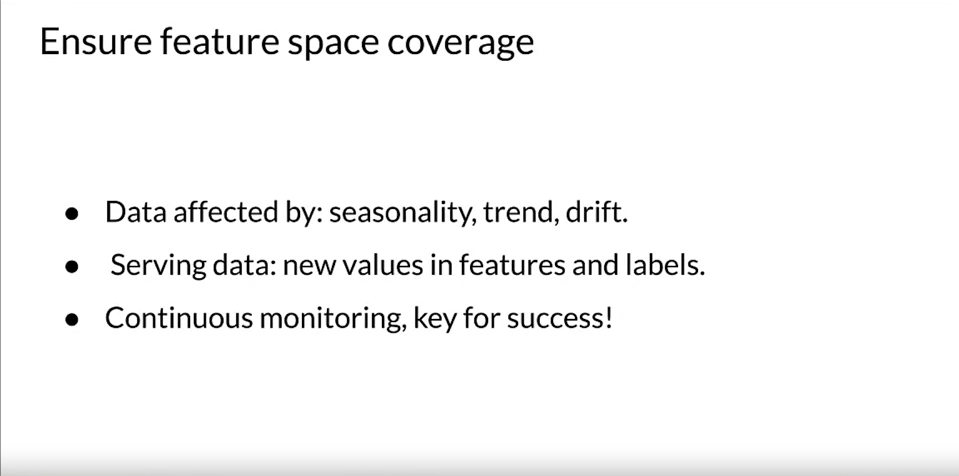

- Ensure feature space coverage

- 우리는 동일한 공간에 있는지 확실한 필요가 있습니다.

- 시계열 데이터에서 시즌을 고려해야 하고,

- Serving data의 경우, 영향을 미칠 new value를 new label에서 발견할 수 있습니다

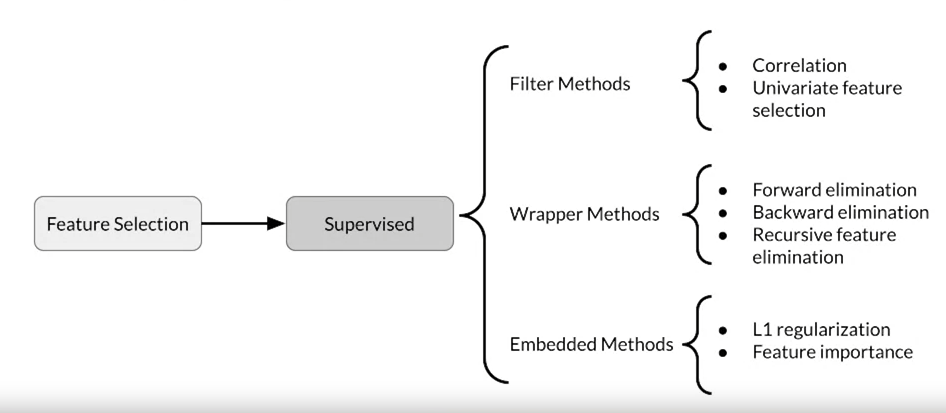

Feature Selection

- Supervised methods는 target과의 관계성이 있을 때 사용합니다. feature selection에는 세 가지 방법이 있습니다.

- Filter methods

- Wrapper Methods

- Embedded Methods

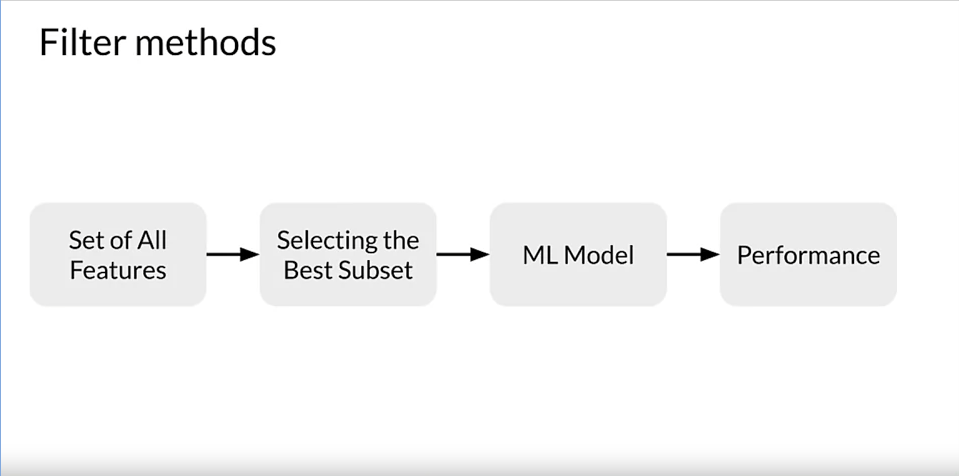

Filter Methods

- Filter methods는 correlation이 큰 feature를 제거한 후 사용합니다.

- 가장 많이 사용되는 filter methods는 Pearson Correlation과 Univariate Feature Selection입니다.

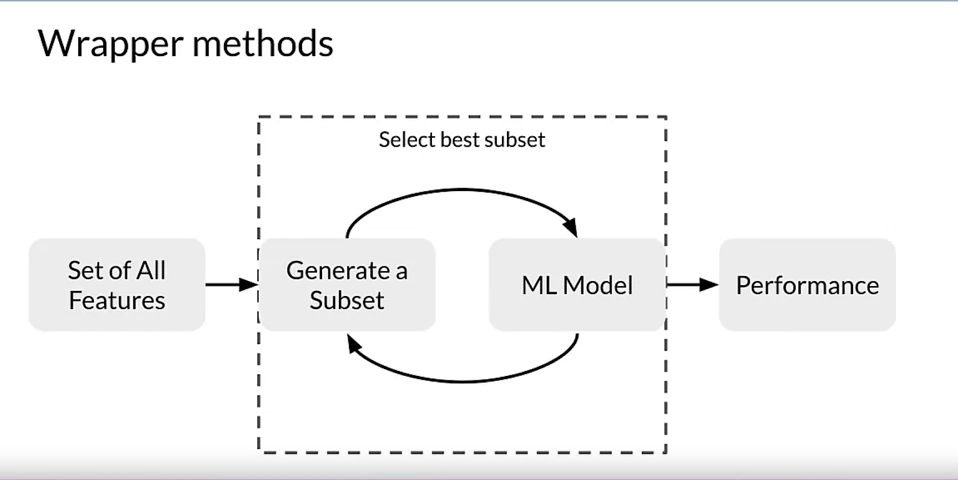

Wrapper Methods

- Wrapper methods는 feature selection을 하고 ML 모델에 serving을 한 다음, best feature들이 선택될때까지 피드백하는 것입니다.

- 가장 많이 사용하는 wrapper methods는 세가지 방법이 있습니다

- Forward selection은 Iterative greedy methode로,

- 처음에는 1개의 feature로 시작을 합니다.

- 한 번에 하나의 feature를 추가하면서 모델의 성능을 평가합니다.

- 최고 성능을 내는 다음 feature를 추가합니다.

- 모델 성능이 더 이상 향상이 없을때까지 반복합니다.

- Backward slection

- 처음에는 모든 feature로 시작을 합니다.

- 한 번에 하나씩 feature를 제거하면서 모델의 성능을 평가합니다.

- 최악 성능을 내는 다음 feature를 제거합니다.

- 모델 성능이 더 이상 향상이 없을때까지 반복합니다.

- Recursive feature elimination(RFE)

- feature importance를 평가할 모델을 선택을 합니다.

- 원하는 feature 수를 선택합니다.

- Fit the model.

- feature들의 importance를 순위를 매깁니다.

- 중요하지 않은 feature들을 제거합니다.

- 원하는 feature 수가 남을 때까지 반복합니다.

- Forward selection은 Iterative greedy methode로,

Embedded Methods

- L1, L2 Reguarization과 Feature importance는 feature selection에 있어서 중요한 embedded methods입니다.