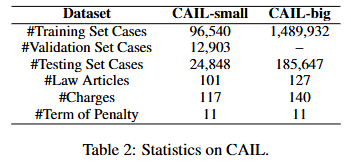

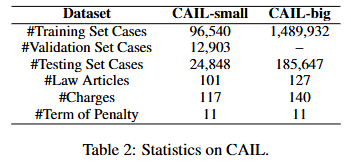

데이터셋

Input data: 범죄 사실

Output data: 법 조항(ta), 죄명(tb), 형량(tc) (ta,tc,tp∈T)

베이스라인 모델

Token representation layer

h1,h2,...hlf=Legal-BERT(x1,x2,...xlf)

- D={x1,x2,...xlf}: 범죄 사실을 토큰화 한 집합

- Hf={h1,h2,...hlf}: 피처 벡터

Generating context features

hˉ=maxpooling(h1,h2,...hlf)

맥스풀링 레이어를 거쳐 context representation을 만든다.

Incorporating law article semantics

이렇게 생성된 문맥 표현 hˉ와 관련된 법조항 사이의 연관관계를 학습시켜야 한다.

따라서 법조항을 위와 동일한 방식으로 Legal-BERT에 통과시킨 뒤 맥스풀링을 하여 context representation으로 만든다.

h1,h2,...hla=Legal-BERT(x1,x2,...xla)

- 법조항을 토큰화 한 집합 Da={x1,x2,...xla}

- 피처 벡터 Ha={h1,h2,...hla}

c=maxpooling(h1,h2,...hla)

이후 범죄 사실 진술과 법조항 사이의 연관관계를 학습시키기 위해, 아래와 같은 과정을 진행한다.

αj=hˉTWccj

- cj: j번째 c

- Wc: 학습 가능한 파라미터

이렇게 얻어진 αj는 hˉ와 cj 간의 연관관계에 대한 가중치이다.

cˉ=∑∑k=1exp(αk)exp(αj)cj

해당 범죄 사실에 대한 모든 법조항 사이의 연관관계를 구하여 가중치화한다.

이후 이들을 혼합하여, 해당 범죄 사실과 관련된 법조항의 정보를 통합한다.

yt^=softmax(Wt[hˉ;cˉ]+bt)

- hˉ: 범죄 사실로부터 생성된 context representation

- cˉ: 관련된 법조항의 정보가 혼합된 context representation

- Wt,bt: 학습 가능한 파라미터

- yt^: 예측 결과