[논문리뷰] DECISION-BASED ADVERSARIAL ATTACKS: RELIABLE ATTACKS AGAINST BLACK-BOX MACHINE LEARNING MODELS, ICLR, 2018

논문 리뷰 및 실습

- DECISION-BASED ADVERSARIAL ATTACKS: RELIABLE ATTACKS AGAINST BLACK-BOX MACHINE LEARNING MODELS, ICLR, 2018

이 논문은 black-box attack에 관하여 다룬 논문입니다.

Abastract

많은 machine learning algorithms들이 Inputs에 대한 perturbations에 매우 취약하다는 사실이 알려저 있습니다. 기존의 많은 방법들은 detail한 model information(graident based attacks)이나, class-probabilites 같은 Confidence score(score-based attack)에 의존하고 있는 방식이었습니다. 하지만 이 논문에서는 final model decision의 중요성을 강조하면서, decision-based attack을 소개합니다.

Decision-based attack은 또한 real-world에 적용 가능하며, 사전지식을 적게 알아도 되며, transfer-based attacks보다 적용하기도 쉽고, simple defences에 대해서도 robust하다고 합니다.

그래서 필자들은 Boundary Attack방법을 소개하고 있는데, 이는 large adversarial perturbation부터 시작해서 adversarial한 상태를 유지한채로, perturbation을 줄인다고 합니다. 이 공격방법은 simple하고, hyperparameter tuning을 거의 해줄 필요가 없으며, substitute model에 의존적이지도 않으며, 좋은 성능을 보여준다고 합니다.

1. Introduction

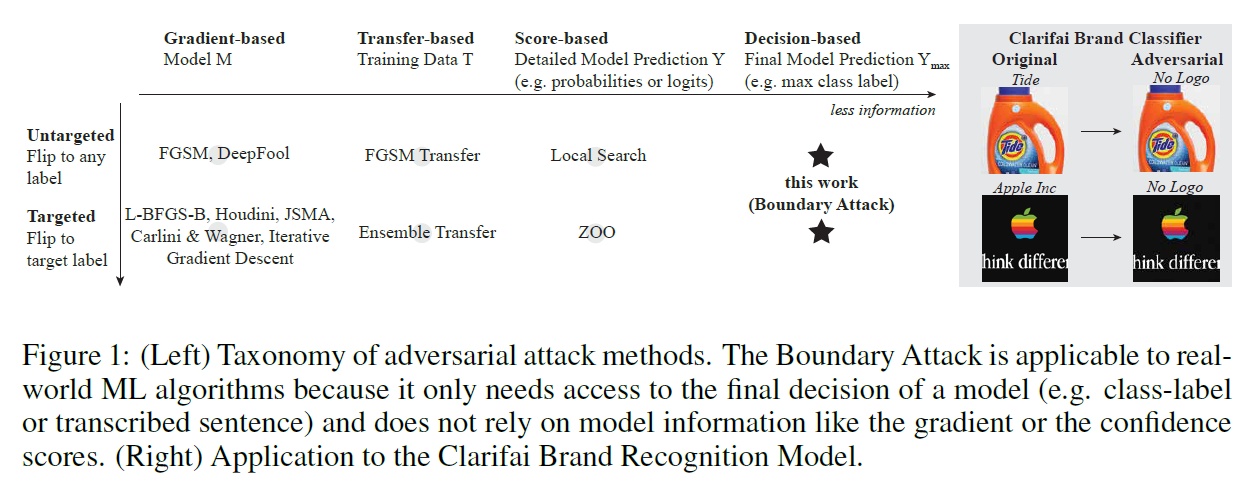

먼저 기존의 adversarial attacks 방법들을 3가지로 나누고 있습니다.

- Gradient-based : FGSM, BIM, DeepFool, JSMA, Carlini & Wagner 등의 방법이 있습니다

- Score-based : 몇개의 방법은 agnositc하며, predicted scores(e.g class probabilites or logits)에만 의존한다고 합니다.

- Transfer-based : 모델에 관한 정보는 필요없으나, training data에 관한 정보는 필요한 방식입니다. Substitute model에 대해 얻은 perturbations을 model간의 transferability를 이용하여 공격하는 방법입니다.

위와 같이 기존의 3가지 방법이 있었다면, 이 논문에서는 Decision-based attacks을 주목합니다. 이 공격방법은 model의 final decision에 대해 direct한 attack을 가합니다. 이러한 방법의 장점으로는, gradient나 logits, scores에 비해 real-world에 더 잘 적용가능하며, standard한 defences에 대해 robust하며, 사전 지식을 적게 알아도 된다는 점이 있다고 합니다.

이 논문의 contributions은 다음과 같다고 합니다

- real-world applications에 relevant한 공격 방법의 소개

- 복잡한 모델과 natural datasets에 대해 효과적인 공격 수행이 가능한 방법의 소개(simple, flexible, litte-hyperparameter tuning, competitive with best gradient-based attacks)

- 기존의 defence-mechanisms이 통하지 않는 방법

- Boundary Attack의 practical applicability를 보여줌

2. Boundary Attack

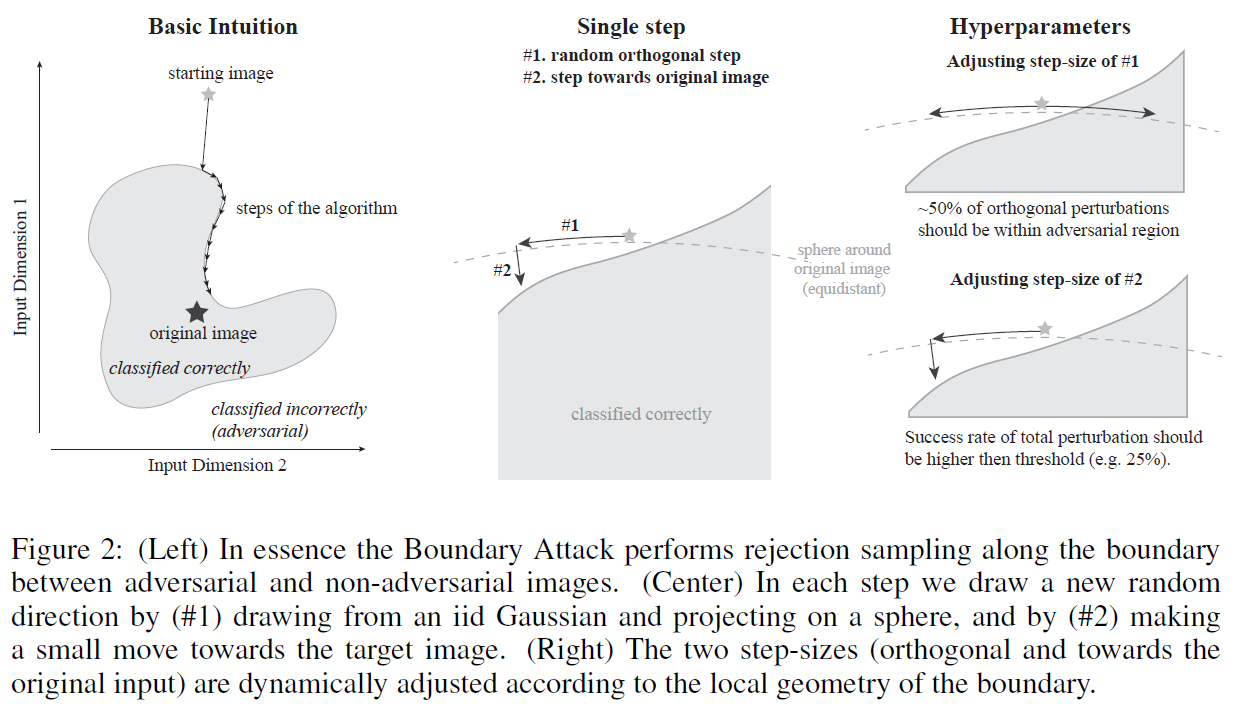

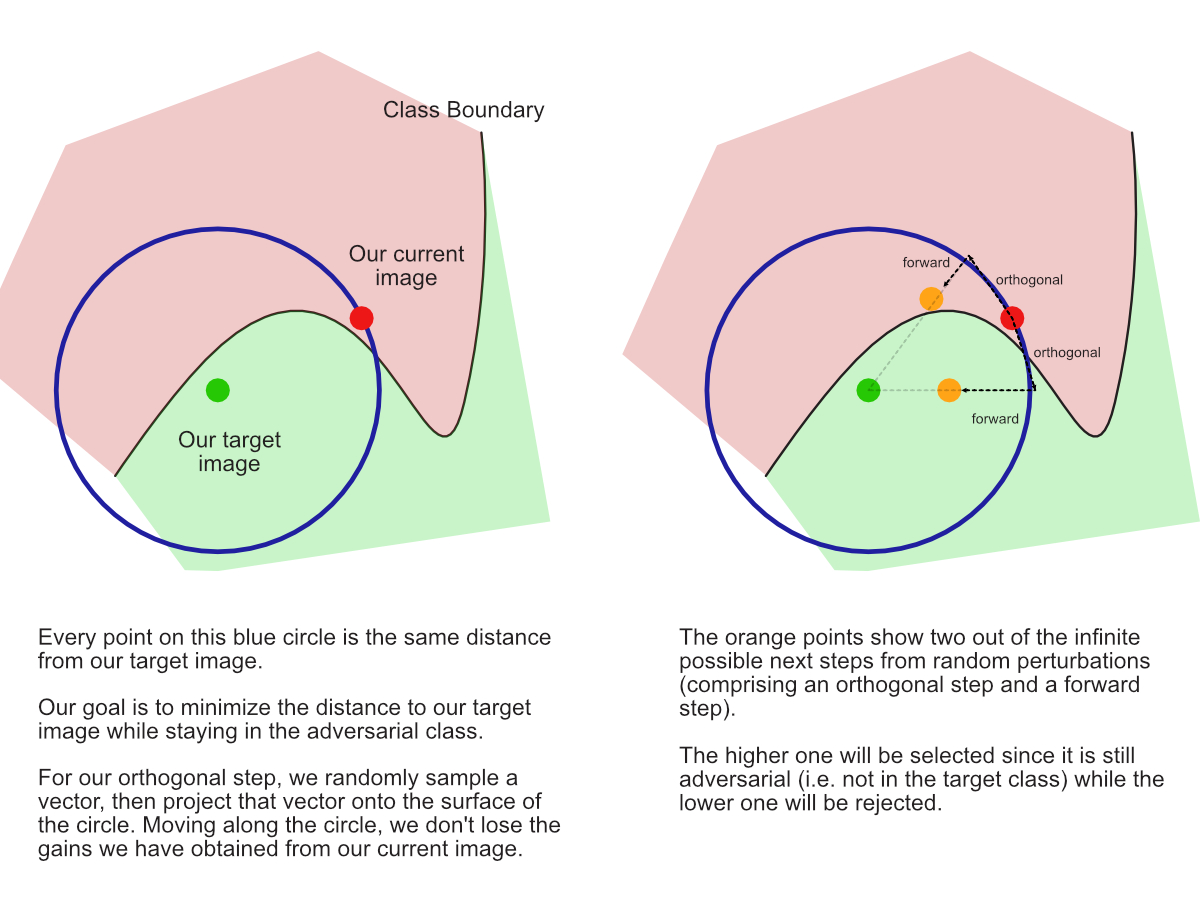

Basic한 원리는 아래의 그림과 같습니다.

먼저 adversarial한 상태의 point부터 시작하여서, boundary를 따라 진행하면서, adversarial한 영역 중 original image와의 거리가 최소인 점을 찾는 것이라 요약할 수 있습니다. 아래 그림의 single step을 살펴보면 random한 orthogonal한 방향으로 이동한 다음에, original image방향으로 파고드는 것이라 이해하면 될 것 같습니다.

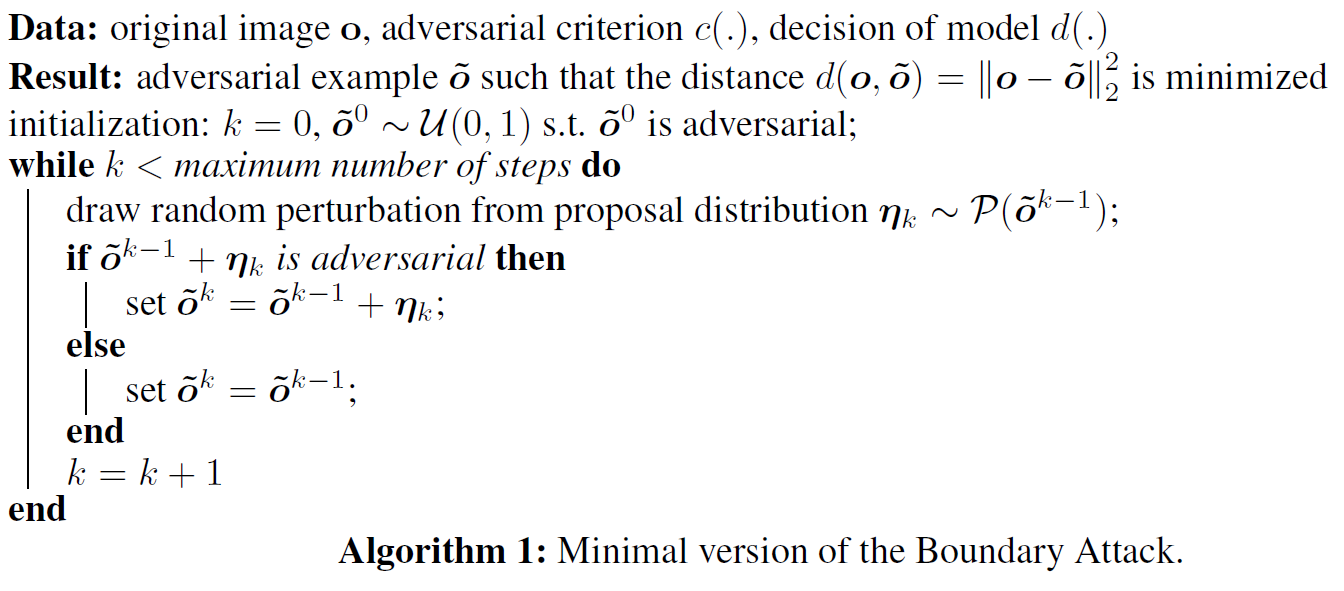

- ~o refers to the adversarially perturbed image

- ~o(k) refersto the perturbed image at the k-th step of an attack algorithm.

- y max is the predicted label

아래는 위의 내용에 대한 추가 설명입니다.

2.1 Initialisation

Boundary Attack은 이미 adversarial한 sample로 initialize됩니다. Untargetted의 경우, maximum entropy distribution에서 샘플링한다고 합니다. CV의 경우, [0, 255]사이의 uniform distribution U(0, 255) 에서 adversarial 하지 않은 것을 제외하여 샘플링 한다고 합니다.

Targeted의 경우에는 model에 의해 target class 영역에서 초기점을 샘플링 하면 된다고 합니다.

2.2 PROPOSAL DISTRIBUTION

proposal distribution P에 따라 효율성이 결정된다고 합니다. 필자들은 2d 가우시안 분포라는 매우 simple한 proposal distribution을 적용 해보았는데, 놀랍게도 잘 된다고 합니다. k-th step에서, maximum entropy distribution로부터 perturbation(η(k))을 얻기 위해서는 아래와 같은 3가지 constraints가 있다고 합니다

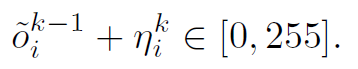

1) perturbated sample은 input domain에 속해야 한다

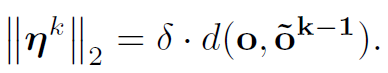

2) perturbation은 δ라는 relative size를 가지고 있다

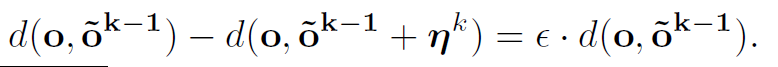

3) perturbation은 perturbated image와 original image간 의 거리를 줄여야 하며, ε에 의해 크기가 결정된다

위를 만족하는 distribution을 찾기 위해서, 먼저 2차원 가우시안 분포 Ν(0, 1)에서 sampling하고, 위의 1), 2)식을 만족하도록 rescale과 clip을 한다고 합니다.

그 다음과정으로는, η(k) original image o 주변의 구에 project시켜, 1)식을 만족하게 합니다. 이 과정은 orthogonal perturbation라 하며, hyperparmeter tuning에도 사용한다고 합니다.

마지막 단계로는 original image방향으로 1),3)을 만족하는 small movement를 주는 과정입니다.

2.3 ADVERSARIAL CRITERION

이 섹션에서는 Boundary Attack은 다양한 adversarial criterion에 대해서 flexible하다는 것을 설명하고 있습니다.