[2022 공간빅데이터 경진대회] 7. 지원서 작성, 접수 완료

분석 완료 후

- 제출 당일 저녁이 되서야 작업을 완료했다.

- 시간이 많지 않아 서둘러 지원서를 작성했다.

참가 기본정보

참가 과제정보

- 참가분야 : 분석사례

- 참가주제 : 주택문제해결·주거복지지원 등

- 제목 : 반지하 주택 침수 위험지역 분석

과제 개요

- 활용이 예상되는 분야 : 각 지자체 주택안전 및 건축물관리 지원

- 제안 사유 :

- 올해 8월 폭우로 인해 발생한 반지하 주택 인명사고와 같은 침수 피해를 예방하고자 함(매년 여름에 찾아오는 태풍과 폭우로 인한 재해 대비)

- 재건축을 통한 반지하 주택 감소는 비용과 시간이 많이 들기 때문에, 현황을 파악하고 위험 지역을 집중 관리하여 피해 예방

- 서울 내 반지하 주택은 무려 225,639채 (건축물대장 2022년 7월 기준)

- 아이디어의 차별성/창의성 :

- 침수위험지역을 반지하 주택과 연결지어 분석한 사례가 부족함

- 침수위험지역과 반지하 주택의 공간적 분포를 함께 분석함으로써 실질적으로 피해를 예방할 수 있는 방안을 제안

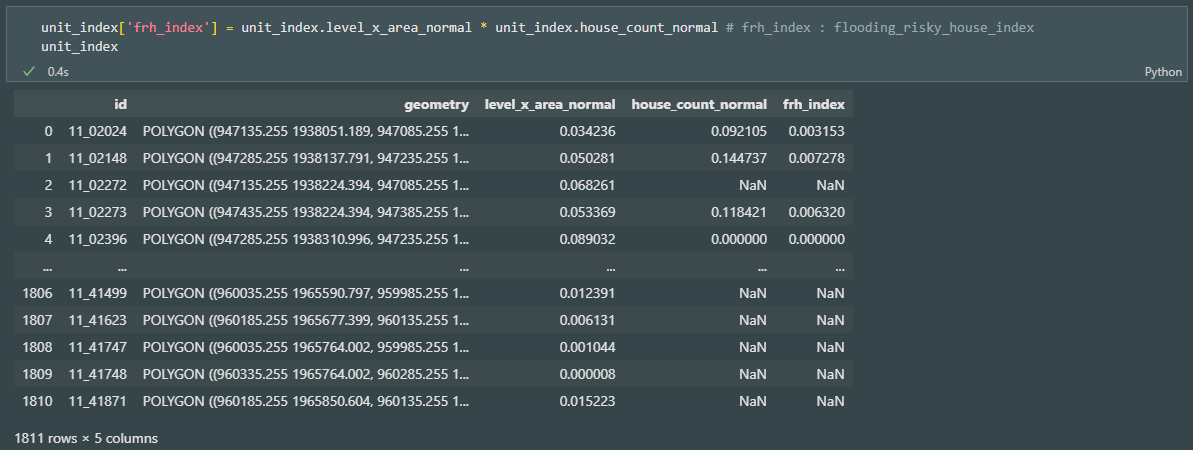

- 침수 위험 주택 지표를 제안하여, 침수 위험과 중요도를 한 번에 볼 있음

- 침수위험지역의 면적과 위험도, 그리고 반지하 주택의 개수를 활용

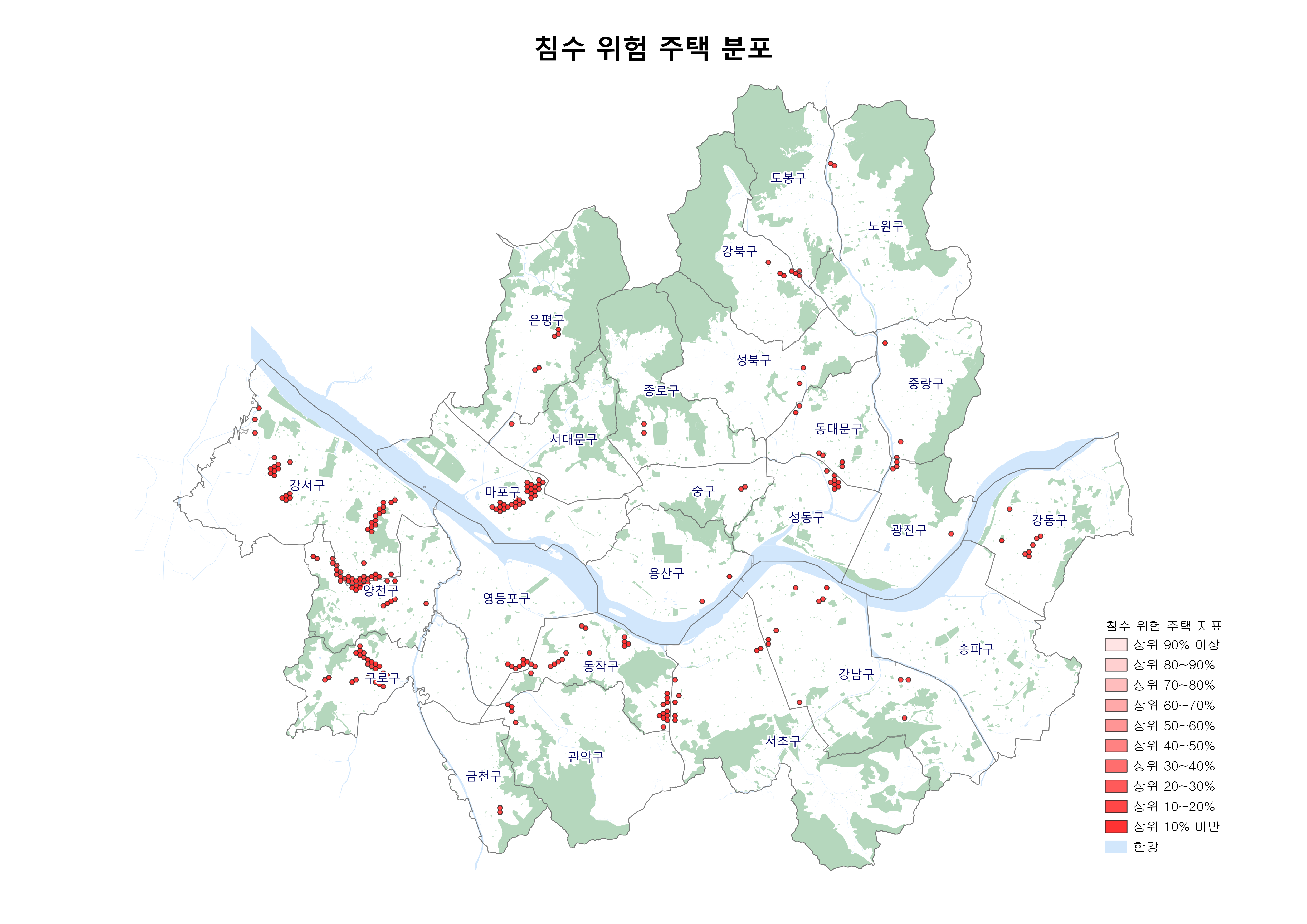

- [반지하 주택 침수 위험도] = ∑([침수예상구역 level] x [침수예상구역 면적]) x [반지하 주택 개수]

활용 데이터

- 침수예상도

- 건축물대장 표제부

- 건축물대장 층별개요

- 연속지적도형정보

분석 프로세스

- 반지하 주택 데이터 추출

1-1. 건축물대장을 활용하여 지하층을 주거용도로 사용중인 주택 데이터 추출(아파트 제외)

1-2. 추출된 반지하 주택 데이터의 주소와 연속지적도형정보 데이터의 주소를 결합(Table Join)하여 반지하 주택을 공간 데이터화

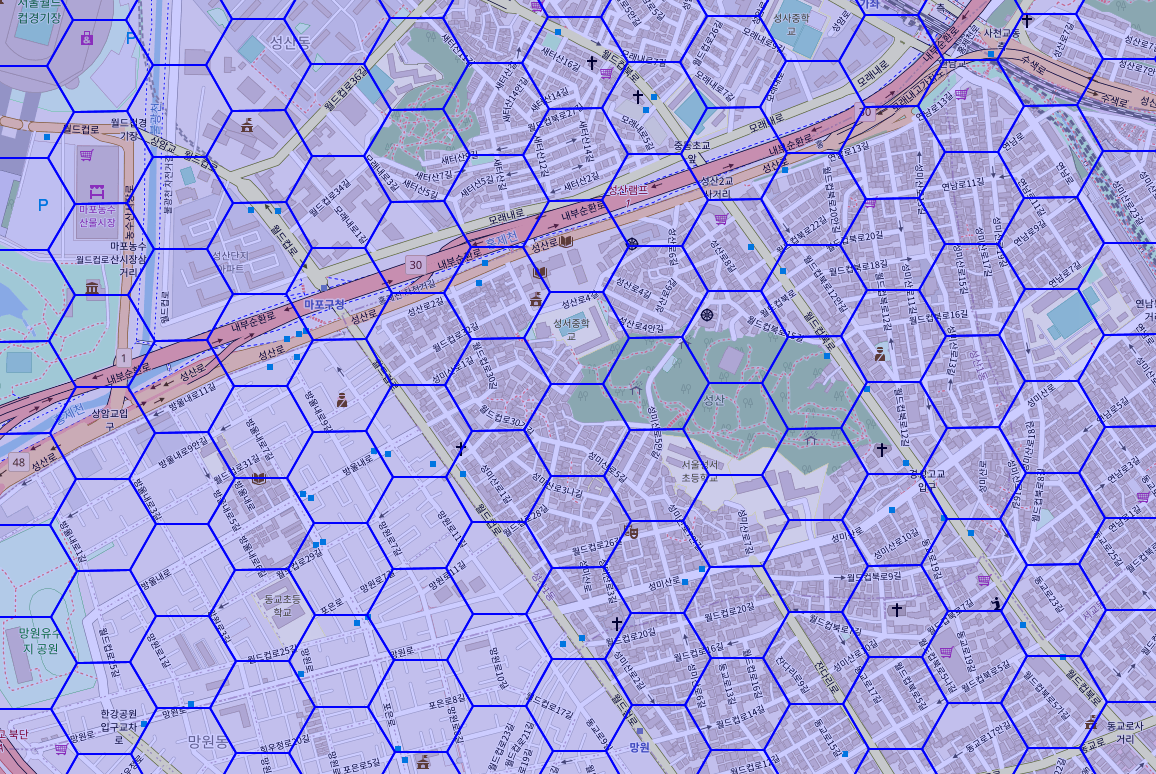

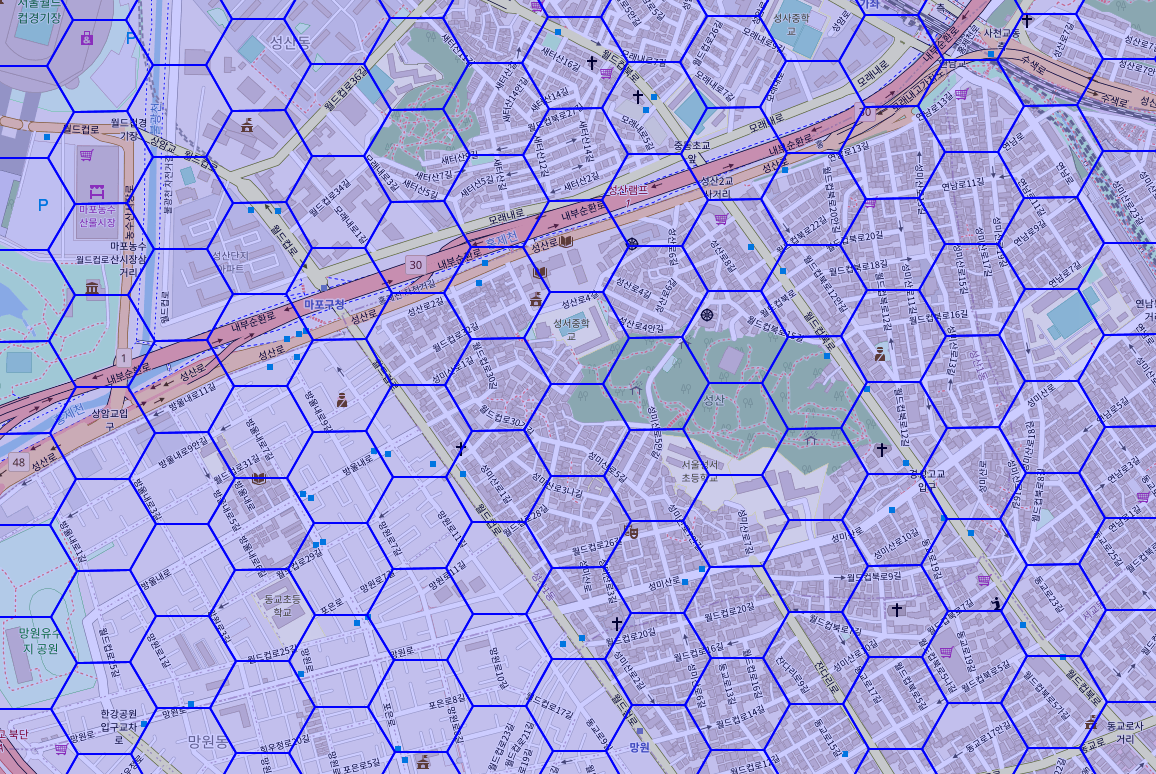

- 분석 Unit으로 사용할 정육각형(Hexagon) 폴리곤 생성

2-1. 한 변이 100m인 정육각형 폴리곤을 서울 전역에 생성

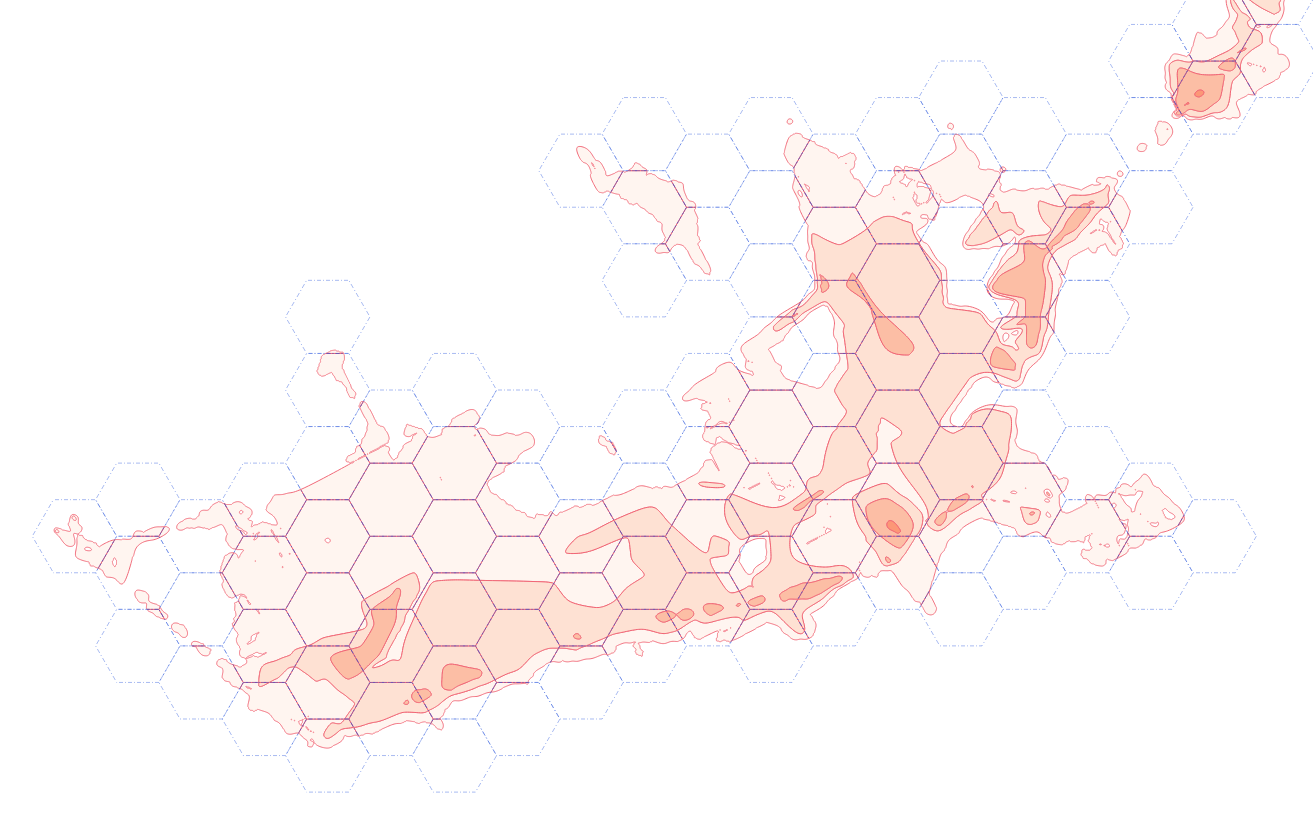

- 침수위험지역 데이터와 반지하 주택 데이터를 분석 Unit에 따라 재산출

3-1. 분석 Unit과 침수위험지역의 중첩 면적(Area), 각 지역의 위험도(Level) 산출

3-2. 분석 Unit 내 반지하 주택 개수를 산출

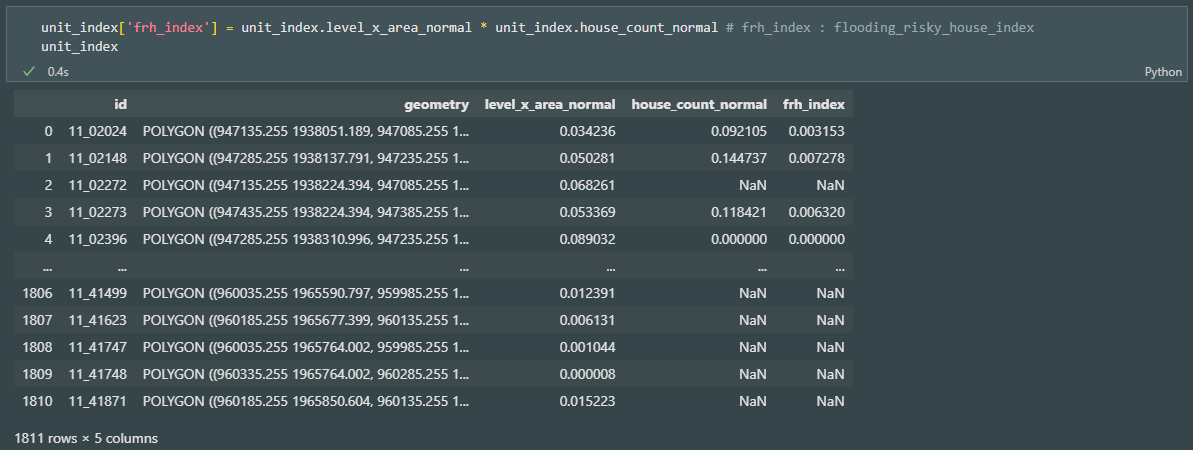

- 침수 위험 주택 지표 산출

4-1. 각 변수를 정규화(Normalization)하여 변수 간 범위와 분포의 차이를 보정함

4-2. 지표 산출식에 따라 지표 산출

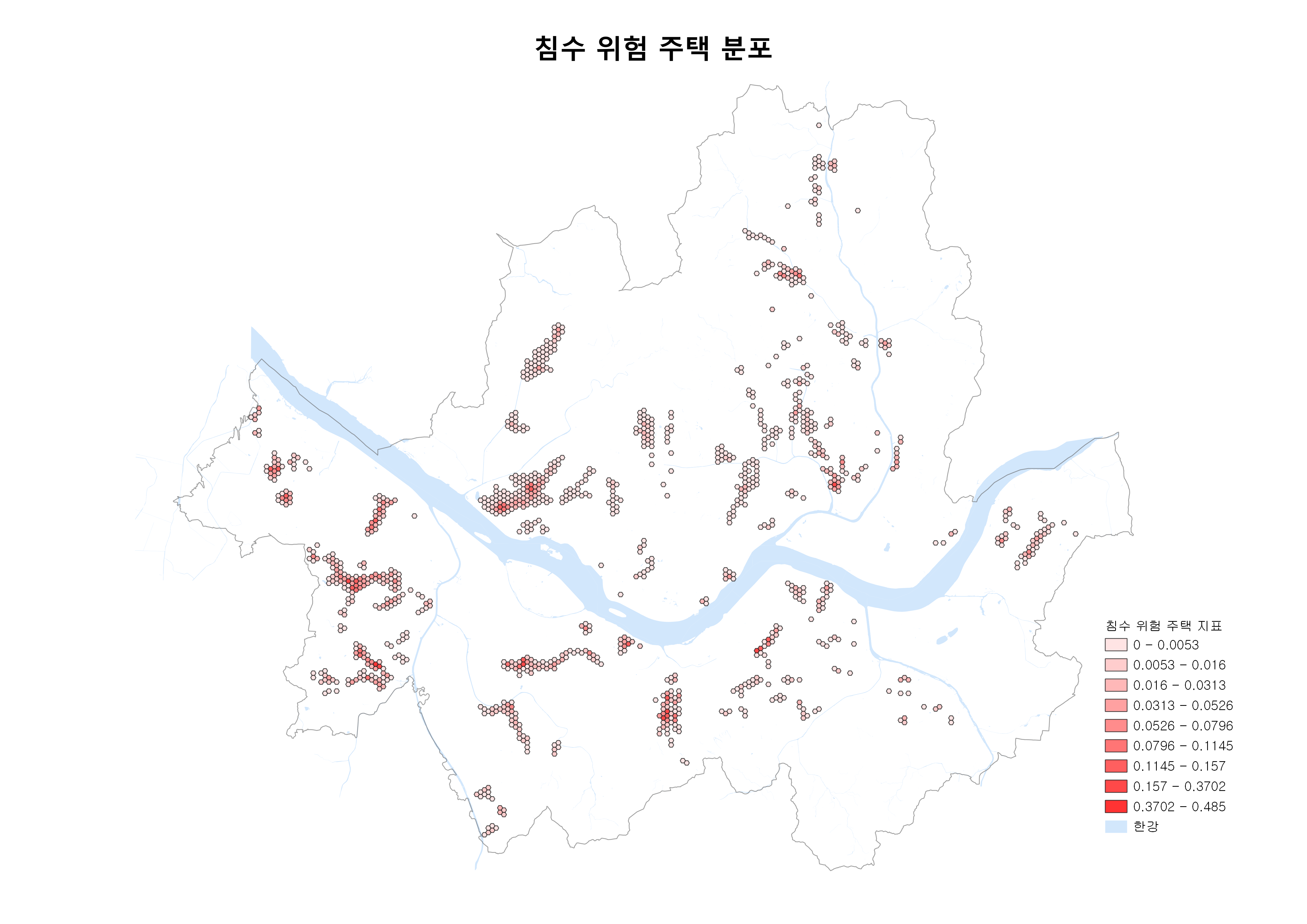

- 분석 Unit과 지표를 시각화

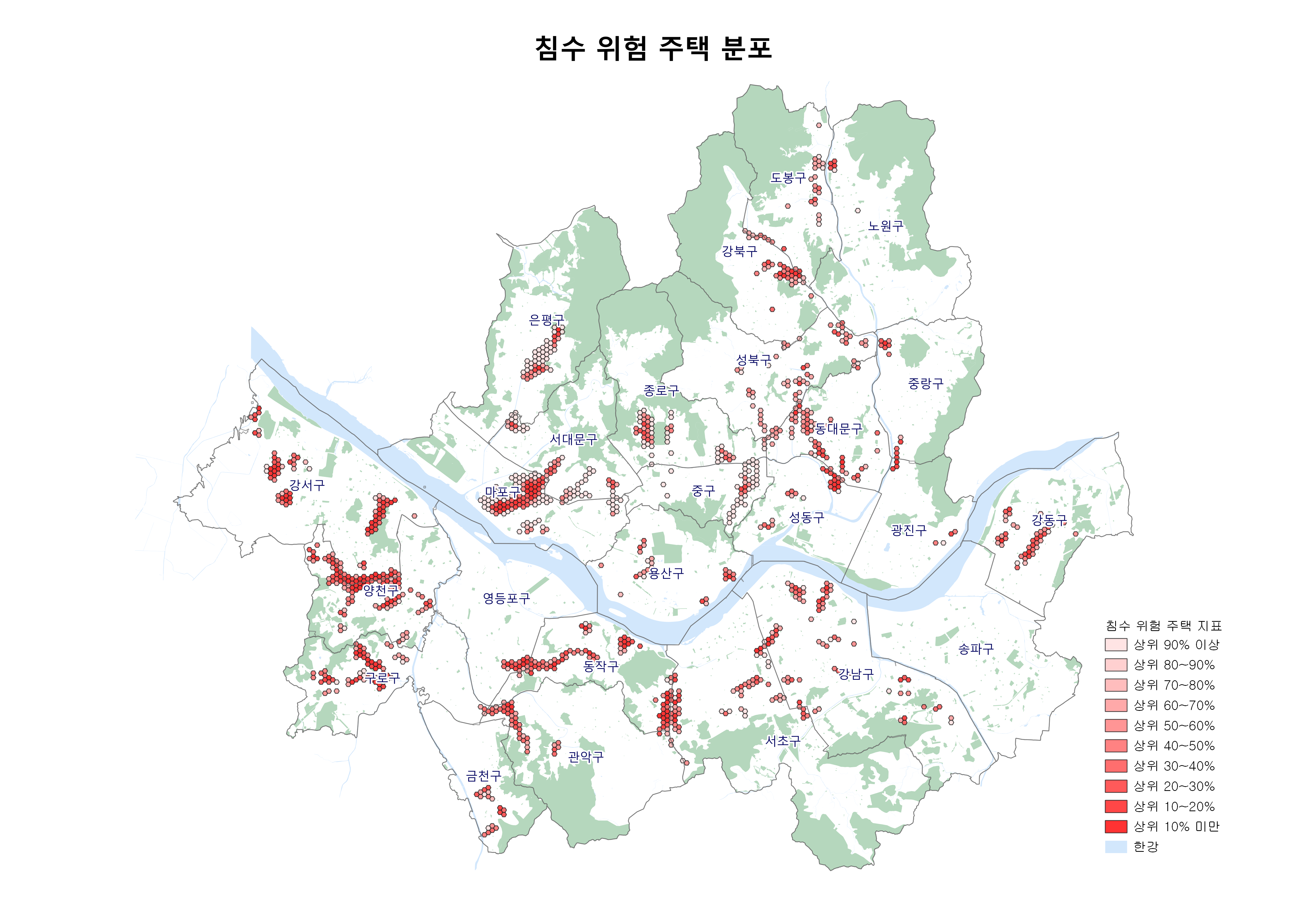

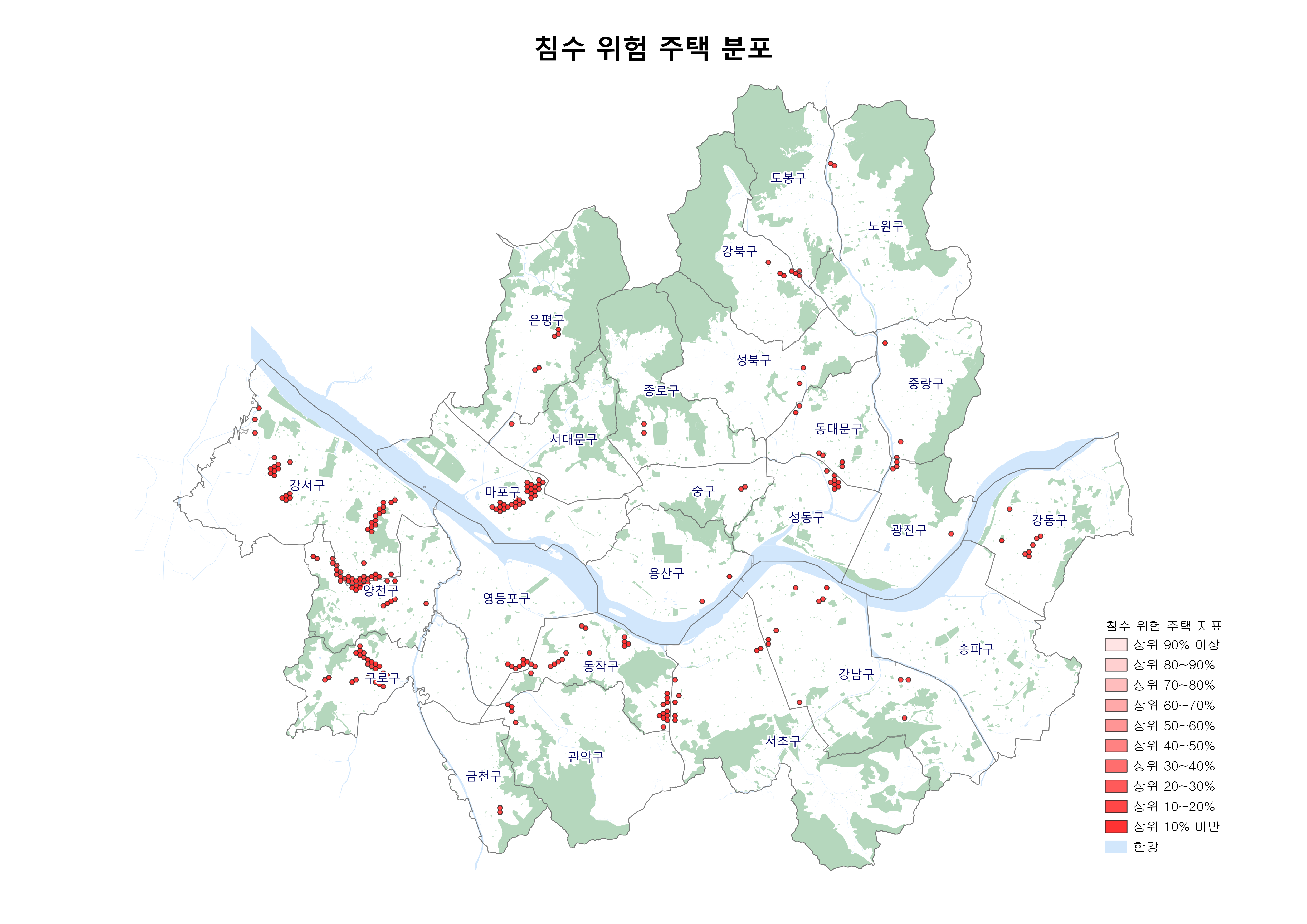

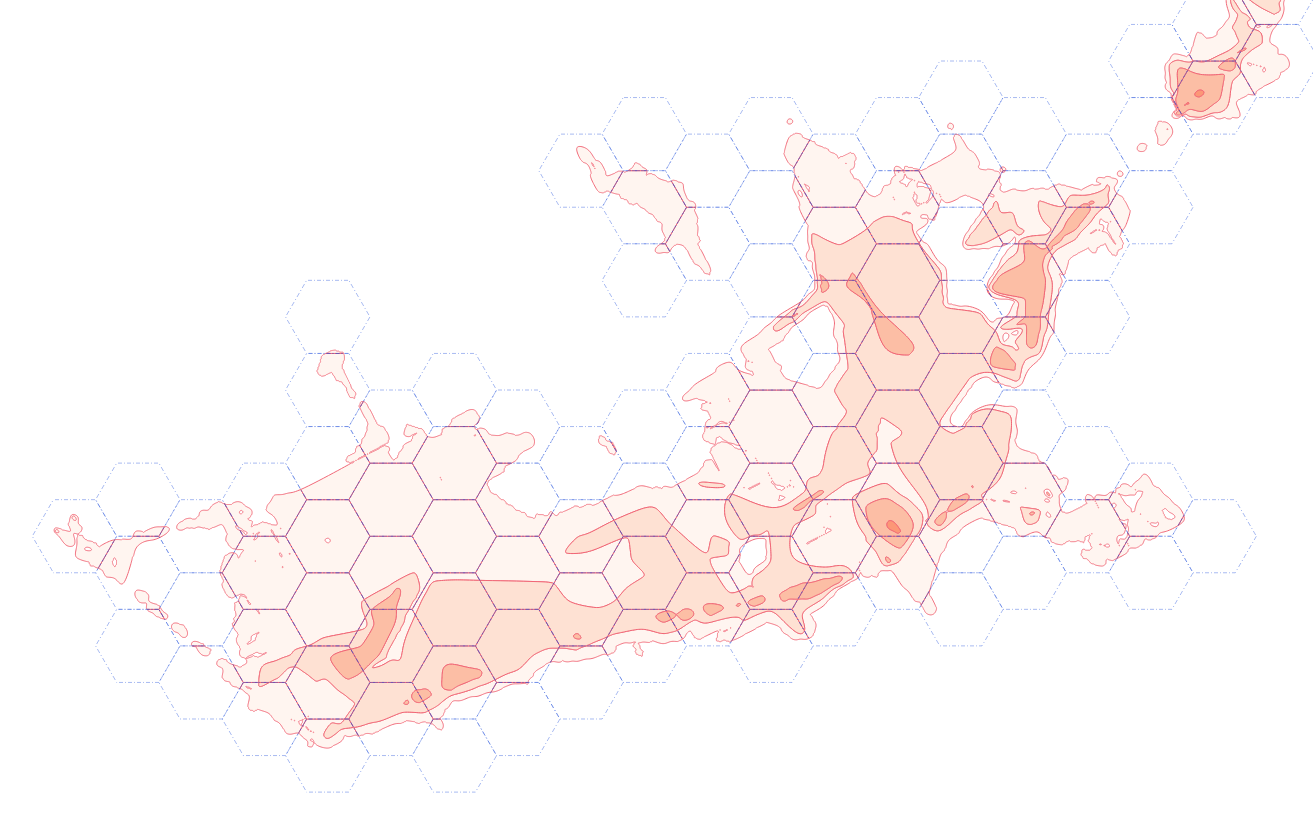

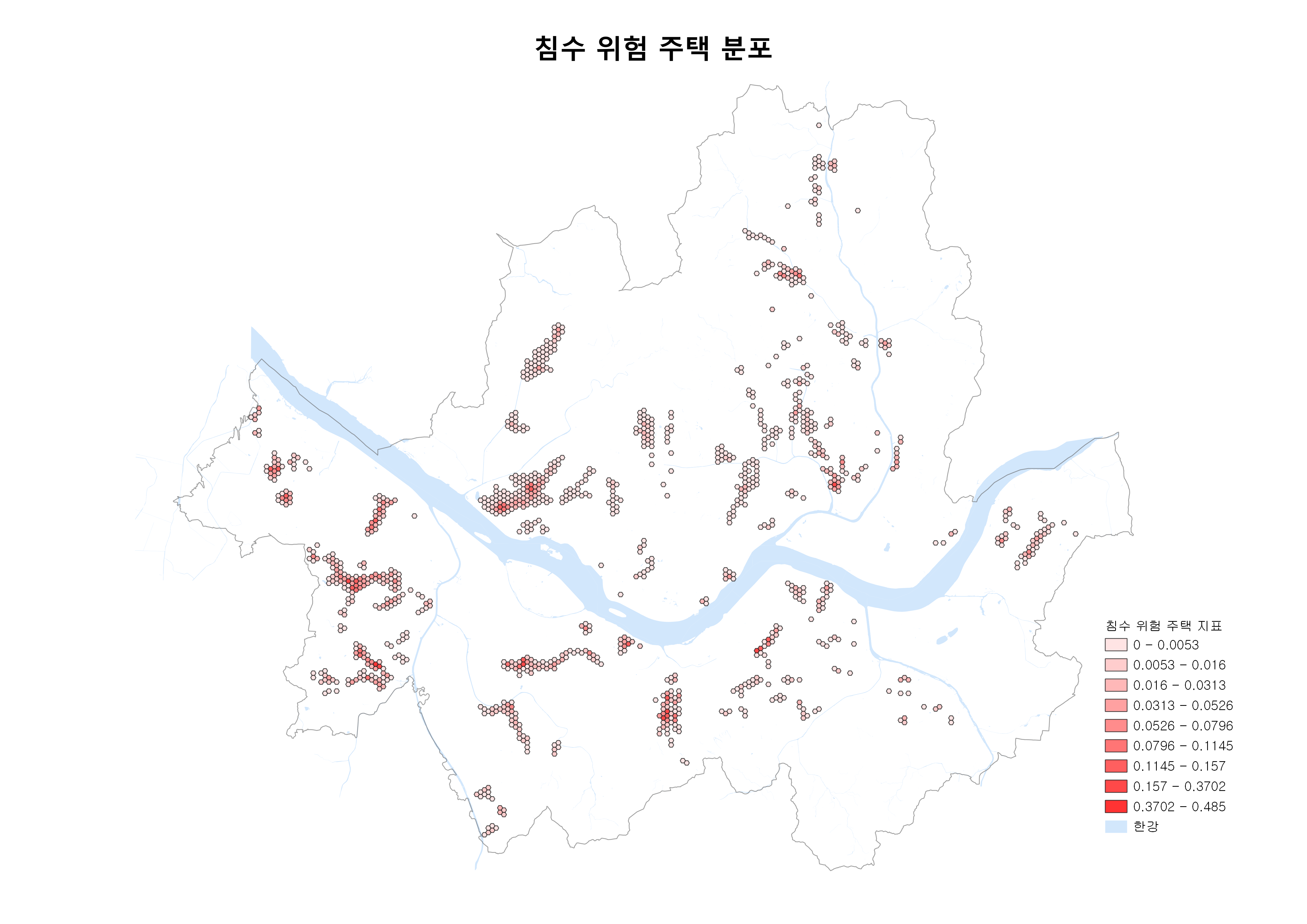

분석 결과

- 침수위험지역과 반지하 주택이 함께 존재하는 지역에서만 데이터 생성(1,167개)

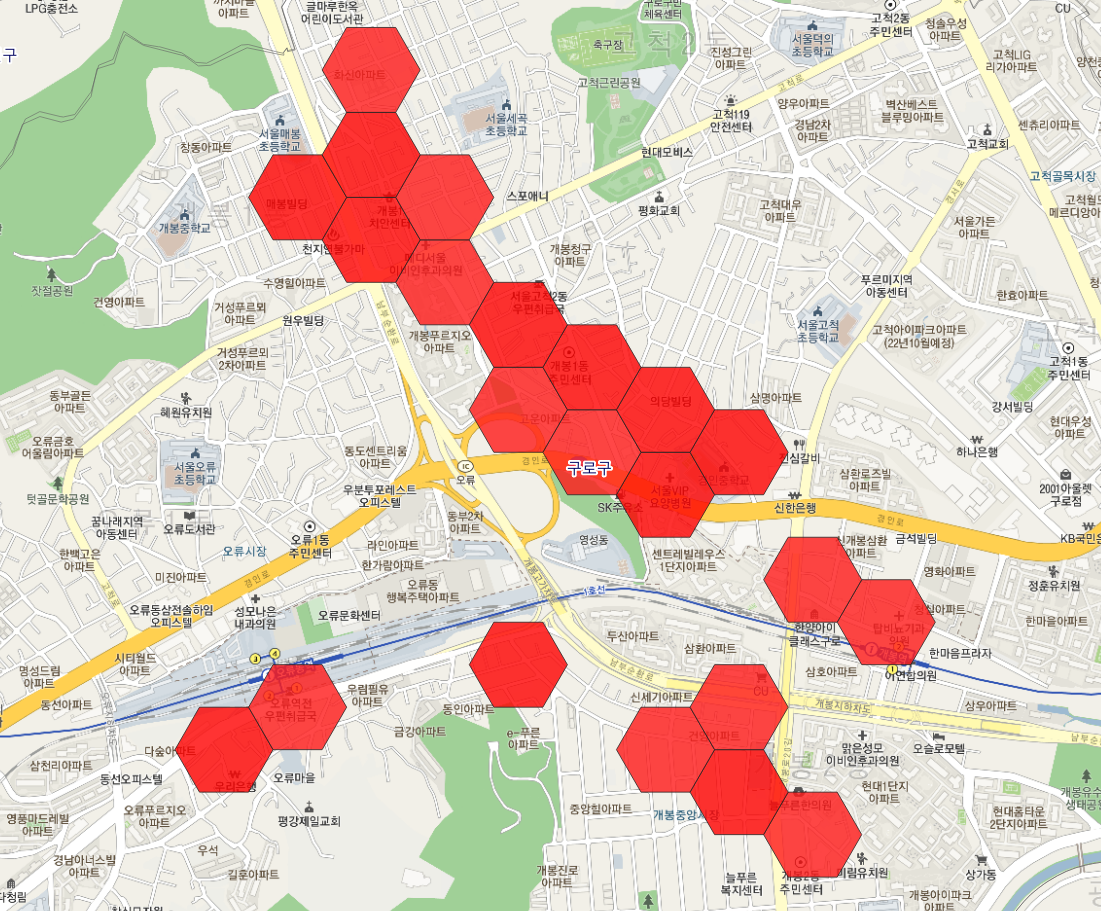

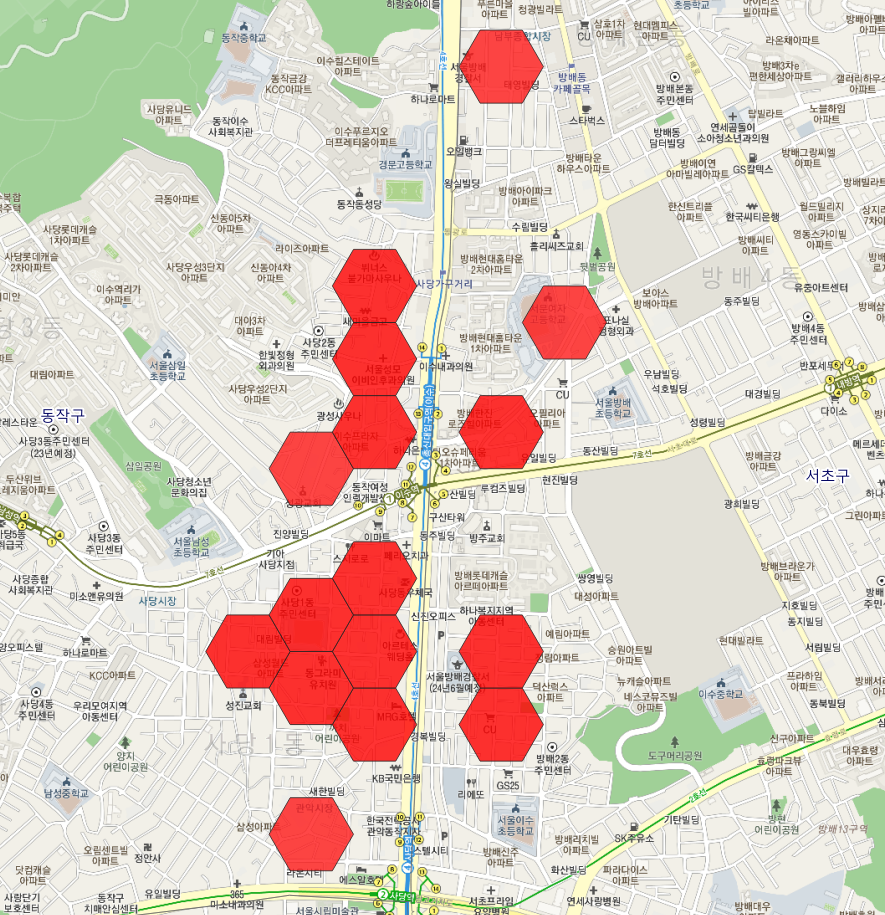

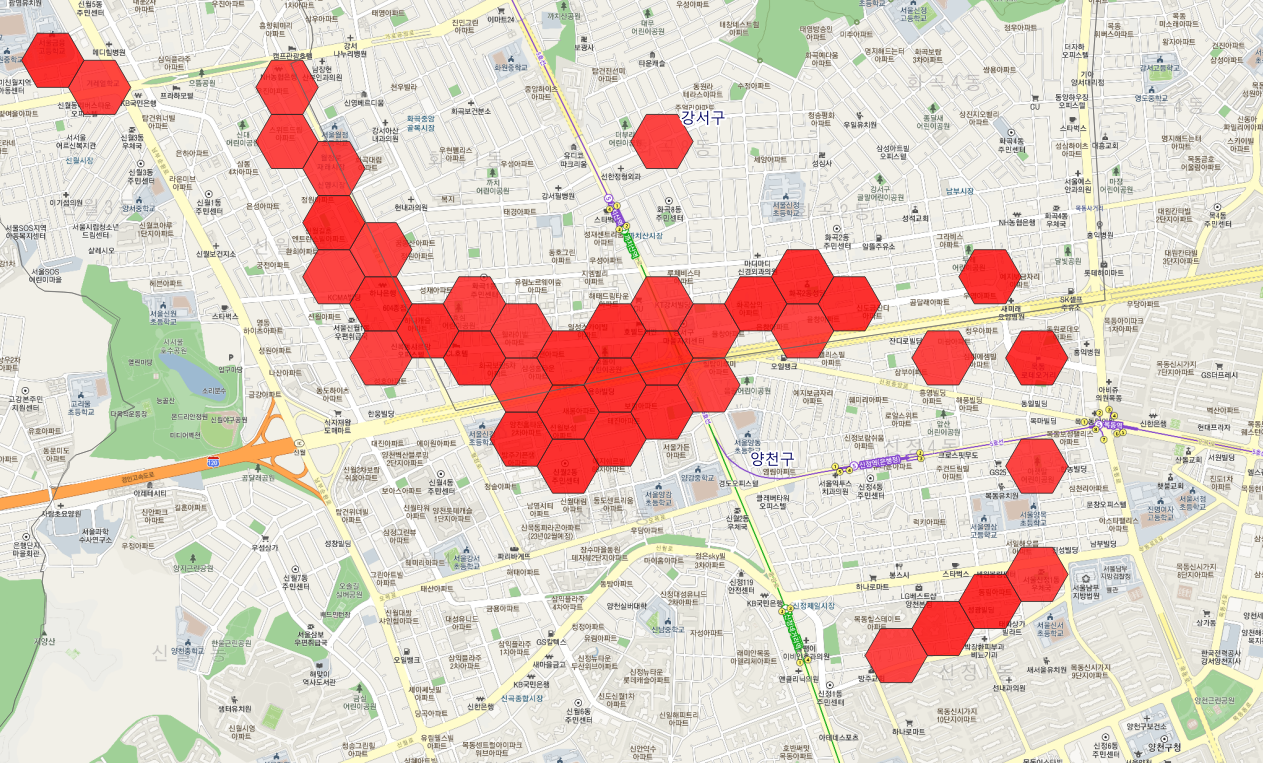

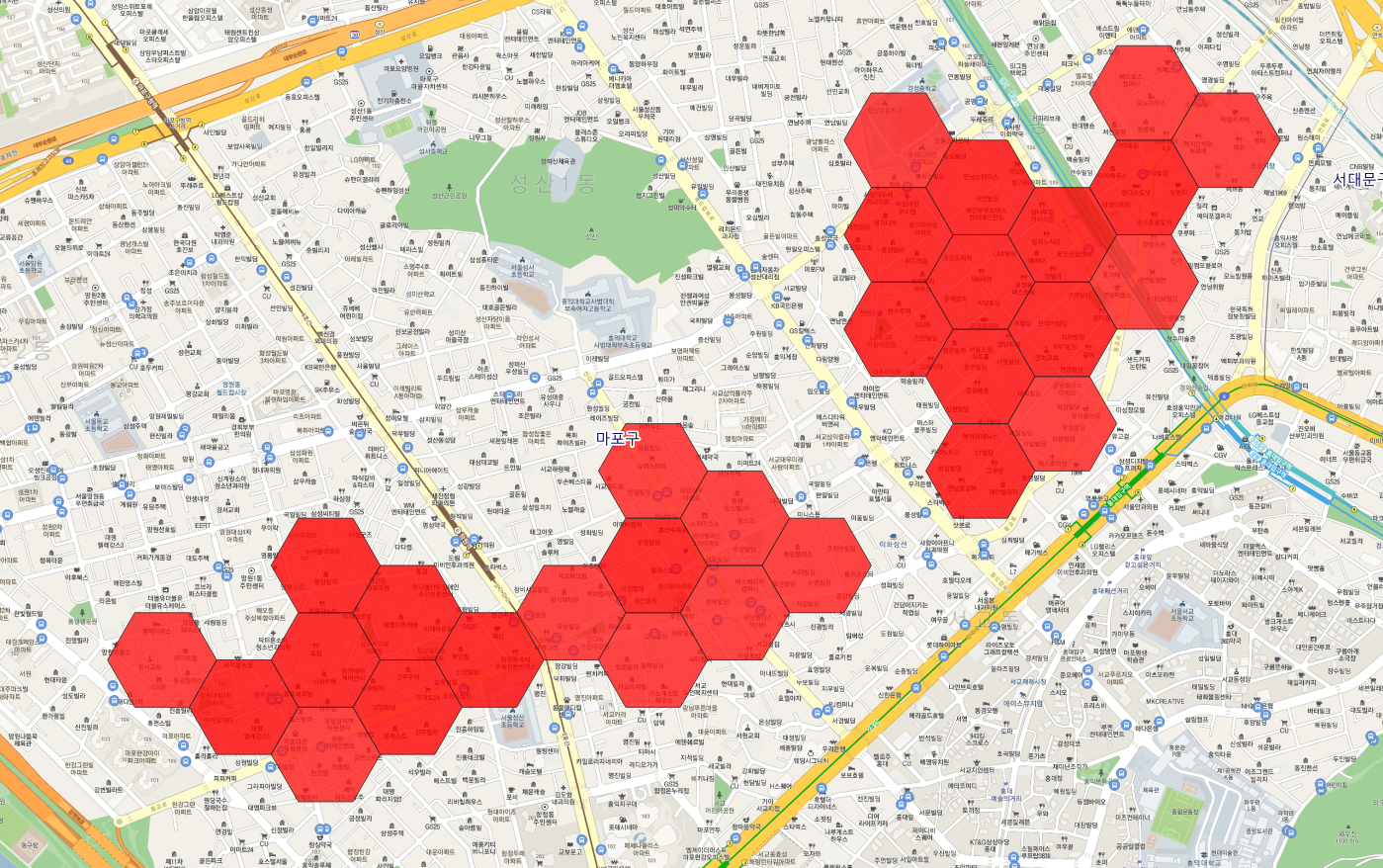

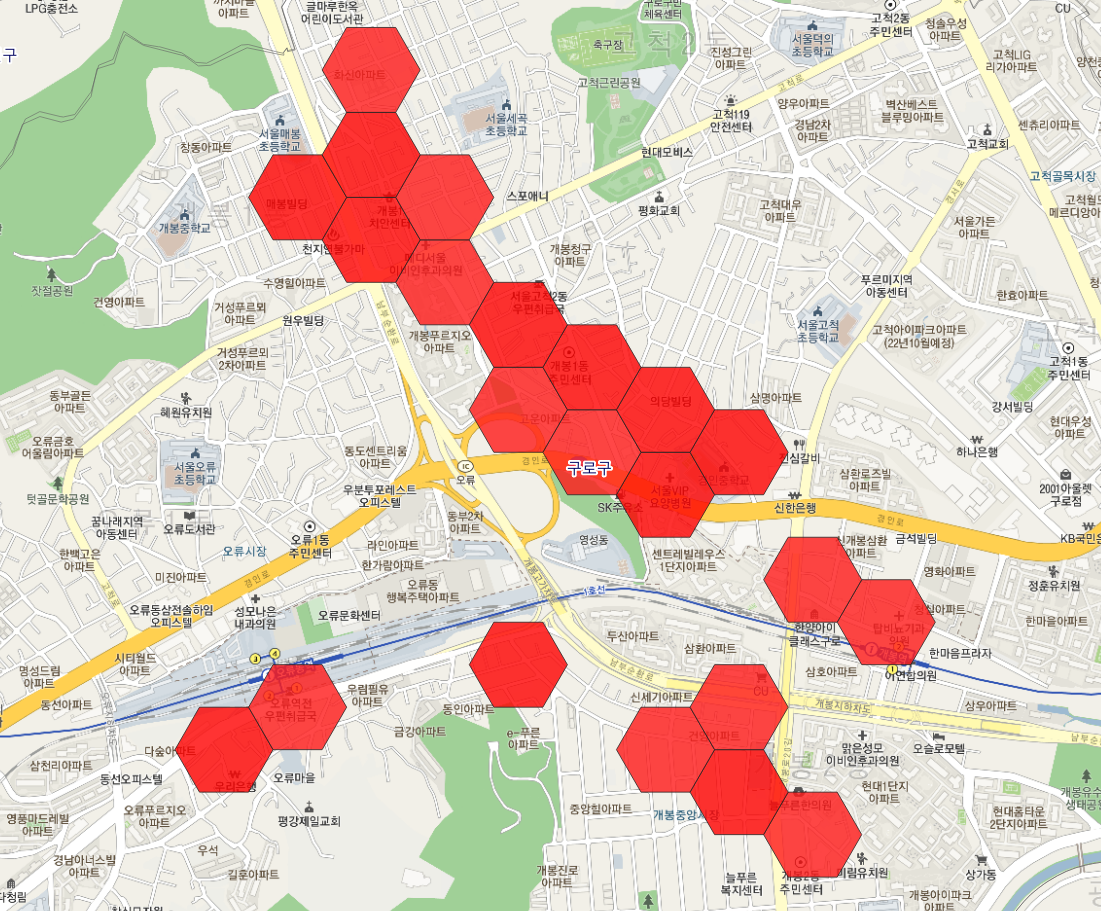

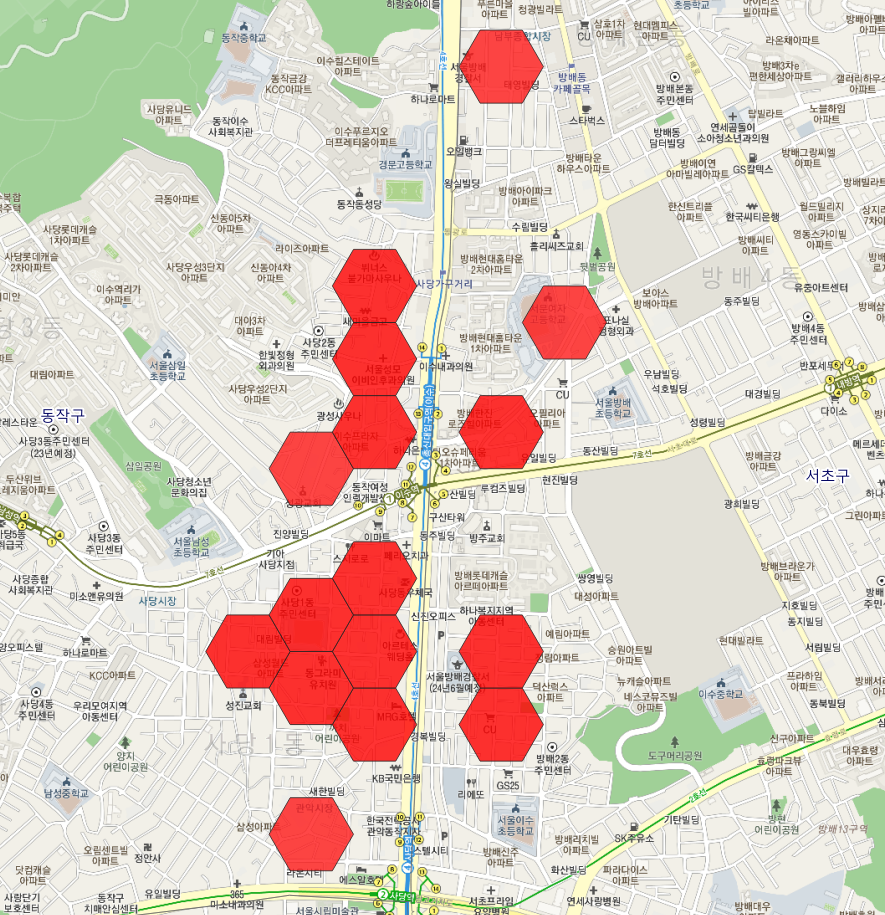

- 마포구, 양천구, 동작구, 구로구

- 시각화 범례, 붉은색 > 분홍색 > 살구색 순으로 위험도가 높은 지역

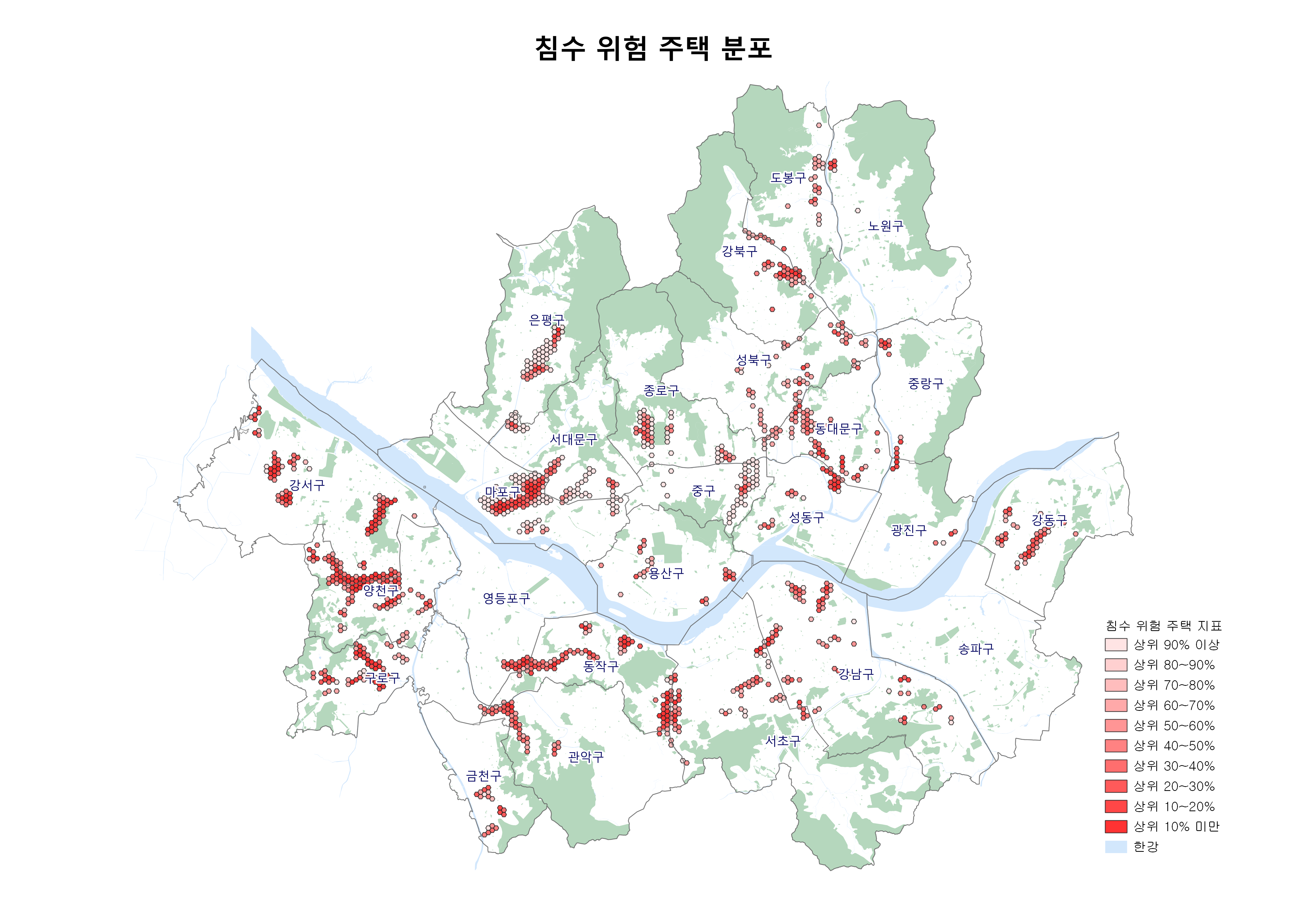

- 단, 위험도 상위 20%(또는 상위 50%) 지역만 추출해보면,

마포구, 양천구, 강서구, 구로구가 높은 위험지역임을 알 수 있음

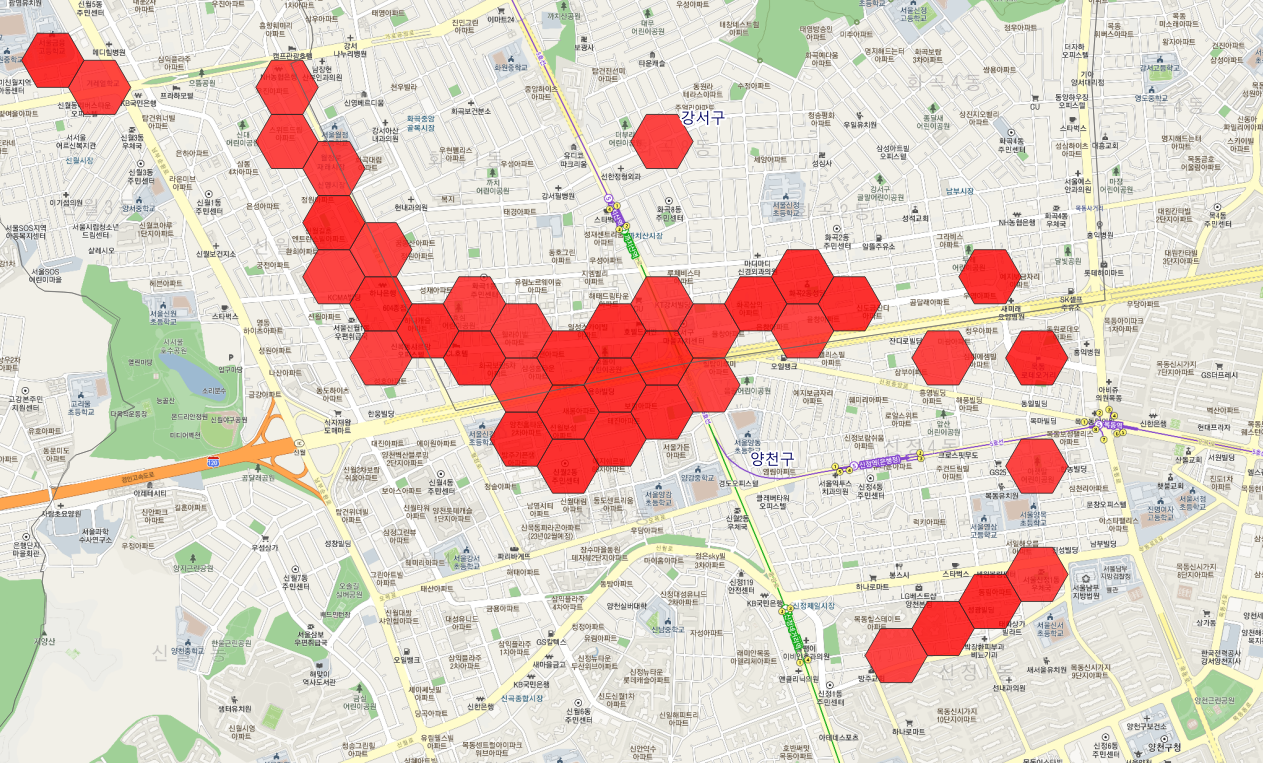

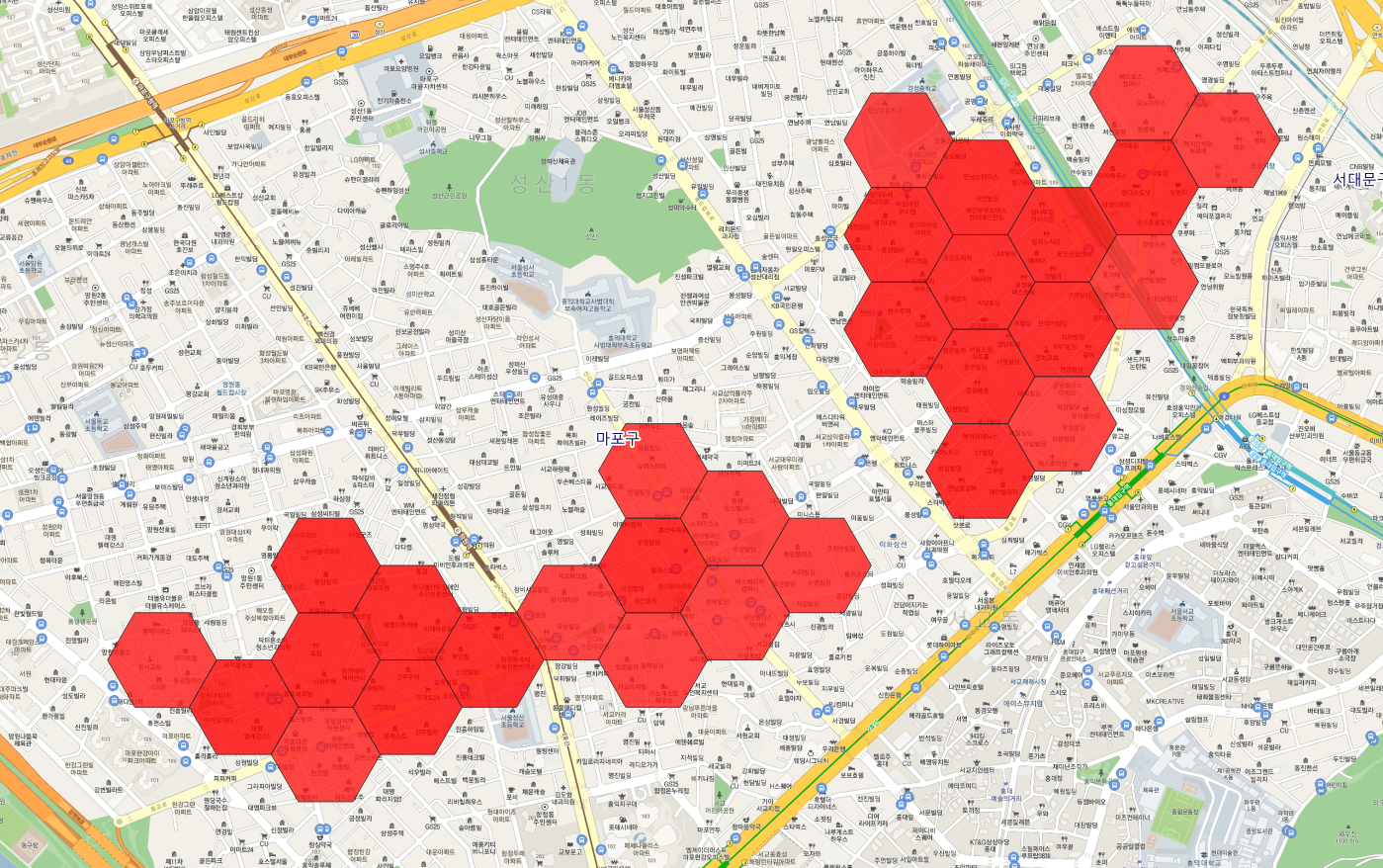

- 침수위험지역을 확대하여 지도서비스(카카오맵)와 함께 살펴보면,

구체적인 관리지역을 식별할 수 있음

- 양천구 화곡고가 사거리 일대

- 마포구 홍대입구역-망원역 일대

- 구로구 오류동역-개봉역 일대

- 동작구 이수역 일대

기대 효과

- 수혜자 범위

- 지자체 : 반지하 주택의 침수피해 예방을 위한 참고자료

- 거주인구 : 사전 대비를 통한 피해 최소화

- 정량적 기대효과

- 침수로 인한 피해금액 감소 효과() : 위험지역 주택 수 x 침수로 인한 피해금액

- 반지하 주택 관리 효율 증대(%) :

((반지하 주택 총 개수 - 위험 반지하 주택 개수)/ 반지하 주택 총 개수) 만큼의 관리 효율 증대

- 정성적 기대효과

- 침수피해에 대한 불안감 감소 : 매년 발생하는 태풍과 폭우로부터 거주안정 확보

대회 접수