📌 Validation (검증)

검증은 머신 러닝 모델의 성능을 평가할 수 있는 방법이다. 검증에는 크게 Hold-out Validation, K-Fold Cross Validation, LOOCV (Leave-One-Out Cross Validation)이 있다.

📍 Hold-out Validation

홀드아웃 검증 방식은 지금까지 해왔던 방식과 비슷하다. 즉, 전체 데이터 셋을 training set과 test set으로 일정 비율을 통해 나누어서 진행하는 것이 홀드아웃 검증 방식이다. (참고로 하이퍼파라미터 튜닝이 필요한 경우, 혹은 딥러닝 같은 경우에는 Train set / Validation set / Test set 으로 나누어 사용할 수도 있다.)

우리는 다음과 같이 홀드아웃 검증을 써왔다.

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)홀드아웃 검증 방식은 데이터가 많고 빠르고 간단하게 모델 성능을 평가하고 싶을 때 효과적이다.

하지만 데이터가 부족한 경우, 훈련 데이터와 테스트 데이터의 분할에 따라 결과가 크게 달라질 수 있고, 테스트 데이터는 훈련에 사용되지 않기 때문에 데이터의 활용 측면에서 굉장히 비효율적이다. 그리고 데이터를 한 번만 나누기 때문에 일반화 성능을 제대로 평가하기 어려울 수 있다.

이러한 문제를 해결하기 위해서는 교차 검증 (Cross Validation)을 이용하는 것이 좋다. 교차 검증 중 k-겹 교차 검증에 대해서 먼저 알아보자.

📍 K-Fold Cross Validation

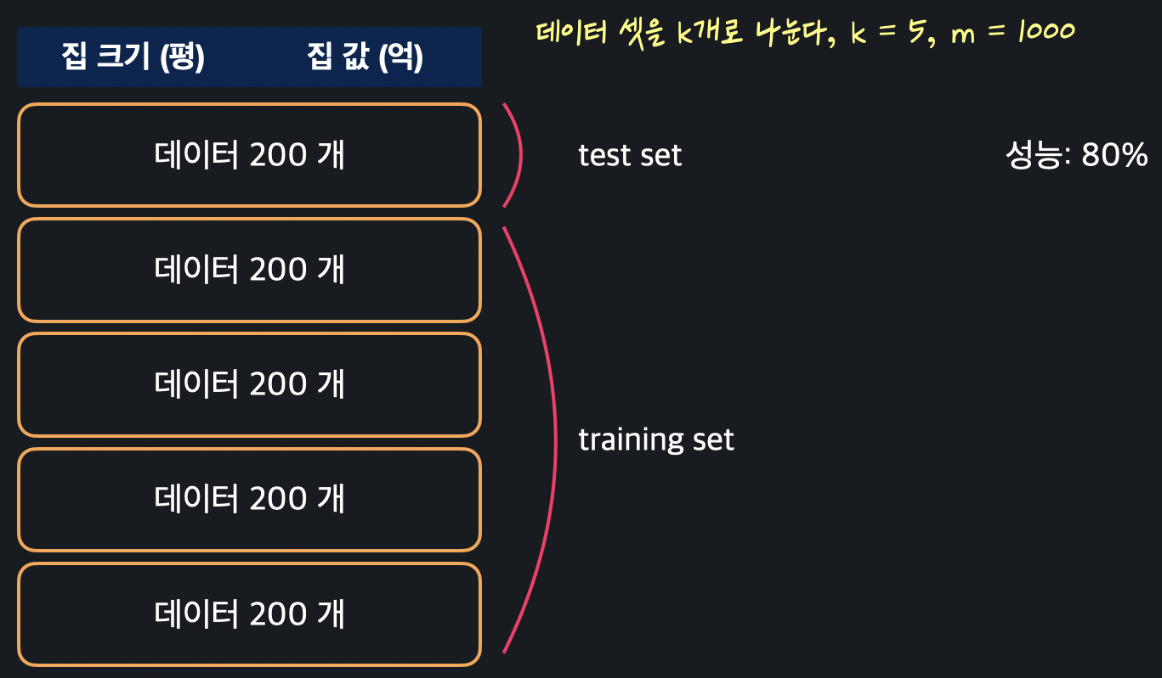

k-겹 교차 검증을 할 때는 먼저 전체 데이터를 k 개의 같은 사이즈로 나눈다. 예를 들어 k=5, 데이터가 총 1000개가 있다면 이 데이터를 200개씩 5개의 셋으로 나누면 된다.

이 데이터 셋들을 이용해서 모델의 성능을 여러 번 검증할 건데, 맨 처음에는 가장 위에/앞에 있는 데이터 셋을 test test으로 사용하고, 나머지를 training set으로 사용한다. 그리고 그렇게 했을 때의 성능을 체크한다.

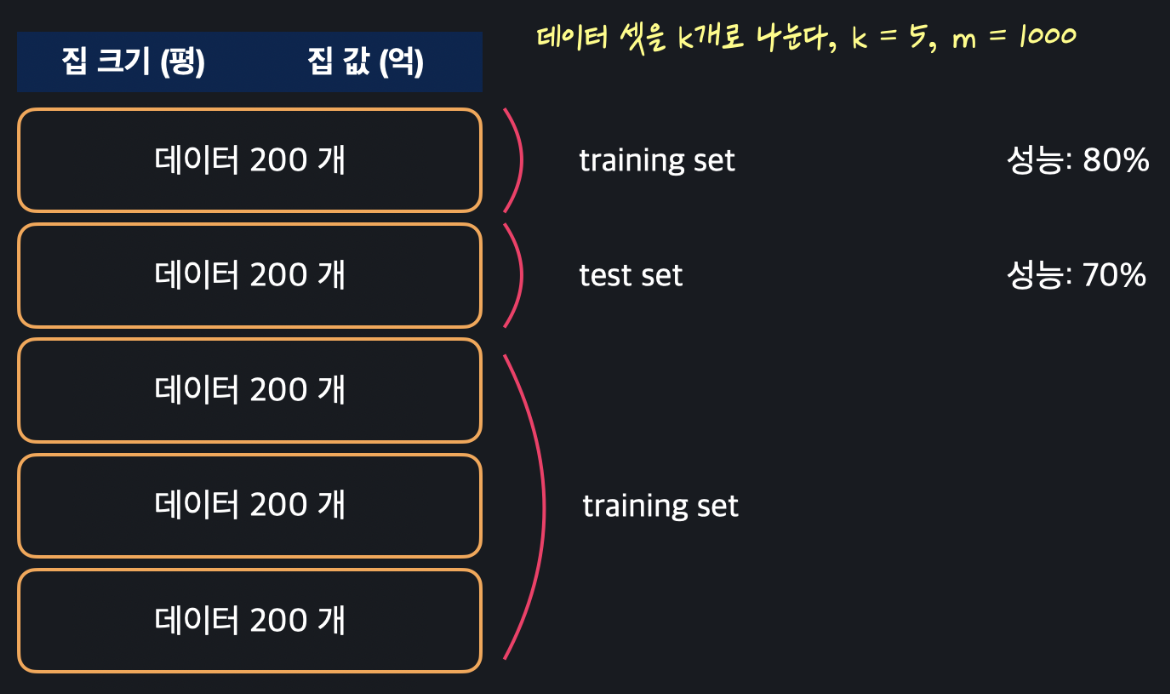

그 다음에는 두 번째 데이터 셋을 test set으로 사용하고, 나머지 4개를 training set으로 사용해서 다시 모델을 학습시킨다. 그리고 또다시 이 때의 성능을 파악한다. 예시는 위와 같다.

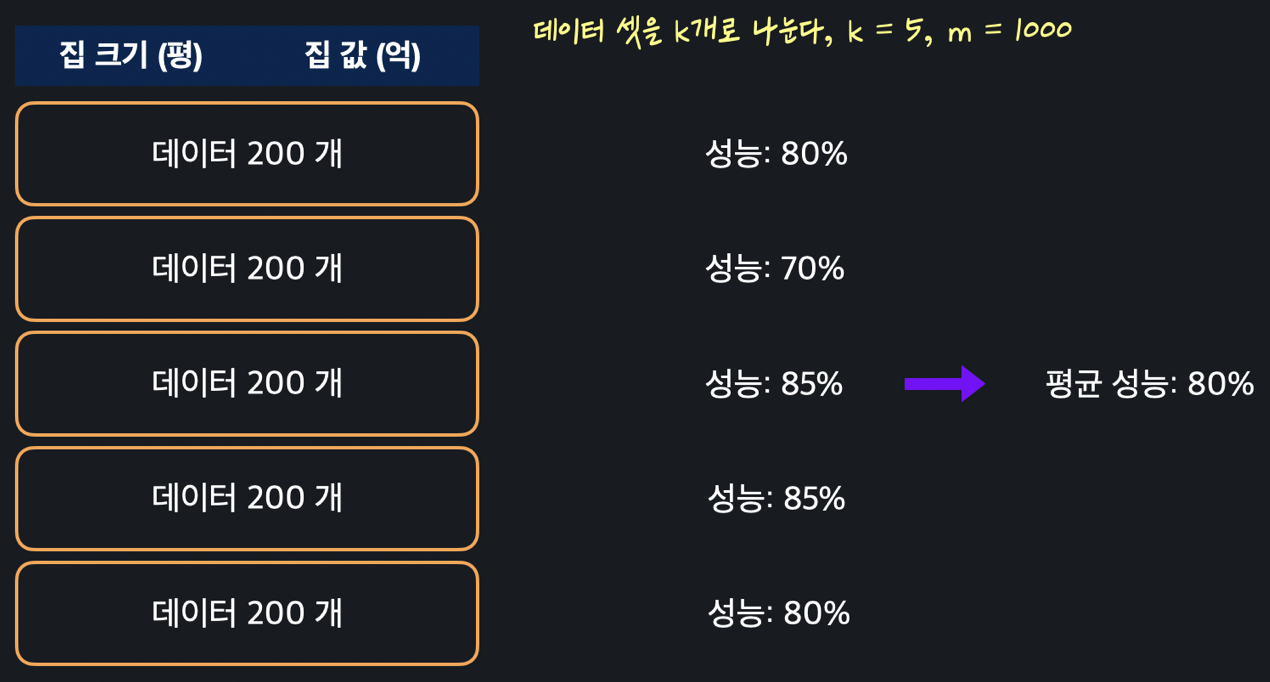

이 과정을 모든 데이터 셋에 반복해준다. 그러면 위와 같이 5개의 테스트 셋에 대한 성능이 k개 즉, 5개 있을 텐데, 이 성능 5개의 평균을 모델 성능으로 보는 것이다. 모델의 성능을 여러 번 다른 데이터로 검증(교차 검증)하기 때문에 평가에 대한 신뢰가 올라갈 수 있다.

k-겹 교차 검증을 직접 실습 해보자.

from sklearn import datasets

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression

import numpy as np

import pandas as pd

import warnings

warnings.simplefilter(action='ignore', category=FutureWarning) # 경고 메세지 무시하는 용도

iris_data = datasets.load_iris()

X = pd.DataFrame(iris_data.data, columns=iris_data.feature_names)

y = pd.DataFrame(iris_data.target, columns=['Class'])

logistic_model = LogisticRegression(max_iter=2000)

cross_val_score(logistic_model, X, y.values.ravel(), cv=5) # k-겹 교차 검증을 할 모델, 입력 변수, 목표 변수, k를 정하는 파라미터이렇게 5겹 교차 검증을 진행하면 다음과 같은 5개의 성능이 넘파이 배열로 출력된다.

array([0.96666667, 1. , 0.93333333, 0.96666667, 1. ])이 성능들을 평균을 내면 일반화된 모델의 성능을 알 수 있는 것이다.

np.average(cross_val_score(logistic_model, X, y.values.ravel(), cv=5)) # 5개의 성능의 평균을 낸다결과: 0.9733333333333334💡 Stratified K-Fold Cross Validation (계층적 K-겹 교차 검증)

k-겹 교차 검증에도 단점이 있다. 바로 데이터 편향이 존재하는 경우, 제대로 된 모델 학습과 검증이 이루어지지 않을 수 있다.

예를 들어 클래스 0이 95%, 클래스 1이 5%인 데이터셋이 있다고 가정하자. 일반 K-Fold를 사용하면 일부 폴드에서는 클래스 1이 거의 포함되지 않을 수 있다. 정말 극단적으로는 일부 폴드에는 클래스 0만 가득차 있을 수 있는 것이다.

이러한 문제를 해결하기 위해 계층적 K-겹 교차 검증을 한다.

계층적 K-겹 교차 검증은 모든 폴드에서 클래스의 비율들을 동일하게 만든다. 이렇게 하면 데이터가 편향되어 있을 경우 k-겹 교차 검증을 했을 때보다 더 안정적인 모델 평가가 가능해진다.

코드는 다음과 같다.

from sklearn.model_selection import StratifiedKFold, cross_val_score

# Stratified K-Fold 설정 (K=5)

skf = StratifiedKFold(n_splits=5, shuffle=True, random_state=42)

# 로지스틱 회귀 모델 학습 및 평가

logistic_model = LogisticRegression(max_iter=200)

# 교차 검증 수행

scores = cross_val_score(logistic_model, X, y, cv=skf)계층적 k-겹 교차검증은 데이터가 이미 균형되어 있다면 그냥 일반 k-겹 교차 검증을 사용해도 좋다.

하지만 데이터가 너무 적어서 특정 클래스가 특정 폴드에 거의 포함되지 않는 문제를 방지하고 싶을 때에 계층적 k-겹 교차검증을 사용하면 효과적이다.

그리고 계층적 k-겹 교차검증은 분류 문제에서만 사용하기 때문에 회귀에서는 사용하지 않아도 된다.

📍 LOOCV (Leave-One-Out Cross Validation)

LOOCV는 K-Fold 교차 검증의 극단적인 경우로, k-겹 교차 검증에서는 샘플링된 데이터가 폴드(군집)이지만 LOOCV에서는 낱개이다.

다시 말해 LOOCV는 데이터를 낱개로 뽑아 K-Fold 교차 검증 방식으로 진행하는 것이다. 따라서 데이터가 N개 있으면, N-Fold 교차 검증을 수행하는 것과 동일하다고 볼 수 있다.

코드는 다음과 같다.

from sklearn.model_selection import LeaveOneOut, cross_val_score

# LOOCV 설정

loo = LeaveOneOut()

# 로지스틱 회귀 모델

logistic_model = LogisticRegression(max_iter=200)

# LOOCV 수행

scores = cross_val_score(logistic_model, X, y, cv=loo)LOOCV는 데이터를 낱개로 샘플링 하기 때문에 연산 비용이 굉장히 크다. 따라서 LOOCV는 데이터가 매우 적지만 k-겹 교차 검증 방식은 채택하고 싶을 때 효과적이다.

📌 Grid Search

그리드 서치는 하이퍼 파라미터를 튜닝하는 방법 중 하나이다.

먼저 하이퍼 파라미터에 대해 알아보자.

💡하이퍼 파라미터(Hyperparameter)

Lasso 모델을 예시로 보자.

scikit-learn에서 Lasso 모델을 만들 때 alpha와 max_iter라는 옵셔널 파라미터를 다음과 같이 지정해줬다.

model = Lasso(alpha=0.001, max_iter=1000)복습하면 alpha 는 정규항에 곱해지는 상수 였고, max_iter 는 경사 하강을 최대한 몇 번 할지를 정하는 값이었다.

이 두 값은 모델이 직접 학습해서 배우는 게 아니라 모델을 만드는 사람이 정해줘야 한다.

이처럼 머신 러닝 모델을 학습시키기 전에 사람이 미리 정해줘야 되는 변수들을 하이퍼 파라미터라고 한다.

하이퍼 파라미터에 어떤 값을 넣느냐에 따라 모델의 성능에 큰 차이가 있을 수 있기 때문에 모델의 성능을 최대한 높여주는 하이퍼 파라미터를 고르는 게 굉장히 중요하다.

그러면 이제 좋은 하이퍼 파라미터를 고르는 방법 중 하나인 그리드 서치에 대해서 알아보자.

📍 Grid Search

그리드 서치는 정해줘야 하는 각 하이퍼 파라미터에 넣어보고 싶은 후보 값을 몇 개씩 정한 뒤, 모든 후보 값의 조합으로 모델을 학습시켰을 때 성능이 가장 좋았던 하이퍼 파라미터 조합을 고르는 방식이다.

그림으로 보면 다음과 같다.

각 하이퍼 파라미터 후보 값들의 모든 조합으로 모델의 성능을 평가했을 때 나올 수 있는 표는 위와 같다. (이때 성능은 k-겹 교차 검증을 사용해서 조금 더 정확하고 공평하게 계산한다.)

그리고 그 성능들 중 가장 성능이 좋은(평균 제곱 오차근이 낮을수록 성능이 좋다.) 하이퍼 파라미터 조합을 선택하면 된다.

이런 식으로 표로 Grid(격자 모양)를 만들고, 여기서 성능이 가장 좋은 하이퍼 파라미터를 찾는 방법이기 때문에 Grid search라고 부른다.

하이퍼 파라미터가 2개 이상일 때도 똑같은 방식으로 모든 조합을 확인한 뒤 성능이 가장 잘 나오는 하이퍼 파라미터 조합을 선택하면 된다.

코드는 아래와 같다.

from sklearn.linear_model import Lasso

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error

from sklearn.preprocessing import PolynomialFeatures

from sklearn.model_selection import GridSearchCV

from math import sqrt

import numpy as np

import pandas as pd

admission_df = pd.read_csv('../data/admission_data.csv')

X = admission_df.drop('Chance of Admit ', axis=1)

polynomial_transformer = PolynomialFeatures(2) # 2차식 변형기 정의

polynomial_features = polynomial_transformer.fit_transform(X.values)

features = polynomial_transformer.get_feature_names_out(X.columns)

X = pd.DataFrame(polynomial_features, columns=features)

y = admission_df[['Chance of Admit ']]

hyper_parameter = { # 각 하이퍼 파라미터의 후보군들을 담은 딕셔너리

'alpha': [0.01, 0.1, 1, 10],

'max_iter': [100, 500, 1000, 1500, 2000]

}

lasso_model = Lasso()

hyper_parameter_tuner = GridSearchCV(lasso_model, hyper_parameter, cv=5) # 사용할 모델, 실험해볼 하이퍼 파라미터 값들, 각 성능 판단시 몇 겹 교차 검증을 할 건지

hyper_parameter_tuner.fit(X, y) # hyper_parameter_tuner에 X, y를 넣어서 하이퍼 파라미터 후보들 중 이 데이터에 알맞는 최적의 조합을 찾는다.(fit 한다.)

hyper_parameter_tuner.best_params_ # 최적의 하이퍼 파라미터 조합 확인결과:

{'alpha': 1, 'max_iter': 100}출처: 코드잇