**논문 : "PlanRAG: A Plan-then-Retrieval Augmented Generation for Generative Large Language Models as Decision Makers" (2024)

https://arxiv.org/abs/2406.12430

📑 논문 개요 요약

1. 연구 목적

- LLM을 복잡한 데이터 분석이 필요한 의사결정 도구로 활용하는 가능성을 탐구.

- 새로운 문제 정의: Decision QA → 데이터베이스(D), 비즈니스 규칙(R), 의사결정 질문(Q)을 입력으로 받아 최적의 의사결정(d_best)을 산출.

- 기존 RAG 기법은 단순 지식 기반 QA에 강점이 있으나, 의사결정 과정의 핵심인 계획 수립(Planning) 단계에 약점이 존재.

2. Decision QA와 DQA 벤치마크

-

Decision QA: 계획 수립 → 데이터 검색/분석 → 최종 결정 산출의 전체 과정을 LLM이 담당.

-

DQA 벤치마크: 실제 기업 데이터를 대체하여 게임 데이터(유로파 유니버설리스 IV, 빅토리아 3) 기반으로 제작.

- Locating 시나리오: 특정 국가가 이익 극대화를 위해 상인을 어느 무역 노드에 배치해야 하는가?

- Building 시나리오: 특정 상품의 가격을 낮추기 위해 어떤 공장을 확장해야 하는가?

-

총 301개의 의사결정 상황(Locating 200, Building 101) 제공.

-

관계형 DB(RDB)와 그래프 DB(GDB) 두 가지 형태로 구성하여 다양한 질의 환경 지원.

3. 제안 기법: PlanRAG

-

PlanRAG = 계획(Plan) + 검색(Retrieval) + 재계획(Re-planning)

-

단계별 절차:

- Planning: 질문(Q), 스키마(S), 규칙(R)을 바탕으로 필요한 분석 계획을 수립.

- Retrieving & Answering: 계획에 따라 질의(SQL 또는 Cypher)를 실행하여 결과를 기반으로 추론.

- Re-planning: 초기 계획이 부족할 경우 재계획을 수행하며, 이 과정을 반복.

-

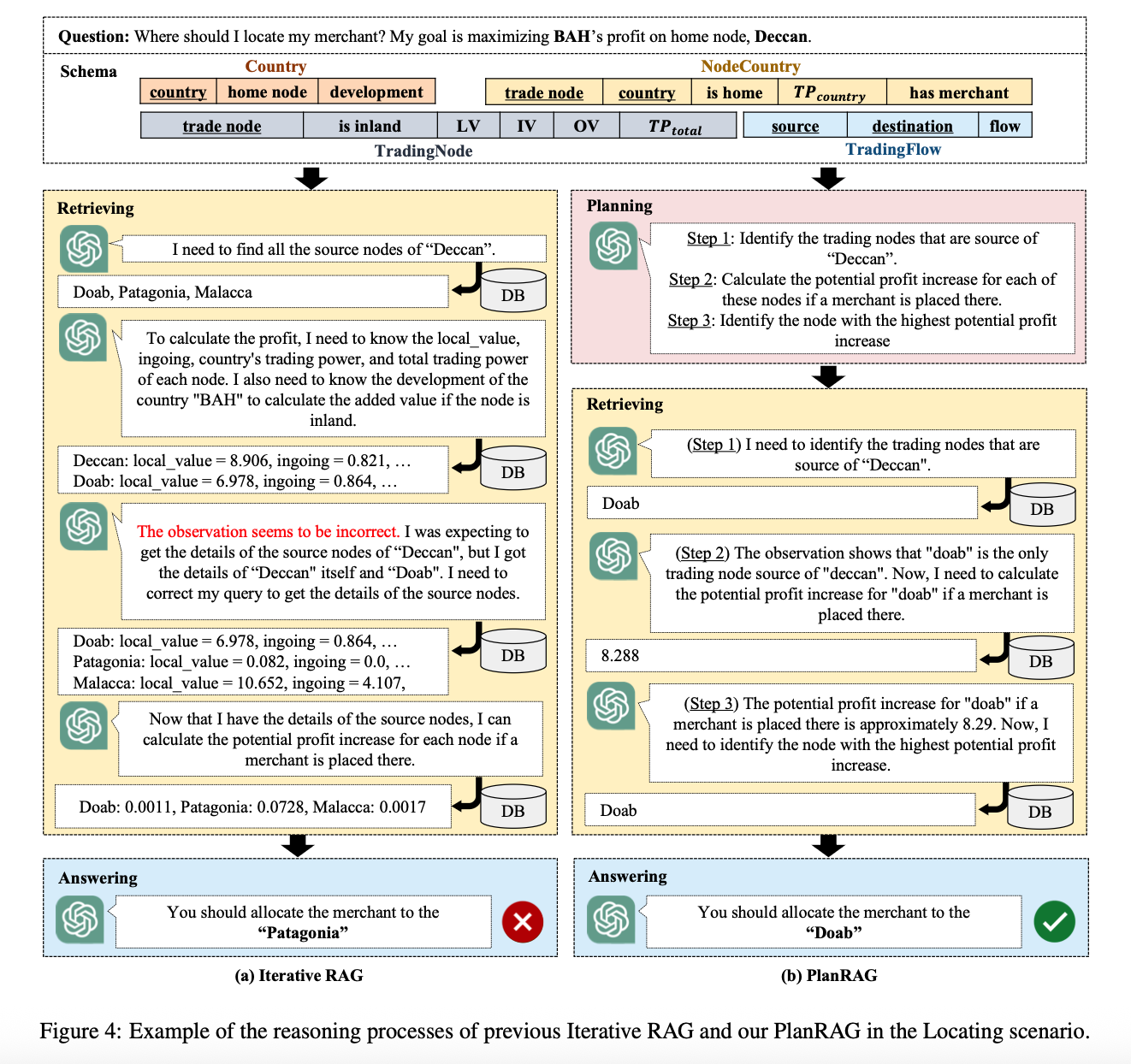

기존 Iterative RAG는 단순 반복 검색만 수행하지만, PlanRAG는 체계적인 계획 기반 반복을 통해 성능을 향상.

4. 실험 결과

-

비교 대상: SingleRAG-LM, IterRAG-LM, PlanRAG-LM, PlanRAG-LM (Re-planning 제거).

-

결과 요약:

- Locating 시나리오: PlanRAG 64.3% 정확도 (IterRAG 대비 +15.8%).

- Building 시나리오: PlanRAG 45.0% 정확도 (IterRAG 대비 +7.4%).

-

Re-planning의 효과: 재계획 과정을 제거하면 Locating에서 10.8% 정확도 하락 → 재계획이 핵심 역할을 함.

-

RDB, GDB 모두에서 PlanRAG가 가장 우수. 특히 복잡한 그래프 탐색이 필요한 Building 시나리오에서 효과적.

5. 분석 및 한계

-

장점:

- 기존 RAG가 취약한 **데이터 분석 단계(IV, CO, PD 계산 등)**에서 누락률을 크게 줄임.

- 질문 난이도에 따라 적절한 다중 검색 전략을 선택하여 정확도 향상.

- 실패 유형 중 "후보 선택 오류(CAN)"와 "데이터 분석 누락(MIS)"을 효과적으로 감소.

-

한계:

- 현재는 RDB/GDB에 국한됨 → 하이브리드 DB, 벡터 DB 확장 필요.

- 고수준 RAG 기법에 집중했으며, 세부적인 질의 최적화(예: Cypher 전용 fine-tuning)는 다루지 않음.

- 단일 LLM 프레임워크만 실험 → 멀티 LLM 구조에서의 성능은 미검증.

6. 결론

- PlanRAG는 **계획 기반 반복 검색(Plan + Retrieval + Re-plan)**을 통해 기존 RAG 대비 의사결정 정확도를 크게 개선.

- 제안된 Decision QA와 DQA 벤치마크는 LLM을 실제 의사결정 시스템에 적용하기 위한 새로운 실험 환경을 제공.

- 연구 결과는 LLM이 단순 답변 생성을 넘어 복잡한 데이터 기반 의사결정 지원에도 활용될 수 있음을 보여줌.

🔎 PlanRAG vs IterRAG 비교 요약

1. 기본 개념 차이

-

IterRAG (Iterative Retrieval-Augmented Generation)

- 질문(Q)에 대해 데이터를 검색(Retrieval) → 결과 기반으로 답변 생성 → 필요시 반복.

- 단점: 단순 반복 검색만 수행, 분석 계획 수립(Planning) 능력이 부족.

-

PlanRAG (Plan-then-Retrieval Augmented Generation)

- 먼저 어떤 분석이 필요한지 계획(Planning) 수립.

- 그 후 검색(Retrieval)과 추론 → 필요시 재계획(Re-planning) 반복.

- 강점: 체계적 계획 기반 접근으로 복잡한 의사결정 문제 해결에 강함.

2. 절차적 차이

| 단계 | IterRAG | PlanRAG |

|---|---|---|

| 1. 계획 | 없음. 곧바로 검색 시작 | 질문·스키마·규칙을 바탕으로 분석 계획 수립 |

| 2. 검색 | 반복적 검색 (정확도 낮음) | 계획에 따라 구체적 질의 생성 후 검색 |

| 3. 재계획 | 없음 | 필요시 계획 수정 후 추가 검색 |

| 4. 답변 생성 | 검색 결과 기반 단순 응답 | 체계적 분석 결과 기반 최적 의사결정 도출 |

3. 성능 차이

-

Locating 시나리오:

- IterRAG 48.5% → PlanRAG 64.3% (+15.8%)

-

Building 시나리오:

- IterRAG 37.6% → PlanRAG 45.0% (+7.4%)

-

Re-planning 제거 시: Locating에서 10.8% 정확도 하락 → 재계획이 효과적임을 입증.

4. 오류 유형 비교

-

IterRAG:

- CAN(잘못된 후보 선택), MIS(데이터 분석 누락) 오류가 많음.

-

PlanRAG:

- CAN, MIS 오류 크게 감소 → 질문 이해도와 데이터 접근 정확도가 향상.

- 대신 DEEP(수식/데이터 오용) 오류가 상대적으로 증가 (계획 기반으로 더 깊은 분석을 시도하기 때문).

5. 핵심 차이 정리

- IterRAG = “검색 중심” 접근 → 복잡한 데이터 분석 문제에서 취약.

- PlanRAG = “계획 + 검색 + 재계획” 접근 → 체계적이고 정확도가 높음.

- 특히 질문 난이도 오판 방지와 중요 데이터 누락 최소화에서 PlanRAG가 우월.

👉 요약하면, IterRAG는 단순 반복 검색에 머무르지만, PlanRAG는 계획(Planning)을 도입하여 LLM이 스스로 분석 방향을 정하고 필요시 재계획을 통해 더 나은 의사결정을 수행한다는 점에서 본질적인 차이가 있다.