NLP

1.Seq2Seq model with attention

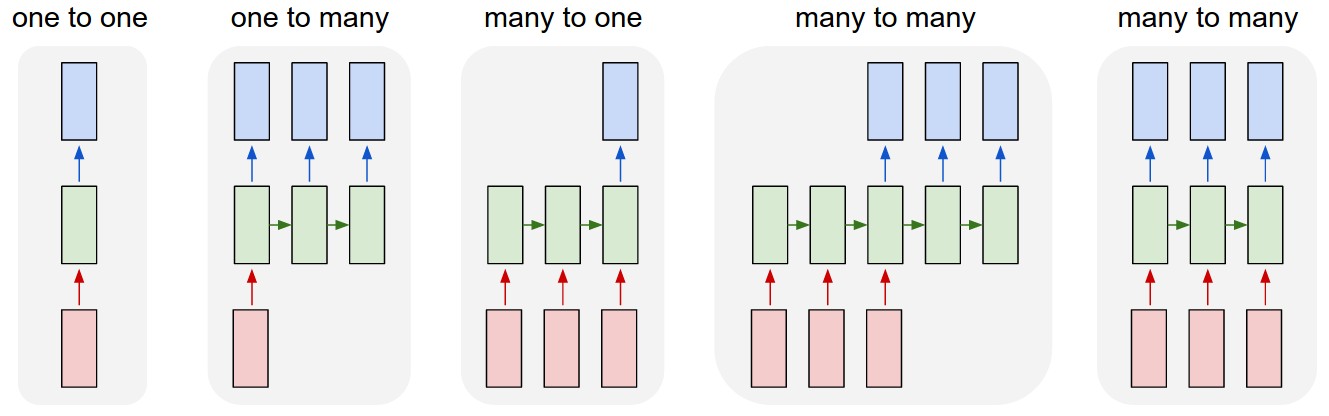

Seq2Seq 모델은 RNN의 유형 중 many to many를 사용하는 모델이다.attention은 RNN이 가진 문제(인코더의 끝단에 갈수록 병목 현상 및 정보 손실 문제)를 해결하기 위해 나온 idea이다. many to many model은 그림에서 볼 수 있듯

2022년 3월 14일

2.attention, scaled dot-product

Transfomer의 논문 제목 "Attention is all you need"에서 볼 수 있듯이 Transformer는 Seq2Seq with attention 모델에서 attention을 주로 사용한 모델이다.

2022년 3월 16일