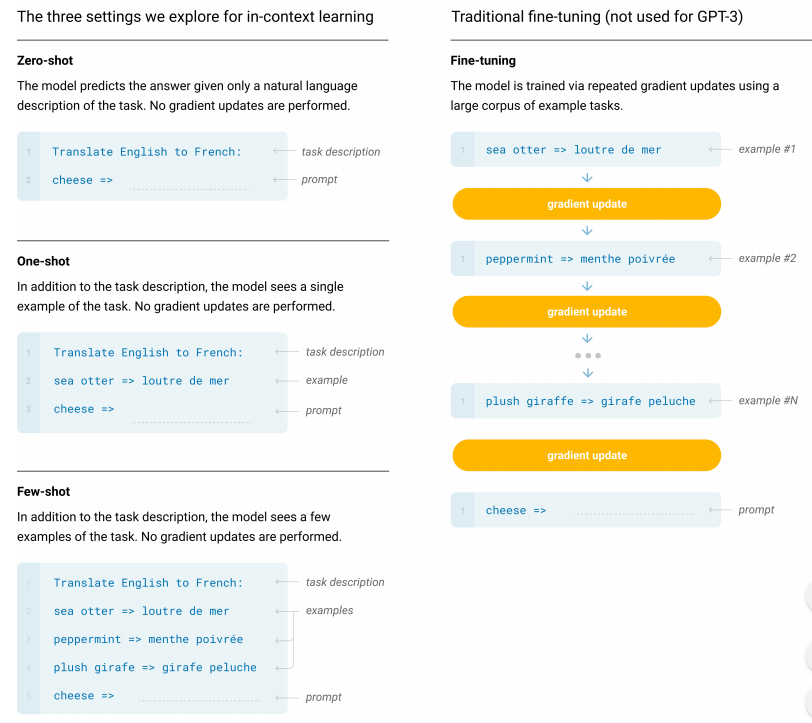

zero-shot: 딱히 어떠한 예제 없이 주어진 task 설명 만으로 결과 도출

one-shot: 한 개의 예제와 task 로 결과 도출

few-shot: 여러 개의 예제와 task 로 결과 도출

위 과정들은 전부 데이터로 fine-tuning 없음(대신 task 설명이나 몇몇 예제를 input 에 넣고 이해시키는 것 , gradient update 없음), in-context learning 이라고 부름, 주로 parameter 규모가 커짐에 따라 (LLM) 발전됨

fine-tuning: nlp 에서 가장 보편적인 방법, 수천개 라벨링 데이터를 사용, 라벨링 데이터가 많이 필요하다는 단점

GPT-1 : unlabeled text corpora 로 사전 학습 후 labeled data 로 fine-tuning

GPT-2 : 대용량 WebText 로 학습, 지도학습 대신 처음부터 비지도학습 사전 모델 이용한unsupervised multitask learning, 혁신적인 zero-shot 도입했지만 성능이 좋진 않음

GPT-3 : 엄청난 파라미터 수 증가(1750억), few-shot learning 사용해서 다양한 task 적응 가능