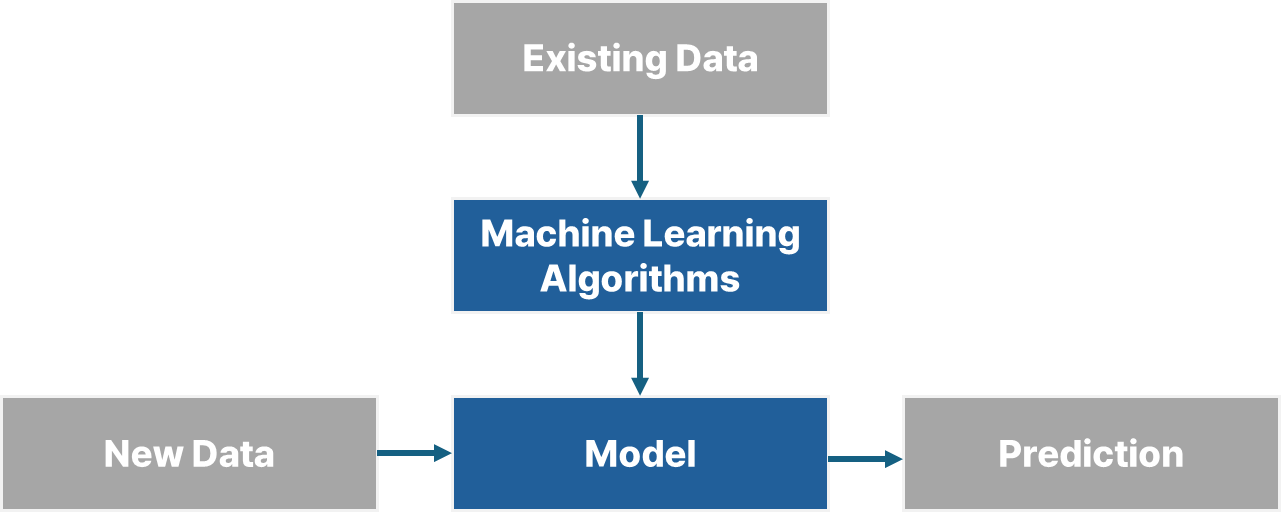

Machine Learning Process

Key concepts

- Model : 예측을 위한 수학 공식, 함수

- 1차 방정식, 확률분포, condition rule

- Algorithms : 어떠한 문제를 풀기 위한 과정

- Model을 생성하기 위한 (훈련) 과정

모델을 학습할 때 영향을 주는 것들

y = ax + by- 주어진 Y값: 종속변수a,b- 알고리즘을 통해 최적값을 찾음x- 주어진 X값: 독립변수

y에 대해 영향을 줄 수 있는 x는 여러 개가 존재할 수 있다.

X변수의 실제 데이터는 특징(feature)을 나타낸다.

feature vector

- : 특징(feature) 벡터

- : 가중치(weight) 벡터

- : 가중치와 특징 벡터의 내적 -> 예측값

- 일 경우, 는 편향(bias) 항으로 사용된다.

- 선형대수의 표기법

와 를 list 형태의 값으로 표현하게 되면, y의 값을 구할 수 있게 된다.

Representing a model

벡터를 Array로 표현하기

- : 데이터 Sample

- : Weight number

- : Data table

REFERENCE