Vanishing Gradient Problem이 문제가 되는 이유

레이어가 엄청나게 많을 때 발생하는 문제. Output Layer에서 출력된 예측값과 정답값을 비교해서 계산된 Loss를 토대로 optimizer는 weight값을 조정하려 할 때 어떤 weight가 문제였는지 추적이 힘들어진다.

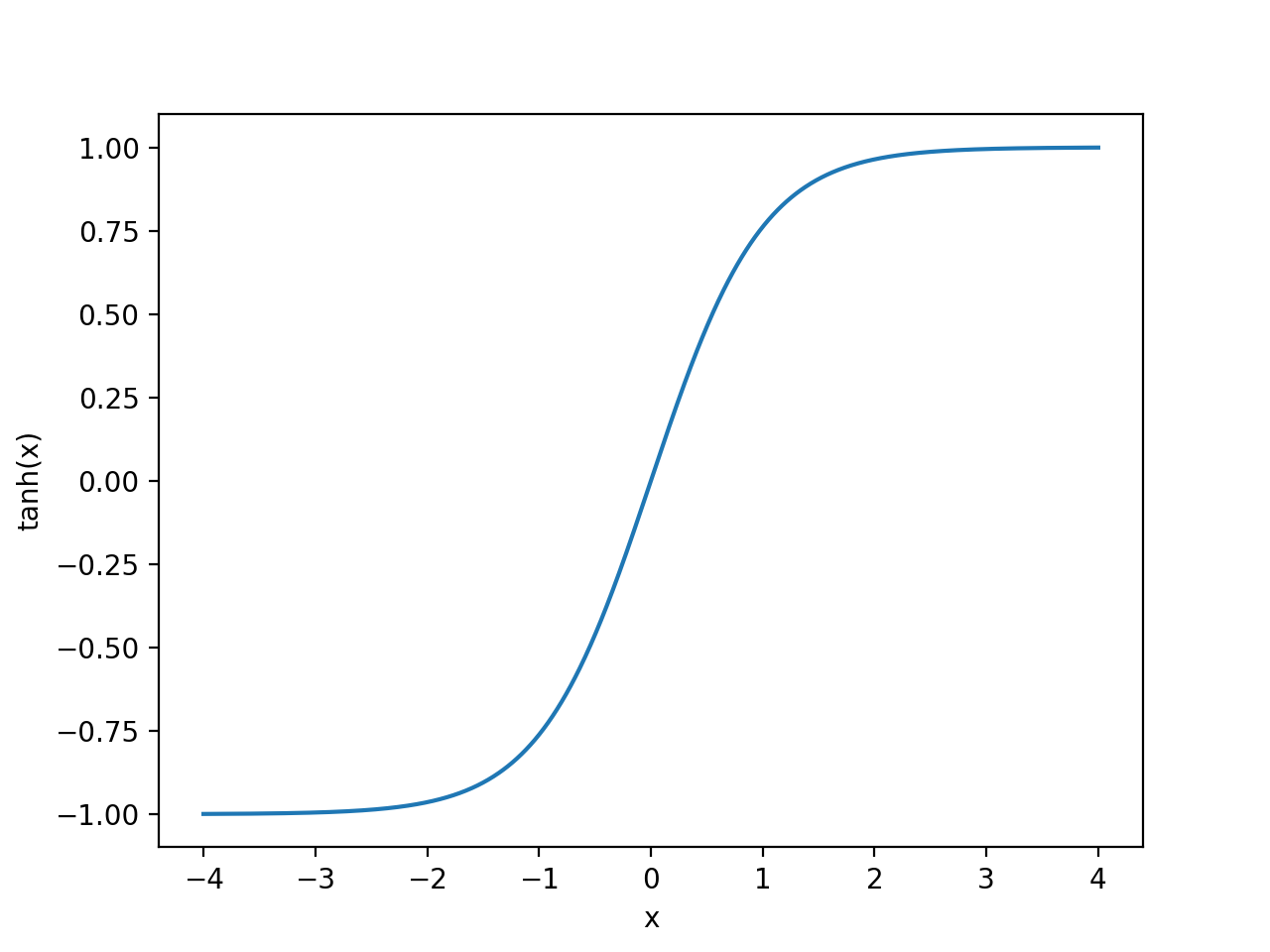

대표적으로 문제가 발생하는 tanh 그래프를 보시면 Input이 -1일 때와 1일 때의 값의 차이는 매우 크다. 하지만 2와 4의 차이는 거의 미미. 분명 Input 값의 차이는 절댓값 2만큼으로 동일하나 결괏값의 차이가 다르다. 조금 더 극단적으로, input이 5일 때와 5,000,000 일 때의 결괏값의 차이는 0이라고 봐도 무방. 그래서 레이어가 많아질수록 문제가 되는 weight값을 찾기가 힘든 것.

이러한 면에서 non-linear한 특징과 linear한 특징을 동시에 가지고 있는 relu function의 사용이 필수적.