Unsupervised Representation Learning for time series including Contrastive Learning

Total Review

1. TCL: Unsupervised Feature Extraction by Time-Contrastive Learning and Nonlinear ICA

(NIPS, 2016, 225회 인용)

Abstract

- 비선형 독립 성분 분석(ICA)는 비지도 학습을 위한 프레임워크 제공했지만 식별 불가능하다는 한계점 존재

- TCL 모델에서는 데이터의 비정형 구조를 사용하는 비지도 딥러닝 제안

- TCL은 시간 세그먼트(윈도우)의 최적의 변별을 가능하게 하는 표현을 찾음

- 또한 ICA가 시간적 비정상성을 포함하도록 재정의 할때, TCL이 비선형 ICA모델과 어떻게 관련될 수 있는지 보여줌

- 마지막으로 선형 ICA와 결합한 TCL모델은 비선형 ICA모델이 point-wise 변환까지 추정함?

1. Introduction

Unsupervised nonlinear feature learning, or unsupervsied representation learing

-> 유명한 methods = multi-layer belief nets, Restricted Boltzmann Machines, autoencoders

-> 하지만 이런 모델들은 scalability, theoretical justification이 부족함

더 나은 방법론은 시계열의 temporal 구조를 반영한 것임

-> temporal coherence, slow feature analysis

-> 천천히 변화하는 features를 찾음

- 여기에 Kernel-based methods와 deep learning 방법을 추가함

2. CPC: Representation Learning with Contrastive Predictive Coding

(2019.01.22, 3121회 인용)

- 본 논문은 고차원 데이터에서 유용한 representation을 추출하기 위한 unsupervised learning 접근법을 제안

- 강력한 auto-regressive 모델을 사용하여 latent space에서 추출된 z를 이용하여 미래를 예측하는 representation 학습법 제안

- 미래 샘플을 예측할 때 가장 유용한 정보를 얻기 위해 latent space를 유도하는 확률적 contrastive loss 사용

1. Introduction

- 지도학습 기반 end-to-end 모델은 데이터 효율성, robustness, 일반화와 같은 과제가 남아있음

- 이를 위해 high-level representation 학습이 가능한 unsupervised 기법이 필요함

- 하지만 고차원의 representation 모델링은 여전히 어렵고 어떤게 가장 이상적인 representation인지 알기 어려움

- 비지도 학습을 위한 가장 일반적인 전략 중 하나는 미래를 예측하는 것이며, predict coding 아이디어는 데이터 압축을 위한 신호 처리에서 사용된 오래된 기술 중 하나임

- 실제로 이러한 아이디어를 사용하여 이웃 단어를 예측하여 단어 표현을 학습한 word2vec 사례가 있음.

2. Proposed method

1) Conditional 예측 모델링을 쉽게 하기 위해 latent embedding space로 고차원 데이터를 압축

- 이 latent space에서 강력한 autoregressive model을 사용하여 미래에 많은 steps를 예측함

- 즉, 고차원 데이터 간의 shared information을 인코딩한 mutual information을 얻기 위해 representation을 학습함

2) Noise-Contrastive Estimation에 의존한 loss 함수

- NLP에서 word embedding을 학습하는데 사용된 것과 유사한 방식으로, loss함수에 대해 Noise-Contrastive Estimation에 의존하여 전체 모델이 end-to-end 학습 가능하도록 제안

Noise-Contrastive Estimation

- NCE를 사용하면 (실제 분포에서 얻은 샘플=Positive)와 (인공적으로 만든 잡음 분포에서 얻은 샘플=Negative)를 구별하는 이진 분류 문제로 바꿀 수 있게 됨.

- 현재(목표, target, positive)단어에는 높은 확률을 부여하고, 나머지 단어(negative, noise)에는 낮은 확률을 부여하여 가장 큰 값을 만드는 목적함수 사용

즉, 정리해보면,

CPC = 미래 관찰 예측 + 확률적 대비 손실 의 결합이라고 볼 수 있음

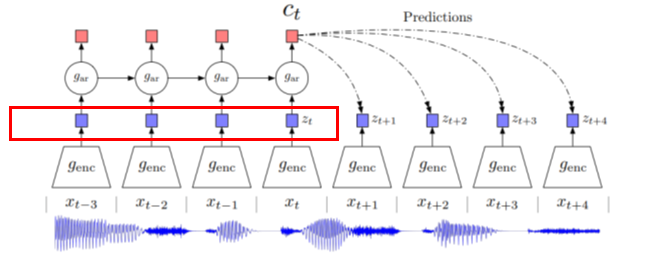

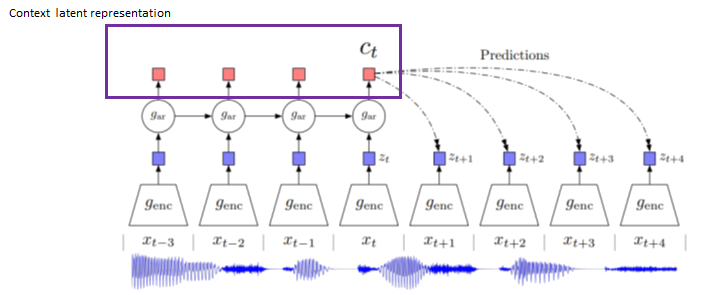

Model architecture

1) 비선형 인코더 g_enc

- 해당 time step t를 기준으로 진행되며, 이후의 값들을 사용하여 예측하지 않음

- 관측치 x_t인 input sequence를 z_t = g_enc(x_t)로 매핑함

- 이를 통해, 잠재적으로 더 lower한 temporal resolution으로 변경됨

2) Autoregressive model g_ar

- Latent space의 현재 시간 t를 포함한 이전의 모든 값들에 대해 요약

- 이후 Context latent representation c_t = g_ar(z_t)를 생성

3. SRL: Unsupervised Scalable Representation Learning for Multivariate Time Series

(NIPS, 2020.01.03, 141회 인용)

4. TST: A TRANSFORMER-BASED FRAMEWORK FOR MULTIVARIATE TIME SERIES REPRESENTATION LEARNING

(KDD, 2020.12.08, 87회 인용)

5. TNC: UNSUPERVISED REPRESENTATION LEARNING FOR TIME SERIES WITH TEMPORAL NEIGHBORHOOD CODING

(ICLR 2021, 2021.06.01,26회 인용)

6. TS-TCC: Time-Series Representation Learning via Temporal and Contextual Contrasting

(IJCAI-21, 2021.06.26, 26회 인용)