Total Review

1.Contrastive Learning without Negative Pairs

기존 대조학습 방법들은 negative pair를 잘 선택해줘야 함. 이를 위해 customoized mining 전략 등이 제안됨.많은 memory bank가 필요함또한 굉장히 큰 batch size에서 학습을 시켜야 하고, 학습에 사용된 image augmentat

2022년 9월 28일

2.12월 논문 간단 요약

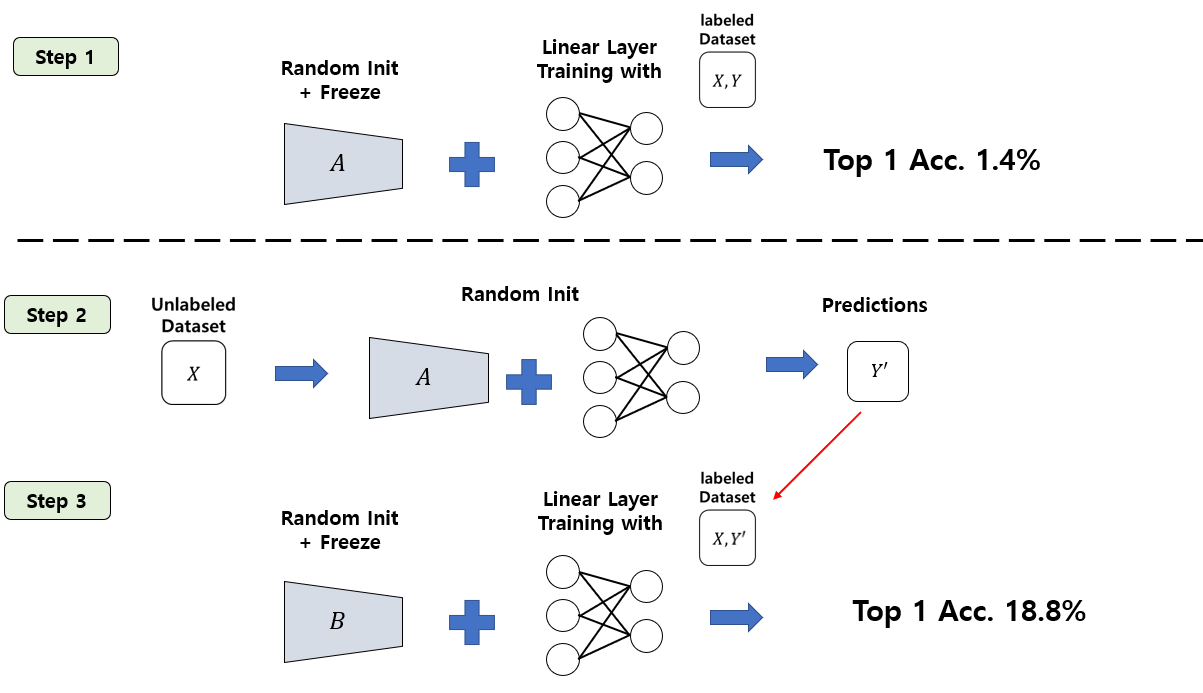

<Unsupervised pre-training과 Supervised fine-tuning> 과정으로 이루어짐. unsupervised pre-training을 통해 representation을 학습할 수 있는 모델인 Transformer 사용함. Transfor

2022년 12월 6일

3.기본 딥러닝 개념

📌 Batch vs Mini-Batch https://welcome-to-dewy-world.tistory.com/86 ✔ 배치(Batch) 인공신경망에 10만개의 데이터를 학습시키고자 할 때, 어떻게 하면 빠르게 학습시킬 수 있을까? A) 데이터를 1개씩 입력

2022년 12월 12일

4.Domain Generalization with Representation Learning

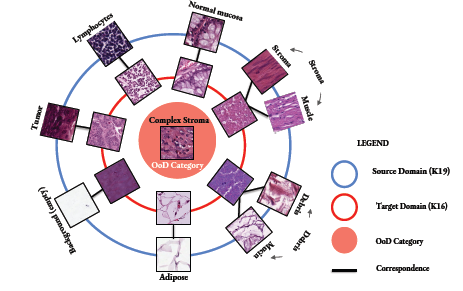

1. SOoD: Self-Supervised Out-of-Distribution Detection Under Domain Shift for Multi-Class Colorectal Cancer Tissue Types (ICCV 2021, 9회 인용) 자기지도, OOD

2023년 8월 16일

5.Unsupervised Representation Learning for time series including Contrastive Learning

1. TCL: Unsupervised Feature Extraction by Time-Contrastive Learning and Nonlinear ICA (NIPS, 2016, 225회 인용) Abstract 비선형 독립 성분 분석(ICA)는 비지도 학습을 위한 프

2024년 2월 6일