week6 - day1 Deep Learnong: 신경망의 기초

인공지능이란?

- 혁명의 시작

- 인간처럼 생각하고 행동하는 기기의 탄생

기계학습 개념

관찰된 데이터들을 어떻게 설명할 것인가?

- 가설: 눈대중으로 데이터 양상이 직선임-> 모델을 직선으로 선택 가정

기계 학습의 훈련

- 주어진 문제인 예측을 가장 정확하게 할 수 있는 최적의 매개변수를 찾는 작업

- 처음은 임의의 매개변수 값에서 시작하지만, 개선하여 정량적인 최적 성능에 도달

훈련을 마치면, 추론을 수행

- 새로운(unkown)특징에 대응되는 목표치의 예측 에 사용

기계학습의 궁극적인 목표

- 테스트 집합에 대한 높은 성능을 일반화 능력이라 부름

기계학습의 필수요소

- 학습 데이터가 있어야함

- 규칙이 존재해야됨

- 수학적으로 설명이 불가능

특징 공간에 대한 이해

- 모든 데이터 정략적으로 표현되며, 특징 공간 상에 존재

차원의 저주

- 차원이 높아짐에 따라 발생하는 현실적인 문제들 ex) d=784인 MNIS 샘플의 화가 0과 1을 가진다면 2^784 개의 칸이 거대한 공간에 고작 6만개의 샘플을 흩뿌린 희소한 분포

- 차원이 높아질수록 유의미한 표현을 찾기위해 지수적으로 많은 데이터가 필요함

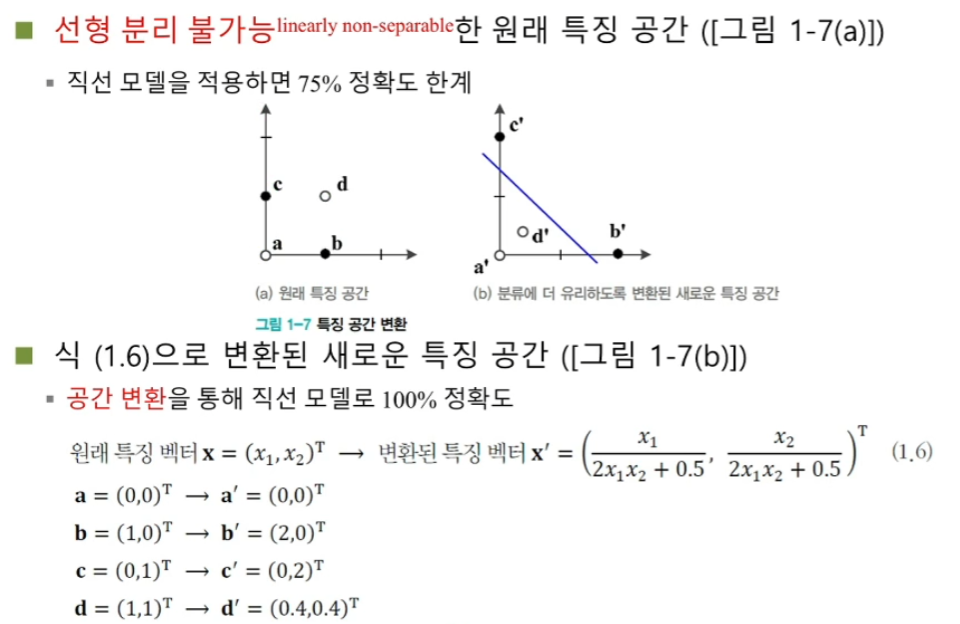

특징 공간 변환과 표현 문제

표현 문제의 예

(직선으로 나눌수 있음)

표현 학습

- 좋은 특징 공간을 자동으로 찾는 작업

심층학습 : Deep Learning

- 표현학습의 하나로 다수의 은닉층을 가진 신경망을 이용하여 최적의 계층적인 특징을 학습

데이터에 대한 이해

과학 기술의 정립 과정

- 데이터 수집 -> 모델정립(가설)-> 예측 -> 데이터수집

기계학습

- 기계학습은 복잡 문제/과업을 다룸

- 데이터를 설명할 수 있는 학습 모델을 찾아내는 과정

데이터 생성 과정

데이터생성 과정을 완전히 아는 인위적 상황의 예제(가상)

실제 기계 학습 문제(현실)

- 데이터 생성 과정을 알 수 없음

- 단지 주어진 훈련집합 x, y 로 가설 모델을 통해 근사 추정만 가능

데이터의 중요성

데이터의 양과 질

- 주어진 과업에 적합한 다양한 데이터를 충분한 양 만큼 수집-> 과업 성능 향상

적은 양의 데이터베이스로 어떻게 높은 성능을 당성하는가?

- 데이터 희소특성 가정

- 매니폴드(많이+끼다) 가정

간단한 기계 학습의 예

선형회긔 문제

직선 모델(가설) 을 사용하므로 두개의 매개변수

목적함수 또는 비용함수

- 평균제곱오차 라고 부름

(식)

- 는 예측함수의 에측출력, 는 예측함수가 맞추어야 하는 실제 목표치

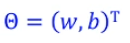

과소적합과 과잉적합

과소적합

- 모델의 용량이 작아 오차가 클 수밖에 없는 현상

대안: 비선형 모델을 사용

과잉적합

- 12차 다항식 곡선을 채택한다면 훈련집합에 대해 거의 완벽하게 근사화함

- 하지만 '새로운' 데이터 를 예측한다면 큰 문제 발생

- 이유는 '모델의 용량 이 크기' 때문에 학습과정에서 잡음까지 수용 -> 과잉적합 현상

- 훈련집합에 과몰입해서 단순 암기했기 때문임

- 적절한 용량의 모델을 선택하는 모델 선택 작업이 필요함

1차~12차 다항식 모델의 비교

- 1~2차는 훈련집합과 테스트집합 모두 낮은성능: 과소적합

- 12차는 훈련집합에 높은 성능을 보이나 테스트집ㅎ바에서 낮은 성능 -> 낮은일반화 능력:과잉적합

- 3~4차는 훈련집합에 대해 12차보다 낮겠지만 테스트집합에서는 높은 성능-> 높은일반화 능력: 적합모델 선택

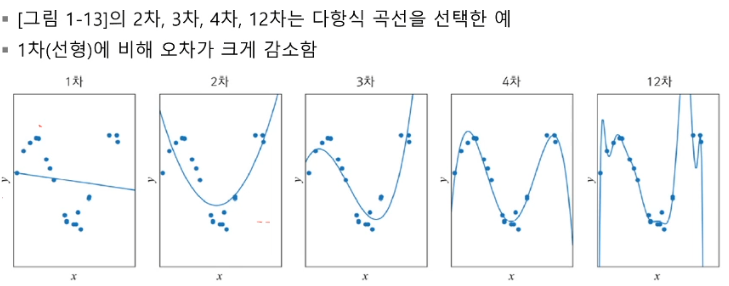

모델의 일반화 능력과 용량 관계

편향(bias) 과 분산(variance)

훈련집합 을 여려 번 수집하여 1차~12차에 반복 적용하는 실험

- 2차는 매번 큰 오차 -> 편향이 큼. 하지만 비슷한 모델을 얻음 -> 낮은 변동

- 12차는 매번 작은 오차 -> 편향이 작음. 하지만 크게 다른 모델을 얻음 -> 높은 변동

- 일반적으로 용량이 작은 모델은 편향이 크고 분산이 작음 복작한 모델은 편향이 작고 분사이 큼

기계 학습의 목표

- 낮은 편향과 낮은 분산을 가진 예측 모델을 만드는 것이 목표

- 하지만 모델의 편향과 분산은 상충 관계

- 따라서 편향을 최소로 유지하며 분산도 최대로 낮추는 전략 필요

검증집합과 교차검증을 이용한 모델 선택 알고리즘

검증집합을 이용한 모델 선택

- 훈련집합과 테스트집합과 다른 별도의 검증집합 을 가진상황(데이터 양 많음)

교차검증(cross validation)

- 비용 문제로 별도의 검증집합이 없는 상황에 유요한 모델선택기법(데이터 양 적음)

부트스트랩(bootstrap)

- 임의의 복원추출 샘플링 반복

- 데이터가 불균형일 때 적용

현실적인 해결책

현대 기계학습의 전략

- 용량이 충분히 큰 모델을 선택 한 후, 선택한 모델이 정상을 벗어나지 않도록 여러 규제 기법을 적용함

데이터 확대

- 데이터를 더 많이 수집하면 일반화 능력이 향상됨

- 데이터 수집은 많은 비용이 듦

- 인위적으로 데이터 확대

가중치를 작게 조절하는 기법

- 가중치 감쇠는 개선된 목적함수 를 이용하여 가중치를 작게 조절하는 규제기법

지도 방식에 따른 유형

지도학습

- 특징벡터 X와 목표치Y(정답있음) 가 모두 주어진 상황

- 회귀(regression) 와 분류(classification) 문제로 구분

비지도 학습

- 특징벡터 x는 주어지는데 목표치 y 가 주어지지 않는 상황(정답 없음)

- 군집화 과업

- 밀도추정, 특징 공간 변화 과업

강화 학습

- (상대적) 목표치가 주어지는데, 지도 학습과 다른 형태임(==보상) ex: 바둑

준지도 학습

- 일부는 X와Y를 모두 가지지만, 나머지는 X만 가진 상황

- 최근, 대부분의 데이터가 X의 수집은 쉽지만, Y는 수작업이 필요하여 최근 중요성 부각

오프라인 학습 과 온라인학습

- 보통 오프라인 학습을 다룸

- 온라인 학습은 loT 등에서 추가로 발생하는 데이터 샘플을 가지고 점증적 학습 수행