혼자 딥러닝이 뭘까 고민하고 정리한 내용들을 그냥 주절주절 대고 싶어 쓰는 글들은 따로 시리즈를 만들어 쓰려고 합니다.

남들에게 설명하려면 정리가 좀 필요 하거든요..ㅎㅎㅎ

Deeplearning이 뭘까?

딥러닝(Deep Learning)의 사전적인 의미는 여러 비선형 변환기법의 조합을 통해 높은 수준의 추상화(다량의 복잡한 자료들에서 핵심적인 내용만 추려내는 작업)을 시도하는 기계학습 알고리즘의 집합이라고 정의 할수 있습니다.

저는 보통 특징과 답을 알려주고, 답을 찾아는과정을 위해 기계가 스스로 특징을 찾고, 특징으로 답을 찾는 과정을 딥러닝이라고 생각합니다.

예컨데 정통적인 머신러닝(Machine Learning)에선 사진속에서 저를 찾기위해 얼굴이 동그랗다, 생머리이다, 이런 특징들을 인간이 직접 알려준후 가려내게 했다면, 딥러닝은 특징을 알려주지않고 저의 사진들을 주어 학습시킨다음, 모종의 알고리즘으로 사람들 사이에서 저를 가려내는, 그 모종의 알고리즘을 찾는 과정을 딥러닝이라고 생각하고 해오고 있습니다.

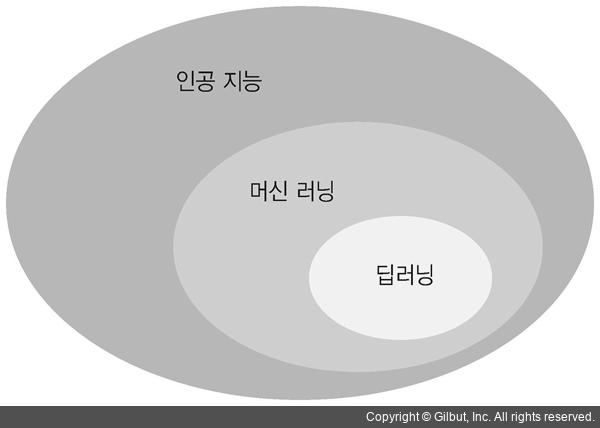

인공지능? 머신러닝? 딥러닝? 그래서 뭔데?

인공지능(Artificial Intelligence)

인공지능(Artificial Intelligence)의 사전적 의미는 인간의 지능이 갖고 있는 기능을 갖춘 컴퓨터 시스템을 뜻하며, 인간의 지능을 기계 등에 인공적으로 구현한 것을 말합니다. 가장 큰범주라고 할수있겠네요.

머신러닝(Machine Learning)

머신러닝(Machine Learning) 혹은 기계학습은 인공지능의 한 분야로, 컴퓨터가 학습할 수 있도록 하는 알고리즘과 기술을 개발하는 분야를 뜻하며, 인간이 직접 알고리즘을 기계에게 알려줘야합니다. 개인적으로 공부하면서 심층신경망을 사용하지않은 진짜 머신러닝들이 너무 어려워서 제 CPU 불타 흘러내렸던 기억이있습니다.

딥러닝(Deep Learning)

딥러닝(Deep Learning)은 여러 비선형 변환기법의 조합을 통해 높은 수준의 추상화(다량의 복잡한 자료들에서 핵심적인 내용만 추려내는 작업)을 시도하는 기계학습 알고리즘의 집합이라고 정의하고있지만, 저는 위의 챕터에서 말씀드린것처럼 답을찾는 알고리즘을 찾는 과정이라고 생각합니다. 매일 데이터들로 모델을 깎고있는데(저는 깎는다고 표현합니다) 불상깎는 노인처럼 조용히 앉아 데이터 전처리하고, 다른분들 코드보면서 리뷰해보고, 구현해보고 하는게 취미처럼 되버렸네요.. 알면알수록 재미있고 신기한 분야입니다.

NN이 뭔지가 본론아니였나?

NN은 다른글들에서 이미 설명한바 있지만, 아시다싶히 neural network, 즉 신경망입니다.

인공신경망은 보통 ANN, DNN, CNN, RNN 이렇게 다섯갈래가있고 사용되는데요.

하나씩 짧게나마 설명해보겠습니다

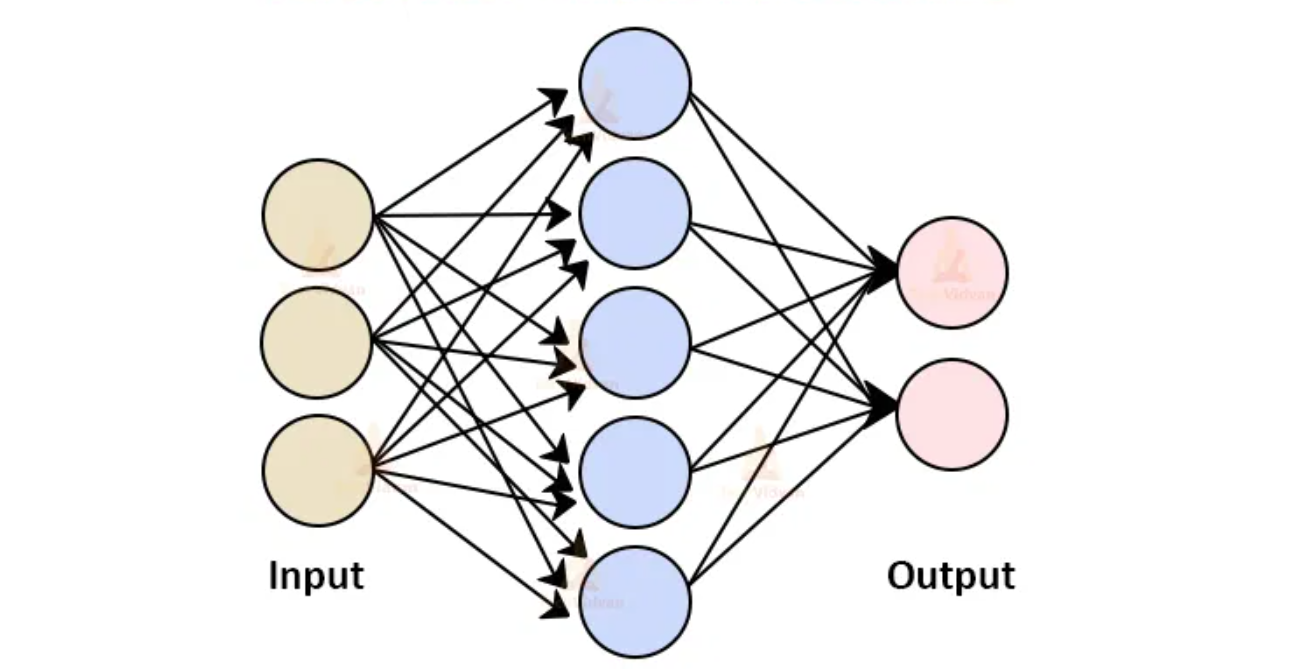

인공신경망(ANN:Artificial Neural Network)

위에서 보신 이미지처럼 머신러닝(Machine Learning)의 한 분야인 딥러닝은 인공신경망(Artificial Neural Network)를 기초로 하고 있습니다.

인공신경망(ANN:Artificial Neural Network)은 사람의 신경망 원리와 구조를 모방하여 수학적으로 구현한 기계학습 알고리즘 입니다.

인간의 뇌에서 뉴런들이 어떤 신호, 자극 등을 받고, 그 자극이 어떠한 임계값(threshold)을 넘어서면 결과 신호를 전달하는 과정에서 착안한 것입니다.

여기서 뇌에 들어온 자극은 인공신경망에서 입력된 데이터이며 임계값은 가중치(weight), 자극에 의해 어떤 행동을 하는 것은 ㅊ출력데이터라고 생각하시면 됩니다.

실제 뇌처럼 생각하진 못해, 융통성은없지만, 작동원리를 모방했기때문에 이전의 기계학습들보다 괜찮은 결과들이 나왔고, 머신러닝의 분야에서 딥러닝이라는 새로운 기수가 나올 수 있었습니다. 하지만 과대적합(over fitting)이나 연산시간이 느리다는 단점들이있습니다.

인공신경망은 시냅스의 결합으로 네트워크를 형성한 인공뉴런(노드)이 학습을 통해 시냅스의 결합 세기를 변화시켜, 문제 해결 능력을 가지는 모델 전반을 가리킨다.

<출처 : 위키백과>

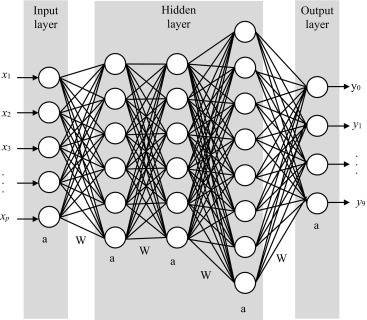

심층 신경망 (DNN:Deep Neural Network)

<이미지출저: https://www.sciencedirect.com/topics/engineering/deep-neural-network>

인공신경망의 은닉층(Hidden Layer)을 많이 쌓아 학습의 결과를 향상시키는 방법을 심층 신경망 (DNN:Deep Neural Network)이라고 합니다.

심층 신경망 (DNN:Deep Neural Network) 은닉층인공신경망의 은닉층(Hidden Layer)을 2개이상 쌓아 학습의 결과를 향상시키는 방법을 심층 신경망 (DNN:Deep Neural Network)이라고 합니다.

컴퓨터가 스스로 특징을 추출해 분류기준을 만들어 내고 차원을 축소하는등, 공간을 외곡하고 데이터를 구분하는 과정을을 반복하여 최적의 결과값을 도출해냅니다.

많은 데이터와 반복학습, 사전학습과 오류역전파 기법을 통해 현재 널리 사용되고 있습니다.

mnist데이터로 구현해보셨던 CNN(합성곱신경망 : Convolution Neural Network)과 간단하게 자연어를 학습시켜본 순환 신경망( RNN :Recurrent Neural Network), 그것의 본질적인 갈래인 장단기 메모리(LSTM:Long Short-Term Memory)이용한 날씨 예측등이 다! 심층 신경망 (DNN:Deep Neural Network)을 응용한 알고리즘인것이죠.

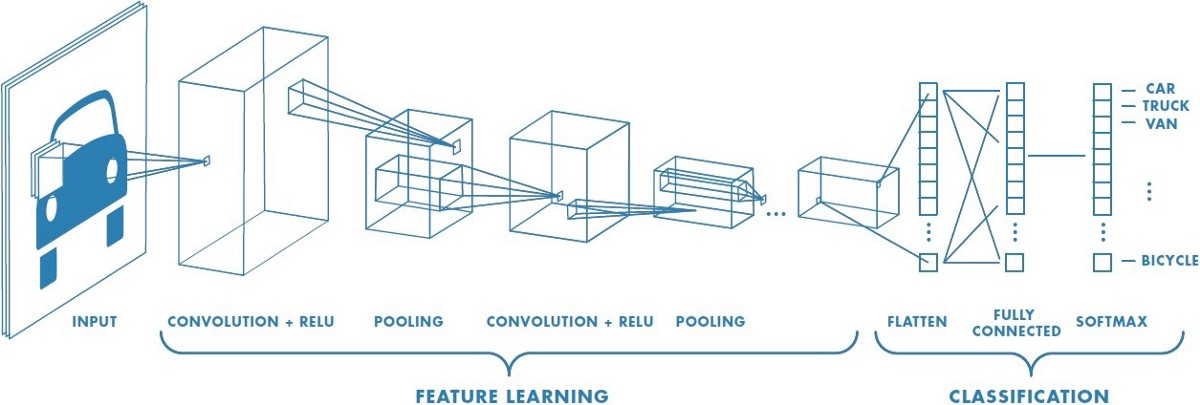

합성곱 신경망 (CNN:Convolutional Neural Network)

합성곱 신경망(CNN; Convolutional Neural Network)은 합성곱 연산을 사용하는 인공신경망(Artificial Neural Network, ANN)입니다.

여기서 합성곱이란 단어가 생소 하실수도 있을탠데, 단순히 생각하면 "뒤집어서 곱하는것" 이라고 표현할 수 있겠는데요. 수학적으로 말씀드리자면, 하나의 함수와 또 다른 함수를 반전 이동한 값을 곱한 다음, 구간에 대해 적분하여 새로운 함수를 구하는 연산과정을 합성곱이라고 합니다.

합성곱을 사용하면 다 차원 데이터의 공간적인 정보를 유지한 채 다음 레이어로 보낼 수 있는데요, 그래서 이미지나, 음성처리등에 강한 성능을 뽐내며 사용되고있습니다.

순환 신경망(RNN:Recurrent Neural Network)

<이미지 출저 :https://brunch.co.kr/@linecard/324 >

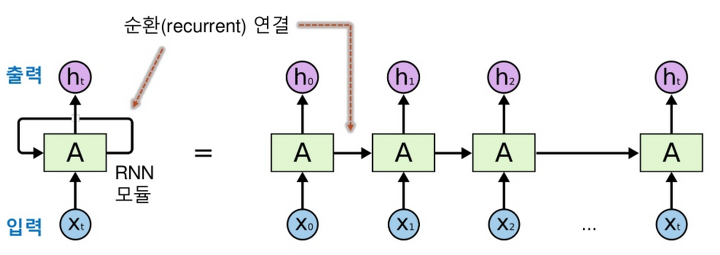

순환 신경망(RNN:Recurrent Neural Network)은 노드(node)간의 연결이 순환적 구조를 갖는 특징을 갖고 있는 신경망인데요.

이러한 구조는 시간이 흐른다는 동적 특징을 모델링 할 수 있도록, 계속해서 신경망 내부에 상태를 저장할 수 있게 합니다.

순방향으로 흘러가는 신경망과 달리 내부의 메모리를 이용해 시퀀스(흐름? 이라고 할까요?) 형태의 입력을 처리할 수 있습니다.

.따라서 순환 인공 신경망은 자연어나 음성 인식과 같은 시변적 특징(시간의 흐름)을 지니는 데이터를 처리하는데 적용할 수 있어 시계열 데이터 처리에 주로 사용하는 신경망입니다.

또 위에서 설명 드렸듯, 신경망 내부에 계속해서 상태를 저장하는데, 그 저장공간이 그래프의 형태이기 떄문에 시간 지연의 기능을 하거나 피드백 루프(개체의 행위가 인과를 거쳐, 다시 자신에게 되돌아오는 현상)를 가지게 할수도 있습니다.

이와 같은 저장공간을 게이트된 상태(gated state) 또는 게이트된 메모리(gated memory)라고 하며, 장단기 메모리(LSTM:Long Short-Term Memory)와 게이트 순환 유닛(GRU:Gated Recurrent Unit)이 이를 응용하는 대표적인 예시라고 할 수 있습니다.

아무튼.. 뭐 그렇습니다.

제가 처음 공부하면서 어려웠던 부분이 이런 신경망들의 종류와 인공지능, 머신러닝, 딥러닝이 어떤 관계인지 참 햇갈렸었는데요.. 제가 여러 사람한테 설명하면서, 저조차 정리가 제대로 안됬다고 느껴서 주저리 해보게 되었습니다.

앞으로도 재미있는 프레임워크나, 기법들이 생기면 이 시리즈에 올릴거같아요..^^

긴 주저리 읽어주셔서 감사합니다~ 오늘도 깊은 하루 되세요!

11개의 댓글

Great breakdown of NN and how deep learning continues to evolve. As these models become more advanced, I think balancing innovation with privacy controls

is going to be crucial for user trust. Thanks for the insightful read!

Great breakdown of the fundamentals of NN and its challenges in deep learning. Understanding how a model controls decision boundaries is crucial for improving performance and reducing hesitation. I found this guide on controls

particularly helpful for diving deeper into practical applications.

Great breakdown of NN and its evolving role in deep learning! It's interesting how advancements in neural networks also raise important questions about privacy in AI-driven systems. I recently explored this topic here: privacy

would love to hear your thoughts.

Great breakdown of NN and its role in deep learning! It's fascinating to see how the hesitation phenomenon plays a part in model development. I've recently been diving deeper into this topic, and from my personal review

, it's clear that understanding these subtle hesitations can really improve model accuracy. Looking forward to more insights on this! Thanks for sharing.

Great post! I found the insights on deep learning hesitation really thought-provoking. It’s interesting to see how much NN (Neural Networks) have evolved in terms of their complexity and accuracy. One thing that I’ve observed, especially in practical applications, is the importance of ensuring software and hardwarecompatibility

for optimal performance. It can significantly impact the results you get from training and inference processes. Thanks for sharing this! I’m excited to see how deep learning continues to improve in the future.

This post nicely explains the conceptual hesitation around neural networks and their real-world applications. It’s interesting how similar uncertainty applies in strategy-based games like https://3patticrown.me/, where decision-making under uncertainty plays a central role.

Way cool! Some extremely valid points! I appreciate you writing this post plus the rest of the website is also really good. https://bittlife.com/

Great insights from the inaugural lecture! The emphasis on global strategies truly highlights how digital tools are reshaping international business. I’ve also come across platforms like Torrentio (https://sassascheck.co.za/

) that provide useful examples of how technology adapts to audiences worldwide.

Very cool! You’ve made some excellent points, and I really appreciate this post. The rest of the website is also fantastic.https://www.beautyplus.com/ai-clothes-changer

Way cool! Some extremely valid points! I appreciate you writing this post plus the rest of the website is also really good.

https://infocampus.co.in/ui-development-training-in-bangalore.html

https://infocampus.co.in/web-development-training-in-bangalore.html

https://infocampus.co.in/reactjs-training-in-marathahalli-bangalore.html

https://infocampus.co.in/mern-stack-training-in-bangalore.html

https://infocampus.co.in/javascript-jquery-training-in-bangalore.html

https://infocampus.co.in/data-structure-algorithms-training-in-bangalore.html

https://infocampus.co.in/angularjs-training-in-bangalore.html

https://infocampus.co.in/front-end-development-course-in-bangalore.html