아무리 집에서 언어모델을 써 보고 싶어도 GPU가 없다! 이래저래 해 보고 싶은 것은 많지만 서버가 없어서 aws를 뭐 어떻게 해야 하나 생각하던 차에 좋은 게 나왔다.

공개 모델을 pc에서 실행할 수 있도록 하게 한다! (이 컴퓨터 지금 롤도 제대로 안돌아간다는 걸 감안하면 아주 잘되는 중이다)

물론 환경세팅도 필요하다. 라마3을 쓰려면 최소 8G램이 필요하다고...

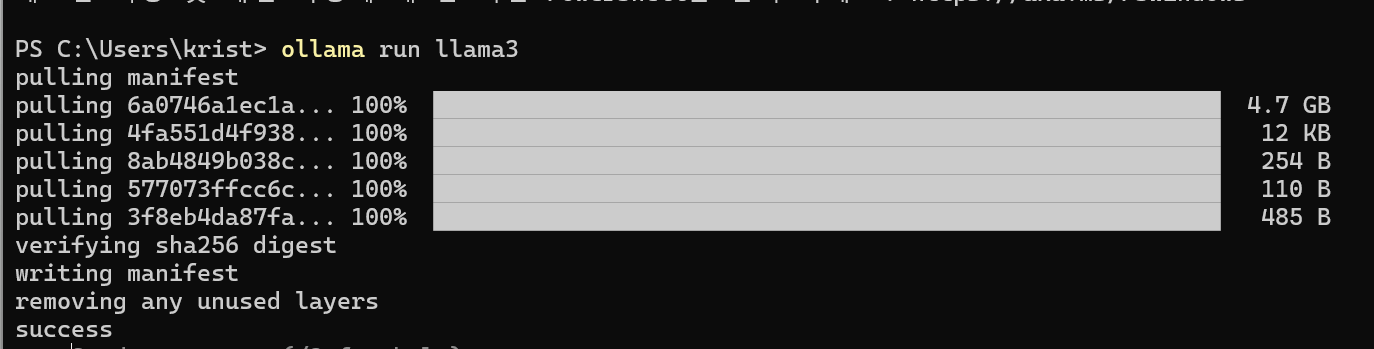

ollama 홈페이지에 들어가서 다운로드를 받은 다음, ollama run llama3으로 모델을 실행시킨다.

이렇게 하면 기존의 8B모델을 기본적으로 받아오게 된다. 모델이 더 커질수록 더 많은 램을 요구하니 주의.

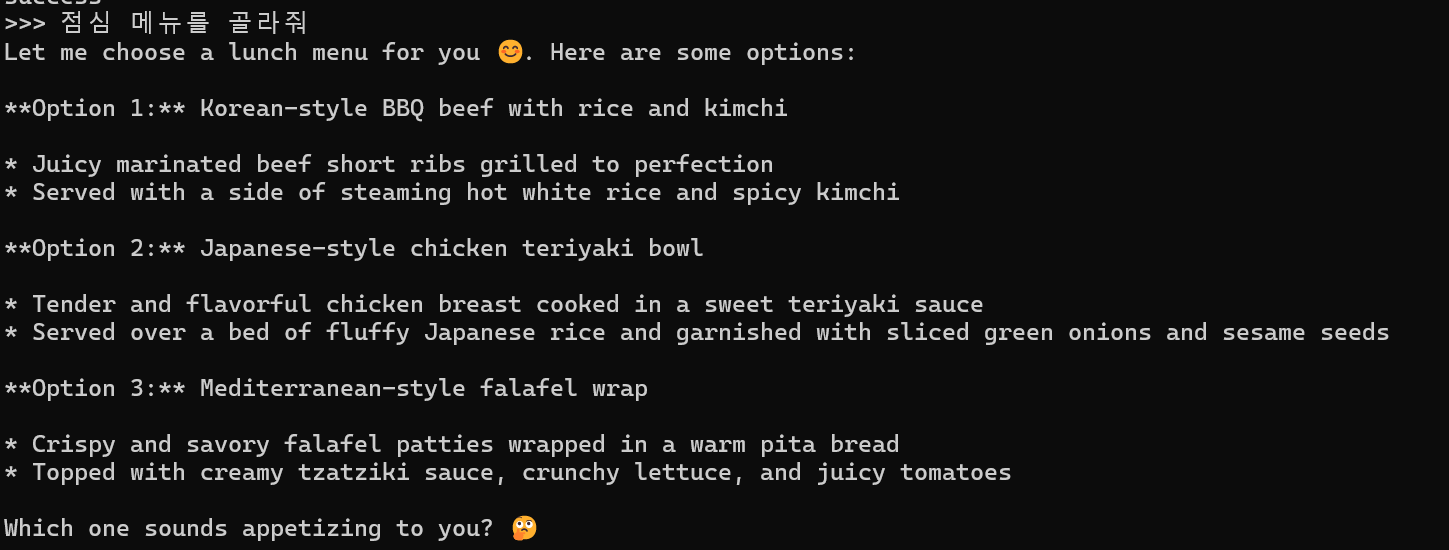

일단 테스트겸 간단한 프롬프트를 실행시켜보았다. 기본적으로 프로그램 자체에 멀티턴 / 챗봇 인퍼런스 기능이 들어가 있는 것 같다.

Langchain

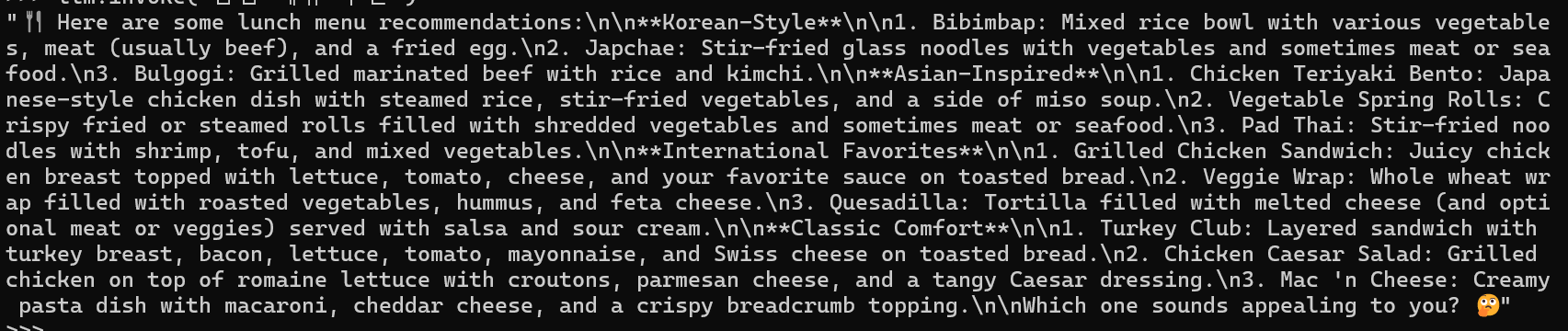

랭체인에 이미 ollama관련 파이썬 패키지가 제공되어 있다. 일단 오늘은 단순 인퍼런스만 시켜보는걸로.

from langchain_community.llms import Ollama

llm = Ollama(model="llama3")

llm.invoke("점심 메뉴를 골라줘")

아까랑 포맷이 다른 것을 볼 수 있는데, 아까 프로그램 같은 경우 말했듯 챗봇 인퍼런스 기능이 들어가 있는 것으로 생각된다. 그에 비해 지금 인퍼런스 모델은 랭체인 LLM 클래스에 속해 있는데, 이는 다른 모델의 model.generate와 다르지 않다. 이에 비해 챗봇 기능을 할 수 있는 모델은 ChatOllama를 선택하면 된다.

from langchain_community.chat_models import ChatOllama

llm = ChatOllama(model="llama3")

llm.invoke("점심 메뉴를 골라줘")

다음 글 언제 올라오나요~~