퍼셉트론, MLP, 오차역전파, 활성화 함수

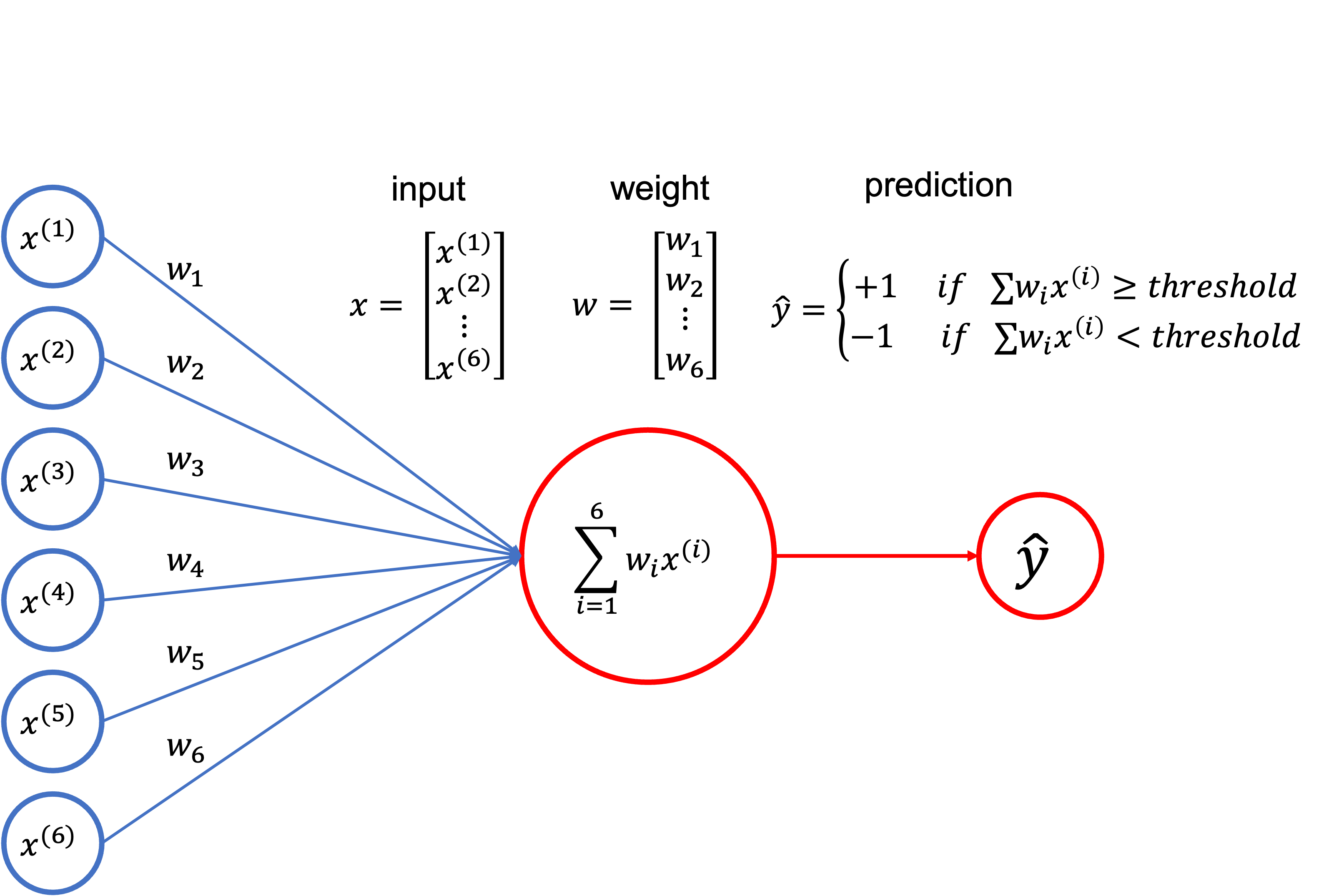

퍼셉트론

퍼셉트론은 인공 신경망의 한 종류로, 이진 분류기를 만드는 알고리즘

프랑크 로젠블라트가 1957년에 처음 고안하

퍼셉트론은 입력과 가중치를 곱한 값의 합을 특정 임계값과 비교하여 결과를 출력하는 방식으로 동작

이 과정에서, 가중치는 초기에 무작위로 설정

학습 데이터에 따라 가중치를 조정하면서 최적의 값을 찾아감

이진 분류기로서의 퍼셉트론은 간단하고 빠르며,

선형적으로 분리 가능한 데이터를 분류 가능

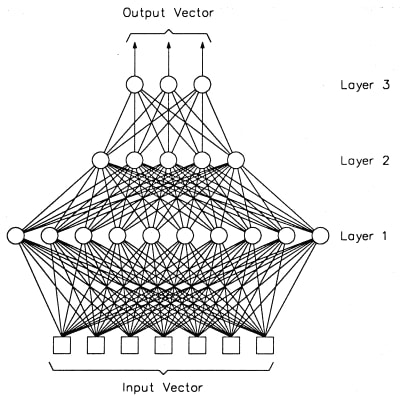

MLP

MLP(Multi-Layer Perceptron)은 인공 신경망의 대표적인 모델 중 하나

MLP는 퍼셉트론의 단점인 선형적인 분류만 가능하다는 한계를 극복하기 위해 여러 개의 층(layer)을 쌓아서 비선형적인 분류를 수행

MLP는

- 입력층(input layer)

- 은닉층(hidden layer)

- 출력층(output layer)

각 층은 여러 개의 뉴런(neuron)으로 구성

각 뉴런은 이전 층의 모든 뉴런과 연결되어 있으며,

가중치를 곱한 값의 합을 활성화 함수(activation function)에 넣어서 출력값을 계산

MLP는 다층 퍼셉트론(Multi-Layer Perceptron)의 약자로,

다층으로 구성된 신경망을 의미

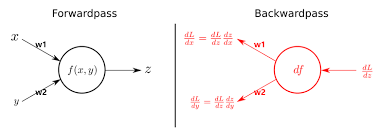

오차역전파

오차역전파(Backpropagation)는 MLP에서 가중치를 학습하는 알고리즘

MLP의 출력값과 실제값의 오차를 이용하여 출력층에서부터 입력층으로 거꾸로 오차를 전파시켜가며 각 층의 가중치를 조정

이 때, 역전파 알고리즘을 이용하여 가중치를 조정하는데,

이는 출력층에서부터 역방향으로 오차를 전파시키면서 가중치를 갱신하는 과정을 반복

활성화 함수의 미분 값을 이용하여 각 층에서의 오차 기여도를 계산

이를 이전 층으로 전파시켜 나가며 가중치를 조정

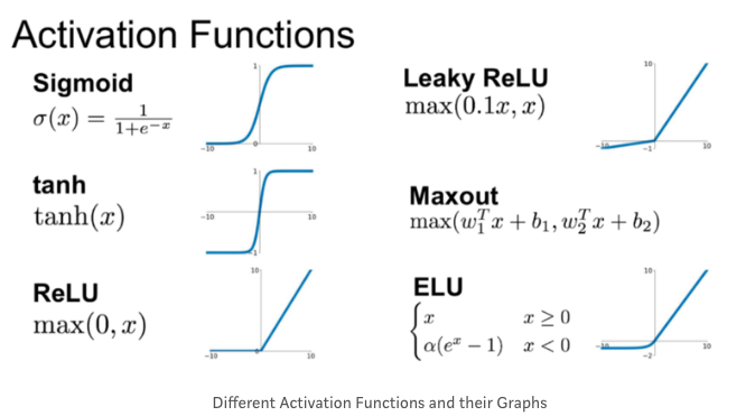

활성화 함수

활성화 함수(Activation function)는 인공 신경망에서 입력값을 처리하여 출력값을 결정하는 함수

활성화 함수는 인공 신경망의 학습 능력과 성능에 큰 영향을 미침

대표적인 활성화 함수로는

- 시그모이드 함수

- ReLU(Rectified Linear Unit) 함수

- tanh 함수

시그모이드 함수는 S자 형태의 곡선을 가지며,

입력값이 크면 1에 가까운 값을 출력하고 작으면 0에 가까운 값을 출력

ReLU 함수는 입력값이 0보다 작으면 0을 출력하고,

0보다 크면 그 값을 그대로 출력

tanh 함수는 시그모이드 함수와 비슷한 형태를 가지며,

입력값이 크면 1에 가까운 값을 출력하고 작으면 -1에 가까운 값을 출력

활성화 함수는 인공 신경망에서 학습을 할 때,

출력값과 실제값의 오차를 계산하여 오차를 최소화하는 방향으로 가중치를 조정

활성화 함수는 이러한 학습 과정에서 출력값을 비선형적으로 만들어줌으로써,

인공 신경망이 복잡한 비선형 관계를 학습할 수 있도록 도움

When you believe in a thing, believe in it all the way, implicitly and unquestionable.

Walt Disney

네가 무언가를 믿을 때, 온 힘을 다해, 무조건적으로 그리고 여지없이 그것을 믿어라.

월트 디즈니