출처: https://www.boostcourse.org/ai212/lecture/41157

Lec 01: 기본적인 Machine Learning 의 용어와 개념 설명

- 명시적 프로그램explicit programming의 한계

- 스팸메일 분류: 규칙이 많다

- 자율주행: 규칙이 너무 많다

- 아서 사뮤엘Arthur Samuel (1959) "컴퓨터에게 학습할 능력을 주자"

-

학습방법에 따른 분류

- 지도학습supervised learning: 라벨링이 완료된 데이터(training set)로 학습

- 비지도학습unsupervised learning: 일일이 라벨링할 수 없는 데이터 ex. 구글 뉴스 그루핑

-

지도학습의 분류

- regression(회귀) ex. 공부시간에 따른 시험성적 예상

- binary classification(이진 분류) ex. 공부시간에 따른 pass/fail 판단

- multi-label classification(멀티 레이블 분류) ex. 공부시간에 따른 성적 판단(A, B, C, ..., F)

Lec 02: Simple Linear Regression 선형회귀 기초

-

프랜시스 갤튼 경Sir Francis Galton (1822~1911) "통계는 평균으로 돌아가는 특징이 있다 Regression toward the mean"

-

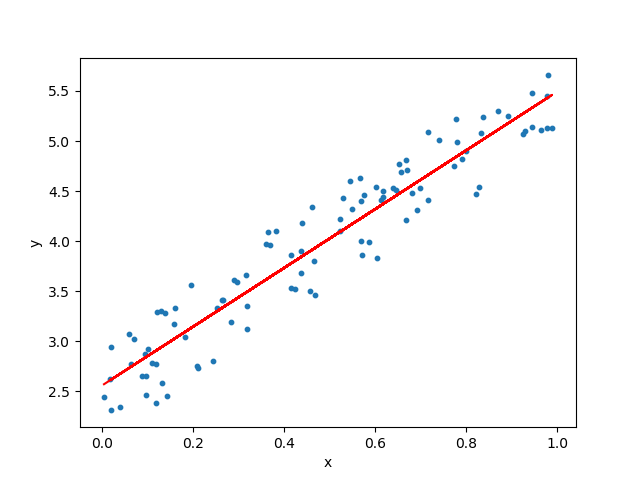

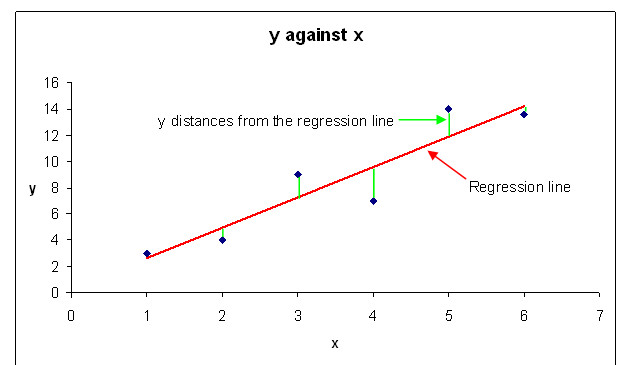

선형 회귀 Linear Regression: y=ax+b 형태로, 데이터를 가장 잘 대변하는 직선의 방정식을 찾는 것

-

가설 Hypothesis:

- W(weight): 기울기 => 가중치

- b(bias): 절편 => 편향

-

어떤 그래프가 데이터를 가장 잘 나타내는지 판단하려면?

- 비용이 작으면 작을수록 가설이 데이터를 잘 대변한다(represent)고 할 수 있다.

- 비용이란?

- cost, loss, error

-

- 즉, 가설과 실제 데이터와의 차이/거리(distance, difference)

- 비용을 계산하는 방법: 비용 함수(Cost function)

- 값은 양수일 수도 음수일 수도 있기 때문에 제곱하여 합한 값을 사용

- 비용함수 1: 표시를 간단하게 하기 위해 편향(b) 생략

- 비용함수 2: 기본 형태

-

목표: 비용을 최소화하는 W와 b를 찾는 것

글 잘 봤습니다.