2주차 화요일

- 경사 하강법 (순한맛)

- 경사 하강법 (매운맛)

📉[경사 하강법 (순한맛)]

- 미분

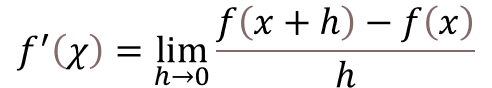

변수의 움직임에 따른 함수값의 변화를 측정하기 위한 도구.

특정 지점에서 함수의 순간변화율 (접선의 기울기)라고 표현할 수도 있다.

*파이썬에서는sympy모듈의diff()함수를 사용해서 미분할 수 있다.

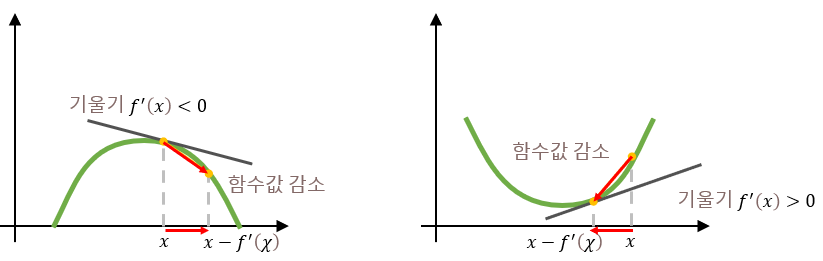

특정 지점에서 접선의 기울기를 알면 함수값 f(x)를 증가/감소시키기 위해 x값을 어느 쪽으로 옮겨야 하는지 알 수 있게 된다.

해당 지점에서의 미분값이 음수든 양수든 상관없이 미분값을 빼 주면 (f(x-f'(x))) 함수값이 감소하고, 미분값을 더해 주면 (f(x+f'(x))) 함수값이 증가한다.

(함수의 오목/볼록한 모양 때문에 그렇다)

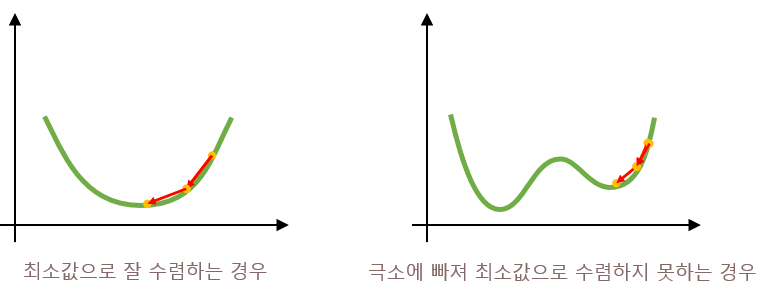

미분값을 조금씩 더하거나 빼서 함수의 극값을 찾는 방법을 경사 상승법 / 경사 하강법이라고 부른다. 머신러닝에서는 손실 함수(=오차 함수, 비용 함수)의 최소값을 찾기 위해 경사 하강법을 적용한다. 그런데 경사 하강법만 적용할 경우 최소값이 아닌 극소(local minima)에 빠질 수 있기 때문에 실제로는 좀더 보완된 방법을 사용한다.

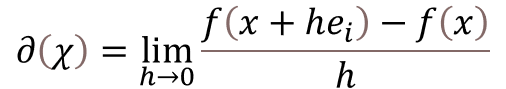

- 편미분

입력이 x 하나인 일변수 함수는 2차원 xy 그래프 위에 그릴 수 있지만, 벡터(원소가 많다)를 입력으로 받는 다변수 함수의 그래프는 n차원 공간 상에 그려진다. 그런데 이걸 그냥 미분하면 x값을 옮길 수 있는 방향이 너무 많다. 다변수 함수의 각 변수를 대상으로, 다른 변수는 상수 취급하고 그 자신에 대해서만 미분하는 것(각 변수의 변화율을 따로따로 구하는 것)을 편미분이라고 한다.

- gradient 벡터 ∇f

다변수 함수 f의 각 변수에 대해 편미분한 것을 벡터로 모아 놓은 걸 gradient 벡터라고 부르고, ∇와 같이 표기한다. 델 또는 nabla라고 읽는다.

그래디언트 벡터는 다변수 함수의 그래프에서 순간변화율이 가장 빠른(가장 가파른) 방향을 나타낸다.

일변수함수 y = ax의 선형 회귀에 경사 하강법을 적용할 때는 다음과 같은 과정을 거친다.

beta = init # 초기값을 지정

grad = gradient(beta) # 미분값 계산하는 함수

while abs(grad) > eps: # eps : 입실론(기울기가 이 값 이하로 내려가면 반복 중단)

beta = beta - lr * grad # lr : learning rate, beta를 업데이트하기 위한 '보폭' 을 결정

grad = gradient(beta)📉[경사 하강법 (매운맛)]

다변수함수의 선형 회귀에 경사 하강법을 적용해 보자.

y = Xβ (y, β는 벡터, X는 행렬)

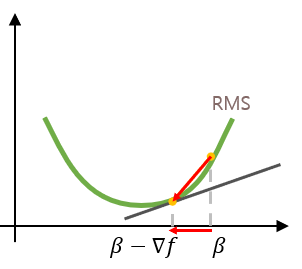

손실 함수는 입력으로 주어지는 모든 x들과 y 사이의 거리 ||y - Xβ||2 (Root Mean Square)이다.

X와 y는 고정 입력/출력으로 주어지기 때문에, 손실 함수값이 줄어들도록 손댈 수 있는 변수는 β다.

따라서, 손실 함수가 최소가 되도록 하는 β를 구하기 위해서 다음과 같은 과정을 거친다.

(업데이트해야 할 변수가 β다)

beta = [init] # 다변수함수라 하나의 입력 x가 벡터, beta도 벡터

for i in range(T): # T:반복횟수 (종료조건을 이렇게 할 수도 있다)

error = y - X @ beta # X는 행렬, beta는 벡터라 행렬곱 계산

grad = -transpose(X) @ error # X^T에 error를 곱해주면 gradient

beta = beta - lr * grad # grad를 빼는 이유는?

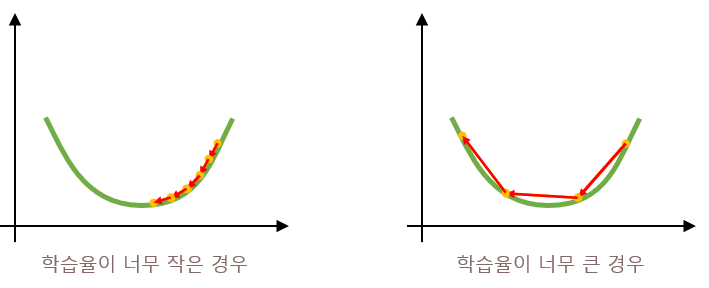

# 위의 그래프처럼 β값을 옮겨 함수값을 감소시키기 위해서.처음에는 기울기 β를 임의의 벡터로 정해 놓고 손실 함수(오차)를 계산한다. 손실 함수가 작아지는 방향으로 β를 업데이트하기 위해 β에서 gradient * lr를 빼 준다. lr란 학습율(learning rate)로, β 업데이트의 '보폭'을 결정한다. 보폭이 너무 크면 극소로 수렴하지 않고, 보폭이 너무 작으면 시간이 오래 걸린다.

- 확률적 경사 하강법 (Stochastic Gradient Descent)

경사 하강법은 좋은 도구지만 손실 함수가 볼록한 모양이 아니라 W 형태처럼 최소가 아닌 극소값이 있는 경우에는 최소값으로 수렴하지 않고 극소(local minima)에 빠질 위험이 있다. 그럴 때는 모든 데이터를 이용해 β를 업데이트하는 기존 경사 하강법 대신 확률적 경사 하강법을 사용한다.

확률적 경사 하강법을 사용하면 일부 데이터만 사용해서 gradient를 구하고, 그걸 이용해서 β를 업데이트한다. 일부 데이터만 사용하고 평균을 냈기 때문에 손실함수 그래프가 모든 데이터를 사용했을 때와 약간 달라진다고 한다. 그렇기 떄문에 경사 하강법에서 구한 gradient 0인 지점이 확률적 경사 하강법에서는 gradient 0이 아닐 수 있게 된다. 이를 이용하면 극소에서 탈출할 수가 있다.

그 밖에도 adagrad, momentum, adam 등 경사 하강법의 단점을 보완하기 위한 방법들이 많이 있다.

👨👩👧👦[피어 세션]

강의에서 이해가 잘 되지 않는 부분을 서로 이야기하며 다시 생각해 보는 시간을 가졌다. 다변수함수에 경사 하강법을 적용할 때 y, β가 벡터고 X가 행렬이라는 것을 미처 생각하지 못해서 매우 헷갈렸는데, 팀원들의 설명을 듣기도 하고 내가 설명할 수 있는 부분을 설명하기도 하면서 좀 더 제대로 이해하게 되었다.

그리고 향후 과제 등이 나오면 팀 내에서 코드 리뷰를 하기 위해서 우리 팀의 Github 레포지토리를 따로 만들었다.