papers

1.[논문리뷰] Attention Is All You Need

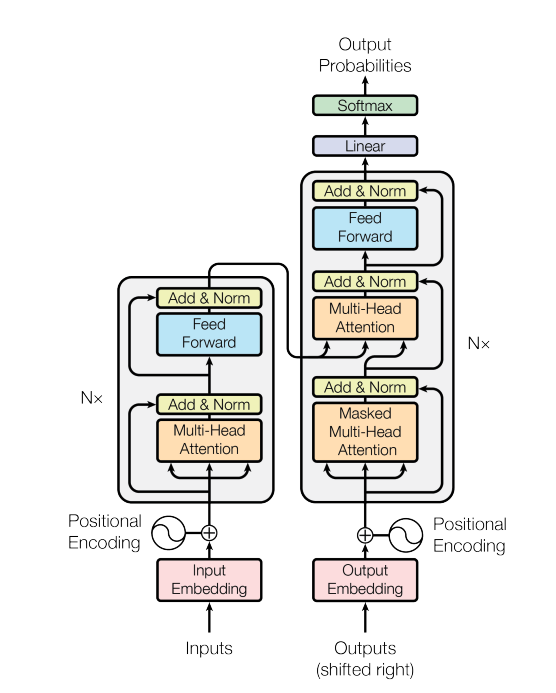

처음으로 하는 논문 리뷰! 선택한 논문은 Attention Is All You Need이다. 현재 NLP분야에서 최고존엄인 BERT모델이 이 논문에서 제안한 Transformer 아키텍쳐의 Encoder를 바탕으로 하고 있다. Transformer는 RNN과 CNN을

2022년 3월 9일

2.XLNet

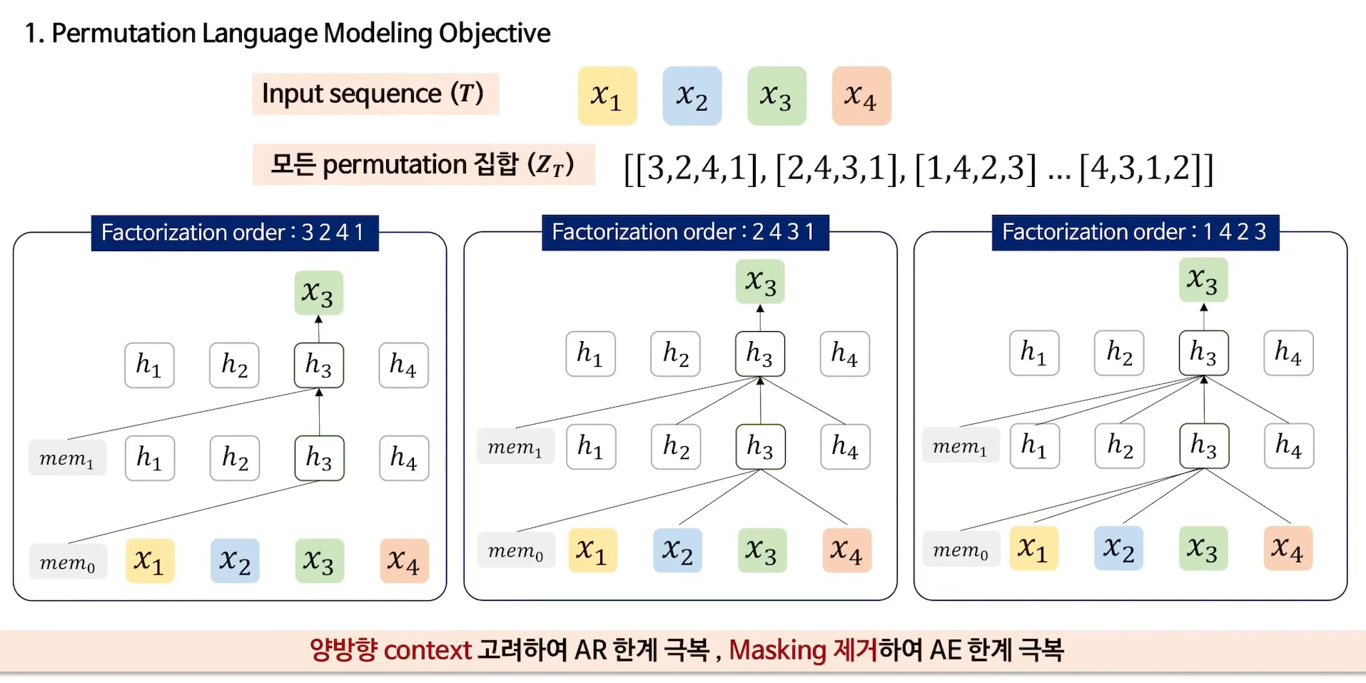

XLNet BERT + GPT AE(Auto Encoder) + AR(Auto Regressive) Factorizationorder고려하여 양방향 학습 AR formula를 통해 BERT한계 극복 Auto Encodeing과 Auto Regressive XLNe

2022년 4월 7일