활성화 함수란

딥러닝에서 사용하는 인공신경망들은 일반적으로 이전 레이어로부터 값을 입력받아 "어떠한 함수"를 통과시킨 후 그 결과를 다음 레이어로 출력한다.

이때 "어떠한 함수" 즉 인공신경망의 은닉층에 사용되는 함수를 활성화 함수라고 한다.

비선형 활성화 함수가 일반적으로 사용된다.

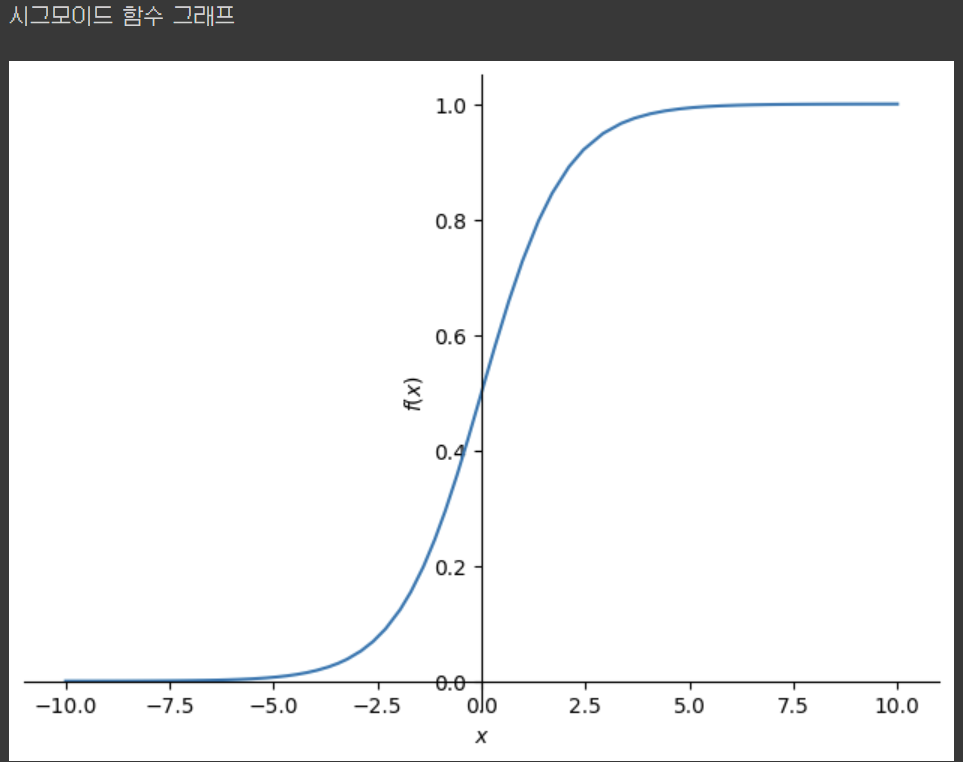

시그모이드 함수 (Sigmoid function)

시그모이드(Sigmoid) 함수는 딥러닝에서 널리 사용되는 활성화 함수 중 하나입니다. 이 함수는 0과 1 사이의 값을 출력하며, 입력값을 확률로 변환하는 데에 사용됩니다.

특징

- 출력값이 0과 1 사이이다.

- 출력값의 중심이 1/2이다.

- 입력값이 커질수록 출력값은 1에 가까워지고, 입력값이 작아질수록 출력값은 0에 가까워진다.

- 입력값이 커질수록/작아질수록 기울기는 0에 가까워진다.

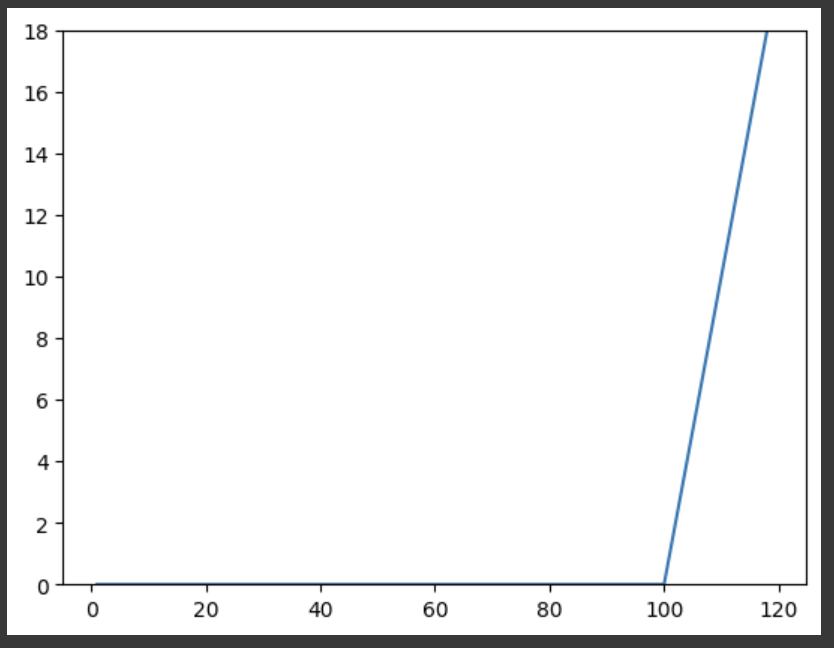

소프트맥스 함수 (Softmax Function)

소프트맥스 함수는 시그모이드 함수를 일반화하여 얻을 수 있다.

소프트맥스 함수는 딥러닝에서 가장 일반적으로 사용되는 활성화 함수 중 하나입니다. 소프트맥스 함수는 입력된 벡터의 각 요소를 0과 1 사이의 확률값으로 변환해주는 함수입니다.

특징

- 출력값이 0과 1사이이다.

- 출력값의 총합이 1이다.

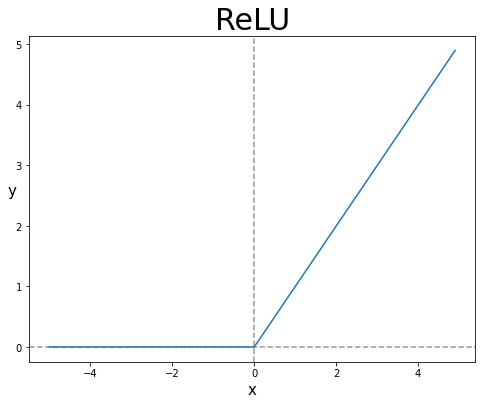

ReLU 함수 (Rectified Linear Unit function)

특징

- 입력값이 0보다 작으면 출력값은 0이 되고, 입력값이 0보다 크면 출력값은 x가 됩니다.

- 입력값이 0보다 작으면 기울기는 0이고, 입력값이 0보다 크면 기울기는 1이다.