확률론 맛보기

이번 강에서는 확률론에 대하여 학습을 진행했다. 딥러닝은 확률론 기반의 기계학습 이론에 바탕을 두고 있기 때문에, 딥러닝을 공부하기 위해서 확률론에 대한 기초를 다지는 것은 필수이다. 이번 강의를 통해서 확률론에 대한 기초를 완벽히 다지기 위해 노력했다.

00. 공부 내용

- 딥러닝에서의 확률론의 활용에 대하여 공부

- 확률분포에 대하여 공부

- 머신러닝에서의 조건부확률의 활용에 대하여 공부

- 몬테카를로 샘플링에 대하여 공부

01. 딥러닝에서의 확률론

- 예측이 틀릴 위험을 최소화 하도록 데이터를 학습하는 것이 기계학습의 기본 원리이다.

- 머신러닝은 Loss Function을 이용하여 위험을 최소화 하는 방향으로, 데이터를 바탕으로, 학습을 진행한다.

- 회귀에서는 L2-norm을 손실함수로 사용하며, 본 손실함수는 예측오차의 분산을 가장 최소화하는 방향으로 학습이 진행된다.

- 분류에서는 Cross-Entropy을 손실함수로 사용하며, 본 손실함수는 모델 예측의 불확실성을 최소화하는 방향으로 학습이 진행된다.

- 따라서 분산 및 불확실성을 최소화하기 위해서는 '측정하는 방법'을 알야하는데, 이 대상을 측정하는 방법이 바로 통계학에서 제공되므로 우리는 기계학습을 이해하기 위해서 확률론의 기본개념을 알아야 한다.

02. 확률분포

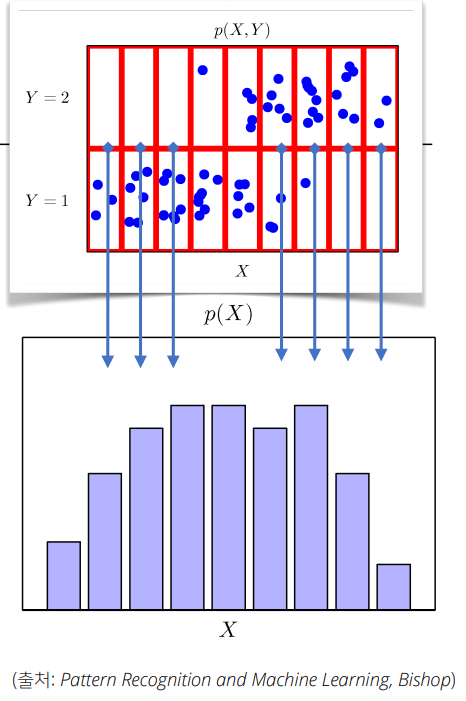

- 위와 같이 확률분포는 데이터의 초상화라고 할 수 있다.

- 즉, 우리는 확률분포를 알 수 있다면 새로운 데이터가 주어졌을 때 본 데이터가 어떤 클래스에 위치하는 지를 추론할 수 있게 된다.

- 따라서 우리는 주어진 데이터를 바탕으로 확률분포를 모델링을 해야하며, 확률변수에 따라 모델링의 식이 달라지게 된다.

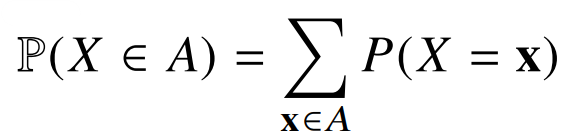

- 확률분포가 위와 같은 형태를 이룬다면, 이산형 확률변수로 확률변수가 가질 수 있는 경우의 수를 모두 고려한 확률은 더해서 모델링을 하게된다.

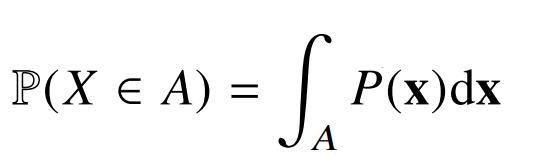

- 확률분포가 위와 같은 형태를 이룬다면, 연속형 확률변수로 데이터 공간에 정의된 확률변수의 밀도 위에 서의 적분을 통해 모델링을 하게 된다.

03. 머신러닝에서의 조건부 확률

- 우리 앞서 주어진 데이터를 바탕으로 확률분포를 모델링하여 어떠한 데이터가 주어졌을 때, 본 데이터가 속할 클래스의 확률을 구한다고 했다.

- 이처럼 어떠한 데이터 X가 주어졌을 때 y의 확률은 구하는 것이 바로 조건부 확률이다.

- 즉, 우리는 확률 분포를 모델링하고 확률 분포를 가지고 조건부 확률을 구해 예측을 한다고 보면 된다.

- 위의 조건부 확률 식은 입력변수 x에 대하여 정답이 y일 확률을 의미한다.

- 로지스틱 회귀에서 사용했던 선형모델과 소프트맥스 함수의 결합은 데이터에서 추출된 패턴을 기반으로 확률을 해석하는데 사용된다.

- 즉, 분류(회귀) 문제 모두 손실함수를 바탕으로 데이터의 패턴을 추출하고, 데이터 x로부터 추출된 특징패턴과 가중치행렬을 통해 조건부확률(기대값)을 계산(추정)하는 것이다.

- 여기서 딥러닝은 다층신경망을 사용하여 데이터로부터 특징패턴을 추출하게 되는 것이다.(모델과 기계학습 문제에 따라서 특징 패턴을 학습하기 위한 손실함수가 달라짐)

04. 몬테카를로 샘플링

- 확률분포가 주어진다면 우리는 여러 통계적 범함수를 계산할 수 있다.(평균(기대값), 분산, 첨도, 공분산등)

- 그런데 기계학습의 많은 문제들은 이러한 확률분포를 명시적으로 모를때가 대부분이다.

- 확률분포를 모를 때(확률 분포의 형태) 데이터를 이용하여 기대값을 계산하는 방법이 바로 몬테카를로 샘플링 방법이다.(획률 변수가 이산형이든 연속형이든 상관없이 성립)

- 예를 들어 우리가 함수식의 넓이를 구한다고 가정했을 때, 해당 함수식을 매우 잘게 쪼개서 쪼개진 선을 모두 더하면 그 넓이는 함수식의 넓이와 동일할 것이다. 그런데 몬테카를로 샘플링 방식은 정해진 샘플링의 수 만큼 데이터를 뽑아서 본 데이터의 넓이를 구하고, 그 데이터의 평균 값을 구하는 과정을 정해진 반복 만큼 수행한 후, 전체 반복으로 구해진 데이터의 평균과 분산을 구했을 때 그 값이 실제 함수의 참 값과 비슷하더라 이다. 따라서 몬테카를로 샘플링을 직관적으로 설명한다면, 함수식을 쪼개는 과정을 샘플링 만큼만 수행하는데, 수행한 샘플링의 반복이 모인다면, 그 값이 실제 참 값과 유사해지는 방식이라고 볼 수 있다.