공짜 점심 없음 이론(NFL)

데이터에 관해 완벽하게 어떤 가정도 하지 않으면 한 모델을 다른 모델보다 선호할 근거가 없음

-David Wolperts-

- 세상의 모든 데이터를 포함한 완벽한 데이터셋에 대해 한 모델이 다른 모델보다 항상 더 좋다고 말할 수 없음

- 데이터에 대해 아무런 가정도 하지 않는다면, 선형 모델, 신경망 등 모든 모델의 평균적인 성능은 모두 같음

- 즉, 모든 데이터를 고려하는 것은 현실적이지 못하니 주어진 데이터에 대해 타당한 가정을 하고(이 데이터는 선형적 특성을 가졌다 등 데이터 분석을 통해), 이 데이터의 특징에 효과적인 모델을 선택하여 실험 후 성능이 뛰어난 모델을 선택하는 것이 머신러닝 실무의 목표

성능 측정 지표

RMSE(X,h)=n1∑i=1n(h(x(i))−y(i)))2

MAE(X,h)=n1∑i=1n∣h(x(i))−y(i)∣

Q) RMSE는 n1이 제곱근 내부에 존재하기 때문에 오차 제곱합 제곱근에 n1을 곱한 것이고, MAE와 스케일이 다르지 않을까? 왜 n1을 제곱근 외부에 곱하지 않을까?

A) RMSE는 통계학의 표준 편차를 모방했기 때문이다.

Var(X)=n1∑i=1n(xi−μ)2

σ(X)=Var(X)=n1∑i=1n(xi−μ)2

Q) 그럼 분산은 왜 오차 제곱합의 평균일까?

A) 데이터의 흩어진 정도를 정량화하는 지표이기 때문이다. 오차 제곱합을 데이터 개수로 나눠주지 않는다면 흩어진 정도가 같더라도 개수가 더 많은 데이터셋의 분산이 더 크게 측정되기 때문이다.

Q) 표준 편차는 왜 분산의 제곱근일까?

A) 분산을 유도하는 과정에서 제곱이 되는 과정에서 원본 데이터와 분산의 단위가 불일치하기 때문이다. 제곱근을 취함으로써 표준 편차는 원본 데이터셋의 단위와 일치하게 된다.

상관관계

Var(X)=n1∑i=1n(xi−μ)2=E[(X−E[X])2]

Cov(X,Y)=E[(X−E[X])(Y−E[Y])]=E[XY−XE[Y]−YE[X]+E[X]E[Y]]

=E[XY]−E[XE[Y]]−E[YE[X]]+E[E[X]E[Y]] (E[X], E[Y]는 상수)

=E[XY]−E[Y]E[X]−E[X]E[Y]+E[X]E[Y]

=E[XY]−E[X]E[Y]

공분산은 -1부터 1까지의 값을 가지며 1에 가까우면 강한 양의 상관관계, -1에 가까우면 강한 음의 상관관계, 0에 가까우면 선형적인 상관관계가 없다는 뜻

해석적 방법

정규 방정식

θ^=(XTX)−1XTy

∵y=Xθ⟹XTy=XTXθ⟹θ=(XTX)−1XTy

XTX의 역행렬이 존재하지 않는 경우 성립하지 않음. SVD를 통해 무어-펜로즈 역행렬을 항상 구할 수 있음

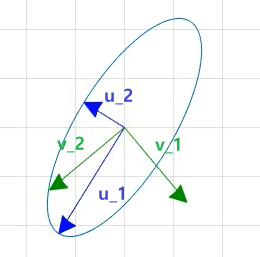

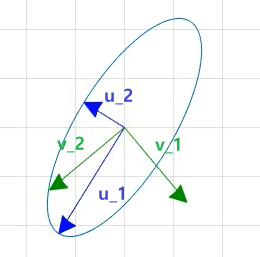

특이값 분해(SVD)

θ^=X+y

X+=VΣ+UT

X=UΣVT

U,V:orthogonal

Σ:diagonal

기본 형태는 AV=UΣ이며 V라는 orthogonal matrix에 A라는 선형 변환을 적용하고 그 결과가 여전히 orthogonal matrix인 상황 (Σ는 scaling factor)