2010 - Mikolov T, Karafiat M, Burget L, Cernocky JH, Khudanpur S. “Recurrent neural network based language model” INTERSPEECH

https://www.researchgate.net/publication/311469848_Recurrent_neural_network_based_language_model - 논문링크

논문 요약

Abstract

RNN 기반 언어 모델(RNN LM)은 기존의 n-그램 기반 백오프 언어 모델에 비해 음성 인식 작업에서 perplexity를 약 50% 줄일 수 있음을 보여줍니다. 이는 RNN이 긴 문맥 정보를 더 잘 처리할 수 있기 때문입니다. 여러 개의 RNN LM을 혼합하여 사용하면 단일 모델보다 더 나은 성능을 달성할 수 있습니다.

Preplexity란?

- Perplexity는 언어 모델의 성능을 평가하는 지표로, 모델이 테스트 데이터의 단어 시퀀스를 얼마나 잘 예측하는지를 나타냅니다. 낮은 perplexity 값은 모델이 다음 단어를 더 정확하게 예측할 수 있음을 의미합니다.

언어 모델 기반 RNN (RNN LM)란?

- RNN LM은 입력 시퀀스의 각 단어를 순차적으로 처리하며, 이전 모든 단어의 정보를 은닉 상태(hidden state)에 저장합니다. 이를 통해 긴 문맥 정보를 고려하여 다음 단어를 예측할 수 있습니다.

- 여러 개의 RNN LM을 혼합하여 사용함으로써 단일 모델보다 더 좋은 성능을 낼 수 있습니다. 이는 각 모델이 다른 방식으로 문맥 정보를 처리하기 때문에, 여러 모델의 예측을 결합하면 더 정확한 예측을 할 수 있습니다.

n-그램 모델이란?

- n-그램 모델은 단어의 연속적인 조합을 사용하여 다음 단어를 예측합니다.

- 예를 들어, 3-그램 모델은 현재 단어가 앞의 두 단어를 기반으로 예측됩니다. 즉, "I am a"라는 문맥이 주어지면 다음 단어를 예측하기 위해 "I am"을 참조합니다.

백오프(Backoff) 전략이란?

- 백오프(Backoff)는 n-그램 모델에서 낮은 빈도로 발생하는 n-그램을 처리하는 전략입니다.

- 예를 들어, 3-그램 "I am a"가 훈련 데이터에 거의 나타나지 않는다면, 백오프 전략을 사용하여 2-그램 "am a" 또는 1-그램 "a"를 참조합니다. 이는 데이터 희소성 문제를 완화합니다.

질문

- 단어가 훈련 데이터에 나타나지 않아서 하나씩 감소(?)하는데, I am a에서 나타나지 않으면, am a, 여기서도 나타나지 않으면 a를 참고해서 단어가 나오게함. 근데, a 다음에 오는 단어를 결국에 하면, 나올 수는 있어도, 문맥상 좀 다르게 나올 수도 있지 않을까?

1. Introduction

순차 데이터 예측은 언어 모델링의 중요한 문제이며, n-그램 모델은 고정된 길이의 문맥만을 사용하여 긴 문맥 정보를 충분히 반영하지 못합니다. 캐시 모델과 클래스 기반 모델이 이를 개선하기 위해 도입되었지만, 실제 적용에서의 어려움이 여전히 존재합니다. 본 연구는 순환 신경망을 사용하여 이러한 한계를 극복하고자 합니다.

캐시 모델(Cache Model)이란?

- 캐시 모델은 언어 모델에서 최근에 등장한 단어들을 기억하여 다음 단어를 예측하는 데 사용하는 기술입니다. 이는 문맥 정보를 단기적으로 저장하고 활용하여 예측 성능을 향상시킵니다.

작동 방식: - 예를 들어, "The cat sits on the"라는 문장이 주어졌을 때, 캐시 모델은 최근에 등장한 단어 "cat", "sits", "on"을 기억합니다.

- 다음 단어를 예측할 때, 캐시에 저장된 단어들이 자주 등장하는 단어 목록에 포함되면 그 단어들의 예측 확률을 높입니다.

- "The cat sits on the mat"에서 "mat"는 이전 문맥에서 자주 등장했으므로 높은 확률로 예측됩니다.

클래스 기반 모델(Class-based Model)이란?

- 클래스 기반 모델은 단어들을 클래스(또는 카테고리)로 그룹화하여 모델링하는 방법입니다. 이를 통해 유사한 단어들 간의 매개변수를 공유함으로써 모델의 복잡도를 줄이고 학습 효율을 높입니다.

작동 방식: - 예를 들어, "dog", "cat", "wolf"와 같은 단어들은 모두 "동물" 클래스에 속할 수 있습니다.

- 문장에서 "The dog barks" 다음에 "animal" 클래스의 단어가 등장할 확률을 예측합니다.

- "The dog barks and the cat meows"에서 "cat"은 "dog"와 같은 "animal" 클래스에 속하므로 높은 확률로 예측됩니다.

이 두 모델은 n-그램 모델의 한계를 보완하기 위해 사용되며, 각각의 특징을 통해 언어 모델의 예측 성능을 향상시킵니다.

2. Model Description

순환 신경망(RNN) 을 사용한 언어 모델의 구조와 학습 방법에 대해 설명합니다. 기존의 n-그램 모델은 고정된 길이의 문맥만을 고려하므로, 긴 문맥 정보를 효과적으로 처리하지 못하는 한계가 있습니다. 이를 극복하기 위해 RNN을 도입하여, 이전의 상태 정보를 현재 입력과 함께 사용함으로써 시퀀스 데이터의 종속성을 학습할 수 있습니다.

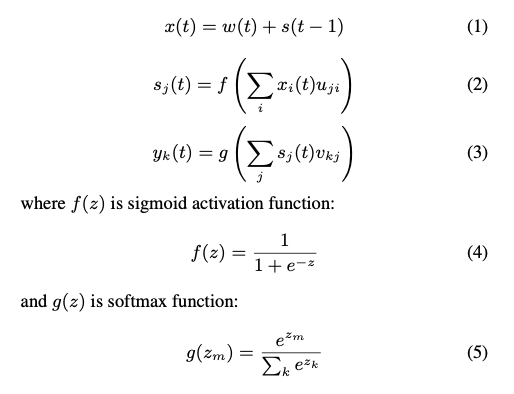

논문에서는 Elman 네트워크라는 단순한 형태의 RNN을 사용했습니다. 이 네트워크는 입력 층, 은닉 층(또는 컨텍스트 층), 출력 층으로 구성되며, 입력 벡터는 현재 단어와 이전 시간의 은닉 상태를 결합하여 형성됩니다. 은닉 층 상태와 출력은 각각 시그모이드 함수와 소프트맥스 함수를 사용하여 계산됩니다.

네트워크는 여러 에포크에 걸쳐 훈련됩니다. 훈련 데이터는 순차적으로 네트워크에 제공되며, 가중치는 작은 값으로 초기화되고 표준 역전파 알고리즘과 확률적 경사 하강법을 사용하여 업데이트됩니다. 학습률은 초기에는 0.1로 설정되며, 에포크마다 검증 데이터의 로그 가능도가 증가하지 않으면 절반으로 줄어듭니다.

또한, 테스트 단계에서도 모델이 학습을 계속하도록 설계된 동적 모델을 도입했습니다. 동적 모델은 캐시 모델과 유사하지만, 연속 공간에서 학습되므로 테스트 데이터에서 자주 등장하는 단어의 확률을 높이는 데 도움이 됩니다. RNN은 피드포워드 신경망과 달리 은닉 층의 크기만 선택하면 되므로, 조정해야 하는 매개변수의 양이 적다는 장점이 있습니다.

3. WSJ Experiments

Wall Street Journal (WSJ) 데이터를 사용하여 RNN 언어 모델의 성능을 평가하는 내용을 다룹니다.

실험에서는 DARPA WSJ'92와 WSJ'93 데이터 세트의 100-베스트 리스트를 다시 점수화하는 방식을 사용했습니다. 훈련 데이터로는 English Gigaword의 NYT 섹션에서 수집한 3700만 개의 단어를 사용했으며, RNN 모델 훈련에는 640만 개의 단어(300,000 문장)까지만 사용했습니다. 다양한 RNN 모델 구성과 Kneser-Ney 평활화된 5-그램(KN5) 모델을 기본 모델로 사용하여 성능을 비교했습니다.

실험 결과, RNN 모델은 n-그램 모델에 비해 현저히 낮은 perplexity를 기록했습니다. 3개의 동적 RNN 모델을 혼합한 경우, KN5 모델에 비해 약 18%의 단어 오류율(WER) 감소를 보였습니다. 실험 결과는 WSJ 작업에서 언어 모델링 기술을 변경함으로써 얻을 수 있는 가장 큰 개선 중 하나를 나타냅니다.

훈련 데이터가 증가할수록 성능 개선 폭이 커졌으며, 더 많은 데이터를 사용할 경우 더 큰 개선이 가능할 것으로 예상됩니다. RNN 모델은 n-그램 모델에 비해 훨씬 적은 데이터로도 우수한 성능을 보였으며, 이는 언어 모델링이 단순히 n-그램을 세는 것 이상이라는 점을 보여줍니다.

4. NIST RTO5 Experiments

NIST RT05 평가 데이터를 사용하여 RNN 언어 모델의 성능을 평가하는 내용을 다룹니다.

실험에서는 NIST RT05 평가 데이터의 독립 헤드셋 조건에서 테스트가 진행되었습니다. 음향 모델은 MPE 기준을 사용하여 차별적으로 훈련된 HMM을 사용했습니다. 피처 추출에는 13개의 Mel-PLP 피처와 델타, 더블 델타, 트리플 델타가 사용되었으며, HLDA를 통해 39차원 피처 벡터로 축소되었습니다. 언어 모델 훈련에는 5.4M 단어만 사용되었으며, 이는 RT05와 RT09 언어 모델에서 사용된 데이터보다 훨씬 적은 양입니다.

실험 결과, 5.4M 단어로 훈련된 RNN 모델은 훨씬 더 많은 데이터로 훈련된 큰 백오프 모델보다 우수한 성능을 보였습니다. 특히, 혼합된 동적 및 정적 RNN 모델을 사용했을 때 가장 낮은 퍼플렉서티를 기록했습니다. RNN 모델은 백오프 모델에 비해 적은 데이터로도 우수한 성능을 보여주었으며, 이는 언어 모델링이 단순히 n-그램을 세는 것 이상이라는 점을 입증합니다. 실험 결과는 RNN 모델이 다양한 도메인에 적응할 수 있는 능력을 가지고 있음을 시사합니다.

5. Conclusion and Future Work

RNN 기반 언어 모델이 기존의 백오프 모델에 비해 뛰어난 성능을 보인다는 점을 강조합니다.

WSJ 실험에서 RNN 모델은 동일한 데이터 양으로 훈련된 기존 모델에 비해 단어 오류율을 약 18% 감소시켰으며, 백오프 모델보다 5배 더 많은 데이터로 훈련된 경우에도 약 12%의 단어 오류율 감소를 달성했습니다. NIST RT05 실험에서도 RNN 모델은 적은 양의 데이터로도 대규모 백오프 모델보다 우수한 성능을 보였습니다. 이는 언어 모델링이 단순히 n-그램을 세는 것 이상이라는 점을 입증합니다.

미래 작업에서는 시간 역전파 알고리즘(BPTT)을 통한 추가적인 개선 가능성을 탐구할 계획입니다. 또한, RNN 모델을 다양한 애플리케이션에 적용하여 언어 모델링, 기계 학습, 데이터 압축 및 인지 과학 연구 간의 연결을 더욱 깊이 이해하고자 합니다. 온라인 학습의 중요성도 강조되며, 이는 모델이 새로운 정보를 습득하고 적응할 수 있게 하는 자연스러운 방법입니다.