2014 - I. Sutskever, O. Vinyals, and Q. V. Le “Sequence to Sequence Learning with Neural Networks” in NIPS

https://arxiv.org/abs/1409.3215 - 논문 링크

논문 요약

Abstract

논문 "Sequence to Sequence Learning with Neural Networks"는 일반적인 시퀀스 학습 접근법을 제시합니다. 이 접근법은 시퀀스 구조에 최소한의 가정을 하며, 다층 LSTM(Long Short-Term Memory)을 사용하여 입력 시퀀스를 고정된 차원의 벡터로 매핑하고, 또 다른 LSTM을 사용하여 이 벡터에서 목표 시퀀스를 디코딩합니다. 주요 결과로, WMT'14 데이터 세트의 영어-프랑스어 번역 작업에서 LSTM 모델은 BLEU 점수 34.8을 달성했습니다. 이는 기존의 문장 기반 통계적 기계 번역(SMT) 시스템의 33.3점보다 높은 점수입니다. 또한, LSTM을 사용한 가설 재정렬로 BLEU 점수가 36.5로 상승했습니다. LSTM 모델은 긴 문장에서도 잘 작동했으며, 소스 문장의 단어 순서를 반대로 하여 성능을 크게 향상시켰습니다.

1. Introduction

이 논문의 "Introduction" 부분에서는 심층 신경망(DNN)이 어려운 문제들에서 뛰어난 성능을 발휘하는 강력한 모델임을 설명합니다. DNN은 음성 인식, 시각적 객체 인식 등에서 우수한 성능을 보여왔지만, 시퀀스 데이터(예: 음성 인식, 기계 번역)에는 적용하기 어렵습니다. 이는 DNN이 고정된 차원의 벡터로 입력과 출력을 표현해야 하기 때문입니다.

시퀀스 데이터의 도전 과제

- 고정된 차원의 벡터 문제: 시퀀스 데이터는 길이가 일정하지 않기 때문에 DNN이 이를 처리하기 어렵습니다.

- 시퀀스-투-시퀀스 문제: 입력 시퀀스를 고정된 벡터로 매핑하고, 이 벡터를 다시 출력 시퀀스로 매핑해야 합니다. 이는 입력과 출력 시퀀스 간의 종속성이 복잡하기 때문에 어려운 문제입니다.

LSTM의 도입

- LSTM(Long Short-Term Memory): LSTM은 긴 시퀀스 데이터의 종속성을 학습할 수 있는 능력이 있어, 시퀀스-투-시퀀스 문제를 해결하는 데 적합합니다.

- 모델 구조: 하나의 LSTM이 입력 시퀀스를 고정된 차원의 벡터로 매핑하고, 또 다른 LSTM이 이 벡터를 사용하여 출력 시퀀스를 생성합니다.

이 논문은 LSTM을 사용한 시퀀스-투-시퀀스 학습 방법을 제안하며, 이를 통해 기계 번역 작업에서 우수한 성능을 달성했음을 보여줍니다. 이 접근법은 시퀀스 데이터의 구조에 대한 최소한의 가정을 하며, 다양한 시퀀스 학습 문제에 적용될 수 있습니다.

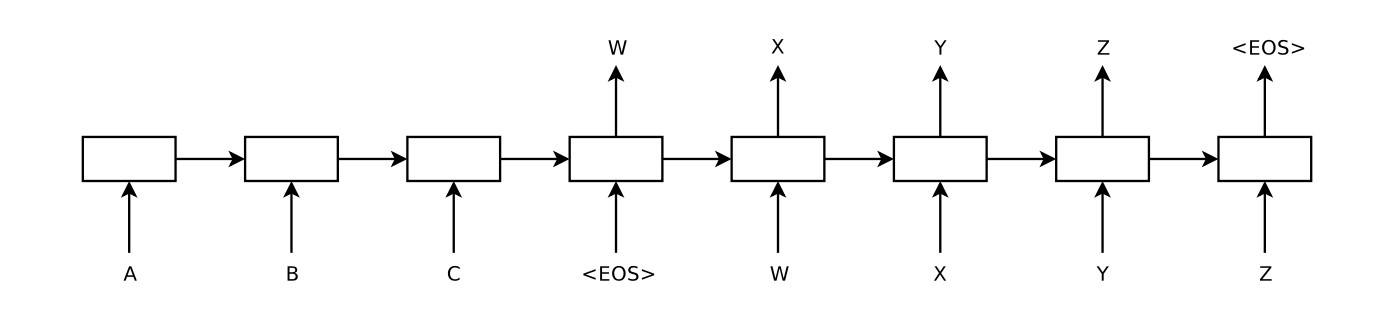

<이 이미지는 LSTM(Long Short-Term Memory) 모델이 어떻게 입력 시퀀스를 처리하고 출력 시퀀스를 생성하는지 보여줌>

이미지 설명:

- 입력 시퀀스 "ABC": 모델은 입력 시퀀스를 하나씩 읽어들입니다.

- 출력 시퀀스 "WXYZ": 모델은 입력 시퀀스를 처리한 후, 출력 시퀀스를 생성합니다.

- EOS (End Of Sentence): 모델은 문장의 끝을 나타내는 토큰을 출력한 후 예측을 중지합니다.

- 역순 입력: 입력 문장을 역순으로 읽습니다. 예를 들어, "ABC"는 "CBA"로 읽힙니다. 이렇게 함으로써 데이터에 많은 단기 종속성을 도입하여 최적화 문제를 더 쉽게 만듭니다.

2. The Model

"The Model" 부분에서는 LSTM(Long Short-Term Memory) 아키텍처를 사용하여 시퀀스-투-시퀀스 문제를 해결하는 방법을 설명합니다. 주요 내용은 다음과 같습니다:

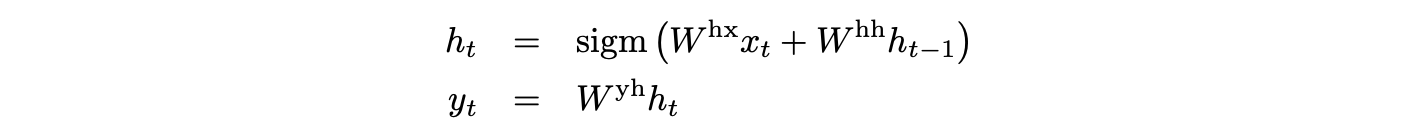

RNN과 LSTM의 도입

- RNN (Recurrent Neural Network): RNN은 시퀀스 데이터를 처리하는 자연스러운 방법입니다. 그러나 입력과 출력 시퀀스의 길이가 다를 때, 특히 복잡하고 비선형적인 관계가 있을 때 적용하기 어렵습니다.

- LSTM: LSTM은 장기 종속성을 학습하는 데 뛰어난 성능을 보여, 시퀀스-투-시퀀스 문제를 해결하는 데 적합합니다.

모델 구조

- 입력 시퀀스에서 벡터로: 하나의 LSTM이 입력 시퀀스를 고정된 차원의 벡터로 변환합니다.

- 벡터에서 출력 시퀀스로: 변환된 벡터를 사용하여 또 다른 LSTM이 출력 시퀀스를 생성합니다.

- 두 개의 LSTM 사용: 입력 시퀀스와 출력 시퀀스를 처리하기 위해 두 개의 LSTM을 사용합니다. 이는 모델 파라미터 수를 증가시키지만 계산 비용은 적고, 여러 언어 쌍에 대해 동시에 학습할 수 있습니다.

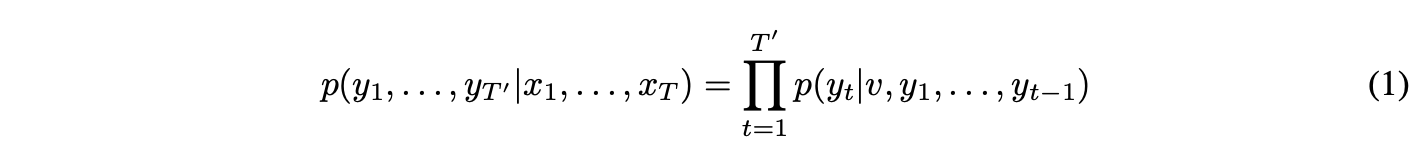

학습 과정

- 조건부 확률: LSTM은 입력 시퀀스 (x_1,...,x_T)를 고정 차원의 벡터 표현 𝑣로 변환하고, 이를 기반으로 출력 시퀀스 (y_1,...,y_T')의 조건부 확률을 계산합니다.

- 소프트맥스 함수: 각 시점 𝑡에서의 출력 확률 p(y_t | v,y_1,...,y_t-1)는 소프트맥스 함수를 사용하여 계산됩니다.

- 단어 순서 반전: 입력 문장의 단어 순서를 반대로 하여 모델의 성능을 크게 향상시켰습니다. 예를 들어, "a, b, c"를 "c, b, a"로 변환하여 단기 종속성을 증가시켰습니다.

주요 차이점

- 깊은 LSTM: 얕은 LSTM보다 깊은 LSTM(여러 층을 가진 LSTM)이 성능이 더 뛰어났습니다.

- 데이터 변환: 소스 문장의 단어 순서를 반대로 하여 최적화 문제를 더 쉽게 해결할 수 있었습니다.

3. Experiments

"Experiments" 부분에서는 LSTM 기반 시퀀스-투-시퀀스 모델의 성능을 평가하기 위해 다양한 실험을 수행한 내용을 다룹니다. 주요 내용은 다음과 같습니다:

실험 설정

- 데이터 세트: WMT’14 영어-프랑스어 번역 작업을 대상으로 실험을 수행했습니다. 훈련 데이터로 12M 문장 쌍(348M 프랑스어 단어, 304M 영어 단어)을 사용했습니다.

- 단어 벡터: 소스 언어와 타겟 언어 각각에 대해 고정된 어휘 목록을 사용했습니다. 소스 언어는 160,000개의 가장 빈도가 높은 단어를, 타겟 언어는 80,000개의 가장 빈도가 높은 단어를 포함했습니다. 어휘에 포함되지 않은 단어는 "UNK" 토큰으로 대체되었습니다.

디코딩 및 재점수화

- 디코딩: LSTM 모델을 사용하여 입력 문장을 직접 번역했습니다. 또한, 베이스라인 SMT 시스템의 1000-베스트 리스트를 재점수화했습니다.

- 빔 서치 디코더: 빔 서치 디코더를 사용하여 가장 가능성이 높은 번역을 생성했습니다. 빔 크기가 2인 경우 대부분의 이점을 제공했으며, 빔 크기가 1인 경우에도 성능이 좋았습니다.

소스 문장 반전

- 성능 향상: 소스 문장의 단어 순서를 반대로 하면 LSTM의 테스트 perplexity가 5.8에서 4.7로 감소했으며, BLEU 점수가 25.9에서 30.6으로 증가했습니다. 이는 소스 문장과 타겟 문장 간의 단기 종속성을 도입하여 최적화 문제를 더 쉽게 만들었기 때문입니다.

학습 세부 사항

- LSTM 구성: 4개의 레이어를 가진 깊은 LSTM을 사용했습니다. 각 레이어에는 1000개의 셀이 있으며, 1000차원 단어 임베딩을 사용했습니다. 전체 모델은 384M 파라미터를 가졌습니다.

- 학습 과정: 확률적 경사 하강법(SGD)과 고정 학습률 0.7을 사용했습니다. 5 에포크 후, 학습률을 절반으로 줄였습니다. 총 7.5 에포크 동안 학습을 진행했습니다.

- 평행화: 8개의 GPU를 사용하여 모델을 병렬화했습니다. 각 LSTM 레이어는 별도의 GPU에서 실행되었고, 소프트맥스도 병렬화되었습니다. 이를 통해 초당 6300 단어를 처리할 수 있었습니다.

실험 결과

- BLEU 점수: LSTM 모델은 WMT’14 영어-프랑스어 테스트 세트에서 BLEU 점수 34.81을 달성했습니다. 이는 베이스라인 SMT 시스템의 33.30보다 높은 점수입니다.

- 긴 문장 성능: LSTM은 긴 문장에서도 우수한 성능을 보였습니다. 소스 문장의 단어 순서를 반대로 한 경우, 긴 문장에서의 성능 저하가 거의 없었습니다.

4. Related Work

"Related Work" 부분에서는 시퀀스-투-시퀀스 학습 및 기계 번역 작업에서 신경망을 적용한 이전 연구들을 검토합니다. 주요 내용은 다음과 같습니다:

이전 연구

- RNN 언어 모델(RNNLM)과 신경망 언어 모델(NNLM): 이전 연구들은 강력한 기계 번역(MT) 베이스라인의 n-베스트 리스트를 재점수화하는 방식으로 RNNLM 및 NNLM을 적용해 왔습니다. 이는 번역 품질을 향상시키는 데 효과적이었습니다.

- 소스 언어 정보 통합: Auli et al.과 Devlin et al.은 입력 문장의 주제 모델을 결합하거나, 디코더의 정렬 정보를 사용하여 NNLM에 소스 언어 정보를 제공함으로써 성능을 향상시켰습니다.

- 입력 문장 벡터화: Kalchbrenner와 Blunsom은 입력 문장을 벡터로 매핑한 후, 다시 문장으로 변환하는 방법을 제시했습니다. 이 연구는 단어 순서를 잃는 CNN을 사용했습니다.

- LSTM을 사용한 시퀀스-투-시퀀스 학습: Cho et al.은 LSTM과 유사한 RNN 아키텍처를 사용하여 문장을 벡터로 매핑하고 다시 문장으로 변환하는 방법을 연구했습니다.

- 주의 메커니즘: Bahdanau et al.은 주의 메커니즘을 사용하여 길이가 긴 문장에서 성능 저하 문제를 해결했습니다.

- 연속 번역: Pouget-Abadie et al.은 소스 문장의 일부를 번역하여 부드러운 번역을 생성하는 방법을 제안했습니다.

시퀀스-투-시퀀스 학습

- 연속 학습: Hermann et al.은 입력과 출력을 피드포워드 네트워크로 표현하여 공간상의 유사한 지점에 매핑하는 방법을 제안했습니다. 그러나 이 접근법은 직접 번역을 생성하지 못하며, 사전 계산된 문장 데이터베이스에서 가장 가까운 벡터를 조회하거나 문장을 재점수화해야 합니다.

5. Conclusion

"Sequence to Sequence Learning with Neural Networks" 논문의 결론 부분에서는 LSTM(Long Short-Term Memory) 기반 시퀀스-투-시퀀스 모델의 성능과 잠재력에 대해 논의합니다.

주요 내용

모델 성능:

- LSTM 기반 모델은 대규모 기계 번역(MT) 작업에서 기존의 SMT(통계적 기계 번역) 시스템을 능가하는 성능을 보였습니다.

- 소스 문장의 단어 순서를 반대로 하는 간단한 기법이 모델의 성능을 크게 향상시켰습니다. 이는 단기 종속성을 도입하여 최적화 문제를 더 쉽게 해결할 수 있게 했습니다.

장기 종속성 처리:

- LSTM은 긴 문장에서의 번역 성능이 뛰어났으며, 이는 기존 연구에서 보고된 문제를 극복한 것입니다.

- 입력 문장을 역순으로 처리함으로써 긴 문장에서도 좋은 성능을 유지할 수 있었습니다.

단순한 접근 방식:

- 본 연구는 단순하고 최적화되지 않은 접근 방식이 SMT 시스템을 능가할 수 있음을 보여줍니다. 이는 추가적인 연구와 최적화를 통해 더욱 높은 번역 정확도를 달성할 수 있는 가능성을 시사합니다.

다른 시퀀스 학습 문제에의 적용:

- LSTM 기반 시퀀스-투-시퀀스 학습 방법은 기계 번역 외에도 다양한 시퀀스 학습 문제에 적용될 수 있습니다.

- 충분한 학습 데이터가 주어진다면, 다른 복잡한 시퀀스 학습 문제에서도 유사한 성과를 낼 수 있을 것으로 예상됩니다.

결론

- 본 연구는 LSTM이 시퀀스-투-시퀀스 문제를 효과적으로 해결할 수 있음을 입증했으며, 특히 기계 번역 작업에서 우수한 성능을 보였습니다.

- 단순한 기법으로도 큰 성능 향상을 달성할 수 있음을 보여주었으며, 이는 향후 연구를 통해 더욱 발전될 수 있습니다.