Non-stationary Transformers: Exploring the Stationarity in Time Series Forecasting (NeurIPS, 2022)

Abstract

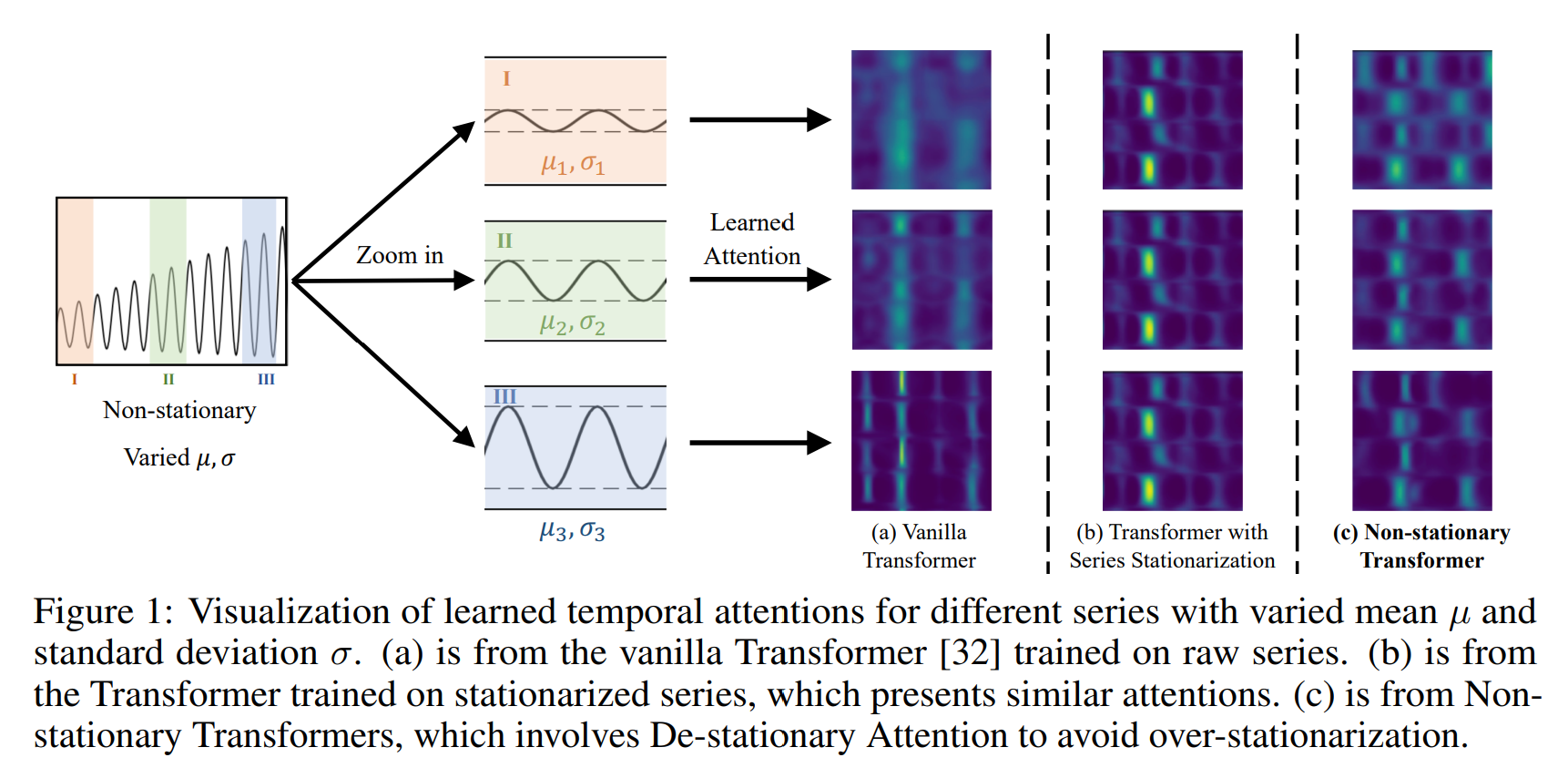

트랜스포머 모델은 글로벌 범위의 모델링 능력으로 시계열 예측에 뛰어난 성능을 보였다. 하지만 혀현실의 non-stationary 데이터에서는 성능이 저하된다. 이는 시계열의 joint 분포가 시간에 따라 변하기 때문이다. 기존 연구들은 stationarization을 사용하였다. 하지만 이렇게 stationarization화 된 시계열은 내재된 비정상성이 사라지고, 현실 세계의 bursty events 예측에는 유용하지 않다. 이는 본 논문에서 over-stationarization라고 규정하며, 트랜스포머가 서로 다른 시계열에 대해 temporal attention을 구별 불가능하게 생성하고, 심층 모델의 예측 성능을 저해한다. 이러한 시계열 예측성과 모델 퍼포먼스의 딜레마를 다루기 위해서, Non-stationary 트랜스포머를 제안한다. 이는 2개의 모듈로 이루어져 있는데, Series

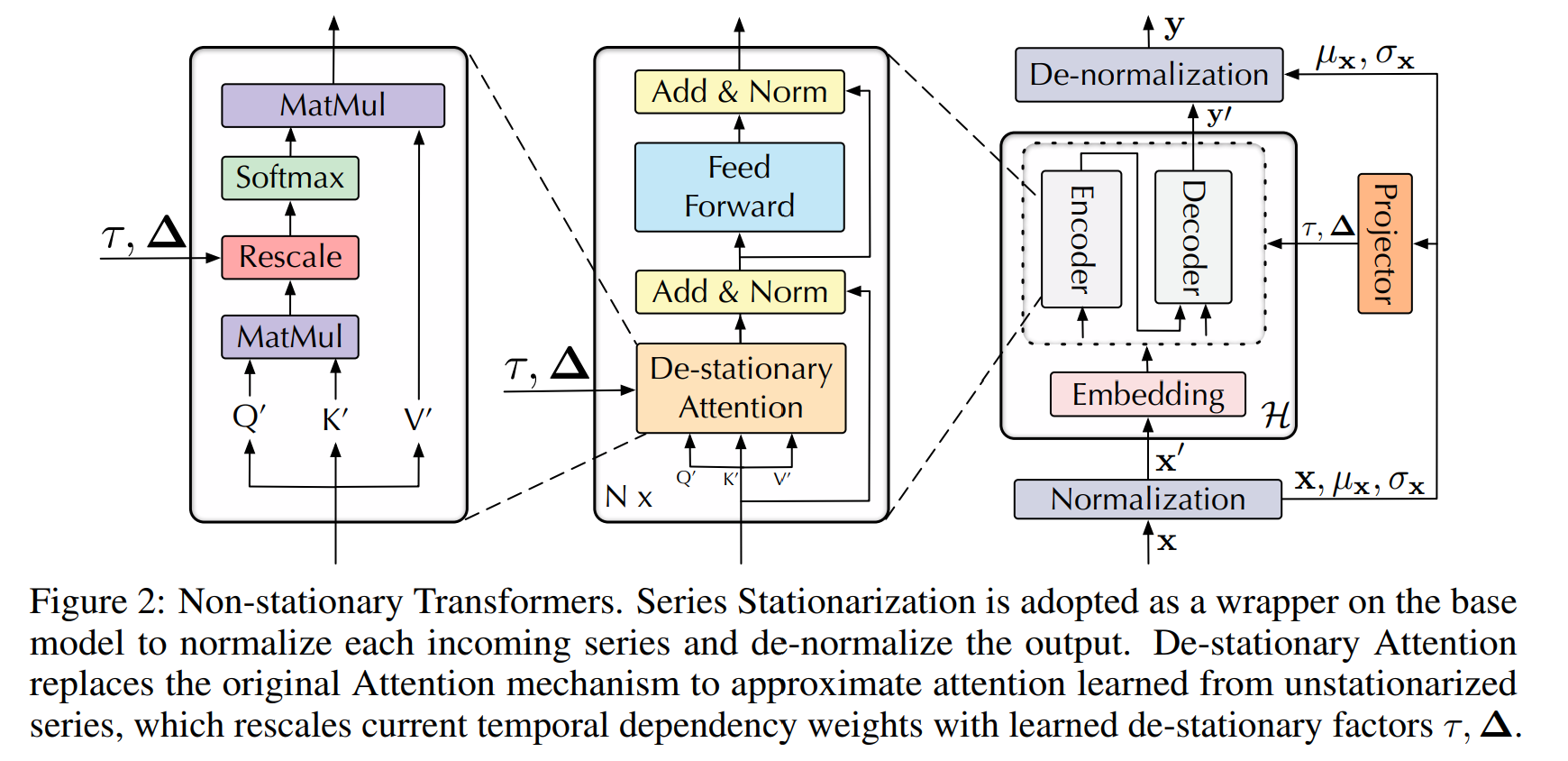

Stationarization 과 De-stationary Attention 이다. 정확하게는, Sereis Stationarization 은 각각의 입력 통계량을 통일하고 예측 가능성을 높이기 위해 복원된 통계량을 통해 출력을 변환한다. over-stationarization 문제를 해결하기 위해서 De-stationarization attention이 고안되어 내재된 비정상성 정보를 raw 데이터에서 재복원한다. 우리의 Non-stationary 트랜스포머 프레임워크는 메인스트림 트랜스포머를 큰 마진을 통해 부스팅하며, 트랜스포머의 MSE를 49.43% 줄였으며, 인포머의 경우에 46.89%, 그리고 리포머에서 SOTA 성능을 달성하였다.

1 Introduction

트랜스포머는 현실 세계의 비정상 데이터 때문에 예측이 어려운 경우가 많다. 비정상성을 가진 시계열 데이터는 시간이 지남에 따라 통계적 속성과 joint distribution이 지속적으로 변화한다. 이는 시계열의 예측력을 떨어트린다. 또한 변화하는 분포에 대해서 일반화하거나 정규화하는 방법은 비정상성을 완화하고 더 안정적인 데이터 분포를 제공하여 예측 가능성을 높인다. 실험적으로 정상성을 가진 시계열을 학습하는 것은 트랜스포머의 attention의 distriction을 저해함을 알 수 있었다. 바닐라 트랜스포머가 Fig 1(a) 처럼 temporal dependencies를 캡처할 수 있다면, stationarized 된 시계열로 학습한 트랜스포머는 부정확한 attention을 생성하게 된다. 이는 Fig 1(b)와 같다. 이는 over-stationarization 이라고 정의되며, 모델의 정확도를 낮춘다.

따라서, 시계열 비정상성을 완화하여 예측 가능성을 높이고, 동시에 모델의 성능을 저하시키는 over-stationarization 문제를 해결하는 것이 예측 성능의 키이다.

본 논문에서는 시계열 예측 태스크에서 stationarization 영향을 탐구하고, Non-stationary Transformer를 제안하여 트랜스포머가 실제 시계열에 더 적합하게 한다. 이는 두가지 모듈로 이루어져 있다. 1) series stationarization 모듈과 over-stationarization을 완화하기 위한 2) de-stationary attention 모듈이다. 이는 상호 의존적이며, 시계열 정규화 과정에서는 각 시계열의 주요 통계량을 통일하는 정규화 전략을 사용한다. De-stationary attention 부분에서는 정규화되지 않은 데이터의 attention을 근사하여 시계열 원본의 내재된 비정상성을 보완한다. 이러한 설계로 정규화된 시계열의 예측 가능성과 시간적 종속성 모두 활용 가능하다. 이를 통해 현실 데이터를 통해 최신 성능을 달성하였다. 본 논문의 contribution은 다음과 같다.

- 비정상성 시계열 예측 모델의 필요성을 제기한다. 현재의 접근 방법론은 over-stationarization 문제가 있어 트랜스포머의 예측 성능을 저하시킨다.

- Non-stationary Transformer를 제안하여, stationarization을 모듈을 통해 시계열을 더 예측가능하게 하며, De-stationary Attention 모듈을 통해 Over-stationarization 문제를 해결하며, 원래 시계열의 비정상성을 포함한다.

- Non-stationary Transformer는 4개의 메인스트림 트랜스포머를 통해서 구성되었으며, 6개의 벤치마크 데이터셋에 대해서 SOTA 퍼포먼스를 보였다.

2 Related Work

2.1 Deep Models for Time Series Forecasting

최근 몇년간 딥 모델들이 시계열 예측 분야에서 성적이 좋았지만, RNN계열은 장기적인 종속성을 모델링하는데 어려움을 겪었다. 트랜스포머는 시퀀스 모델링에서 강력한 성능을 보였고, self-attion구조의 계산복잡도를 줄이는데 초점을 맞추어 연구가 수행되었다. 또한 시계열 예측을 위한 building block들을 추가하는 방향으로 Autoformer는 분해 블록을 표준 구조로 융합하고, 시리즈 간의 연결을 위해 Auto-Correlation을 구축하였다. Pyraformer는 피라미드 attention 모듈(PAM)을 통해서 temporal dependencies를 다른 계층에서 포착하였다. 또한 트랜스포머가 없는 모델도 많은 발전을 이루어서, N-BEATS는 trend 와 seasonal terms에 대한 decomposition을 수행하였으며, 좋은 설명력을 가졌다. 또한 N-HiTs는 계층 레이아웃과 다양한 샘플링을 통해서 시계열과 주파수 밴드 데이터를 다루었다.

본 논문에서는 아키텍처 설계에 초점을 맞춘 이전 연구와는 다르게, 시계열 예측 태스크에서 stationarity의 기본 관점에서 분석하고, Non-stationary Transformer를 제안하여 다양한 트랜스포머 기반의 모델에 적용이 가능함을 보인다.

2.2 Stationarization for Time Series Forecasting

정상성은 시계열 예측에 중요한 역할을 하지만, 현실 세계의 시계열은 항상 비정상성을 갖는다. 정상성을 제거하기 위해서 전처리 방법으로 Adpative normalization이 수행되거나, DAIN을 통해 학습 분포에 따라 시계열을 비선형적인 적응을 통해 stationarization을 수행한다. RevIN은 인풋 및 아웃풋의 2 stage의 정규화를 수행하며, 각 시계열의 discrepancy를 줄인다. 대조적으로 본 연구에서는 시계열을 직접적으로 stationarizing 하는 것이 모델의 temporal dependency를 모델링하는 능력을 저하함을 발견하였다. 따라서, 본 연구에서는 이전 연구들과는 다르게 stationarization뿐 아니라 De-stationary attention을 추가해서 원래의 내제된 정상성을 복구한다.

3 Non-stationary Transformers

3.1 Series Stationarization

비정상적 시계열은 평균과 표준 편차가 변하는 통계적 특성이 있고, 딥 모델이 일반화하기 어렵다. RevIN은 학습 가능한 affin 파라미터들을 사용한 인스턴스 정규화를 각 입력에 수행하고, 출력에서 이를 복원하여 각 시계열이 유사한 분포를 따르도록 하였다. 실험적으로 이 파라미터는 학습없이도 잘 작동되기 때문에 기본 모델로 트랜스포머를 활용하여 더 간단한 설계를 제안한다. 이는 Sereis stationarization 이라고 정의한다.

이는 2가지 모듈로 이루어진다.

normalization 모듈 : 비정상성을 가지는 시계열을 다루기 위한 모듈

각 시계열의 인풋이 다음과 같을때,

translation과 scaling operation을 통해서 변환하면 다음과 같다.

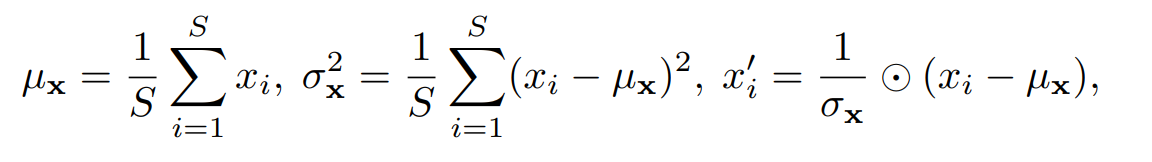

이때 Normaliation 모듈의 식은 다음과 같다.

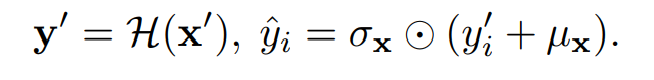

De-normalization 모듈 : 모델 출력을 원래의 통계로 변환하는 모듈

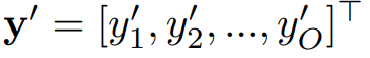

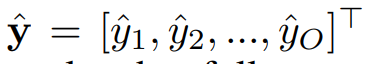

모델의 아웃풋이 다음과 같을 때

다음과 같은 예측 결과를 얻게 된다.

이는 다음과 같은 수식으로 얻어진다.

3.2 De-stationary Attention

각 시계열의 통계를 예측값을 통해 복원하였더라도, 원래 시계열의 비정상성은 De-normalization 만으로 완전히 회복할 수 없다. 특히 over-stationarization 의 효과는 attention과정에서 일어난다. 게다가, 비정상성의 시계열이 잘라지고, 정규화가 된 다음 청크화되어 같은 평균과 분산을 갖게 된다면 raw data에 비해서 비슷한 분포를 갖게 된다. 따라서 모델은 이벤트가 거의 없는 출력을 보이며 raw data의 자연적인 비정상성과 상응하지 않게 된다.

Analysis of the plain model

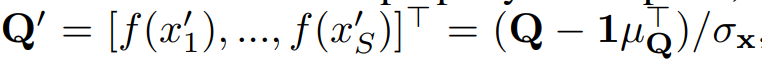

비정상성 정보가 사라지면서 발생하는 과도한 정규화 문제는 기본 모델이 예측을 위해 중요한 시간적 종속성을 포착하지 못하게 한다. 따라서 비정상성을 갖는 원본 시계열에서 학습된 attention을 근사하려고 한다. 정규화 모듈을 거친 뒤 모델은 정규화된 입력을 받게 된다. 따라서, attention 레이어는 다음과 같은 인풋을 얻게 된다.

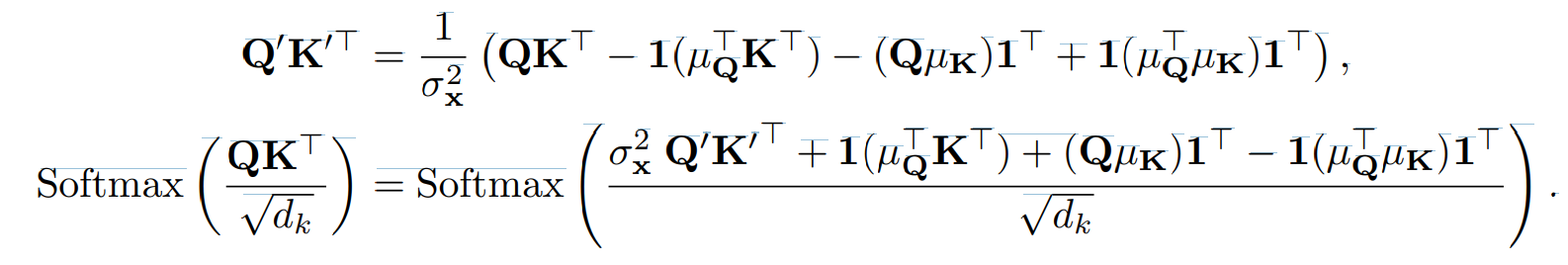

K, V 도 마찬가지로 변환된 인풋을 받게 되는데, self-attentiont 식은 다음과 같이 변화 되어야 한다.

이를 계산하면 기존의 self-attention 식은 다음과 같이 변화된다.

De-stationary Attention

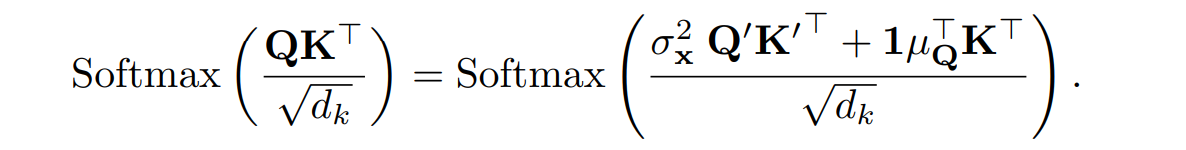

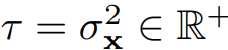

비정상 정보를 계산하기 위해서 양의 스케일링 스칼라

와 shifting 벡터

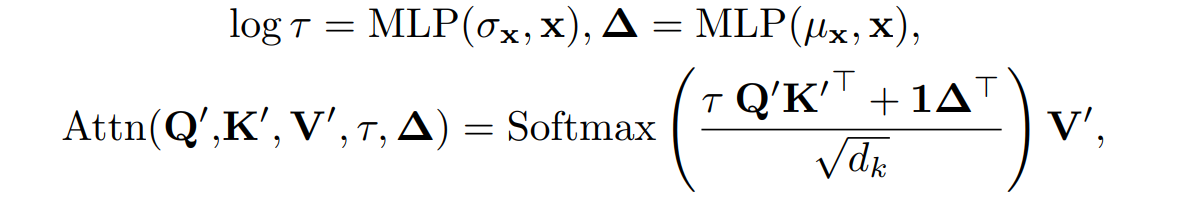

를 근사해야 한다. 실제 인자를 추정하기는 어렵기 때문에 MLP 레이어를 통해서 이 인자를 직접 학습힌다. 현재의 Q' K' 에서 비정상적 정보를 제한적이기 때문에 비정상성을 보완할 수 있는 출처는 정규화되지 않은 x이다. 따라서, 정규화되지 않은 x의 통계량으로부터 비정상성 인자를 학습한다. 이는 다음과 같이 계산된다.

이를 통해서 원본 시계열의 시간적 종속성을 유지할 수 있다.

4 Experiments

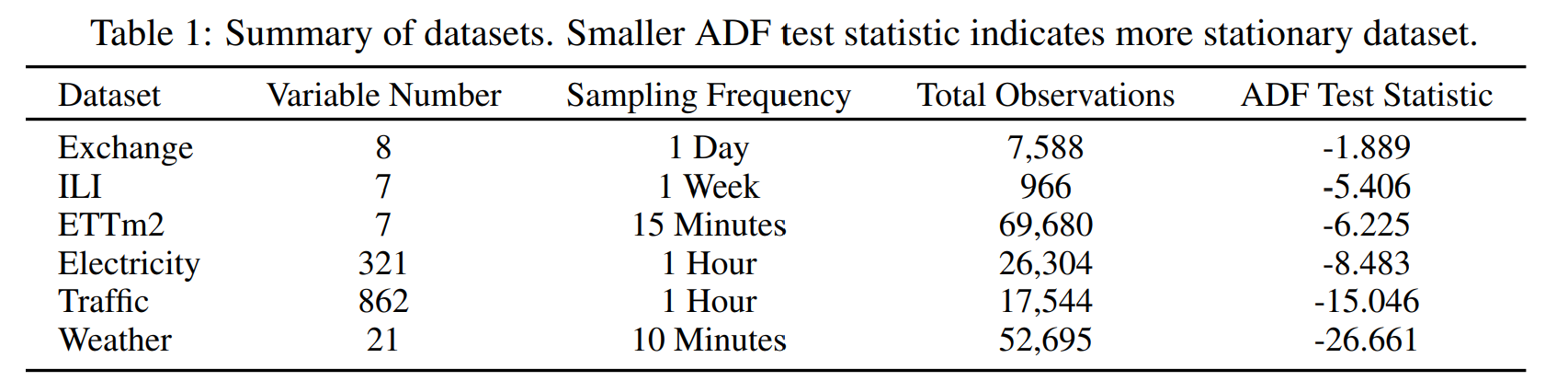

Datasets

Electricity, ETT, Exchange, ILI, Traffic, Weather

Baselines

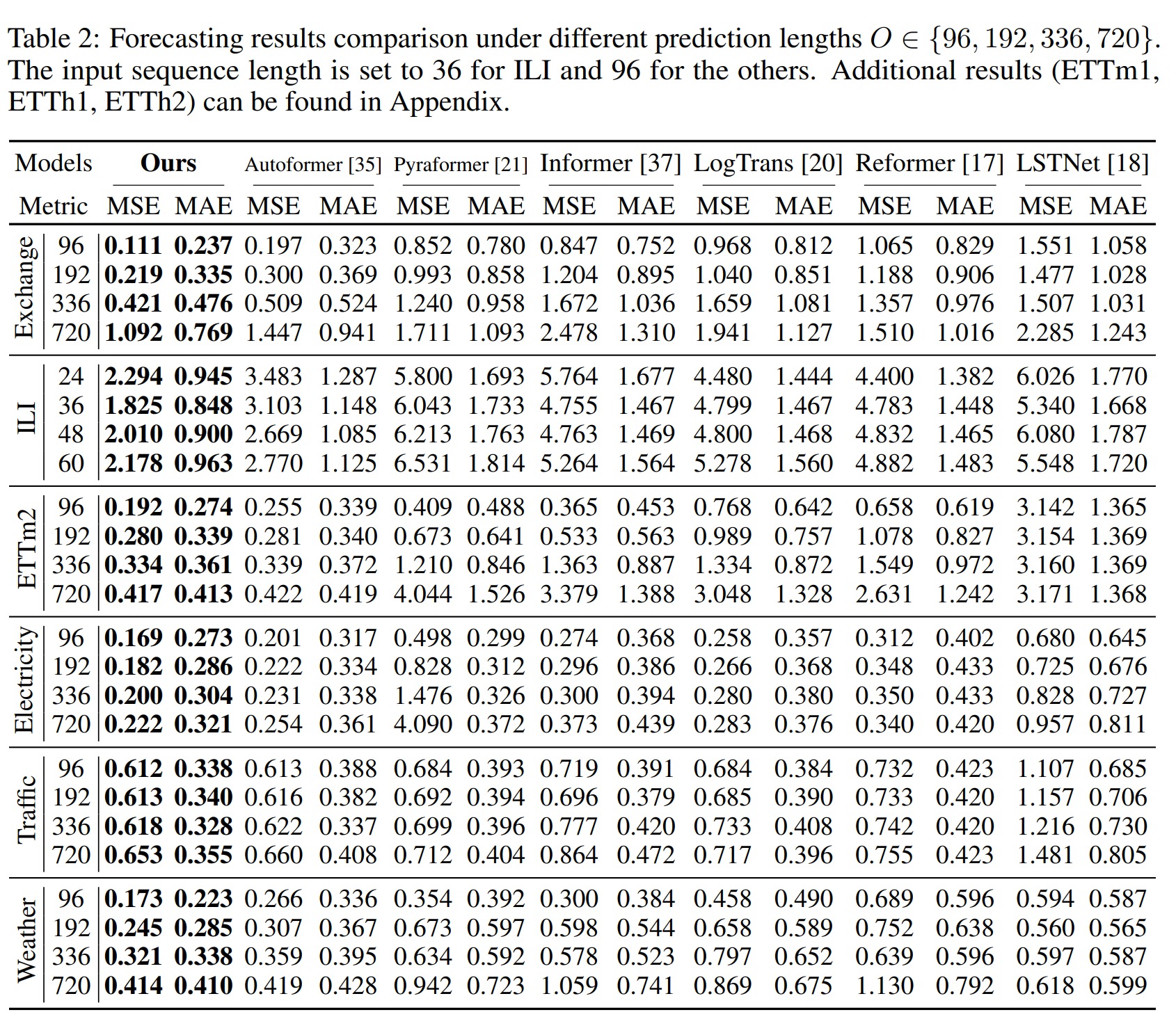

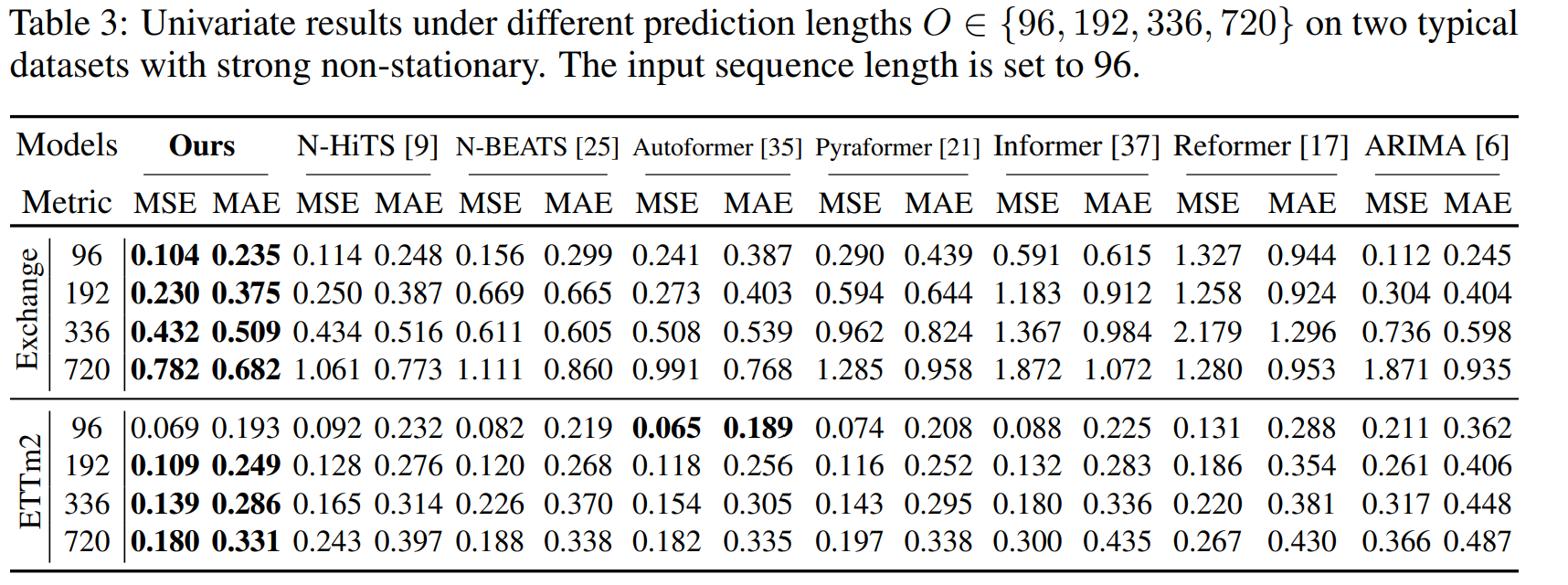

바닐라 트랜스포머에 제안 방법론인 Non-stationary transformer 프레임워크를 단변량, 다변량으로 효과를 분석하였음. 다변량 시계열 예측에서, 6개의 SOTA와 비교하였다. Autoformer, Pytaformer, Informer, LogTrans, Reformer, LSTNet이다. 단변량에서는 N-HiTS, N-BEATS, Autoformer, Pyraformer, Informer, Reformer, ARIMA. 또한 Transformer, Informer, Regormer, Autoformer를 통해서 제안 방법론의 일반화를 평가함

Implementation detail

파이토치를 TITAN V 를 통해 실험을 진행하였음.

4.1 Main Results

Forecasting results

다변량 실험 결과는 다음과 같이 제안한 방법론의 퍼포먼스가 좋음을 알 수 있다.

단변량의 경우에도 다음과 같이 퍼포먼스가 좋았다.

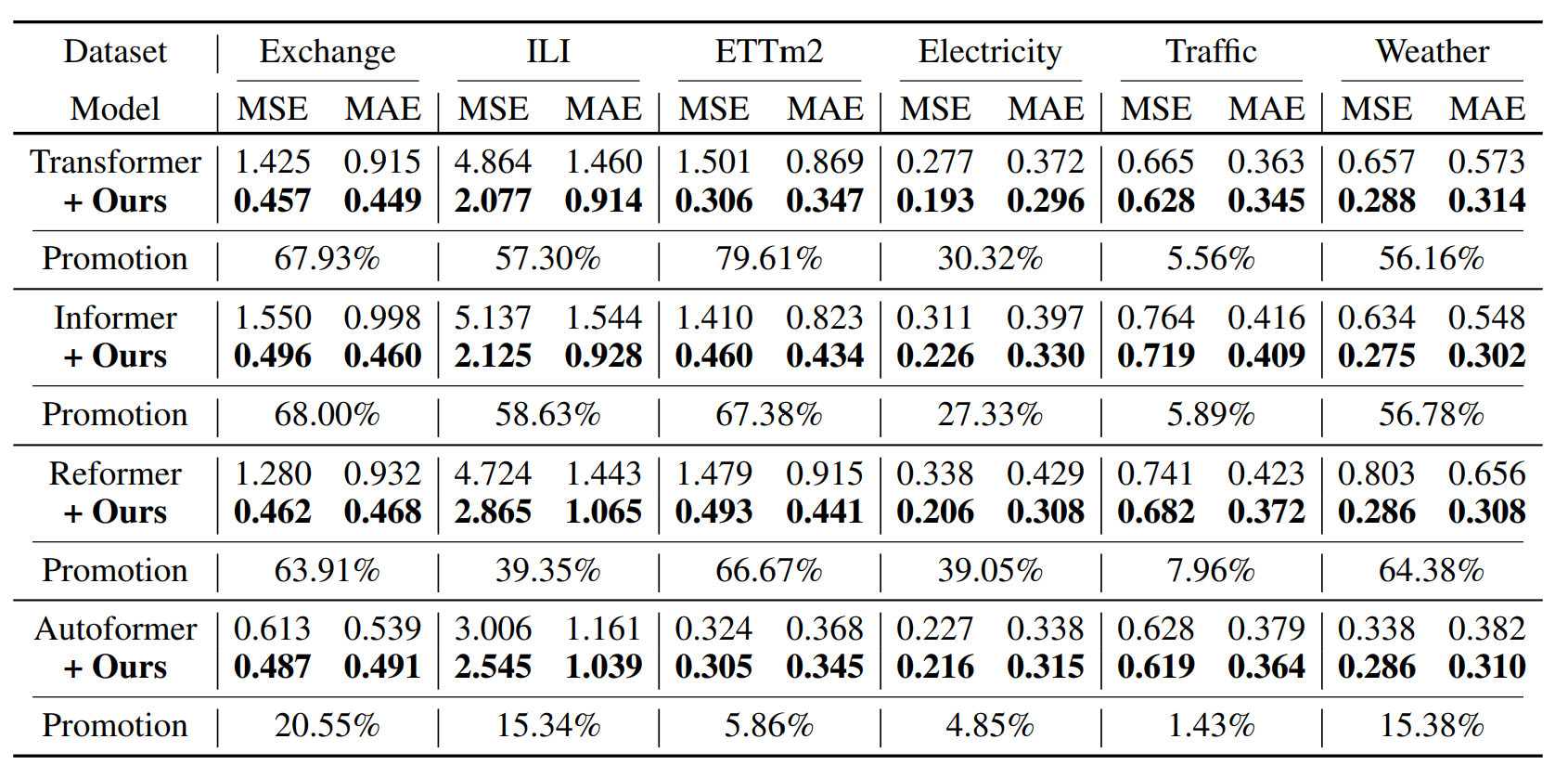

Framework generality

바닐라 트랜스포머의 경우 49.43%의 향상이, Informer에서는 46.89%의 향상이, Reformer 에서는 10.57%의 향상이 있었다.

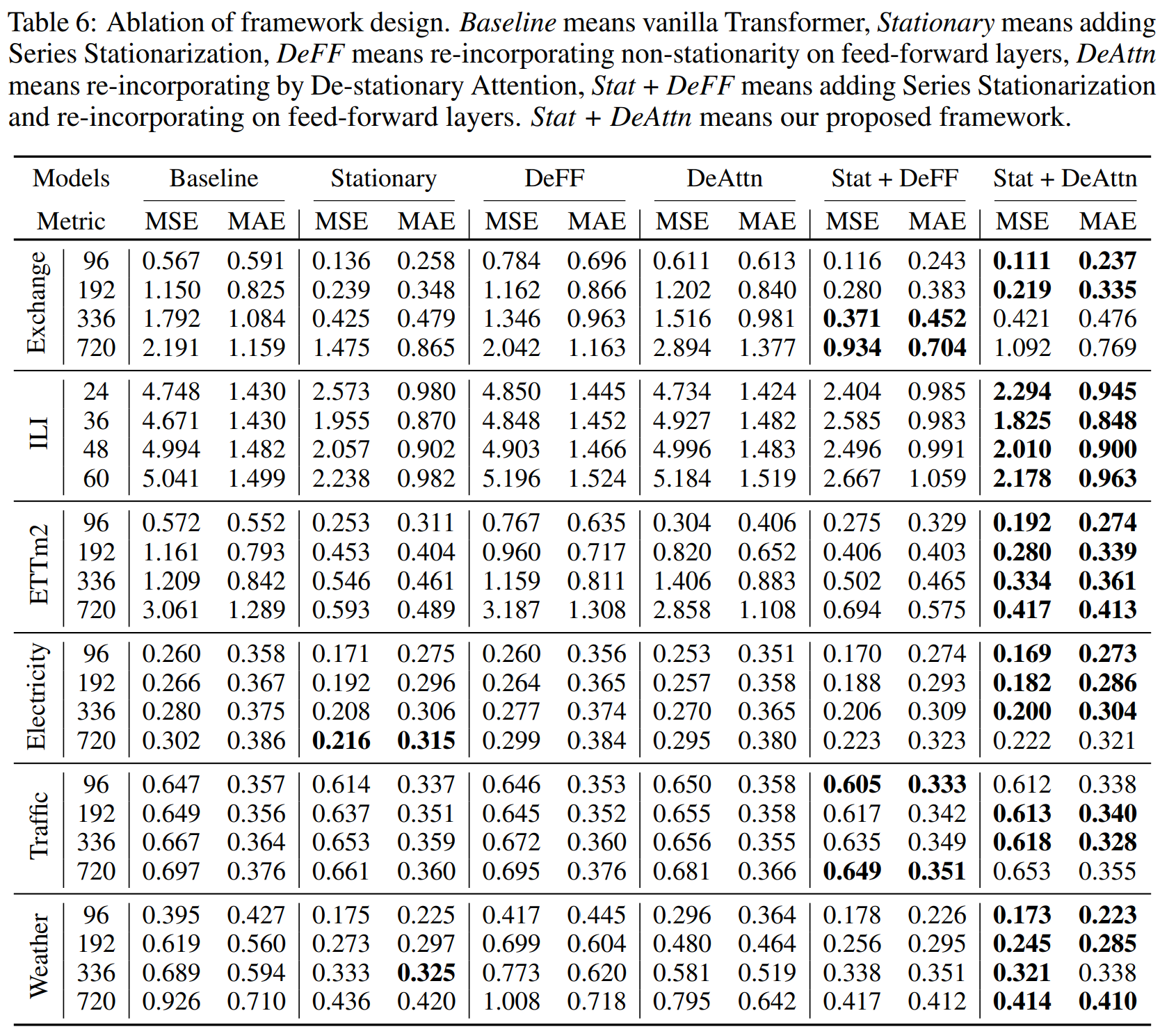

4.2 Ablation Study

Quality evaluation

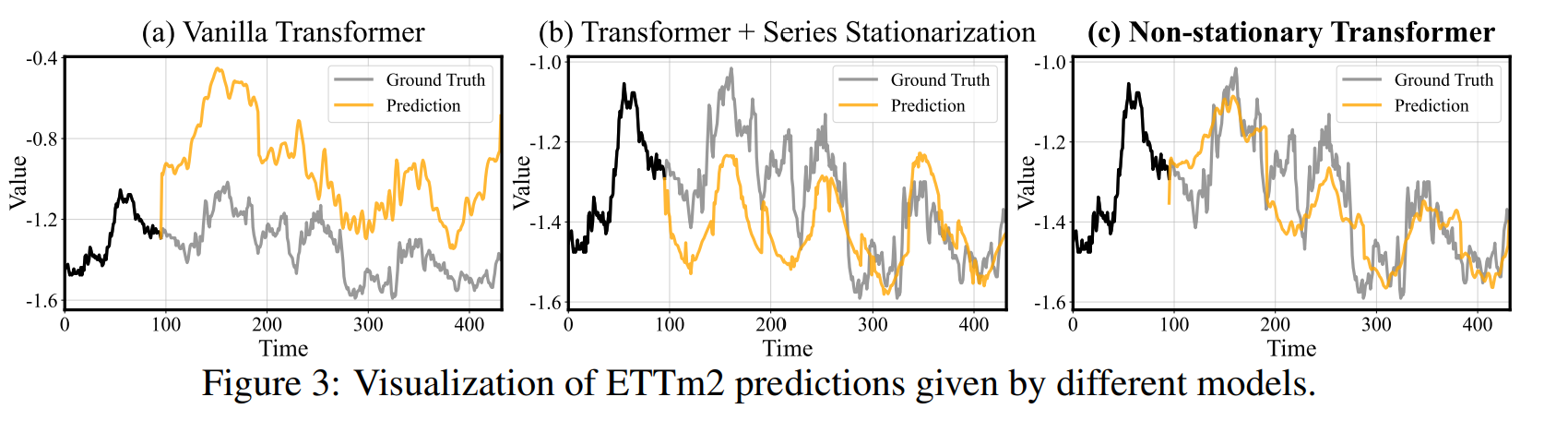

ETTm2에서 3가지 모델에 대해서 ablation 스터디를 진행하였다. 1. 바닐라 트랜스포머, 2. seires stationarization만 있는 경우, 3. 제안 방법론

위 결과를 보면 정확한 시계열의 variation을 예측하기 위해서는 제안 방법론이 가장 잘 예측함을 보여준다.

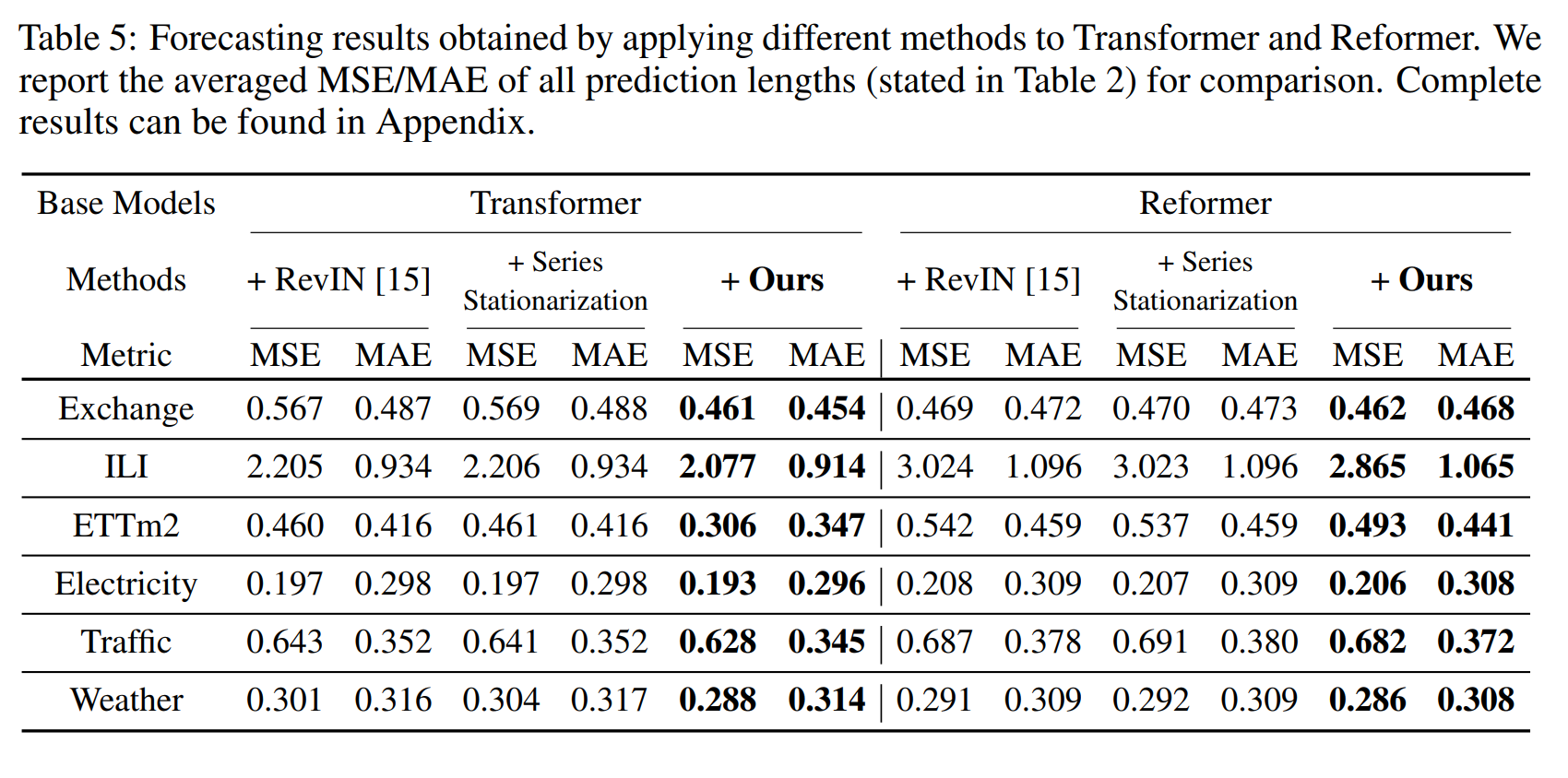

Quantitative performance

SOTA모델과의 비교는 다음과 같다.

예측 결과는 RevIN과 Series Stationarization이 비슷하다. 이는 시계열 stationarization 파라미터를 학습으로 수행하는것이 효과적임을 증명한다. 또한, De-stationary Attention 이 퍼포먼스를 6개 벤치마크 데이터셋에서 효과적으로 예측함을 보였다. 이러한 결과는 statrionarizating 시계열이 트랜스포머의 예측 퍼포먼스를 효과적으로 증가시킴을 이야기한다.

4.3 Model Analysis

Over-stationarization problem

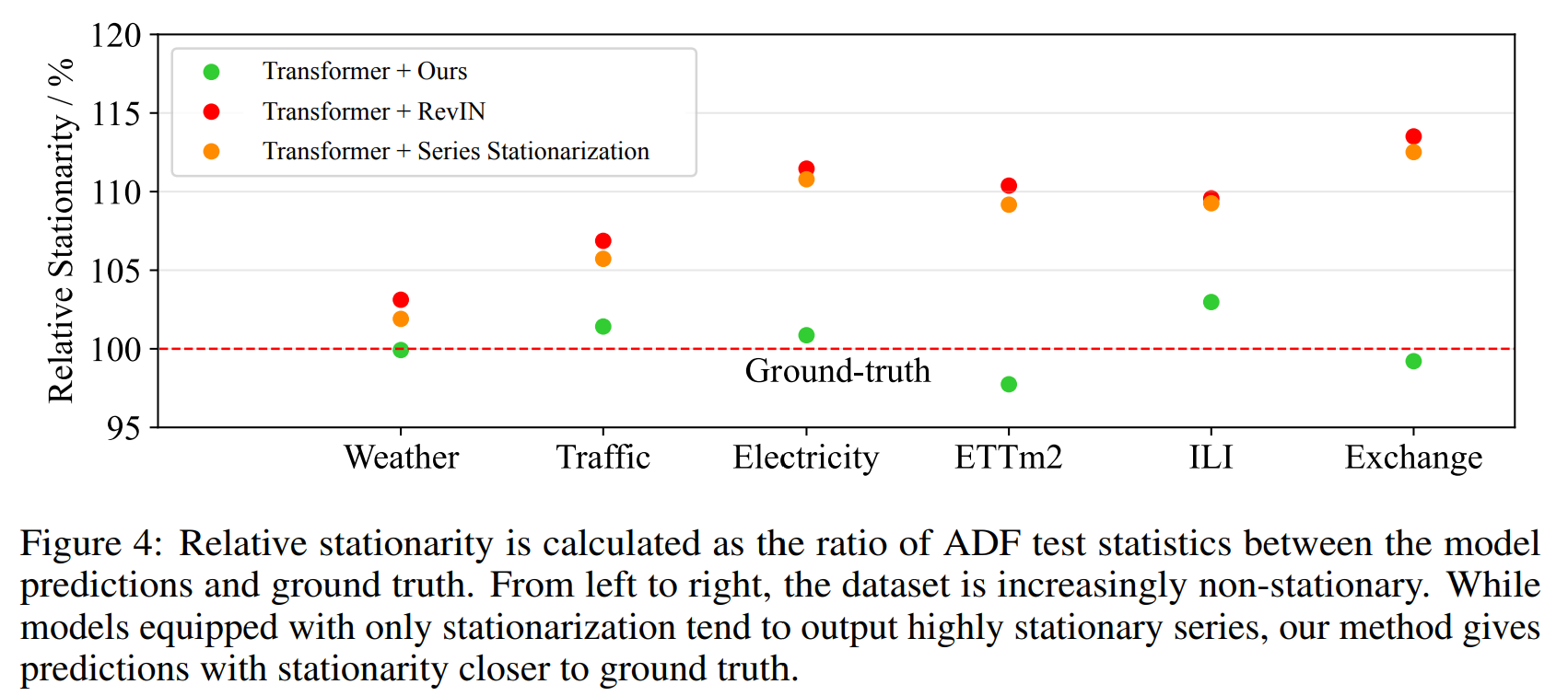

over-stationarization 문제를 검증하기 위해 각각의 방법으로 트랜스포머를 학습시킨 후 모든 시계열을 시간 순서대로 배열하고 실제값과 stationarity를 비교하였다.

stationarization 방법론이 장착된 모델들은 높은 stationarity를 보였다. 그러나, de-statrionary Attention을 가진 제안 방법론은 원본 시계열과 비슷한 statrionarity를 보였다.

Exploring of Non-stationary Information Re-incorporation

non-stationary information을 복구하기 위한 다른 방법론을 위해 뮤와 시그마를 FF레이어에 집어넣어 통합하였다. 이 결과는 Stat+ DeFF 이며, 본 연구에서 제안한 Stat + DeAttn 은 다음과 같다.

결과로 알 수 있듯이, 제안한 De-stationarization 매커니즘이 효과적으로 성능을 높임을 검증하였다.

5 Conclusion

본 연구는 시계열 예측 태스크를 정상성의 관점에서 다루었다. 이전의 연구들은 non-stationary를 없애고, over-statrionarization화 되었다. 우리는 이러한 한계를 통해 non-stationary 정보를 새롭게 재조합하여 데이터의 예측성과 모델의 퍼포먼스를 높였다. 실험을 통해 우리의 방법론이 6개의 실제 데이터에 적합함을 보였으며, 구체적으로 각 구조의 효과를 입증하였다. 추가적으로, model-agnostic 한 솔루션을 탐구할 예정이다.