backbone

- VGG backbone 사용

backbone을 resnet, efficientnet등 다른 backbone으로 대체가능, pre-trained weight 사용가능

Fully convolution layer

- fully connected layer -> fully convolution layer로 공간 정보 손실 없앰

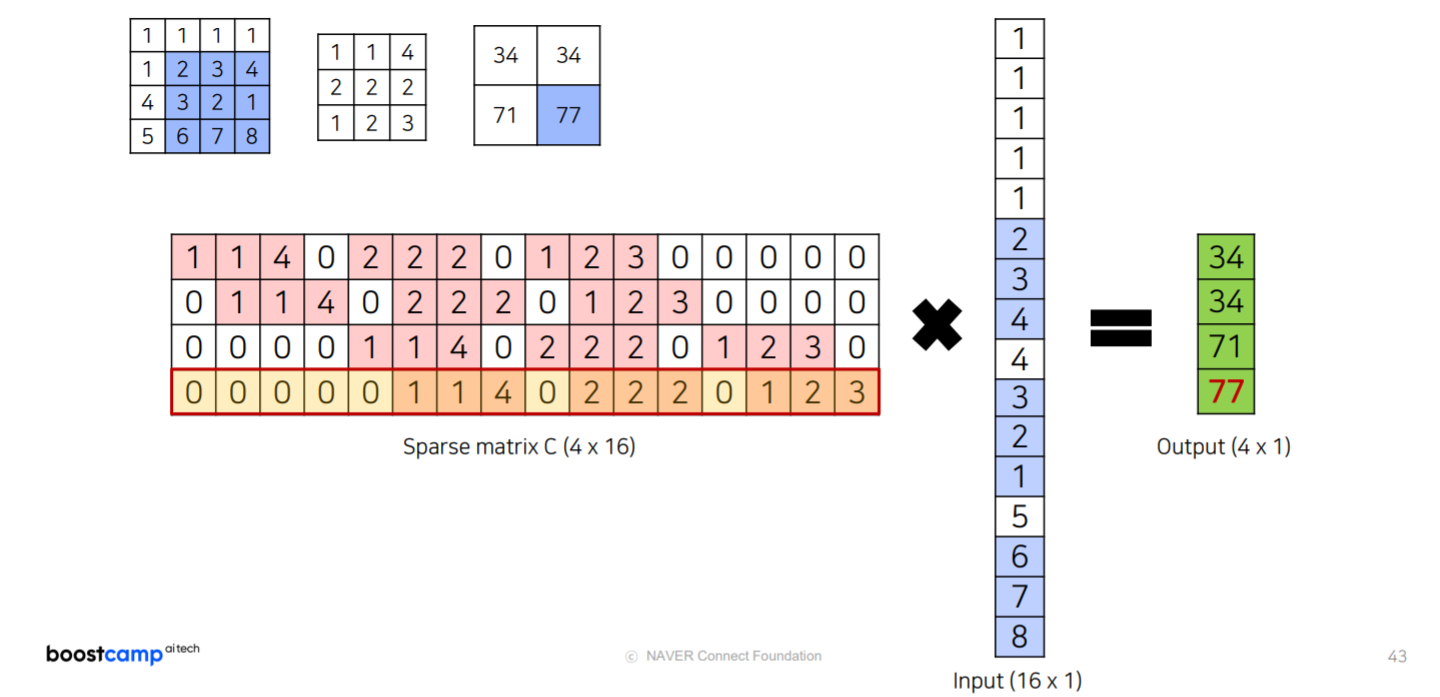

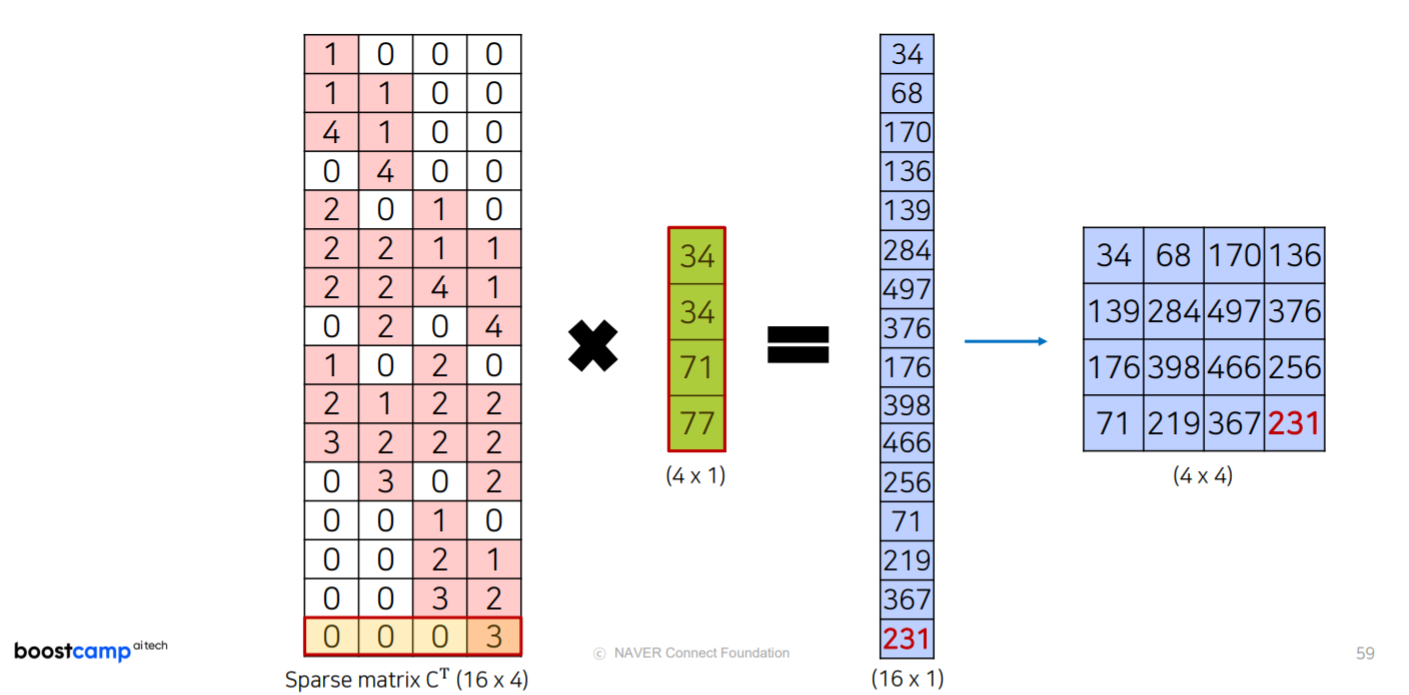

Transposed convolution

- 마지막 input size로 upsampling할때 Transposed convolution을 사용

Transposed convolution은 아래의 측면에서 deconvolution과 다른 개념이다.- 학습가능한 파라미터를 가진다는 점

- 복원 결과가 size만 같을뿐 input과 동일하게 복원되는 것이 아니라는 점

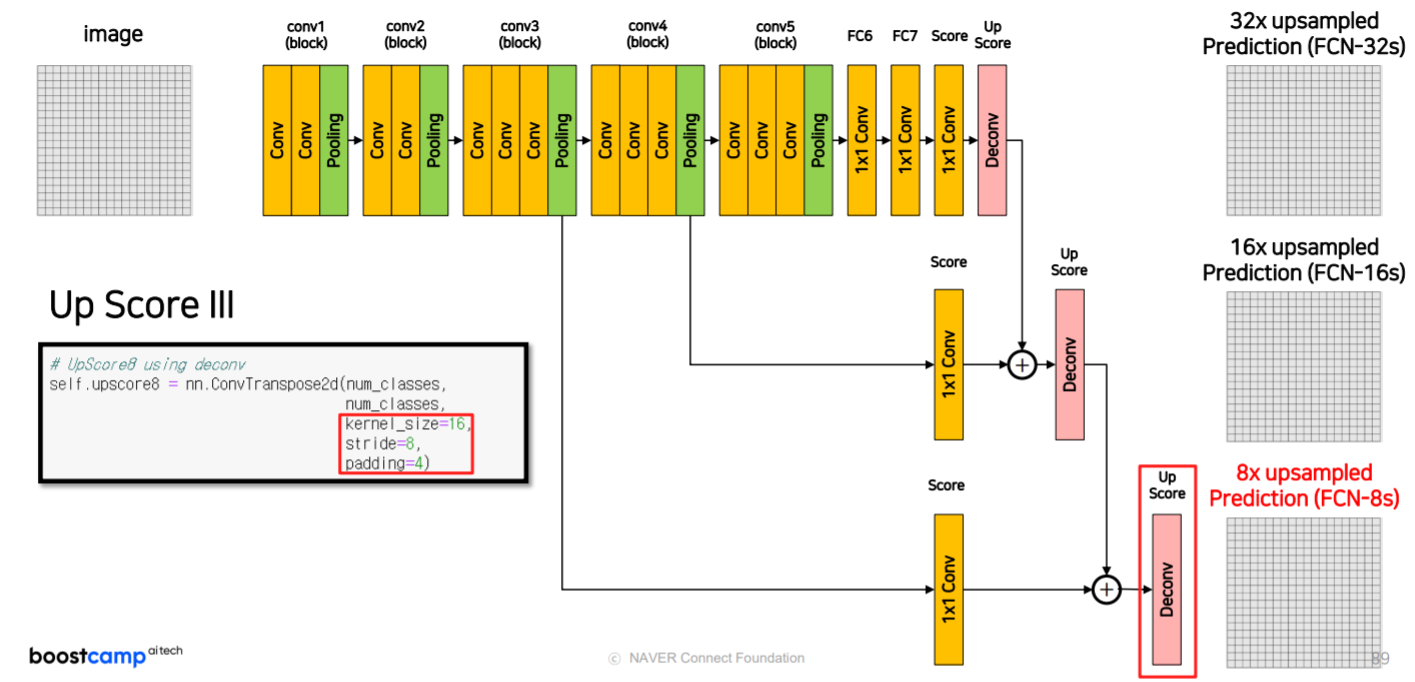

16s 8s

pooling된 input을 한꺼번에 upsampling하는 것은 성능이 좋지 않음

이전 단계의 pooling layer에서의 feature map과 마지막 transposed conv layer에서의 feature map을 더한다.

세번째 pooling layer와의 sum

-

네번째 pooling layer

크기가 1/16 되었다.

뒷단과 더하기 위해 1x1 conv로 class 개수만큼 channel을 만든다. -

last layer

크기가 1/32이므로 1/16과 더하기위해 2배 upsampling

-

세번째 pooling layer

크기가 1/8 되었다.

뒷단과 더하기 위해 1x1 conv로 class 개수만큼 channel을 만든다. -

last layer

크기가 1/16이므로 1/8과 더하기위해 2배 upsampling