Ollama

- 로컬 컴퓨터에서 개인 LLM 서버를 구성할 수 있게 도움을 주는 도구로, Mac,Linux와 Window에서 가능하며, 오늘은 리눅스와 윈도우에서 실행을 해보겠습니다.

1) Linux 방식

1) 우선, 저는 WSL을 통해 실행하였습니다.

- WSL 설치하는 방법은 https://learn.microsoft.com/ko-kr/windows/wsl/install 해당 사이트를 참고하시고, WSL 설치가 완료가 되었으면 다음 단계로 넘어갑니다.

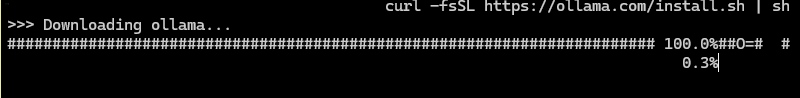

- 그 후 curl -fsSL https://ollama.com/install.sh | sh를 입력하시면 ollama가 설치를 시작합니다.

- Ollama가 설치가 완료가 되면 이제, 사용할 모델을 선택하면 되는데, 현재 Ollama에서 사용할 수 있는 모델은 대표적으로 llama, mistral, gemma가 있습니다.

- 저는 이번에 mistral을 사용해보겠습니다. ollama run mistral 명령어를 입력하면 아래와 같이 mistral 모델을 설치하기 시작합니다.

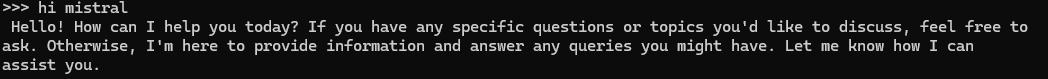

- 설치가 다 되면 아래와 같이 Chat 형식으로 대화가 가능합니다.

- 그리고 대화를 종료하려면 /bye를 입력하면 됩니다.

2) Window 방식

- 윈도우는 리눅스보다 더 간단합니다. https://ollama.com/download 해당 사이트에 접속해서 Windows를 클릭하여 다운로드 한 뒤, PowerShell을 통해 실행하면 됩니다.

- 실행 방식은 리눅스와 똑같이 ollama run mistral을 입력하면 위에서 나타난 것처럼 Chat 형식으로 대화가 가능합니다.

오늘은 이렇게 ollama를 통해 쉽게 개인용 LLM 서버를 구성을 해보았는데, 파인튜닝한 모델들에 대해서는 gguf로 변환을 하면 된다는데, 이 부분에 대해서는 제가 좀 더 공부하고, 구현해보면서 다음에는 파인튜닝 모델을 ollama로 구축해보도록 하겠습니다.