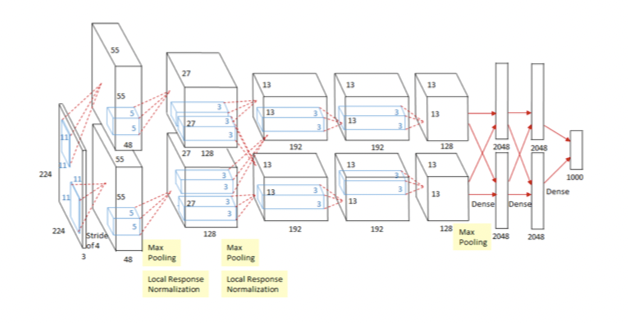

📖 2012 - AlexNet

- 딥러닝을 이용하여 첫 번째로 챌린지에서 1등을 하였음, paradigm shift

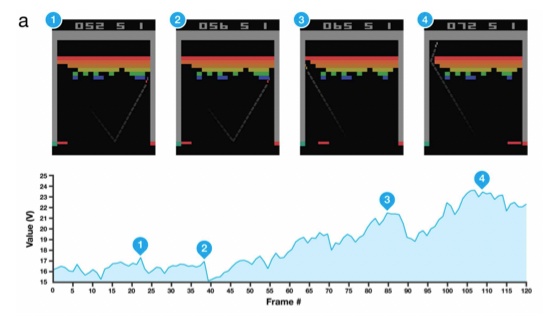

📖 2013 - DQN

- 강화학습에 딥러닝을 접목

- 오늘날의 딥마인드가 있게 한 논문

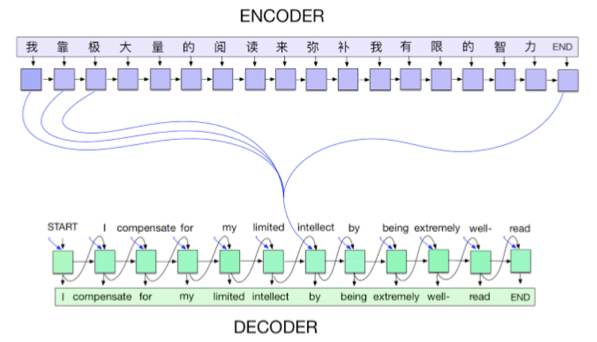

📖 2014 - Encoder / Decoder

- 기계어 번역의 trend가 많이 바뀌게 함

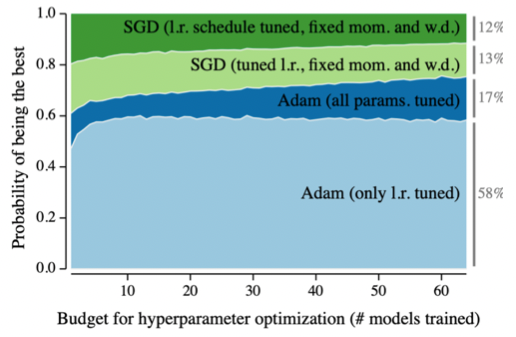

📖 2014 - Adam Optimizer

- Adam Optimizer을 사용하면 일반적으로 어느 정도의 좋은 성능을 보인다고 함

📖 2015 - GAN

- Generator & Discriminator 2개의 모델을 적대적으로 학습시켜 원하는 이미지를 생성시킴

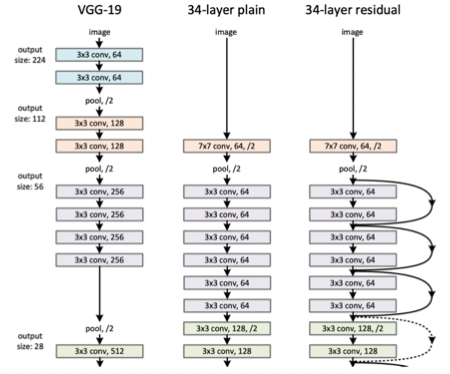

📖 2015 - Residual Networks

- 딥러닝이 'deep'해지는 것을 가능하게 한 연구

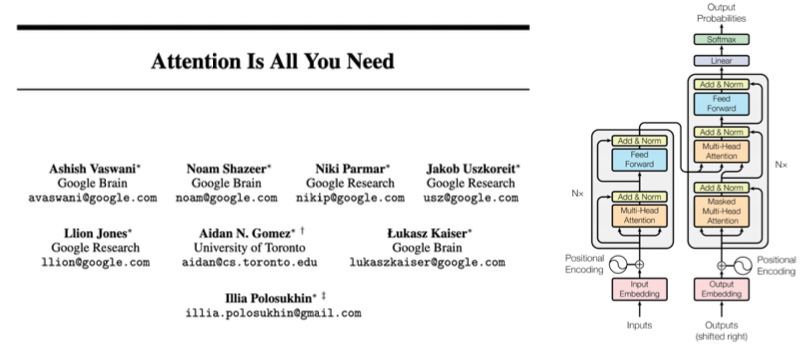

📖 2017 - Transformer

- RNN을 대체하고, vision 분야까지 넘보고 있는 모델

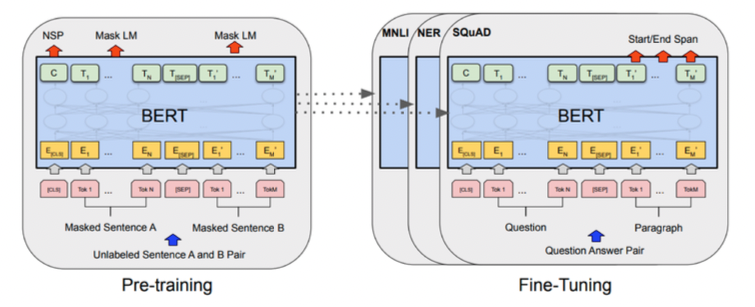

📖 2018 - Bert (fine-tuned NLP models)

- Bidirectional Encoder Representations from Transformers

📖 2019 - Big Language Models

- GPT-3, an autoregressive language model with 175 billion parameters

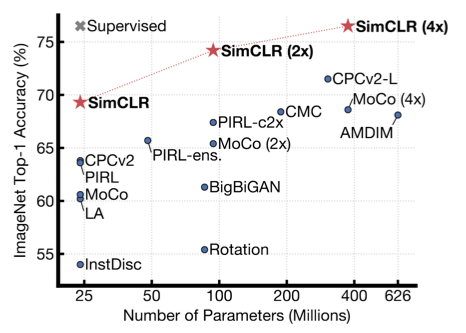

📖 2020 - Self Supervised Learning

- label이 없는 unsupervised-data 또한 학습에 활용을 하는 학습 방법

<이 게시물은 최성준 교수님의 'Historical Review' 강의 자료를 참고하여 작성되었습니다.>

본 포스트의 학습 내용은 [부스트캠프 AI Tech 5기] Pre-Course 강의 내용을 바탕으로 작성되었습니다.

부스트캠프 AI Tech 5기 Pre-Course는 일정 기간 동안에만 운영되는 강의이며,

AI 관련 강의를 학습하고자 하시는 분들은 부스트코스 AI 강좌에서 기간 제한 없이 학습하실 수 있습니다.

(https://www.boostcourse.org/)