모수가 뭐에요?

통계적 모델링은 적절한 가정 위에서 확률분포를 추정하는것이 목표이며, 기계학습과 통계학이 공통적으로 추구하는 목표

- 그러나 유한한 개수의 데이터만 관찰해서 모집단의 분포를 정확하게 알아낸다는 것은 불가능하므로, 근사적으로 확률분포를 추정할 수 밖에 없다.

- 데이터가 특정 확률분포를 따른다는 선험적으로 가정한 후 그 분포를 결정하는 모수를 추정하는 방법을 모수적 방법론이라고 합니다.

- 특정확률분포를 가정하지 않고 데이터에 따라 모델의 구조 및 모수의 개수가 유연하게 바뀌면 비모수 방법론이라 부릅니다.

- 기계하급의 많은 방법론은 비모수 방법론에 속함

- 비모수는 모수가 없는게 아님!! 모수가 무한히 많거나 데이터에 따라 모수가 달라지는 경우

확률분포 가정하기: 예제

- 확률분포를 가정하는 방법: 우선 히스토그램을 통해 모양을 관찰합니다.

- 데이터가 2개의 값(0,1)만 가지는 경우 -> 베르누이분포

- 데이터가 n개의 이산적인 값을 가지는 경우-> 카테고리분포

- 데이터가 [0,1] 사이에 값을 가지는 경우 -> 베타분포

- 데이터가 0 이상의 값을 가지는 경우 -> 감마분포, 로그정규분포 등

- 데이터가 R 전체에서 값을 가지는 경우 -> 정규분포, 라플라스분포 등

- 기계적으로 확률분포를 가정해서는 안되며, 데이터를 생성하는 원리를 먼저 고려하는 것이 원칙

- 분포마다 검정하는 방법들이 있으므로 모수를 추정한 후에는 반드시 검정을 해야한다.

데이터로 모수를 추정해보자

- 데이터의 확률분포를 가정했다면 모수를 추정해볼 수 있습니다.

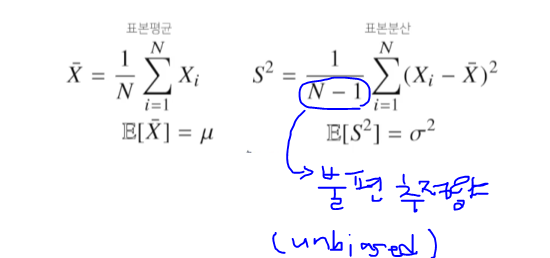

- 정규분포의 모수는 평균과 분산으로 이를 추정하는 통계량은 아래 그림과 같다

- 모수를 추정하기 위한 표본 통계량들을 추정량(Estimate)

- 불편성: 편향이 없다(Unbiased)라는 뜻

- 추정량의 기대값이 모수와 같아진다면, 이 추정량을 불편추정량이라고 한다.()

- 통계량의 확률분포를 표집분포(sampling distribution)라 부르며, 특히 표본평균의 표집분포는 N이 커질수록 정규분포를 따릅니다.

- 이를 중심극한정리이라 부르며 모집단의 분포가 정규분포를 따르지 않아도 성립합니다.

- sampling distribution(표본평균과 표본분산의 확률분포)와 sample distribution(표본들의 분포) 다름

최대가능도 추정법(maximum likelihood estimation, MLE)

- 표본평균이나 표분분산은 중요한 통계량이지만 확률분포마다 사용하는 모수가 다르므로 적절한 통계량이 달라지게 됩니다

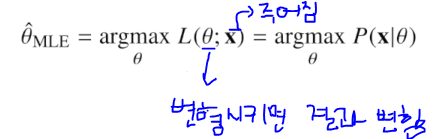

- 이론적으로 가장 가능성이 높은 모수를 추정하는 방법 중 하나는 최대가능도 추정법입니다.

- 가능도함수는 모수θ를 따르는 분포가 x를 관찰할 가능성을 뜻하지만 확률로 해석하면 안됩니다.

- 주어진 데이터x에 대해서 모수θ를 변수로 둔 함수

- 가능도함수는 모수θ를 따르는 분포가 x를 관찰할 가능성을 뜻하지만 확률로 해석하면 안됩니다.

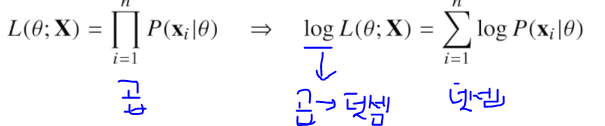

- 데이터 집합X가 독립적으로 추출되었을 경우 로그가능도를 최적화합니다

왜 로그가능도를 사용하나요?

- 로그가능도를 최적화하는 모수θ는 가능도를 최적화하는 MLE가 됩니다.

- 데이터의 숫자가 적으면 상관없지만 만일 데이터의 숫자가 수억 단위가 된다면 컴퓨터의 정확도로는 가능도를 계산하는 것은 불가능합니다

- 데이터가 독립일 경우, 로그를 사용하면 가능도의 곱셈을 로그가능도의 덧셈으로 바꿀수 있기 때문에 컴퓨터로 연산이 가능해집니다

- 경사하강법으로 가능도를 최적화할 때 미분 연산을 사용하게 되는데, 로그가능도를 사용하면 연산량을 에서

- 대게의 손실함수의 경우 경사하강법을 사용하므로 음의 로그가능도를 최적화하게 됩니다

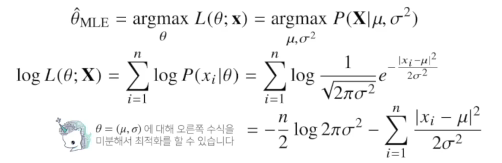

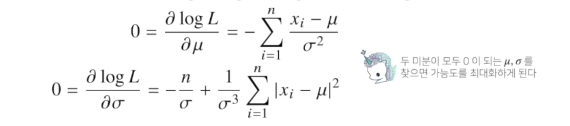

최대가능도 추정법 예제: 정규분포

- 정규분포를 따르는 확률변수X로부터 독립적인 표본{x1,,,,,xn}을 얻었을때 최대가능도 추정법을 이용하며 모수를 추정하면?

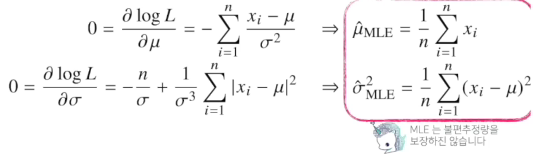

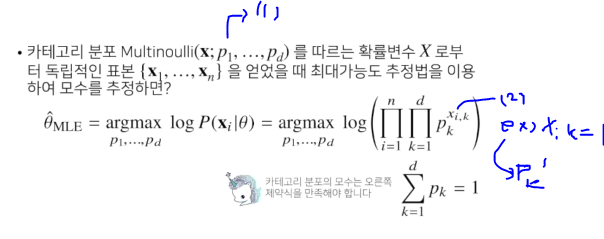

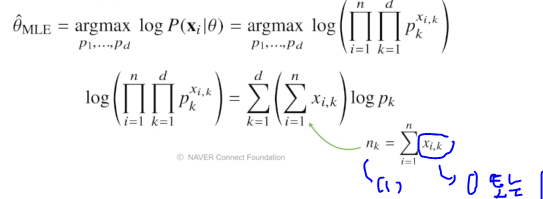

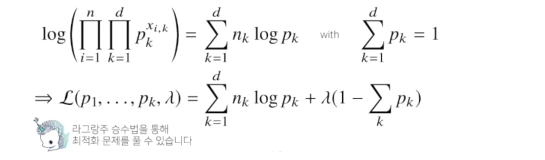

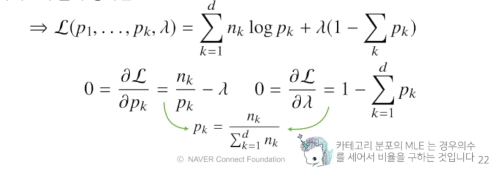

최대가능도 추정법 예제: 카테고리 분포

- (1) 1~d차원까지 각각의 차원에서 값이 0 또는 1이되는 확률들을 말함, 모수들을 다 더하면 1이 됨

- (2)주어진 데이터 Xi에 k번째 값을 승수로 취해줌

(1) 주어진 각 1~n까지 대해서 k 값이 1인 값의 갯수

(1) 주어진 각 1~n까지 대해서 k 값이 1인 값의 갯수

딥러닝에서 최대가능도 추정법

- 최대가능도 추정법을 이용해서 기계학습 모델을 학습할 수 있음

- 딥러닝 모델의 가중치라 표기했을 때 분류 분제에서 소프트맥스 벡터는 카테고리분포의 모수(P1....Pk)를 모델링합니다

- 원핫벡터로 표현한 정답레이블y = (y1....yk)을 관찰데이터로 이용해 확률분포인 소프트맥스 벡터의 로그가능도를 최적화할 수 있습니다

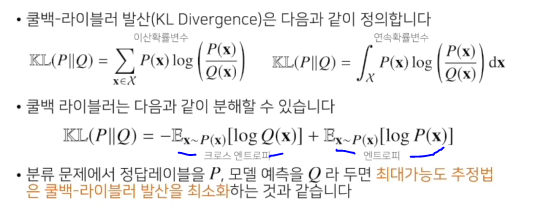

확률분포의 거리를 구해보자

- 기계학습에서 사용되는 손실함수들은 모델이 학습하는 확률분포와 데이터에서 관찰되는 확률분포의 거리를 통해 유도됩니다.

- 데이터공간에 두 개의 확률분포 P(x), Q(x)가 있을 경우 두 확률분포 사이의 거리를 계산할때 다음과 같은 함수들을 이용합니다

- 총변동거리(TV)

- 쿨백-라이블러 발산(KL)

- 바슈타인 거리