Ensemble

"싱글 모델보다 더 나은 성능을 위해 서로 다른 여러 학습 모델을 사용하는 것."

Ensemble of Deep NN

Boosting

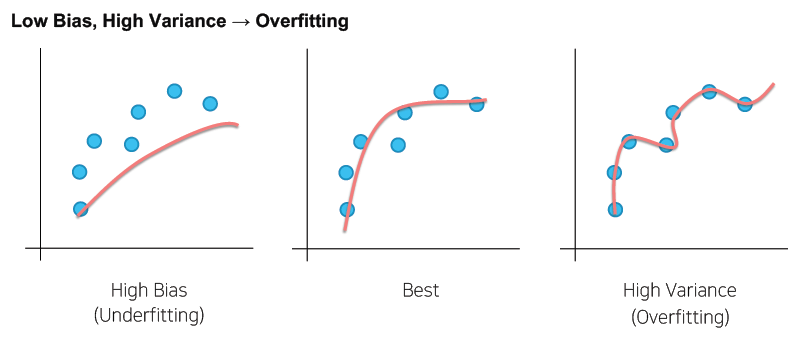

보통 Bias가 높은 모델들을 Ensemble 하는 방법

bias된 하나의 모델을 순차적으로 학습하는 과정을 진행하면서 더 나은 방향으로 fitting 되도록 한다.

ex) XGBoost, LightGMB

Bagging

보통 Variance가 있는 모델들을 Ensemble 하는 방법

데이터 sample을 나누어서 각각을 학습시킨 모델을 취합해서 평균을 낸다.

ex) Random Forest

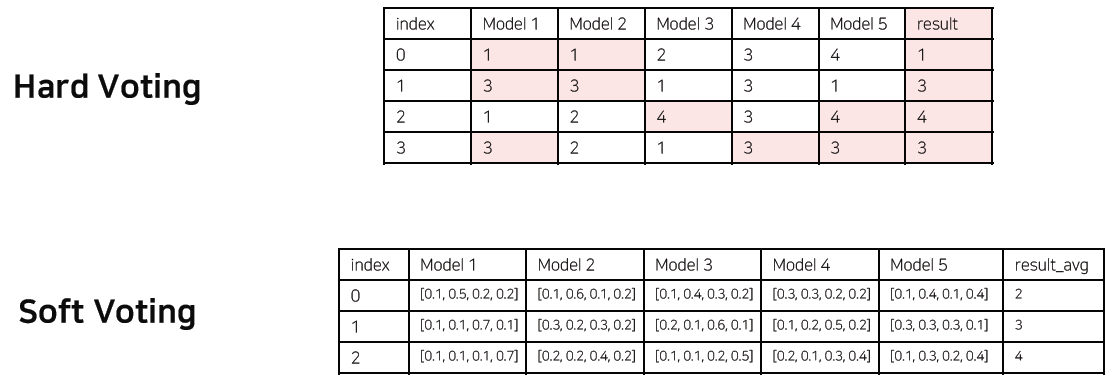

Model Averaging (Voting)

"The reason that model averaging works is that different models will usually not make all the same errors on the test set."

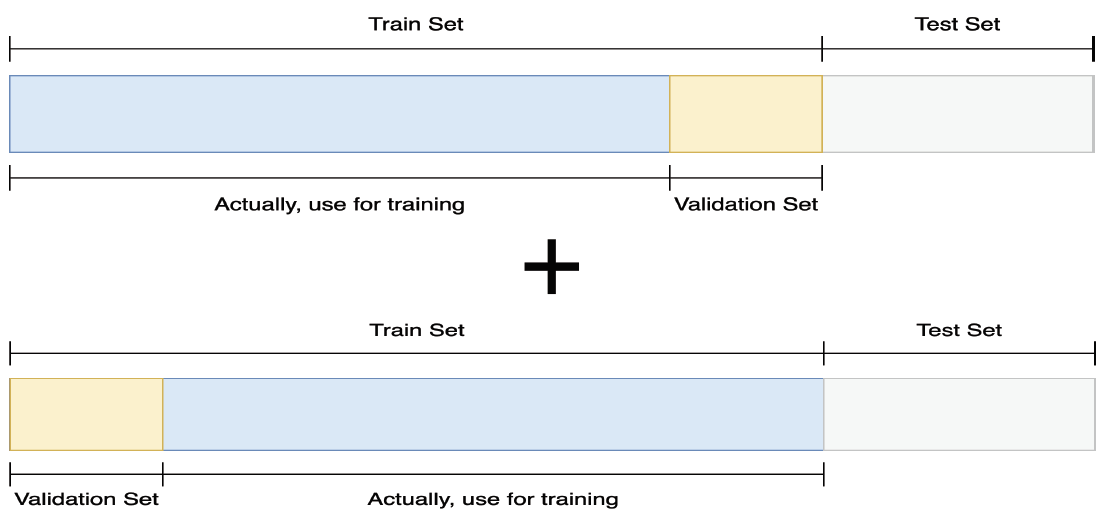

Cross Validation

훈련 셋과 검증 셋을 분리는 하되, 검증 셋을 학습에 활용할 수는 없을까?

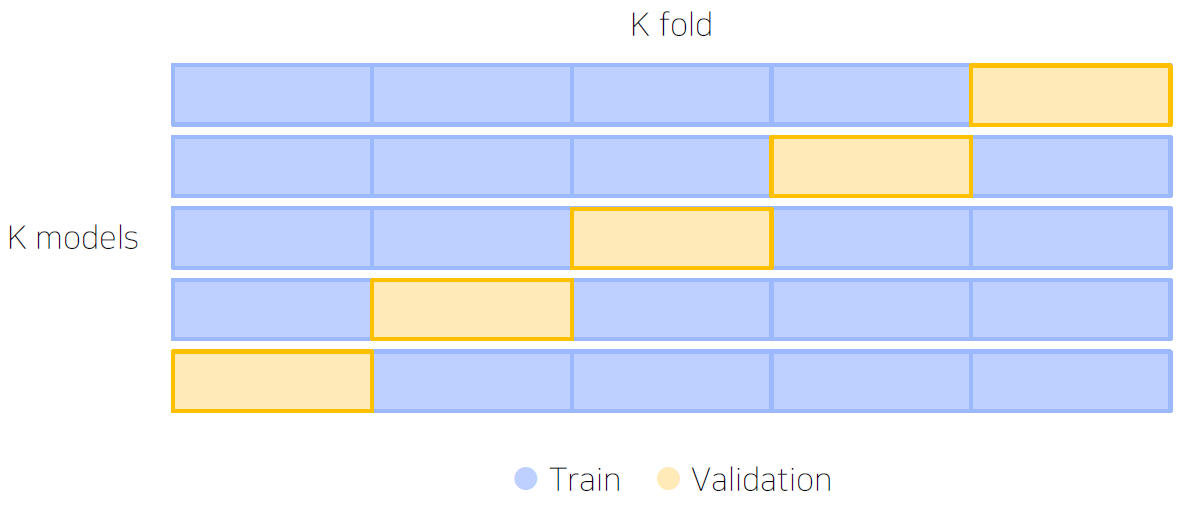

Stratified K-Fold Cross Validation

가능한 경우를 모두 고려 + Split시에 Class 분포까지 고려

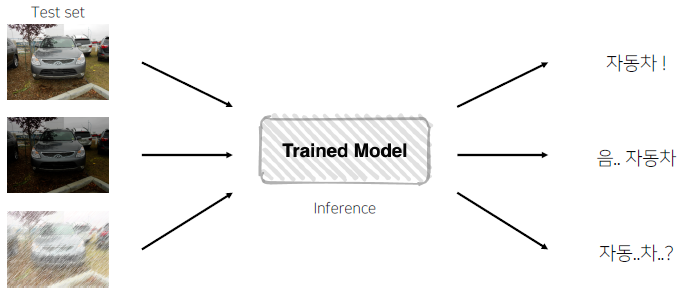

TTA (Test Time Augmentation)

테스트 이미지를 Augmentation 후 모델 추론, 출력된 여러가지 결과를 앙상블