🐱🏍 Classification

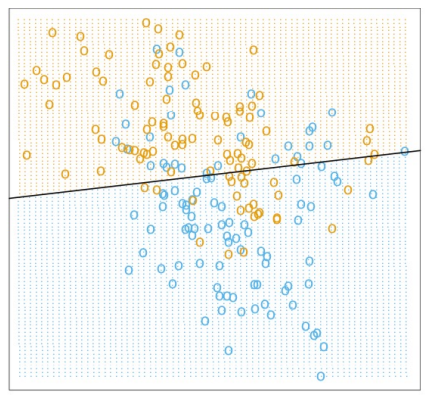

decision boundary를 찾아가는 과정!

ex) 위 그림의 경우 output이 둘로 나뉘어지므로 binary classification이다 ....

spam detection을 예시로 들어보자.

- : features extracted based on the i-th email

- : label

- 1: if the i-th email is spam (positive)

- 0: otherwise (negative)

이와 같은 경우 label인 이므로, hypothesis function 를 binary classification problem에 적용시킬 수 있도록 바꿔줘야 하는데...

🐱🏍 Logistic Regression

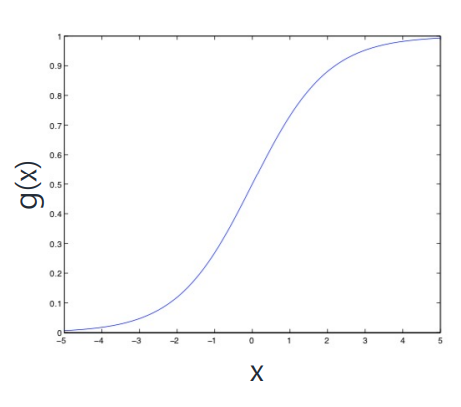

hypothesis function에 sigmoid function을 취해서 0~1 사이 값만 뱉어내게 하자!

in which

✔ Sigmoid Function

The logistic function in linear regression is a type of sigmoid!

Why Sigmoid?

여백이 부족하여 적지 않겟다.

optimization은 미분의 과정을 거치는데, sigmoid function을 미분한 form이 예뻐서... 그 이유 하나뿐인 건 아니지만 ( )

✔ Likelihood of β

Assume that

일반화하면, !!

것보다 확률밀도는 지난번에 햇던 건데 내가 까먹었구나