1. 증명: N-1을 나눠줘야 불편추정량이된다.

S2=n−1i=1∑n(xi−Xˉ)2

E(S2)=E(n−1i=1∑n(xi−Xˉ)2)

E(S2)=n−11E(i=1∑n(xi−Xˉ)2)

E(S2)=n−11E(i=1∑n(xi−μ+μ−Xˉ)2)

E(S2)=n−11E(i=1∑n[(xi−μ)2+2(xi−μ)(μ−Xˉ)+(μ−Xˉ)2])

E(S2)=n−11E(i=1∑n[(xi−μ)2]+i=1∑n[2(xi−μ)(μ−Xˉ)]+i=1∑n[(μ−Xˉ)2])

E(S2)=n−11E(i=1∑n[(xi−μ)2]+2(μ−Xˉ)i=1∑n[(xi−μ)]+n(μ−Xˉ)2)

Xˉ=ni=1∑nxi

E(S2)=n−11E(i=1∑n[(xi−μ)2]+2(μ−Xˉ)(nXˉ−nμ)+n(μ−Xˉ)2)

E(S2)=n−11E(i=1∑n[(xi−μ)2]−2n(μ−Xˉ)2+n(μ−Xˉ)2)

E(S2)=n−11E(i=1∑n[(xi−μ)2]−n(μ−Xˉ)2)

E(S2)=n−11E(i=1∑n[(xi−μ)2]−n(Xˉ−μ)2)

E(S2)=n−11{E(i=1∑n[(xi−μ)2])−nE((Xˉ−μ)2)}

E((Xˉ−μ)2)은 표본평균의 분산이다. 표본평균의 분산은 n모분산 이다. 증명은 아래의 reference를 참고하자.

E(S2)=n−11{E(i=1∑n[(xi−μ)2])−σ2}

E(S2)=n−11{E([(x1−μ)2+⋯+(xn−μ)2])−σ2}

E(S2)=n−11{E[(x1−μ)2]+⋯+E[(xn−μ)2]−σ2}

E[(xi−μ)2]는 크기가 1인 표본평균의 분산으로 볼 수 있다. 따라서 nσ2에서 n이 1이므로, E[(xi−μ)2]=σ2 이다.

E(S2)=n−11{nσ2−σ2}

E(S2)=σ2

2. 카테고리분포란?

-

카테고리 분포는 베르누이 분포를 d차원으로 확장시킨 개념이다.

-

카테로기 분포는 generalized Bernoulli distribution, multinoulli distribution라고도 불린다.

-

베르누이 분포에서는 확률변수 X는 2개의 값만 가진다면, 카테고리 분포에서는 d개의 값을 가진다.

-

카테고리는 원래 scala 값이지만, 확률변수는 다음과 같이 0과 1로만 이뤄진 다차원 벡터(one-hot vector)를 출력한다.

x=(x1,x2,x3,x4,x5,x6)

x=1→x=(1,0,0,0,0,0)

x=6→x=(0,0,0,0,0,1)

- 원소값 xk는

베르누이 확률변수로 볼 수 있기 때문에 각각 1이 나올 확률을 나타내는 모수 μk를 가진다.

벡터를 나타내는 원소와 모수의 제약 조건은 다음과 같다.

i=1∑Kxi=1 , xi={10

i=1∑Kμi=1 , 0≤μi≤1

-

확률 분포는 X∼Cat(x∣μ)로 표기한다.

-

x=(x1,⋯,xK),μ=(μ1,⋯,μK)

-

C=⎩⎪⎪⎪⎨⎪⎪⎪⎧μ1 if x=(1,0,⋯,0)⋮μK if x=(0,⋯,0,1)

-

PMF = P(X=x)=f(x∣μ)=μ1x1⋯μKxK=i=1∏Kμixi

베르누이 확률변수의 데이터가 복수이면 이 데이터의 합이 이항 분포를 이룬다.

카테고리 확률변수의 데이터가 여럿 있으면 이 데이터의 합은 다항분포(Multinomial distribution)가 된다.

3. 라그랑주 승수법(Lagrange Multiplier Method)

-

너무 잘 소개 되어있는 블로그 포스트의 저작권 표시가 저작자 표시, 비영리, 변경 금지 조건이어서, 내용을 그대로 복붙하였다.

-

라그랑주 승수법은 프랑스의 수학자 조세프루이 라그랑주 (Joseph-Louis Lagrange)가 제약 조건이 있는 최적화 문제를 풀기 위해 고안한 방법이다.

-

라그랑주 승수법은 어떠한 문제의 최적점을 찾는 것이 아니라, 최적점이 되기 위한 조건을 찾는 방법이다. 즉, 최적해의 필요조건을 찾는 방법이다.

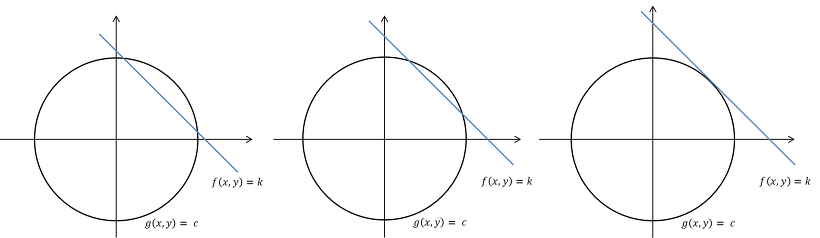

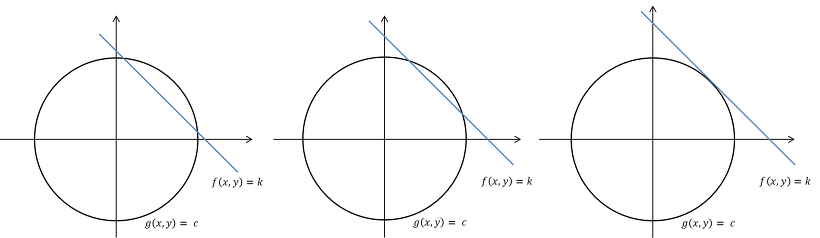

3.1. 기하학적 해석

- 라그랑주 승수법의 기본 가정은 "제약 조건 g를 만족하는 f의 최솟값 또는 최댓값은 f와 g가 접하는 지점에 존재할 수도 있다."는 것이다.

-

라그랑주 승수법에서는 두 함수 f와 g가 접하는 지점을 찾기 위해 gradient vector를 이용한다.

-

아래 식은 f(x,y)에 대한 gradient vector를 나타낸다.

▽f=(∂x∂f,∂y∂f)

-

어떠한 지점에서의 접선 벡터와 gradient vector의 내적은 0이므로, gradient vector는 접선 벡터와 수직을 이룬다.

-

따라서, 두 함수 f와 g가 접한다는 것은 두 함수의 gradient vector가 서로 상수배인 관계에 있다는 것이다.

-

이러한 관계를 ▽f=λ▽g로 날타낼 수 있다. λ는 임의의 상수이다.

-

라그랑주 승수법에서는 아래와 같은 보조 함수를 정의한다.

L(x,y,λ)=f(x,y)−λ(g(x,y)−c)

-

위의 함수 L의 gradient vector가 영벡터가 되는 점을 찾는 것은 ▽f=λ▽g를 푸는 것과 같다.

-

따라서 함수 L의 gradient vector가 영벡터가 되는 점을 찾으면 두 함수 f와 g가 접하는 점을 찾을 수 있다.

-

함수 L을 x와 y에 대해 편미분하면 총 2개의 식을 얻을 수 있으며, 여기에 제약 조건인 g(x,y)=c를 이용하면 미지수가 3개인 문제의 해(solution)를 구할 수 있다.

-

여기에서 구한 x와 y는 제약 조건 g를 만족하는 함수 f의 최적점이 될 가능성이 있는 점이다.

-

만약, 제약 조건 g가 n개인 경우에는 아래와 같이 일반화할 수 있다.

L(x,y,λ1,⋯,λn)=f(x,y)−i=1∑nλi(g(x,y)−ci)

3.1. 전미분(total differential)을 이용한 해석

-

기하학적 해석은 직관적으로 이해하기에는 용이할 수 있지만, 라그랑주 승수법이 어떻게 계산되는지를 명확하게 나타내지는 못 한다.

-

따라서, 전미분을 이용하여 라그랑주 승수법의 정의를 더욱 수치적으로 해석한다.

-

어떠한 함수 f(x,y,z)의 최솟값 또는 최댓값은 극점에 존재할 수도 있으며, 다변수 함수의 극점은 전미분 df=0인 지점 중에 존재한다. 함수 f(x,y,z)의 전미분은 아래와 같이 정의된다.

df=∂x∂fdx+∂y∂fdy+∂z∂fdz

- 변수 dx,dy,dz가 각각 독립적이라면, 함수 df=0이 되는 조건은 아래와 같다.

∂x∂f=∂y∂f=∂z∂f=0

- 제약 조건 g(x,y,z)=0에 대해서 전미분을 하면, 아래의 식을 얻을 수 있다.

dg=∂x∂gdx+∂y∂gdy+∂z∂gdz=0

- 위의 식을 dz에 대해 정리하면 아래와 같다.

dz=−∂z∂g∂x∂gdx+∂y∂gdy

- 위의 식에서 계산한 dz를 함수 f(x,y,z)의 전미분 식 df=∂x∂fdx+∂y∂fdy+∂z∂fdz에 대입하면 아래의 식을 얻을 수 있다.

df=∂x∂fdx+∂y∂fdy−∂z∂g∂x∂gdx+∂y∂gdy

- 함수 f의 전미분이 0이 되는 지점을 찾는 것이 목적이므로, 위의 식이 0인 값을 구해야 한다.

∂x∂fdx+∂y∂fdy−∂z∂g∂x∂gdx+∂y∂gdy=0

(∂x∂f−∂g/∂z∂f/∂z∂x∂g)dx+(∂y∂f−∂g/∂z∂f/∂z∂y∂g)dy=0

- 또한, λ를 아래와 같이 정의한다.

λ=∂g/∂z∂f/∂z

- 그러면 함수 f의 전미분이 0이 되는 지점을 찾는 식을 아래와 같이 정리할 수 있다.

(∂x∂f−λ∂x∂g)dx+(∂y∂f−λ∂y∂g)dy=0

(∂x∂fdx+∂y∂fdy)−λ(∂x∂gdx+∂y∂gdy)=0

- 서로 독립적인 dx와 dy를 포함하는 위의 식을 만족하기 위해서는 아래의 식이 성립해야 한다.

∂x∂f=λ∂x∂g , ∂y∂f=λ∂y∂g

- 위의 식을 정리하면 아래의 식과 같다. 이는 기하학적 해석에서 함수 f의 gradient vector와 제약 조건 g의 gradient vector의 상수배의 관계에 있어야 한다는 식과 같다.

(∂x∂f,∂y∂f)=(λ∂x∂g,λ∂y∂g)

-

정보 이론에서, information은 bit로 측정되며, 주어진 이벤트에서 발생하는 놀라움의 양 으로 이해할 수 있다.

-

이는 어떤 사건이 정보적 측면에서 얼마나 중요한가를 반영한 지표로 볼 수 있다.

-

Information의 수학적 정의는 아래와 같다.

I(x)=log2 PX(X=x)1=−log2 PX(X=x)

동전 앞면이 나올 확률이 0.99이고 뒷면이 나올 확률이 0.01이라면, 뒷면이 나온 경우 훨씬 더 놀라운 상황이다.

이를 수학적으로 나타내면, 앞면에 대한 information은 −log(0.99)=0.0144 bits로 매우 낮고, 뒷면에 대한 information은 −log(0.01)=6.64 bits로 높은 값을 가진다.

4.2. Entropy

-

정보 이론에서, entropy는 확률 분포의 불확실함의 정도를 나타내는 양이다.

-

이는 특정한 특정한 stochastic process에서 생성된 information의 평균(기대값)이다.

-

Entropy의 수학적 정의는 아래와 같다.

H(X)=E[I(X)]=E[log2PX(x)1]=x∈X∑PX(x)log2PX(x)1=−x∈X∑PX(x) log2 PX(x)

위의 동전의 예시를 통해 entropy H(X)를 구하면 아래와 같다.

H(X)=−{0.99log(0.99)+0.01log(0.01)}=0.08 bits

즉, 불공평한 동전은 0.08 bits의 평균 정보 전달률을 갖는 stochastic information generator이다.

만약, 동전 앞/뒤 확률이 0.5로 같았다면, entropy의 값은 1bit가 나온다.

확률이 0.99, 0.01인 경우 앞면이 나온다는 것을 확신할 수 있지만, 확률이 0.5, 0.5인 경우 앞면과 뒷면 중 어느 것이 나오는지를 예측할 수 없다.

결과값을 예측하기 굉장히 쉬우면 entropy 값이 낮게 나오고, 결과값을 예측하기 굉장히 어려우면 entropy 값이 높게 나온다.

- entropy는 홀로 머신러닝에서 자주 사용된다. ex) reinforcement learning에서 손실 함수 정규화, bayesian methods 등

References