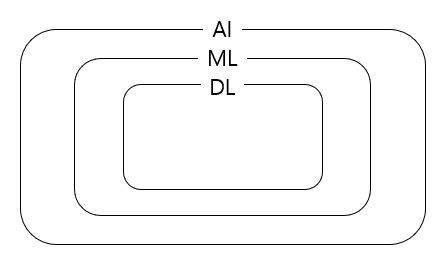

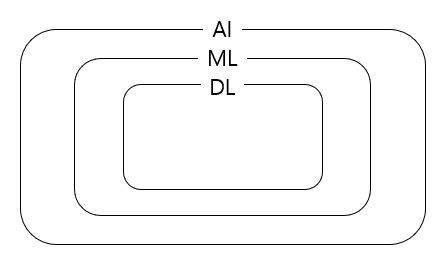

딥러닝

DL key component

- 데이터: 모델의 학습 재료

- 모델: 데이터를 내가 원하는 결과로 변환하는 역할

- loss: 모델의 성능이 얼마나 나쁜지를 정량화

- 모델을 어떻게 학습할지 지표가 되는 역할

- loss값이 무작정 줄어든다고 원하는 결과를 얻는 것은 아님.

- loss 별 특징을 알고 골라 써야함

- 알고리즘: 모델 파라미터를 조절하여 loss를 최소화하는 방식

DL의 핵심 연구들

- Deep Learning's Most Important Ideas - A Brief Historical Review

- 연도별

- 2012 - AlexNet

- CNN / classification / 이미지넷 대회에서 최초의 딥러닝 모델 우승, 딥러닝의 시대

- 2013 - DQN

- 강화학습 / Q-learning과 딥러닝의 결합 / deepmind

- 2014

- Encoder/Decoder: 번역 - 한 언어의 단어 시퀀스를 다른 언어의 단어 시퀀스로 변환

- Adam: 가장 흔히 쓰이는 최적화 알고리즘, 큰 비용없이 좋은 결과

- 2015

- GAN: 적대적 생성 모델

- ResNet: 신경망 레이어 수의 한계를 크게 확장함

- 2016 - skip

- 2017 - Transformer

- Attention Is All You Need

- RNN을 대체

- 2018 - Bert

- fine-tuned NLP models: 많은 양의 일반적인 말뭉치로 pre-training, 이후 내가 원하는 도메인 데이터(상대적으로 적음)로 fine-tune

- 2019 - Big Language Models(GPT-X)

- 2020 - Self-Supervised Learning

- SimCLR: a simple framework for contrastive learning of visual representation

- 분류 모델을 학습시킨다면 라벨있는 데이터와 라벨이 없는 데이터를 같이 활용하기 위한 연구

- 좋은 representation을 학습 데이터 외의 추가 데이터를 이용해 얻는 방식

- 다른 트렌드: 도메인 지식, 시뮬레이터를 통해 데이터를 생성하여 더 좋은 모델을 학습시키는 방식