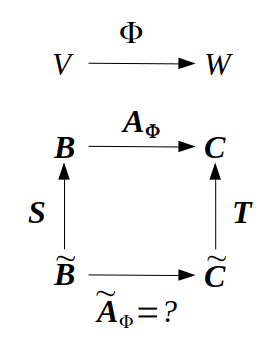

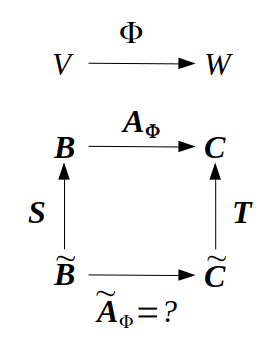

기저 변환

벡터 공간 V와 기저 B=(b1,⋯,bn),B~=(b~1,⋯,b~n),

벡터공간 W와 기저 C=(c1,⋯,cm),C~=(c~1,⋯,c~m),

선형 변환 Φ:V→W와 기저 B,C에 대한 변환행렬 AΦ,

선형 변환 Φ:V→W와 기저 B~,C~에 대한 변환행렬 A~Φ 일 때,

❓: AΦ와 A~Φ의 관계

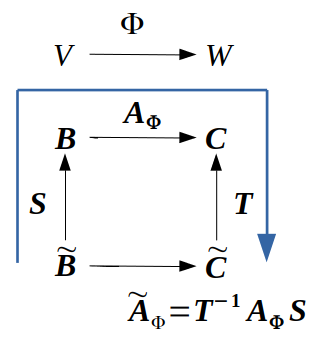

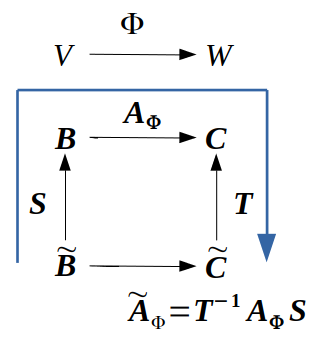

b~j=s1jb1+⋯+snjbn=∑i=1nsijbi ➡ 변환행렬 S: 기저 B~에 대한 좌표를 기저B에 대한 좌표로 변환

c~k=t1kc1+⋯+tmkcm=∑l=1mtlkcl ➡ 변환행렬 T: 기저 C~에 대한 좌표를 기저C에 대한 좌표로 변환

1) 먼저 B~를 C~를 경유해서 C로 표현해본다.

Φ(b~j)=∑k=1mα~kjc~k=∑k=1mα~kj∑l=1mtlkcl=∑l=1m(∑k=1mtlkα~kj)cl

2) 다음은 B~를 B를 경유해서 C로 표현해본다.

Φ(b~j)=Φ(∑i=1nsijbi)=∑i=1nsijΦ(bi)=∑i=1nsij∑l=1mαlicl=∑l=1m(∑i=1nαlisij)cl

3) ∑k=1mtlkα~kj=∑i=1nαlisij ➡ TA~Φ=AΦS ➡ A~Φ=T−1AΦS

📌 A~=T−1AS 를 만족하는 T∈Rm×m, S∈Rn×n 이 존재하면 A,A~ 는 서로 equivalent하다고 한다.

📌 A~=S−1AS 를 만족하는 S∈Rn×n 이 존재하면 A,A~∈Rn×n은 similar, 서로 닮음 이라고 한다.

- 닮은 행렬들은 항상 equivalent하지만 equivalent한 행렬들이 항상 닮은 행렬은 아니다.

Image, Kernel

선형 변환의 image와 kernel은 어떤 특징을 가진 벡터 공간

📌 Φ:V→W 에 대해서

-

kernel, null space:

ker(Φ):=Φ−1(0W)={v∈V:Φ(v)=0W}

🤔 변환시에 0이 되는 V의 벡터들. AΦx=0의 해.

-

image, range:

Im(Φ):=Φ(V)={w∈W∣∃v∈V:Φ(v)=w}

🤔 변환으로 V의 벡터들과 맵핑되는 W의 벡터들의 집합. 변환으로 V에서 도달할 수 있는 W의 벡터들.

-

V를 Φ의 domain, W를 Φ의 codomain이라 한다.

📌 Φ:V→W가 선형 변환, V,W가 벡터공간일 때

-

Φ(0V)=0W를 항상 만족하므로 0V∈ker(Φ). 그러므로 kernel은 공집합이 아니다.

🤔 AΦx=0 의 자명한 해 0

-

Im(Φ)⊆W 는 W의 부분공간, ker(Φ)⊆V는 V의 부분 공간.

🤔 image와 kernel 모두 0를 포함하고 Φ가 선형 변환이면 image의 경우 Φ(αv1)+Φ(βv2)=w1+w2=w=Φ(αv1+βv2) 이므로 w1,w2∈Im(Φ) 일 때,w∈Im(Φ) / kernel의 경우 Φ(αv1)+Φ(βv2)=Φ(αv1+βv2)=0 으로 v1,v2∈ker(Φ) 일 때, αv1+βv2∈ker(Φ)이므로 image, kerenl 모두 벡터 합과 스칼라의 곱에 닫혀있음.

-

Φ는 injective, 단사 ⟺ker(Φ)={0}

🤔 일단 0∈ker(Φ)이므로 Φ가 단사인 경우 ker(Φ)={0} / 단사임을 보이려면 Φ(a)=Φ(b)일 때, a=b를 보여야함. Φ(a)=Φ(b)라면 Φ(a)−Φ(b)=Φ(a−b)=0. 여기서 ker(Φ)={0}이면 a−b=0, a=b. 단사.

📌 A∈Rm×n, 선형 변환 Φ:Rn→Rm,x↦Ax 일 때,

-

A=[a1,⋯,an] 일 때,

Im(Φ)={Ax:x∈Rn}={∑i=1nxiai:x1,⋯,xn∈R}=span[a1,⋯,an]⊆Rm

image는 A의 열들의 span으로 column space, 열공간이라고도 한다. Rm의 부분공간.

-

rk(A)=dim(Im(Φ))

🤔 rank는 행렬의 피벗열의 수 = 선형 독립인 열의 수 = 행렬의 열들로 구성하는 벡터 공간의 기저의 수

-

ker(Φ)는 homogeneous, 동차연립방정식 Ax=0의 일반해로 0∈Rm을 만드는 모든 선형 결합이다.

-

ker(Φ)는 Rn의 부분 공간이고 (n은 A의 열의 수) 행렬의 열들간의 관계를 나타낸다. = 행렬의 열들의 선형 종속 여부를 알 수 있다.

🤔 Ax=0 의 해를 구하는 방식이 행렬의 어떤 열을 다른 열들로 표현하여 0을 만드는 방식이었다.

📖 Φ:R4→R2, ⎣⎢⎢⎢⎡x1x2x3x4⎦⎥⎥⎥⎤↦[1120−1001]⎣⎢⎢⎢⎡x1x2x3x4⎦⎥⎥⎥⎤일 때,

Im(Φ)=span[[11],[20],[−10],[01]]⊂R2 / image는 codomain의 부분공간으로 변환행렬의 열들의 선형 결합 집합.

ker(Φ)를 구하려면 Ax=0을 푼다.

변환 행렬을 기약 사다리꼴로 변환하고

[1120−1001]⇝⋯⇝[10010−211−21]

피벗열이 아닌 열들을 좌측의 피벗열들로 표현하여 상쇄해 0을 만든다.

ker(Φ)=span[⎣⎢⎢⎢⎡02110⎦⎥⎥⎥⎤,⎣⎢⎢⎢⎡−12101⎦⎥⎥⎥⎤]⊂R4 / kernel은 domain의 부분공간.

📌 Rank-Nullity 정리

벡터공간 V,W, 선형 변환 Φ:V→W일 때, dim(ker(Φ)))+dim(Im(Φ))=dim(V)

dim(V)=n,dim(ker(Φ))=k일 때, dim(Im(Φ))=n−k임을 보여야한다.

V의 기저가 (b1,⋯,bn)일 때,

Im(Φ)=span[Φ(b1),⋯,Φ(bn)]

여기서 ker(Φ)의 기저가 (b1,⋯,bk)이라면 Φ(b1)=⋯=Φ(bk)=0 이므로

Im(Φ)=span[Φ(bk+1),⋯,Φ(bn)]

Φ(bk+1),⋯,Φ(bn)가 기저이려면 선형 독립인지 확인해야한다.

∑i=k+1nαiΦ(bi)=Φ(∑i=k+1nαibi)=0

여기서 ∑i=k+1nαibi는 ker(Φ)의 원소이고 이는 ker(Φ)의 기저 (b1,⋯,bk)의 선형 결합으로 표현할 수 있다.

∑i=k+1nαibi=∑j=1kβjbj

(b1,⋯,bn)은 V의 기저이므로 ∀α,∀β=0으로 Φ(bk+1),⋯,Φ(bn)는 선형 독립이며 Im(Φ)의 기저이므로 dim(Im(Φ)))=n−k

- dim(Im(Φ))<dim(V)이면 ker(Φ)는 0V 외의 원소를 갖고 dim(ker(Φ))≥1

- dim(Im(Φ))<dim(V)이면 AΦx=0은 무수히 많은 해를 갖는다.

- dim(V)=dim(W)이면 Φ가 (injective 단사 / surjective 전사 / bijective 단전사)는 3방향 동치.

🤔 단사라면 ker(Φ)={0}이므로 전사. 전사라면 dim(Im(Φ))=dim(W)이고 kernel의 차원 0으로 ker(Φ)={0}이고 단사. 그리고 전단사.